Pyramid Feature Attention Network for Saliency

detection

汇报人:端木明星

2019.11. 21

�

Pyramid Feature Attention Network for Saliency detection

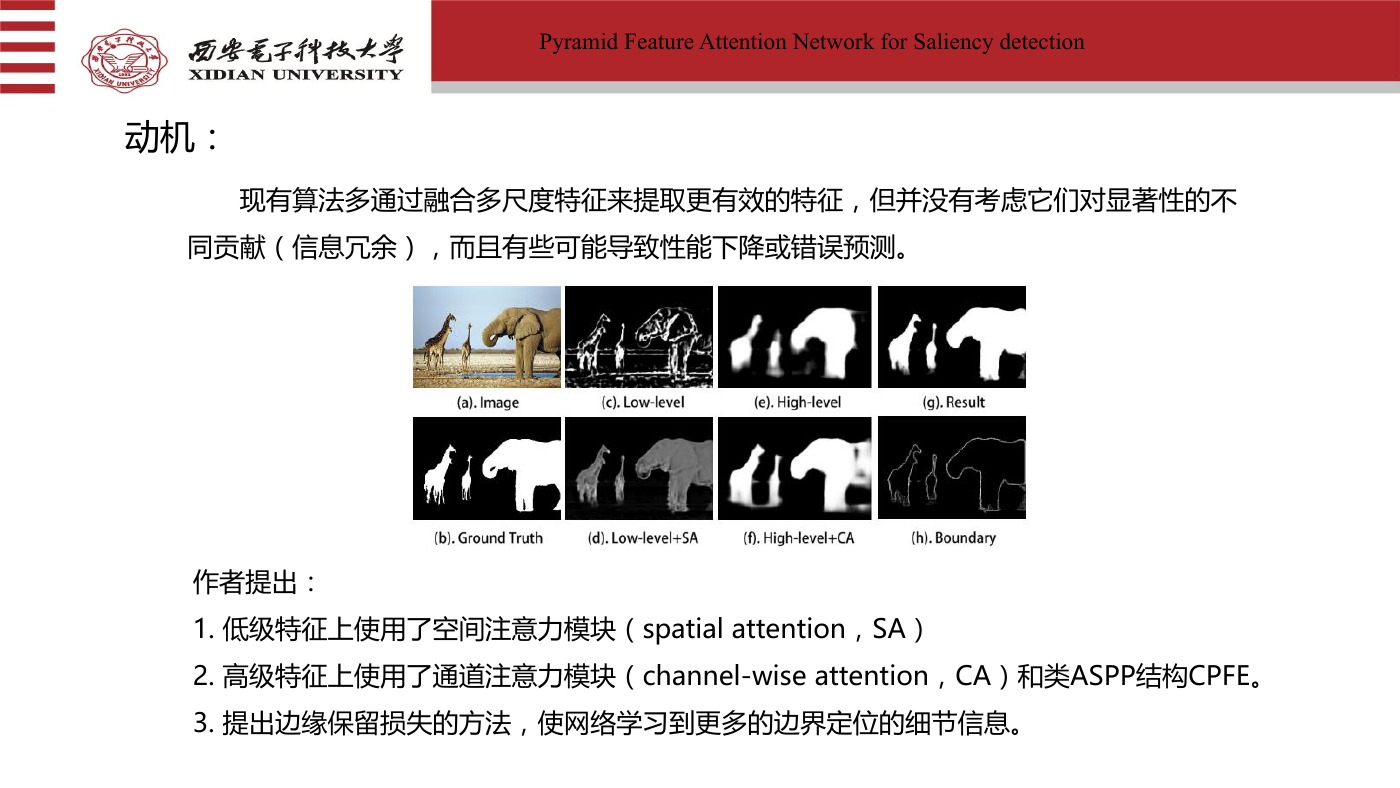

动机:

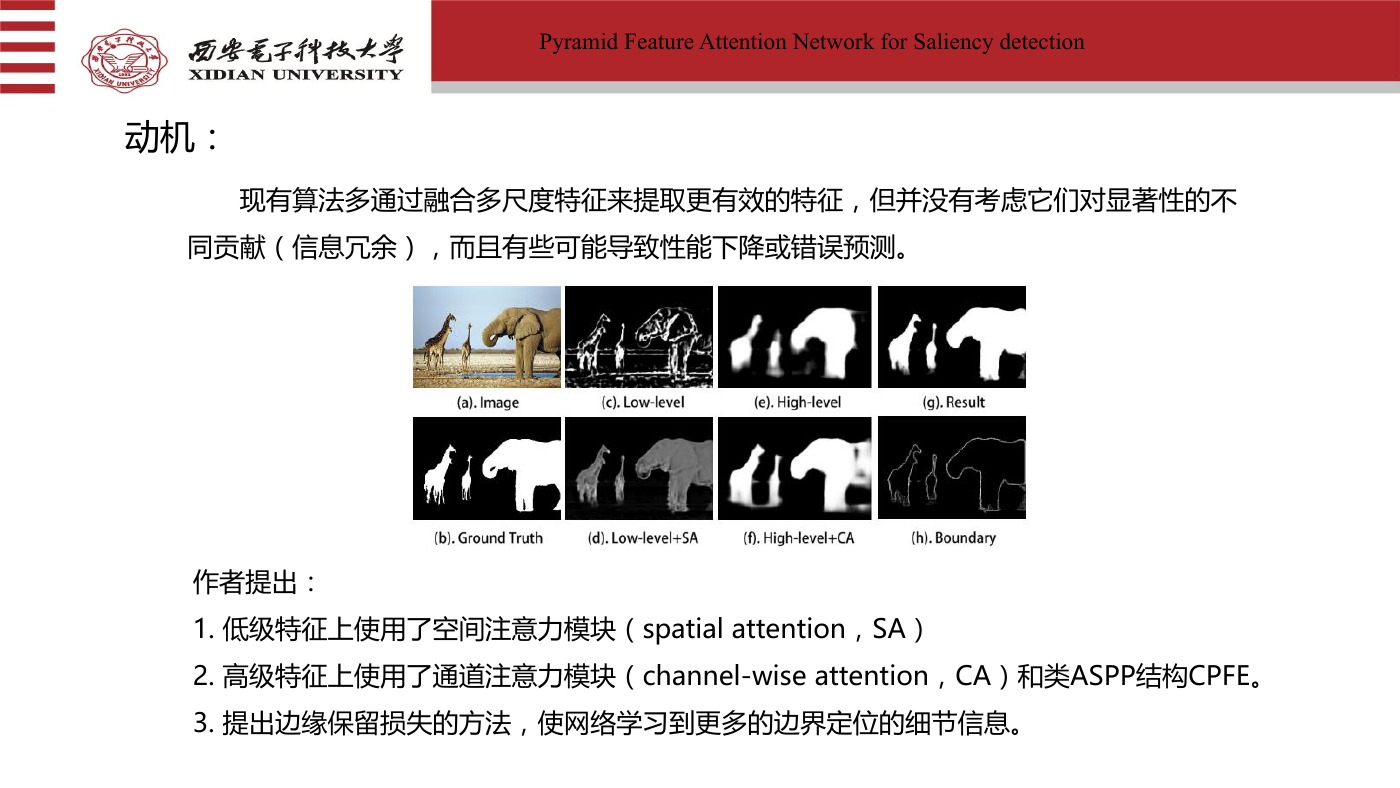

现有算法多通过融合多尺度特征来提取更有效的特征,但并没有考虑它们对显著性的不

同贡献(信息冗余),而且有些可能导致性能下降或错误预测。

作者提出:

1. 低级特征上使用了空间注意力模块(spatial attention,SA)

2. 高级特征上使用了通道注意力模块(channel-wise attention,CA)和类ASPP结构CPFE。

3. 提出边缘保留损失的方法,使网络学习到更多的边界定位的细节信息。

�

Pyramid Feature Attention Network for Saliency detection

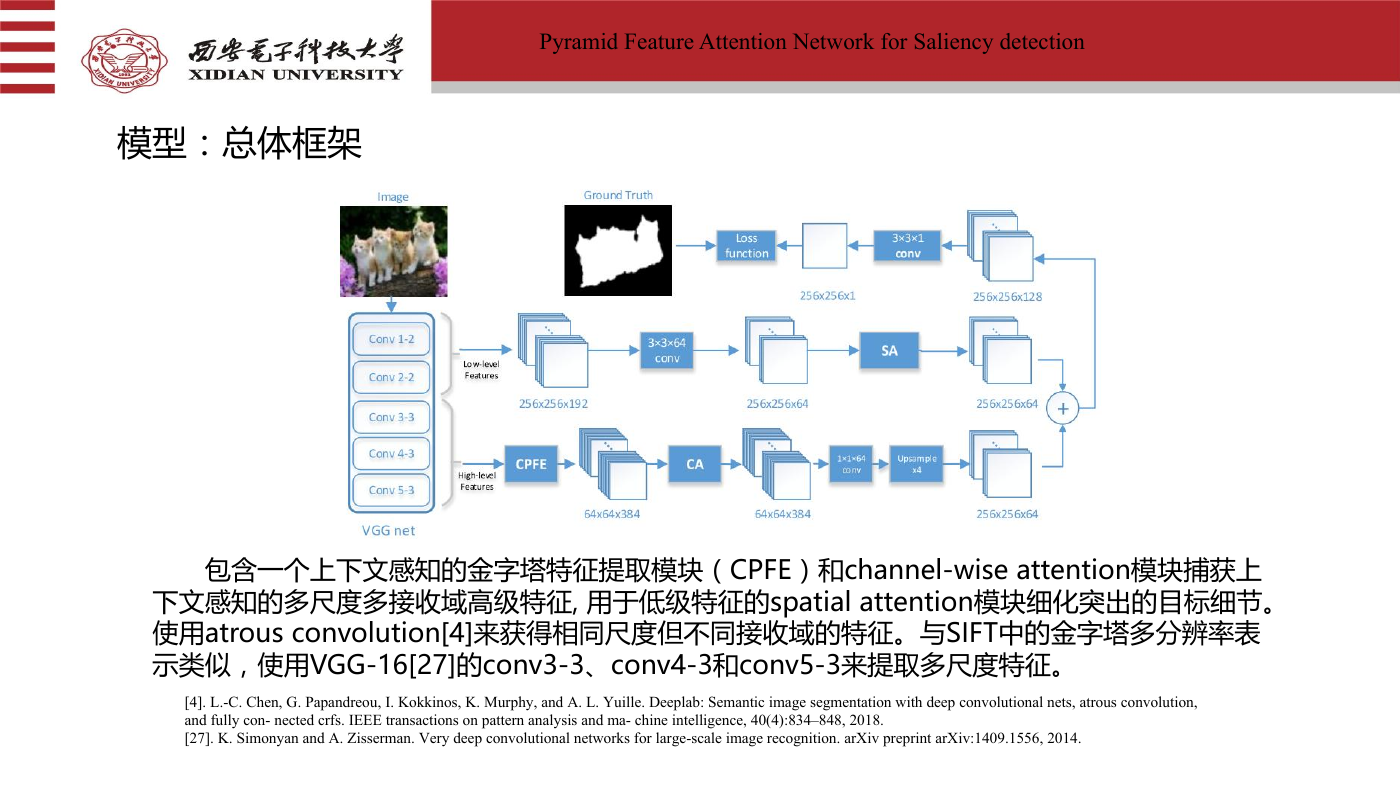

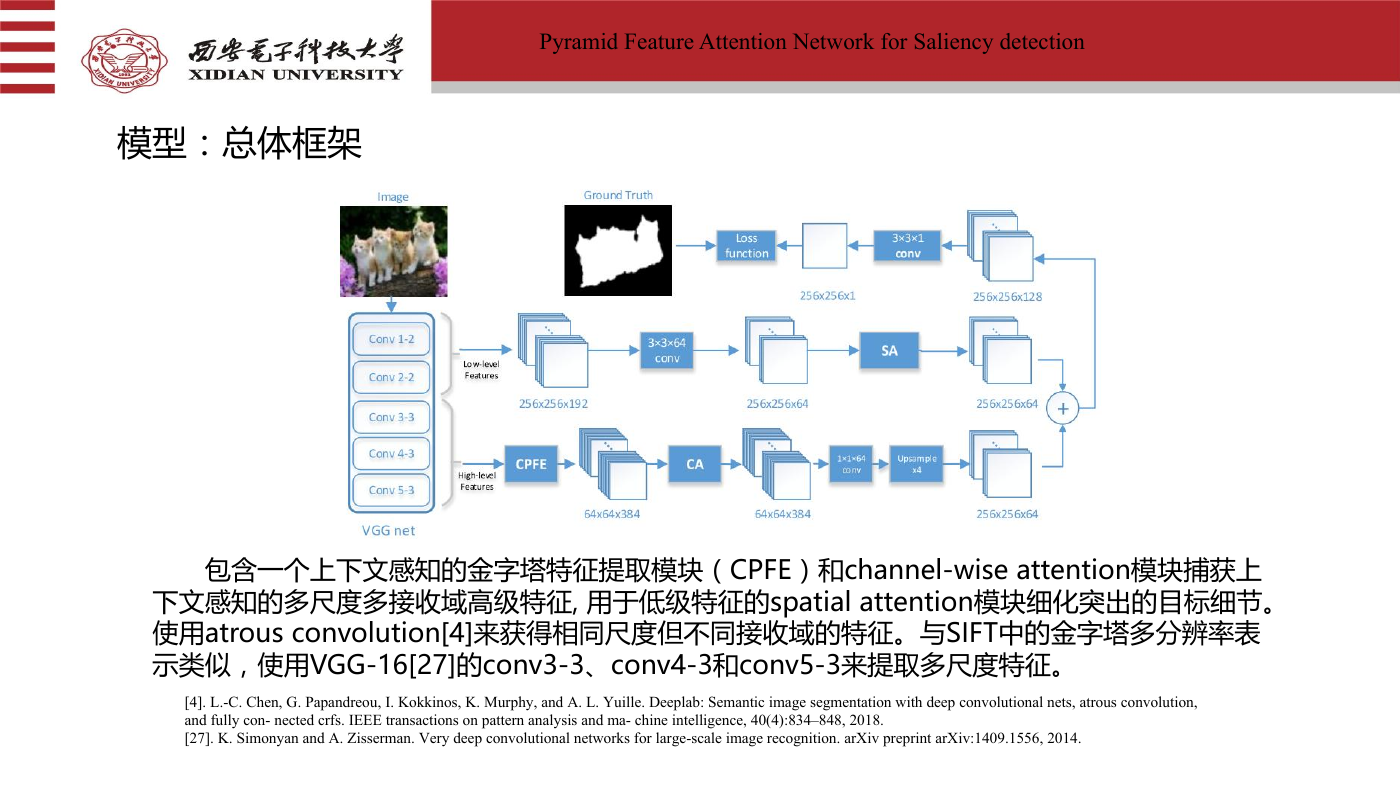

模型:总体框架

包含一个上下文感知的金字塔特征提取模块(CPFE)和channel-wise attention模块捕获上

下文感知的多尺度多接收域高级特征, 用于低级特征的spatial attention模块细化突出的目标细节。

使用atrous convolution[4]来获得相同尺度但不同接收域的特征。与SIFT中的金字塔多分辨率表

示类似,使用VGG-16[27]的conv3-3、conv4-3和conv5-3来提取多尺度特征。

[4]. L.-C. Chen, G. Papandreou, I. Kokkinos, K. Murphy, and A. L. Yuille. Deeplab: Semantic image segmentation with deep convolutional nets, atrous convolution,

and fully con- nected crfs. IEEE transactions on pattern analysis and ma- chine intelligence, 40(4):834–848, 2018.

[27]. K. Simonyan and A. Zisserman. Very deep convolutional networks for large-scale image recognition. arXiv preprint arXiv:1409.1556, 2014.

�

Pyramid Feature Attention Network for Saliency detection

模型:CPFE

1. 采用不同膨胀率(3/5/7)的逐次卷积获取

多接收域上下文信息。

2. 将来自不同对流层的特征图和1×1降维特

征结合起来。

3. 将两个较小的特征上采样到最大的一个。

4. 级联后输出。

�

Pyramid Feature Attention Network for Saliency detection

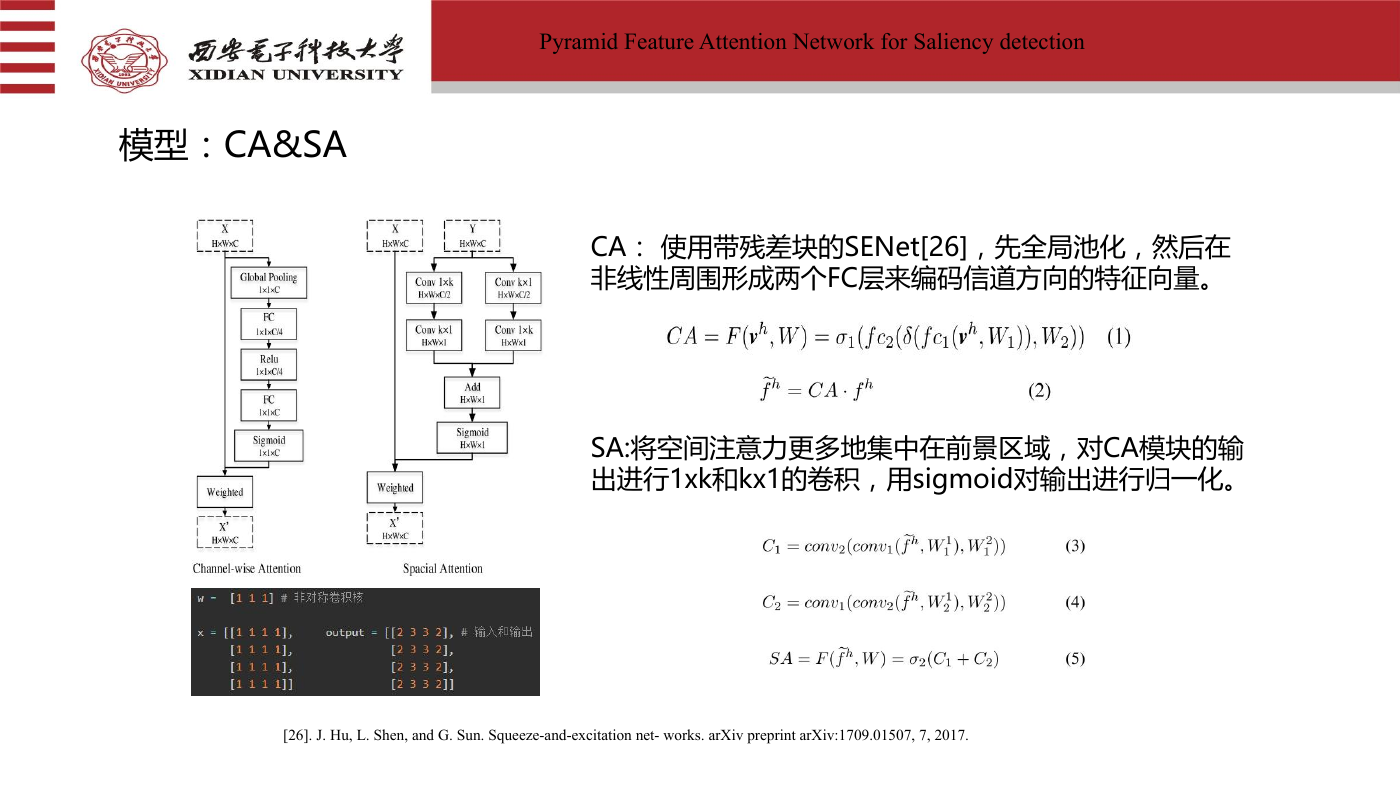

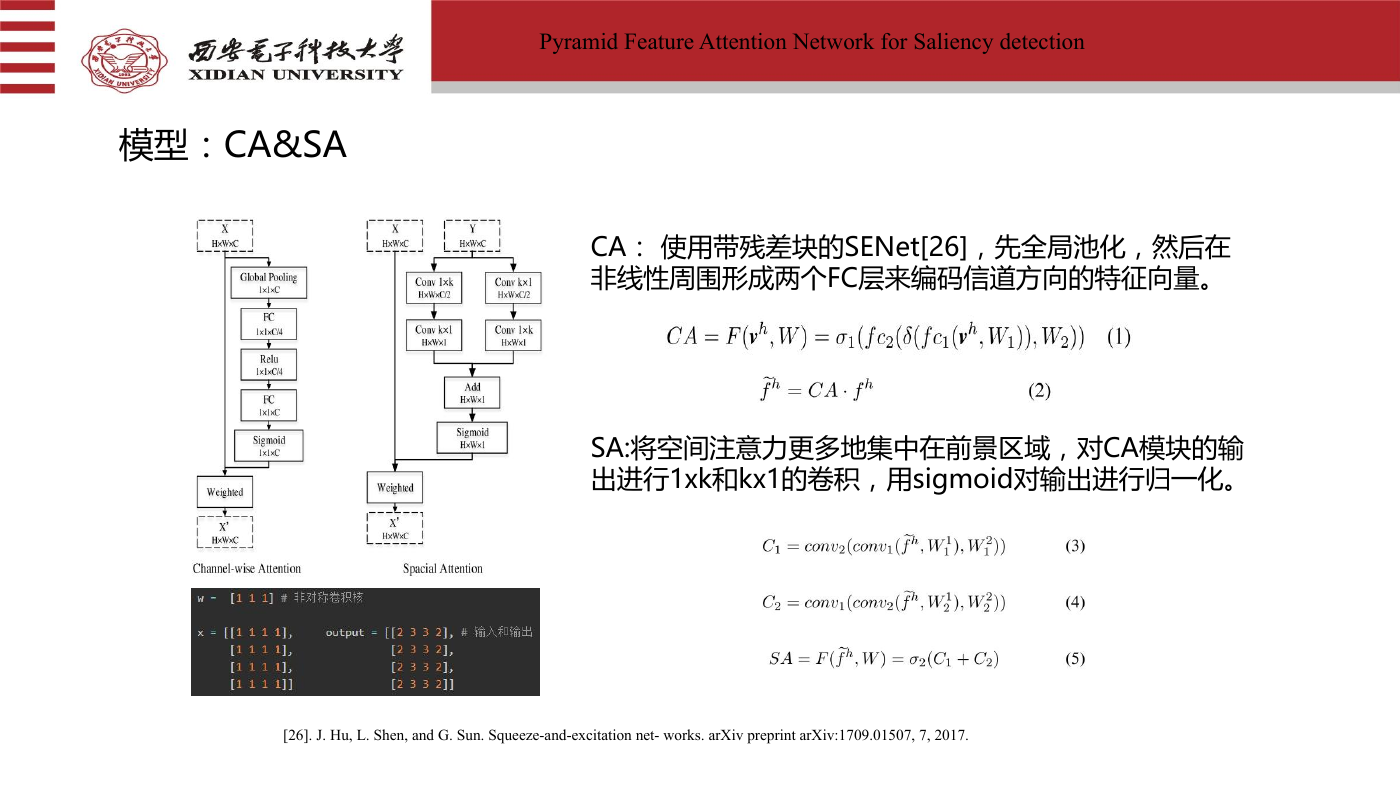

模型:CA&SA

CA: 使用带残差块的SENet[26],先全局池化,然后在

非线性周围形成两个FC层来编码信道方向的特征向量。

SA:将空间注意力更多地集中在前景区域,对CA模块的输

出进行1xk和kx1的卷积,用sigmoid对输出进行归一化。

[26]. J. Hu, L. Shen, and G. Sun. Squeeze-and-excitation net- works. arXiv preprint arXiv:1709.01507, 7, 2017.

�

Pyramid Feature Attention Network for Saliency detection

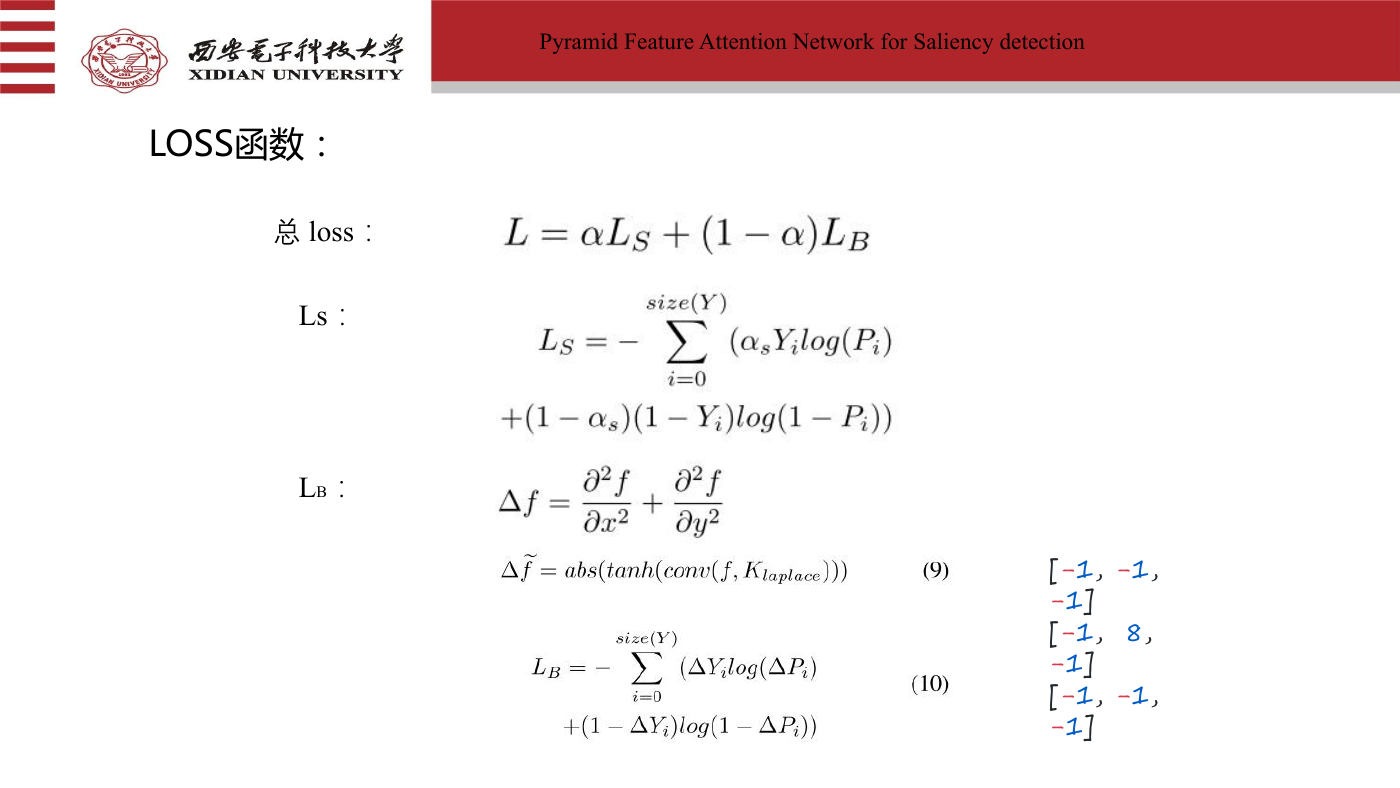

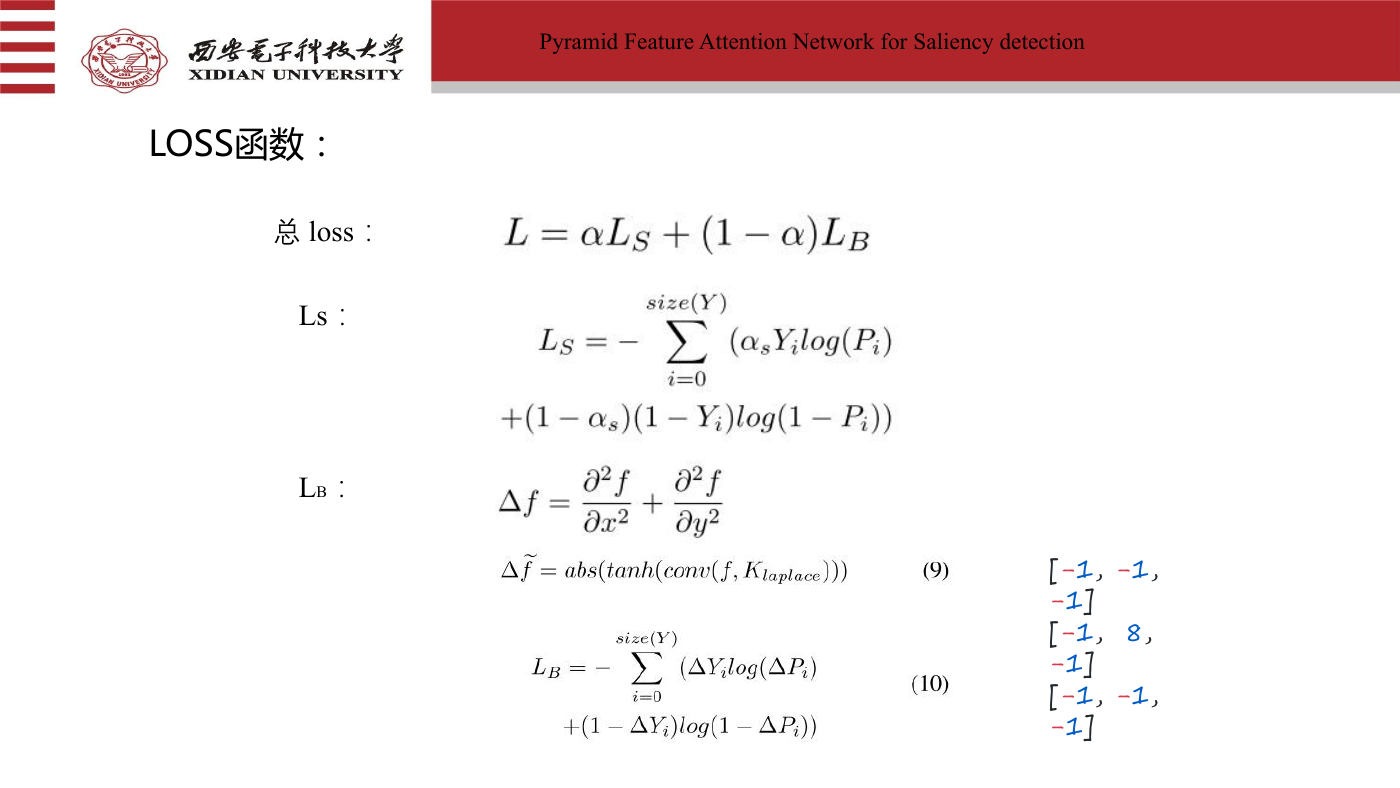

LOSS函数:

总 loss:

Ls:

LB:

[-1, -1,

-1]

[-1, 8,

-1]

[-1, -1,

-1]

�

Pyramid Feature Attention Network for Saliency detection

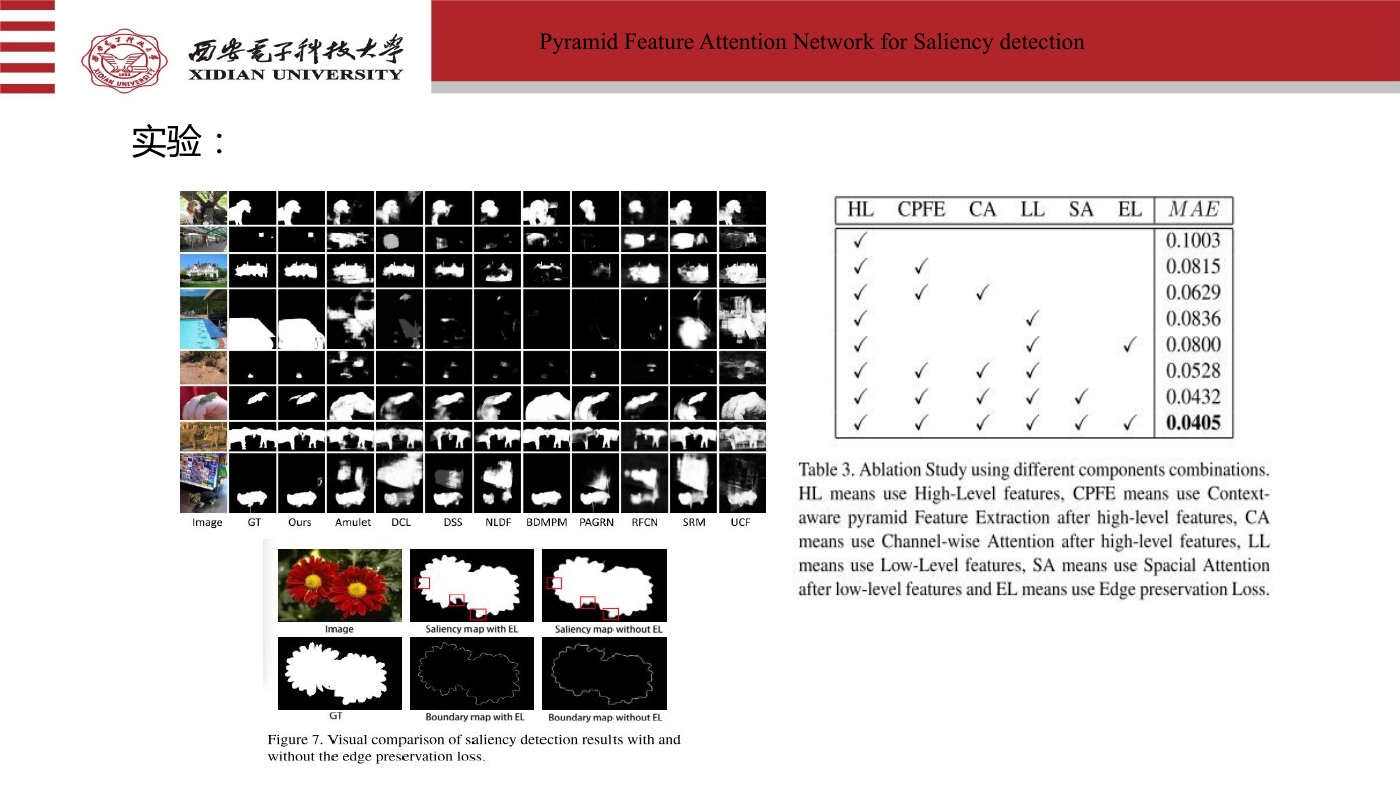

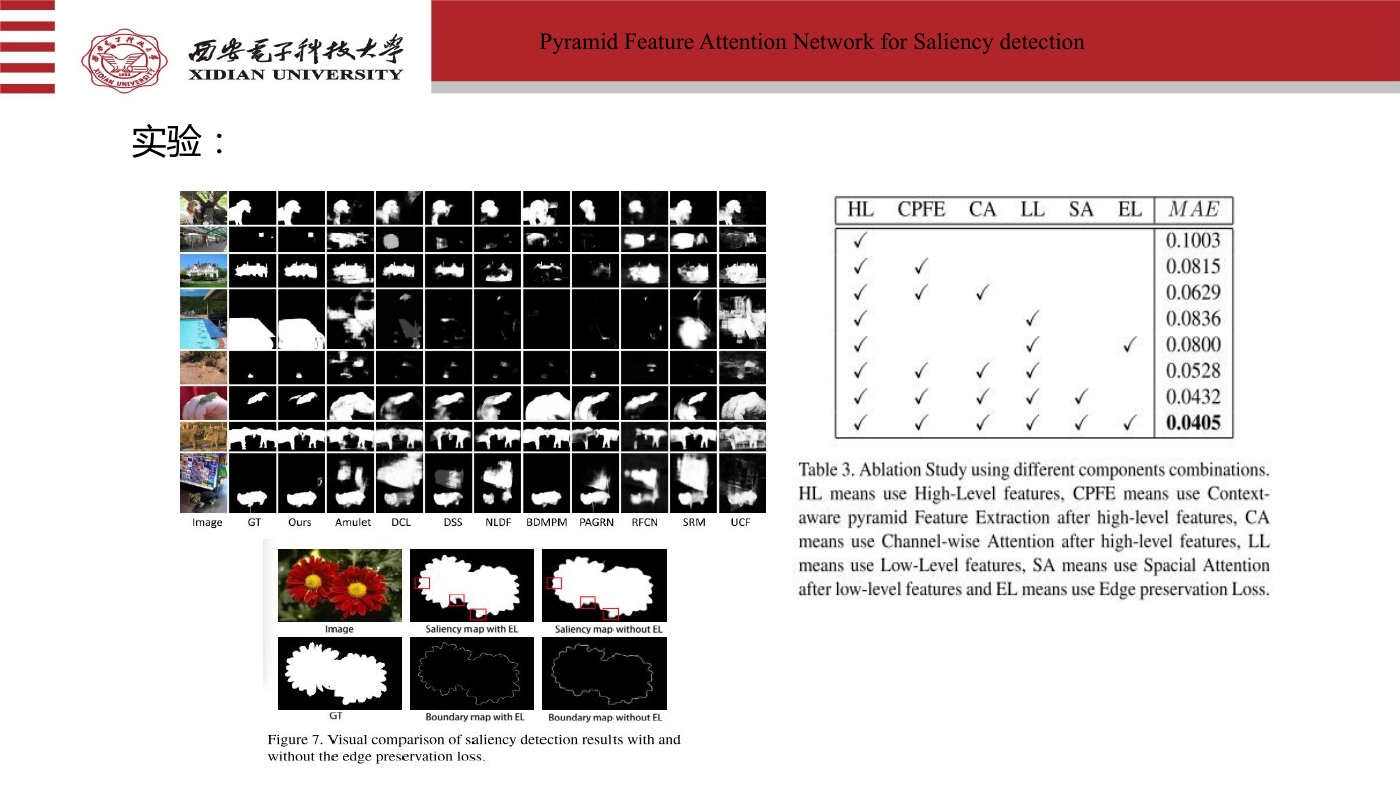

实验:

�

2023年江西萍乡中考道德与法治真题及答案.doc

2023年江西萍乡中考道德与法治真题及答案.doc 2012年重庆南川中考生物真题及答案.doc

2012年重庆南川中考生物真题及答案.doc 2013年江西师范大学地理学综合及文艺理论基础考研真题.doc

2013年江西师范大学地理学综合及文艺理论基础考研真题.doc 2020年四川甘孜小升初语文真题及答案I卷.doc

2020年四川甘孜小升初语文真题及答案I卷.doc 2020年注册岩土工程师专业基础考试真题及答案.doc

2020年注册岩土工程师专业基础考试真题及答案.doc 2023-2024学年福建省厦门市九年级上学期数学月考试题及答案.doc

2023-2024学年福建省厦门市九年级上学期数学月考试题及答案.doc 2021-2022学年辽宁省沈阳市大东区九年级上学期语文期末试题及答案.doc

2021-2022学年辽宁省沈阳市大东区九年级上学期语文期末试题及答案.doc 2022-2023学年北京东城区初三第一学期物理期末试卷及答案.doc

2022-2023学年北京东城区初三第一学期物理期末试卷及答案.doc 2018上半年江西教师资格初中地理学科知识与教学能力真题及答案.doc

2018上半年江西教师资格初中地理学科知识与教学能力真题及答案.doc 2012年河北国家公务员申论考试真题及答案-省级.doc

2012年河北国家公务员申论考试真题及答案-省级.doc 2020-2021学年江苏省扬州市江都区邵樊片九年级上学期数学第一次质量检测试题及答案.doc

2020-2021学年江苏省扬州市江都区邵樊片九年级上学期数学第一次质量检测试题及答案.doc 2022下半年黑龙江教师资格证中学综合素质真题及答案.doc

2022下半年黑龙江教师资格证中学综合素质真题及答案.doc