AT-GAN:一个生成对抗网络中用于对抗迁

移的生成攻击模型

Xiaosen Wang, KunHe

School of Computer Science and Technology

Huazhong University of Science and Technology

Wuhan 430074, China

{xiaosen,brooklet60}@hust.edu.cn

Chuan Guo, Kilian Weinberger, John Hopcroft

Department of Computer Science, Cornell University

Ithaca 14853, USA

{cg563,kilian,jeh}@cornell.edu

摘要

目前的一些研究发现了深度神经网络对对抗样本的不稳健性,这些对于人类

来说难以察觉的对抗样本却能够轻易的欺骗深度神经网络 DNNs。现存的用于生

成对抗样本的方法主要是在原图像上加上一些轻量级扰动,所以其最终生成的对

抗样本也受到原正常样本的限制,即对抗样本与原正常样本间的矩阵范数会很小。

在本文中,我们提出一个名为 AT-GAN 的新攻击模型。AT-GAN 能够使用生成对

抗网络(GANs)由随机噪声直接生成对抗样本。其核心要义是对要攻击的目标

分类器迁移一个预训练的 GAN 来生成对抗样本。一旦建立的模型进行迁移并用

于攻击,AT-GAN 能够很有效的生成多样化的对抗样本。因而 AT-GAN 能够潜在

的加速在防御方面的对抗训练。我们在 MNIST 数字手写数据库上运用典型防御

方法并在灰箱和黑箱的环境下对 AT-GAN 进行了评估。经过大量的与现有的基

准攻击方法的对比显示 AT-GAN 能够达到更高的攻击成功率。

�

1 绪论

深度神经网络(DNNs)于近几年在计算机视觉的一些任务中展示出了极其

优异的性能(Krizhevsky 等人, 2012; He 等人, 2016)。然而,DNNs 却被发现容易

受到对抗样本的欺骗(Szegedy 等人, 2014)。根据鲁棒性和安全方面的含义,这

种用于产生对抗样本的方法叫做攻击。同时一般将对抗攻击分为有目标的攻击和

无目标的攻击等两类。有目标的攻击目的在于生成能够被归为特定类别的对抗样

本,而无目标的攻击的目标在于生成无法归类正确的对抗样本。诸如 Fast

Gradient Sign (FGSM) (Goodfellow 等人., 2015)和 Carlini-Wagner 攻击(C&W)

(Carlini and Wagner, 2017)等的各式算法(Yuan 等人., 2017)被提出,并用于生成

对抗样本。而对抗样本也可以用到训练中去来提高模型的鲁棒性,这也是被称为

对抗训练的流行且有效的防御手段(Goodfellow 等人., 2015; Kurakin 等人., 2017;

Song 等人, 2019)。

大多数的攻击算法(Goodfellow 等人, 2015; Carlini and Wagner, 2017)都是基

于梯度下降在输入端加上不可察觉的扰动来生成对抗样本,而这也意味着这样生

成的对抗样本受到原图像的限制。Xiao 等人(2018)提出训练一个把原正常图片

作为输入的生成器 来生成扰动

,故

就能够欺骗目标模型。然而他

们得到的结果仍然受到原始图像的限制。Song 等人(2018)提出一个利用目标分

类器的梯度下降搜索任意噪声矢量附近的噪声输入的方法,使得这样的输入可以

产生对抗样本。Song 等人(2018)称他们的方法的输出为不受限的对抗样本,因为

其输出不受到原正常图像的限制。然而,因为使用梯度下降在原始噪声的邻域内

寻找良好特性的噪声,故他们的输出仍受限于噪声输入。除此之外,他们的方法

涉及到对梯度下降进行数百次迭代,导致效率低下。

xG()Gx()xGx�

在本文中,我们提出了一种新的生成攻击模型 AT-GAN(在生成对抗网络上的

对抗迁移)。我们首先训练一个生成对抗网络(GANs) (Goodfellow 等人, 2014)然

后迁移标签以从随机噪声中生成对抗样本。注意到相较于 Song 等人(2018),我

们的输出真正不受限于输入。一旦我们的生成模型由生成正常图像迁移到生成对

抗图像,它能够直接由任意随机噪声输入直接产生不受限制的对抗样本,因而具

有更高的多样性。同时,我们的模型不依赖于梯度方法的迭代过程故生成过程非

常高效。

为了评估我们的攻击策略的有效性,我们尝试了几种模型从随机噪声中使用

AT-GAN 生成对抗样本,并将我们的模型与其他几种攻击方法在灰箱和黑箱攻击

中进行了比较。然后,我们应用典型的防御方法(Goodfellow 等人, 2015; Madry

等人, 2017; Tramèr 等人, 2018)来抵御这些生成的对抗样本。实验结果表明,由

AT-GAN 生成的对抗样本具有较高的攻击成功率。

我们主要的贡献如下:

与以往侧重于如何在原始图像中添加人为扰动的攻击方法不同,我们可

以由随机噪声生成不受限制的对抗实例。

与基于优化的攻击不同,我们训练了一个条件生成网络来直接生成对抗

样本,它不依赖于输入的梯度,使得基于梯度的防御更加困难,也提高

了生成过程的效率。

与少数使用 GAN 进行攻击的方法不同,我们生成的图像具有更高的多样

性,因为输出不受限于输入。

通过使用典型防御方法抵御对抗实例的大量实验表明,在灰箱和黑箱攻

击中 AT-GAN 比其他现存的对抗攻击方法可达到更高的攻击成功率。

�

2 相关工作

在本节中,我们将概述现有的用于生成对抗样本的典型的攻击方法,基于对

抗训练的各种防御方法,GANs 和基于 GANs 的几种攻击。

2.1 DNNs 的典型攻击方法

根据攻击者对模型了解程度,我们可以将攻击分为三种类型。第一类是白箱

攻击,攻击可以完全了解目标模型。第二类是灰箱攻击(Xiao 等人,2018),它在

训练时需要 logits 输出,但可以在不了解目标模型的情况下生成对抗样本。最后

一类是黑箱攻击(Papernot 等人, 2017),攻击完全不了解目标模型。现存的黑箱

攻击主要聚焦于迁移性上(Liu 等人, 2017; Bhagoji 等人, 2017),一个模型生成的

对抗实例可以直接迁移去攻击另一个模型。

接下来,我们将介绍三种流行的对抗攻击的方法。所有的对抗样本的元素都

限制在[0,1]之间。

Fast Gradient Sign Method (FGSM):FGSM (Goodfellow 等人, 2015) 在输入 x

上增加训练损失 J 梯度方向的扰动,生成对抗样本。

其中 y 是样本 x 的正确标签, 是模型参数同时 指定了 失真介于 x 和 之

(1)

间。

Projected Gradient Descent(PGD):PGD 对抗者(Madry 等人,2017) 是一个多步

骤 FGSM 变体,它用 FGSM 以预算 迭代 k 次。

(2)

((,,y))advxxxsignJxladvx0advxx1(((,,)),,)tttttadvadvadvadvadvxxclipxsignJxyxxkadvadvxx�

其中 y 是样本 x 的正确标签, 是模型参数, 为扰动上界且

强制输

入 x 留在[p,q]范围内。

Carlini-Wagner’s

attack (CW-

):CW-

(Carlini and Wagner, 2017)是一种

基于优化的攻击方法,其将模型分类精度的可微代换 g 与 -惩罚项相结合。对

于一个输入 x,它将会选择一个目标类别 (且此

,

是网络的输出)

并且寻找一个 来最小化以下等式

(3)

其中

并且

是对输入 x 计算 logits

向量(即 softmax 层之前的输出)的操作。参数

将激励求解器找到可以以高置

信度被归类为目标类别 t 的对抗实例 。更大的参数 可以致使对抗样本更能够

被归为某一类。 随着每一次的迭代而逐渐减小且是 失真的一个估计。

2.2 DNNs 中的防御手段

虽然有诸如检测对抗干扰(Metzen 等人, 2017)、模糊梯度(Buckman 等人, 2018;

Guo 等人, 2018)以及消除扰动(Shen 等人, 2017; 等人, 2018)等的各式防御策略,

各种的对抗训练才是最为有效的方法(Athalye 等人, 2018)。因此,我们也将仅主

要介绍对抗训练的方法。

Adversarial training:Szegedy(2014)和 Goodfellow(2015)等人首次引入对抗训练

方法,将神经网络的标准损失函数 f 修改为如下:

(4)

其中 y 是样本 x 的真实标签且 是模型的参数。改进后的目标是通过对计入对抗

样本进行惩罚来使得神经网络更加鲁棒。在训练期间,通过神经网络的当前状态

计算对抗样本。取 FGSM 作为例子,相应的损失函数可以写为:

(,,)clipxpqllllty(x)tyf(x)fmin ()[max((),0)]iicgx()max(max{():}Z(),)tytygxZxyyxZ()x0xl(,,y)(,,y)(1)(,,y)advffJxJxJx�

(5)

Ensemble adversarial training: Tramèr 等人(2018)提出了一种集合对抗训练的方

法。与对抗训练不同,这里的 DNN 使用从一些固定的预训练过的模型迁移过来

的对抗样本来进行训练。

Iterative adversarial training:Madry 等人(2017)提出使用由诸如 PGD 等迭代方

法生成的对抗样本来训练 DNN。

2.3 生成对抗网络(GANs)

一个生成对抗网络(GAN) (Goodfellow 等人,2014)由两个相互对立训练的神

经网络组成。生成器 G 通过优化来估计数据的分布,而鉴别器 D 的目标是区别

出来自 G 的虚假样本和来自训练集的真实样本。因此 D 和 G 的目标可以表述为

一个最小-最大值函数

:

(6)

条件生成对抗网(CGAN) (Mirza and Osindero, 2014)是 GAN 的第一个条件版本,

它将条件与生成器和鉴别器的输入结合起来。Radford 等(2016)提出了一种深度

卷积生成对抗网(DCGAN),该网络利用卷积网络实现 GAN,并在训练过程中逐步

稳定模型。辅助分类器 GAN (AC-GAN)是 GAN 的另一种变体,它通过一个额外

的分类器在一定条件下扩展 GAN (Odena 等人,2017)。它的目标函数如下:

(7)

2.4 基于 GANs 的 DNNs 的攻击

基于 GANs 的攻击有少数几种,包括 AdvGAN(Xiao 等人,2018)、非受限对

抗攻击(Song 等人, 2018)。基于 GANs 的防御方法有诸如 DeepDGA(Anderson 等

(,,y)(,,y)(1)(,((,,)),y)ffxJxJxJxsignJxy(,)VGD(x)(z)minmax(,)[log()][log(1(G(z)))]datazxpxpGDVGDEDxED(x)(z)(x)(z)minmaxmax(,)[log()][log(1(G(z)))] +[log(1(,))][logC(G(z,y),y)]datazdatazxpxpGDCxpxpVGDEDxEDECxyE�

人, 2016)、Defense-GAN (Samangouei 等人,2018)及 APE-GAN (Shen 等人,

2017)等。在本章节中,我们将会介绍与 AT-GAN 相近的 AdvGAN 和非受限对抗

攻击两种攻击。

AdvGAN:Xiao 等人(2018)提出以正常图像 x 为输入训练 AdvGAN 来产生扰动

G(x),并使目标分类器 f 将 x + G(x) 分类到目标类别 中。其目标函数表示为:

(8)

Unrestricted adversarial attacks:Song 等人(2018)提出在任意噪声向量 搜

索一个噪声输入 用于 AC-GAN 来为目标模型 f 产生对抗样本

。目标函

数写为:

(9)

我们提出的模型主要是基于 AC-GAN 实现的,但我们有不同的目标函数。我

们的目标是生成的图像不仅在视觉上是真实的,而且会是目标分类器不能鉴别处

理而错误分类的。我们的方法和上述的攻击也都不同,具体见接下来的章节。

3 由随机噪声生成对抗样本

要使能够由随机噪声生成对抗样本,我们应该找到一个满足以下条件的生成

器

:

(10)

这里的

是要攻击的分类器,z 为随机噪声,y 是真实标签, 是目标标签,

同时 代表标签为 y 的图像的集合。

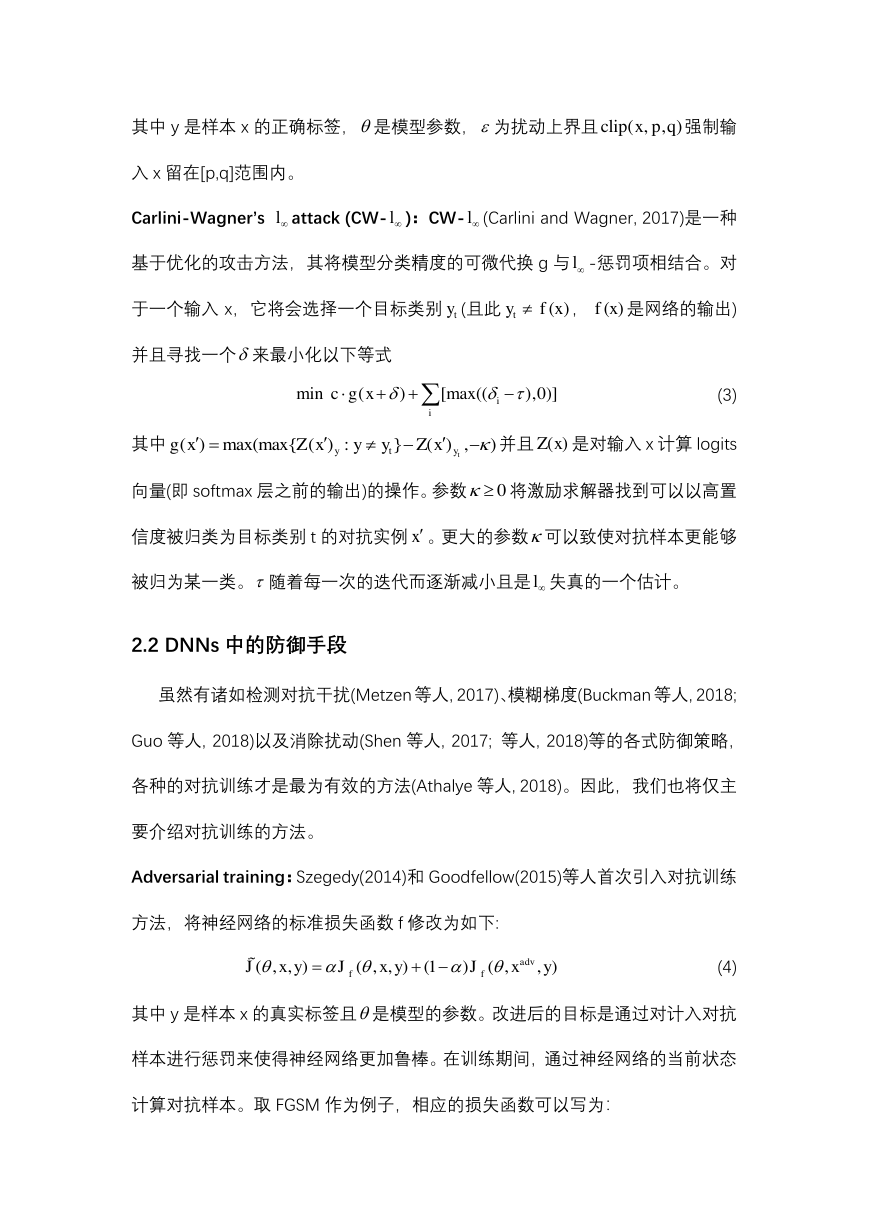

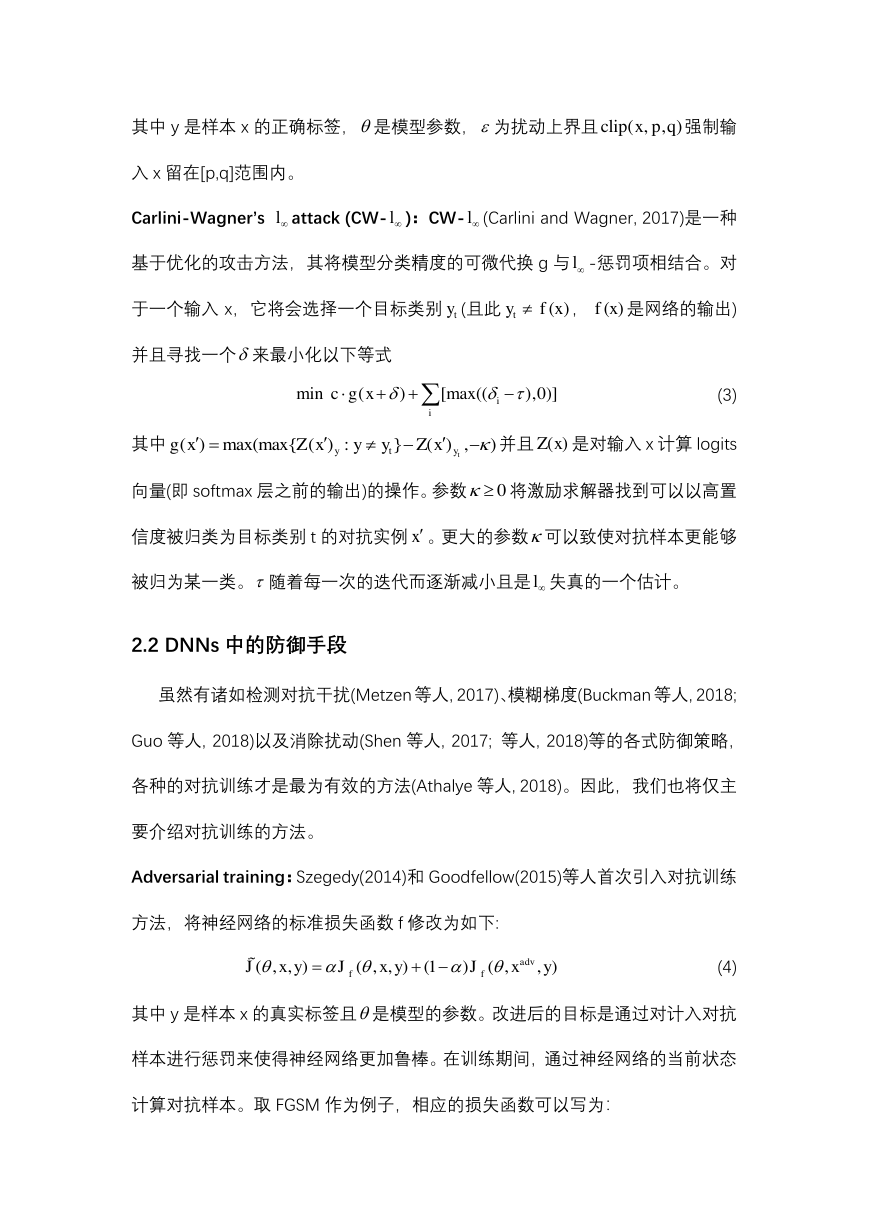

然而这个问题却难以求解,故我们提出了一个新的名为 AT-GAN 的模型,如

图 1 所示。训练 AT-GAN 有两个阶段。在第一阶段,我们训练 GAN 模型来生成

ty(z)2minmax(,,)E[log()]E[log(1(()))] +E((),y)Emax(0,||G()||c)zxzPGDxtxVGDfDxDxGxfxGxx0z*z*(,)sGzy*0*11argminmax{|zz|,0}log((,),)miistzizfGzyymattackGtarget(G(z,y)) .. (z,y)S,attacktattackytfystGyytargetftySy�

图像,故可以得到一个生成器

。然后,我们迁移

来攻击

图 1: AT-GAN 的结构 AT-GAN 相似于 AC-GAN 且第一阶段训练为 AC-GAN。对 G 进行

训练后,复制原始模型

来得到初始攻击模型

并且根据要攻击的目标分类器迁

移

。经过训练后,AT-GAN 可以由

生成对抗样本

3.1 训练初始生成器

图 1 中的左边部分说明了原始 AC-GAN 的总体架构。且此处有三个神经网

络:一个生成器 G、一个鉴别器 D 和一个分类器 f。生成器 G 以随机噪声 z 作为

输入并以标签 y 作为输出来生成图像

。它的目标是生成一张鉴别器 D 不

可区分的图像

且使分类器 f 输出标签 y。G 的损失函数为:

(11)

这里的 H(a,b)为 a 和 b 之间的熵。鉴别器 D 以训练数据 x 和生成的数据

作为输入并尝试取区分它们。D 的损失函数可以写为:

(12)

分类器 f 则将训练数据 x 和生成的数据

作为输入并预测相应的标签。与其

他分类器一样,模型仅在训练数据上进行训练。分类器的损失函数为:

(13)

这一阶段的目标就是训练一个生成器 G,其能够输出真实的样本,所以之后我们

originalGoriginalGtargetforiginalGattackGattackGattackG(,)Gzy(,)Gzy(z)(z)(x,y)E(D(G(z,y)),1)E(f(G(z,y)),y)zzGzPzpLHH(,)Gzy(x)(z)(x,y,z)E(D(x),1)E(D(G(z,y)),0)datazDxpzpLHH(,)Gzy(x)(x,y)E(f(x),y)datafxpLH�

2023年江西萍乡中考道德与法治真题及答案.doc

2023年江西萍乡中考道德与法治真题及答案.doc 2012年重庆南川中考生物真题及答案.doc

2012年重庆南川中考生物真题及答案.doc 2013年江西师范大学地理学综合及文艺理论基础考研真题.doc

2013年江西师范大学地理学综合及文艺理论基础考研真题.doc 2020年四川甘孜小升初语文真题及答案I卷.doc

2020年四川甘孜小升初语文真题及答案I卷.doc 2020年注册岩土工程师专业基础考试真题及答案.doc

2020年注册岩土工程师专业基础考试真题及答案.doc 2023-2024学年福建省厦门市九年级上学期数学月考试题及答案.doc

2023-2024学年福建省厦门市九年级上学期数学月考试题及答案.doc 2021-2022学年辽宁省沈阳市大东区九年级上学期语文期末试题及答案.doc

2021-2022学年辽宁省沈阳市大东区九年级上学期语文期末试题及答案.doc 2022-2023学年北京东城区初三第一学期物理期末试卷及答案.doc

2022-2023学年北京东城区初三第一学期物理期末试卷及答案.doc 2018上半年江西教师资格初中地理学科知识与教学能力真题及答案.doc

2018上半年江西教师资格初中地理学科知识与教学能力真题及答案.doc 2012年河北国家公务员申论考试真题及答案-省级.doc

2012年河北国家公务员申论考试真题及答案-省级.doc 2020-2021学年江苏省扬州市江都区邵樊片九年级上学期数学第一次质量检测试题及答案.doc

2020-2021学年江苏省扬州市江都区邵樊片九年级上学期数学第一次质量检测试题及答案.doc 2022下半年黑龙江教师资格证中学综合素质真题及答案.doc

2022下半年黑龙江教师资格证中学综合素质真题及答案.doc