网络首发时间:2019-07-30 16:04:02

网络首发地址:http://kns.cnki.net/kcms/detail/11.2107.TM.20190730.1531.005.html

中 国 电 机 工 程 学 报

Proceedings of the CSEE 1

DOI:10.13334/j.0258-8013.pcsee.182498 中图分类号:TM 71 文献标志码:A 学科分类号:470-40

基于 Multi-Agent 异步深度强化学习的居民住宅能

耗在线优化调度研究

张虹 1,申鑫 1,穆昊源 2,刘艾冬 1,王鹤 1

(1. 东北电力大学电气工程学院,吉林省 吉林市 132012;

2. 伦敦大学城市学院电气电子工程学院,伦敦市 英国 EC1V 0HB)

Research on Online Optimal Dispatching of Residential Energy Consumption Based on

Multi-Agent Asynchronous Deep Reinforcement Learning

ZHANG Hong1,SHEN Xin1,MU Haoyuan2,LIU Aidong1,WANG He1

(1. School of Electrical Engineering, Northeast Electric Power University, Jilin 132012, Jilin Province, China;

2. Department of Electrical & Electronic Engineering, City, University of London, London EC1V 0HB, the

United Kingdom)

ABSTRACT: To promote the flexible load participating in

本文在智能电网环境下,根据用电设备的特性,以概率论

demand

response

efficiently,

this

paper

applied

的角度对家电设备状态进行描述定义,基于异步深度强化

asynchronous deep reinforcement

learning (ADRL)

to

optimize

the online scheduling of household energy

management system, helping customers transition from a

passive to an active role and achieving the maximum benefit.

According to the characteristics of electrical equipment, we

described the state of appliances from the perspective of

学习(asynchronous deep reinforcement learning,ADRL)进

行家庭能源管理系统调度的在线优化。学习过程采用异步

优势演员-评判家(asynchronous advantage actor-critic,

A3C)方法,联合用户历史用电设备运行状态的概率分布,

通过多智能体利用 CPU 多线程功能同时执行多个动作的

决策。该方法在包括光伏发电、电动汽车和居民住宅电器

probability

theory

in

the smart grid context. The

设备信息的某高维数据库上进行仿真验证。最后通过不同

asynchronous advantage actor-critic (A3C) method was

住宅情境下的优化决策效果对比分析可知,所提在线能耗

proposed to simultaneously perform multi-action decisions

调度策略可用于向电力用户提供实时反馈,以实现用户用

with the probability distribution of historical operating state

电经济性目标。

via multi-agent using the CPU multi-threading function. The

proposed method was validated on a large-scale database,

which

includes

information about photovoltaic power

generation, electric vehicles as well as residential appliances.

Finally, the comparative analysis of decision-making effects

show that online energy consumption scheduling strategies

can achieve economic goals by providing real-time feedback

to consumers.

KEY WORDS : asynchronous advantage actor-critic ;

response ; probability distribution ; online

demand

optimization;multi-agent;multi-action decisions

摘要:为促进居民用户柔性负荷高效参与需求响应,帮助

用户从被动角色转变为主动角色,实现需求侧最大效益。

基金项目:国家自然科学基金项目(51777027);吉林省科技计划重

点研发项目(20170520100JH,20180201010GX)。

National Natural Science Foundation of China (51777027); Key

关键词:异步优势演员-评判家;需求响应;概率分布;

在线优化;多智能体;多动作决策

0 引言

目前,智能电网已成为世界电力网络发展的

大趋势[1],而智能用电作为其重要组成部分,通

过与电网侧的电力流、信息流和业务流的实时互

动参与需求响应[2]。随着居民智能用电的快速发

展,用户可调节的柔性负荷大量增加[3],如空调、

洗碗机以及电动汽车等可控负荷,导致智能电网

中增加商业交易和电力物流的不确定性和复杂性。

因此,从需求侧大量高维融合数据理解个人用电

行为及其使用影响成为需求响应研究的热点。如

何从用户角度出发、考虑用户电器设备的运行状

态的时间分布特征、满足用电负荷的实时调度需

Research and Development of Technology Plan of Jilin Province

China(20170520100JH,20180201010GX).

�

2

中 国 电 机 工 程 学 报

求以达到用户侧经济性最优成为亟待解决的课题。

在少量训练样本和无关特征数据的前提下,使用

深度置信神经网络对电力系统暂态稳定性进行快

速精准评估。文献[12]应用 SARSA 和 Q 学习算

法求解用电设备调度问题,但缺乏时效性考虑,

没有充分利用用户侧高维数据;文献[13-14]分别

将自动学习机和 Q 学习算法应用在需求响应上,

在快速优化的前提下,使用户支出费用最小化,

但没有考虑用户设备的运行状态分布和用电习惯。

异步演员-评判家(Asynchronous Advantage

Actor-Critic,A3C)是一种包含对数据感知能力的

基于概率选择的分布式智能算法,由于决策速度

快、鲁棒性强、异步并行处理等特点,在决策领

域得到广泛应用[15-17]。本文首先根据用户历史用

电数据,建立了一种基于设备运行状态概率分布

的居民用电任务调度优化模型,并根据负荷运行

概率特性对家庭用电任务进行分类;其次,通过

联合设备运行状态概率分布,以离线学习在线评

估的方式,利用 CPU 多线程功能实现了住宅多设

备的在线决策优化;最后,分析了该方法的收敛

能力、稳定性和时效性。通过对算例的求解表明

该方法在线实时进行住宅负荷调度的有效性和正

确性。

1 居民住宅负荷调度策略建模

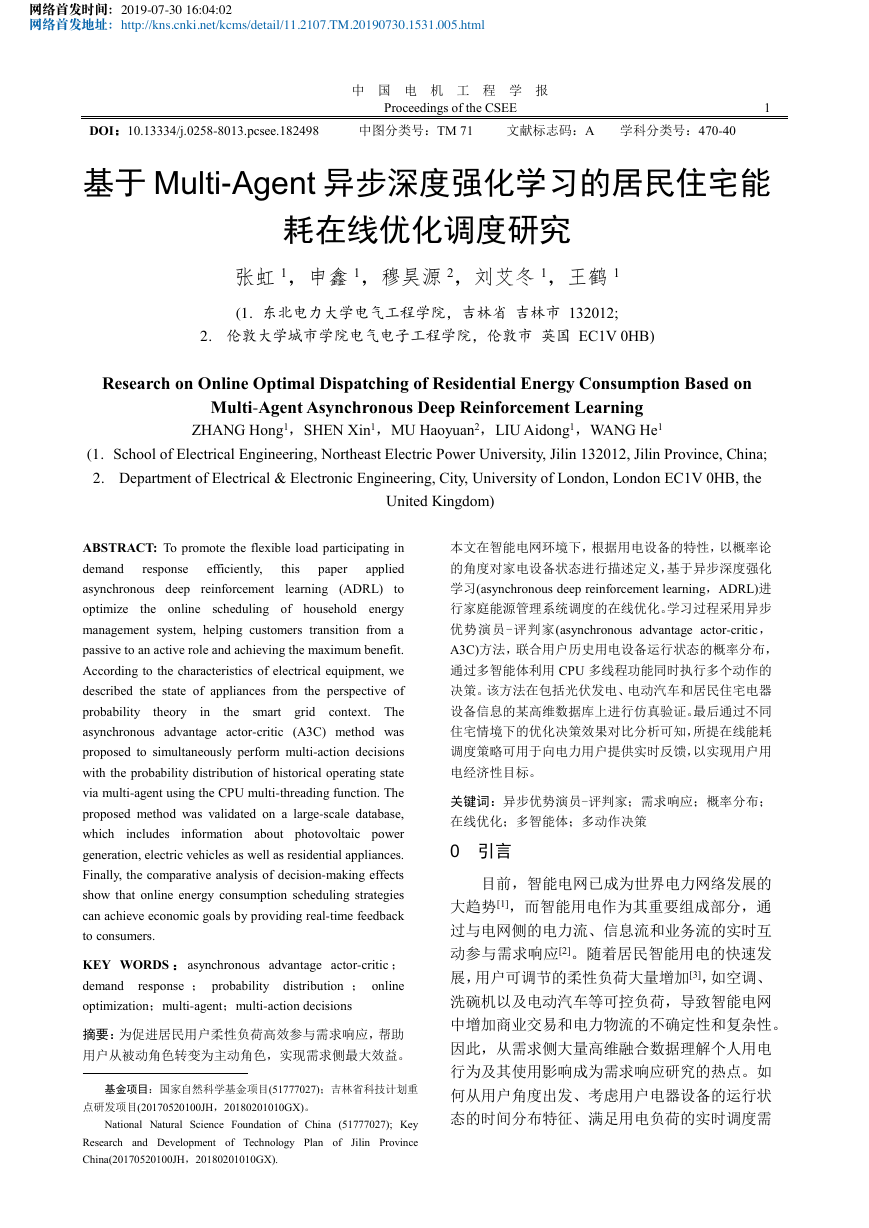

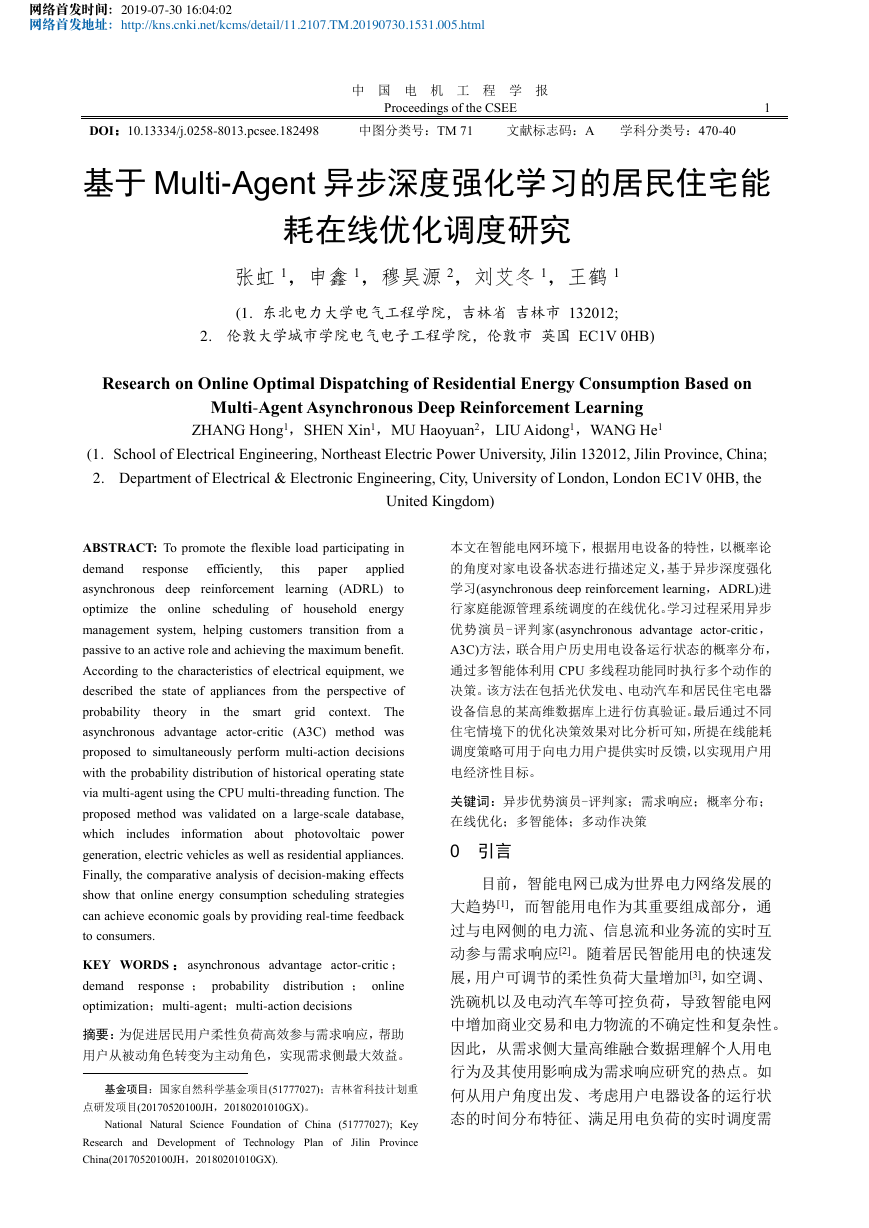

1.1 居民住宅用电场景分析

本文基于奥斯汀市某地区的实测数据进行研

究分析。如图 1 所示,该地区已完全实现居民智

能用电,能源供应商为同一电力公司,电价采用

由电力公司制定的分时电价政策。在本地区每家

居民用户均装有高级量测体系,用以实现用户侧

与电网侧的双向实时互动功能,用户可以通过户

用能耗调度中心(Energy consumption dispatching

center,ECDC)参与电力调度。能源供应商为住宅

用户提供的交互式网络应用程序允许用户监控每

日能耗,查看账单历史记录和未来预测的能源成

本账单。本地区的用户侧存在电动汽车负荷以及

分布式电源即户用分布式光伏发电。

用户侧的实际响应行为体现在家庭中各类电

器设备的运行状态上,因此居民住宅的优化调度

主要研究电器设备层面的用电负荷响应。目前,

很多国内外学者对家庭用电设备层面进行了大量

研究并提出了相应的各种算法。文献[4]提出了一

种基于混合编码遗传算法用于求解家庭用电任务

调度问题,通过对单目标和多目标的求解验证了

该算法的可行性,可以较好地完成家庭用电任务

的调度。文献[5]利用粒子群算法对提出的智能家

居负荷优化调度问题进行了求解,综合结合分布

式能源的特性实现了用户侧净效益最大化的目标。

文献[6]提出了一种家用电器运行调度的优化模

型,建立 eBox 软件框架,最后采用混合整数线

性规划问题对优化问题进行求解,实现在 1 分钟

之内快速求解优化调度方案。文献[7]提出了一种

新的需求侧管理技术,使用线性规划来计算确定

性调度解决方案从而安排家用电器进行操作,以

便根据时变定价模型最小化用户的电费支出。文

献[8]在不泄露私人用电习惯的敏感信息的基础

上,以家庭用户最小电费支出为目标函数,使用

博弈论构建了一种居民家庭智能电器设备的优化

调度方法,实现了保护用户隐私和经济性最优的

目标。

上述文献对于居民负荷调度的研究方法包括

了集中式[4-5]和分散式[6-8]解决方案,但这些方法

都没有考虑到大型真实数据库的在线解决方案。

具体地说,当这些传统方法进行优化时,必须完

全或部分地计算所有可能的解决方案,并选择最

佳的解决方案。这种计算模式导致传统优化过程

很耗时且容易陷入局部最优。在大数据时代,机

器学习方法可以对历史数据连续变换来进行学习,

这种强大的机器学习模型通过与深度神经网络结

合后能够快速提取、控制和优化家庭用电设备模

式来克服这一限制,以应对各种复杂模式下的高

度不确定性。

近年来,由于深度学习对大数据的快速处理

能力、高精度预测能力以及强化学习精准高速的

决策能力,使得新一代人工智能在电力系统中取

得很多进展。文献[9]提出使用极限学习机的方法

在线评估建筑物的能耗,在考虑主建筑围护结构

参数与区域供暖和制冷负荷之间的相关性的前提

下,大幅度的提高了预测时间和精度;文献[10-11]

�

3

而通过用户的历史用电数据可以知道在

,

设备 a 变成准备状态的概率

。附录 A 中

给出了在任意的时段 t 由于出现新任务,设备 a

在时段 t+1 变成准备模式的概率

为

(1)

图 1 家庭能量管理系统

Fig.1 Household energy management system

本文将家电设备集合划分为固定运行设备集

合和可控制运行设备集合。

表示设备必须运行

的且不可以调控, ECDC 没有权限对该类设备进

行调控。可控制运行设备集合分为可延迟设备集合

1.2 家庭用电设备建模

本 文 将 居 民 住 宅 的 调 度 时 间 设 定 在

0:00-24:00 范围内,对一天进行等时段划分,时

段 数 集 合 为 H={1,…t…,T} 。 住 宅 用 户 集 合

B={1,…i…,N},电气设备 Di={1,…a…,m},iB。

在每个任务时段上,设备 a 的状态分为准备状态

和睡眠状态,设备 a 在准备时段上挑选时段执行

任务。

定义 1 对于iB,设备 aDi 在时段 tH 运行

状态

由三元组表示。

和可中断设备集合 两类。 表示该类设备

可延迟时间工作,例如洗衣机和洗碗机等。ECDC

指导其在几个连续时段工作,但不可以中断设备工

作; 指该类设备用电可以随时中断,例如空调

和电动汽车等。ECDC 可中断或延迟该类设备的运

行。

定义 2 对于

术参数组成。

,设备 a 的任务规范由三个技

1) :表示执行用电任务消耗的平均功率。

2)

:时间窗口

表示任务的最

1)

表示将当前用电任务完成需要运行

早开始时间

和截止时间

。

的剩余时段数。

2)

表示当前用电任务可延迟的时段数。

3) 表示当前时刻设备所处的时段编号。

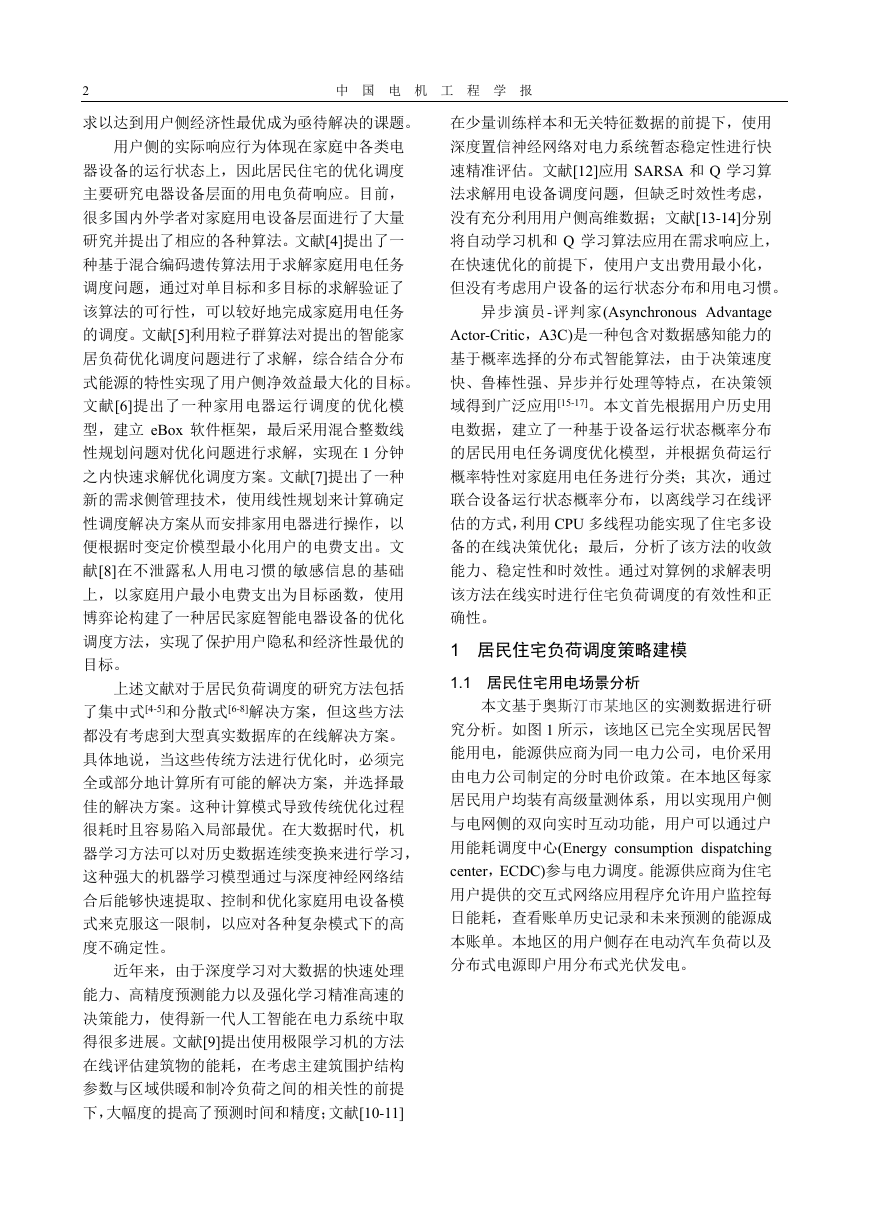

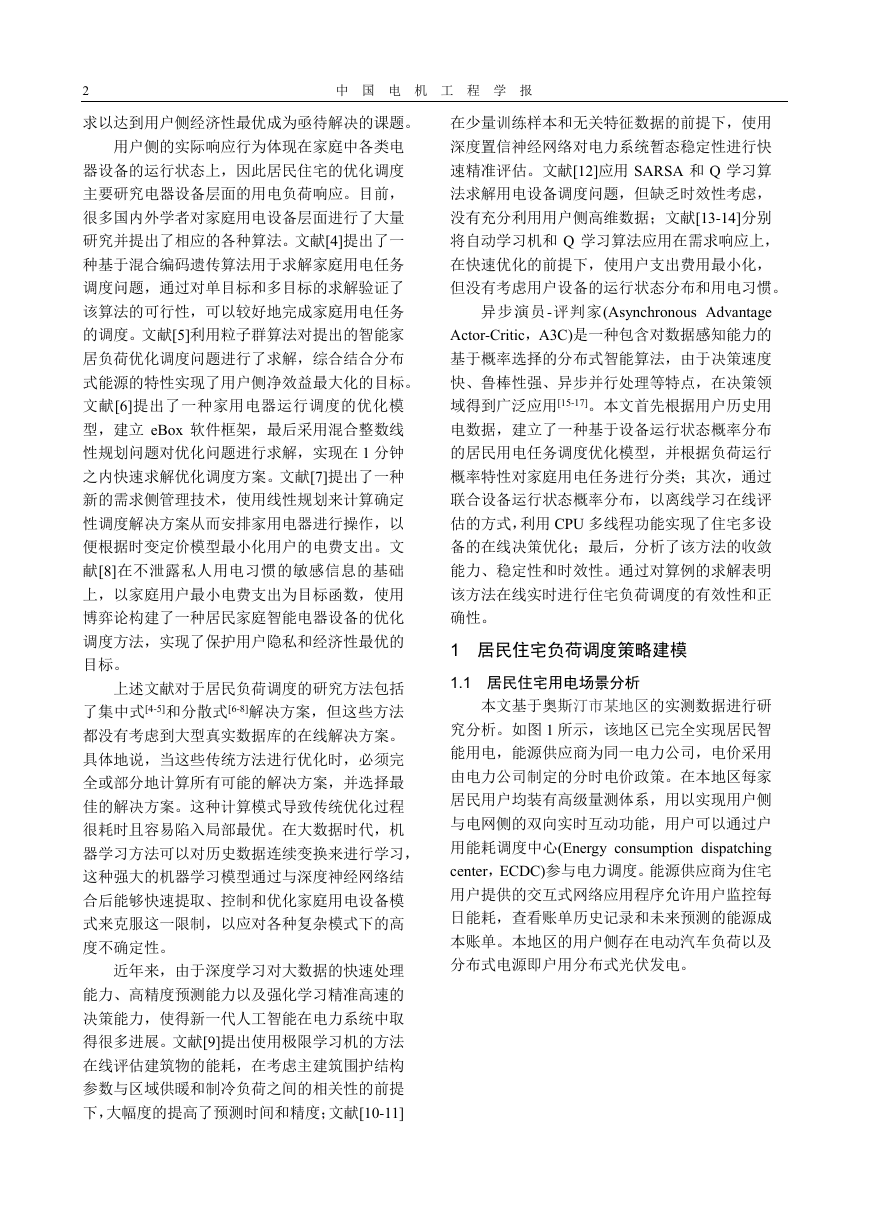

图 2 表示具有需要运行 3 个时段且最大延迟

时段数为 3 的用电任务时,设备 a 处于不同时段

时的

值的变化情况。其中, 随

着任务的进行逐渐减小,当设备完成任务处于睡

的初始值由用户设定,值为

眠状态时值为 0;

0 时,ECDC 不能延迟用电任务;在一个任务中,

时段编号 随时段数增加而增加,由 值可

确定

、 进而获得设备 a 运行状态。当设

备 a 有新任务时,设备由睡眠状态转为准备状态,

此时 复位为 1。

3) :表示

,设备完成任

务需要的时段数。

:表示

,设

备完成任务所需时段数的最小值和最大值。

本文使用二进制决策向量

{0,1}表示设

备的工作情况, =1 表示设备启用,反之表示

设备中断。因此,住宅 i 所有的用电设备可由调

度二进制决策向量 表示:

(2)

1.3 家庭用电设备概率状态描述

1.3.1 固定运行设备

,在时段 tH 时,设备 a 的可操作动

作可用下式表示:

图 2 运行状态三元组示意图

给定时段 t,在 t+1 时段设备的运行状态可以

Fig.2 Three tuple schematic diagram of operation state

ECDC 调度前不知道设备何时处于准备模式,

用以下两种模式表示:

1)当设备

=0 处于睡眠模式或在当前时

(3)

...用户调度中心on/off...分时电价消耗功率预估电费设备设置智能电表照明设备电动汽车空调洗碗机能量流命令流信息流,,,,,,,,(,,)aitaitaitaitq=s,,ait,,aitq,,ait,,,,,,,,aitaitaitq,,ait,,aitq,,ait,,ait,,ait,,aitq,,ait,,ait,,aitq,,ait 准备 睡眠 准备 睡眠t耗电量1 2 3 4 5 6 7 8 1 2 3 4 5 6 7 8 93 2 1 1 1 0 0 0 3 2 1 0 0 0 0 0 03 3 3 2 1 1 0 0 3 3 3 3 2 1 0 0 0===,,1ait,,,()aiaitP,,+1aitP()(),,,,,,,11,1aitaiaitaitaiPPP+−=−FiDTiDIiDTiDIiDiaD,avgaiP,,[,]sdaiaitt,,[,]sdaiaitt,saitH,daitH,aid{,}FTiiaDDminmax,,[,]aiaiddIiaD,,aitx,,aitxix1,11,21,1,12,12,22,2,2,1,2,,T,1,2,,....................................tTtTiaaataammmtmTmxxxxxxxxxxxxxxxx==xxxxxFiaD ,,,,,,1,10, 0aitaitaitx==,,ait�

4

中 国 电 机 工 程 学 报

=1 即将完成任务时,设备 a 以

段

的概

率在时段 t+1 变为准备模式,对应的下一个状态

为

(4)

在时段 t+1,设备 a 以 1-

眠模式,对应的下一状态为

的概率变为睡

务时,设备 a 以

备模式,对应的下一个状态为

的概率在时段 t+1 变为准

(12)

在时段 t+1,设备 a 以 1-

眠模式,对应的下一状态为

的概率变为睡

(13)

(5)

(6)

(14)

2)当

时,设备 a 没有完成当前任务,

对应下一状态为

1.3.2 可延迟设备

2) t+1

=1 时,设

备 a 在当前时段 t 调度,且在时段 t+1 设备处于

准备模式,对应下一状态为

,当

,在时段 tH 时,设备 a 的可操作

动作可用下式表示:

3) t+1

=0 时,设

备 a 没有在当前时段 t 调度,且在时段 t+1 设备

处于准备模式,对应下一状态为

,当

(7)

1.4 目标函数设计

(15)

给定时段 t,在 t+1 时段设备的运行状态可以

用以下三种模式表示:

1)当设备

=0 处于睡眠模式或在当前时

段

=1

=1 即将完成任务时,设备 a 以

的概率在时段 t+1 变为准备模式,对应的

下一个状态为

对于用户侧而言,其参与优化调度的主要目

的是获得最大利润,实现能源消耗的最小化,进

而提高自身的经济效益。其中对于消耗的电能,

由 于 居 民 住 宅 建 筑 中 用 电 设 备 的 移 位 能 力 ,

ECDC 改变可中断设备的运行状态后,用户会体

验相应的不舒适感,产生不舒适成本。因此最优

的花费与不同用户在时间 t 时的用电行为密切相

关。故用户经济性最优表示为

在时段 t+1,设备 a 以 1-

眠模式,对应的下一状态为

的概率变为睡

(16)

(8)

(9)

(10)

本文采用加权欧式距离

表

2)当

=1 时,设备 a 没有完成

当前任务,需在当前时段 t 调度且不能延迟在下

一时段(

=0)工作,对应下一状态为

3)当

=0 时,设备 a 没有完成

当前任务,即没有在当前时段调度,对应下一状

态为

1.3.3 可中断设备

,在时段 tH 时,设备 a 的可操作

动作等价于公式(7)。设备在 t+1 时段的运行状态

可用以下三种模式表示:

1) t+1

,当设备

=0 处于睡眠

模式或在当前时段

=1

=1 即将完成任

式中:优化时域 T=96, 表示在时段 t 用户从

电网买入的电价, 表示在时段 t 用户卖给电网

的电价。

表示优化时域内 i 用户光伏总发电

量,

表示 i 用户中 a 设备的耗电量。

示可中断设备调度后用户产生的不舒适成本[15]。

表示式(2)中 i 用户 a 设备 t 时段的二进制调

度决策向量的值, 表示用户设定的基于最优

舒适感的 a 设备运行状态决策值, 表示二者

的相关系数。不舒适成本是指可中断设备运行状

态改变后,用户会体验相应的不舒适感带来的成

本。其存在有以下两个目的:1)用户通过设定

值控制可中断设备运行状态的改变次数,当

其对舒适度要求较高时,设定较大的

值,反

之设定较小的

值。2)不舒适成本由调度决

策值(优化值)表示可反映出不舒适成本和系统优

(11)

,,ait,,+1aitP(),,1,,0,1aitaid+=s,,+1aitP(),,1,,0,0,1aitait+=+s,,2ait(),,1,,,,1,0,1aitaitait+=−+sTiaD,,,,,,,,,,,,,,,,01, ,,1,11, ,,1,00, 0sdaiaiaitaitsdaitaiaiaitaitaittttqxtttq===或,,ait,,ait,,aitx,,+1aitP(),,1,,,,,1,1dsaitaiaiaiaidttd+=−−+s,,+1aitP(),,1,,0,0,1aitait+=+s,,2ait,,aitx,,1aitq+(),,1,,,,1,0,1aitaitait+=−+s,,1ait,,aitx(),,1,,,,,,,1,1aitaitaitaitq+=−+sIiaD,,[,]sdaiaitt,,ait,,ait,,aitx,,+1aitP()maxmin,,1,,,,,1,1dsaitaiaiaiaidttd+=−−+s,,+1aitP(),,1,,0,0,1aitait+=+s,,[,]sdaiaitt,,2ait,,aitx(),,1,,,,,,1,,1aitaitaitaitq+=−+s,,[,]sdaiaitt,,1ait,,aitx(),,1,,,,,,,1,1aitaitaitaitq+=−+s , ,,,,1111MaxFTNNmavgtittaitaittiiaPtxPt++−=====−−,,,,,,11Nmaitaitaitiaxx==− t− t+,itPt+,,avgaitPt,,,,,,aitaitaitxx−,,aitx,,aitx,,ait,,ait,,ait,,ait�

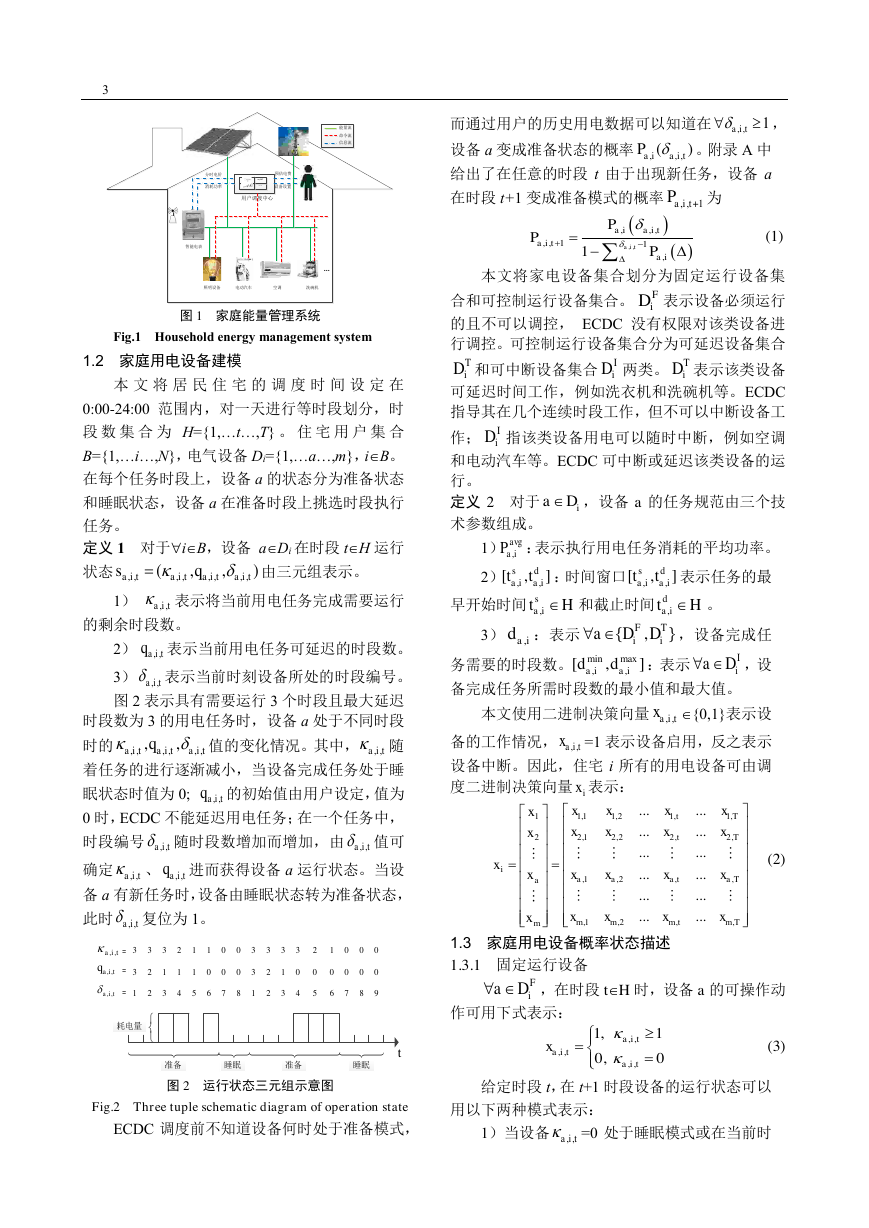

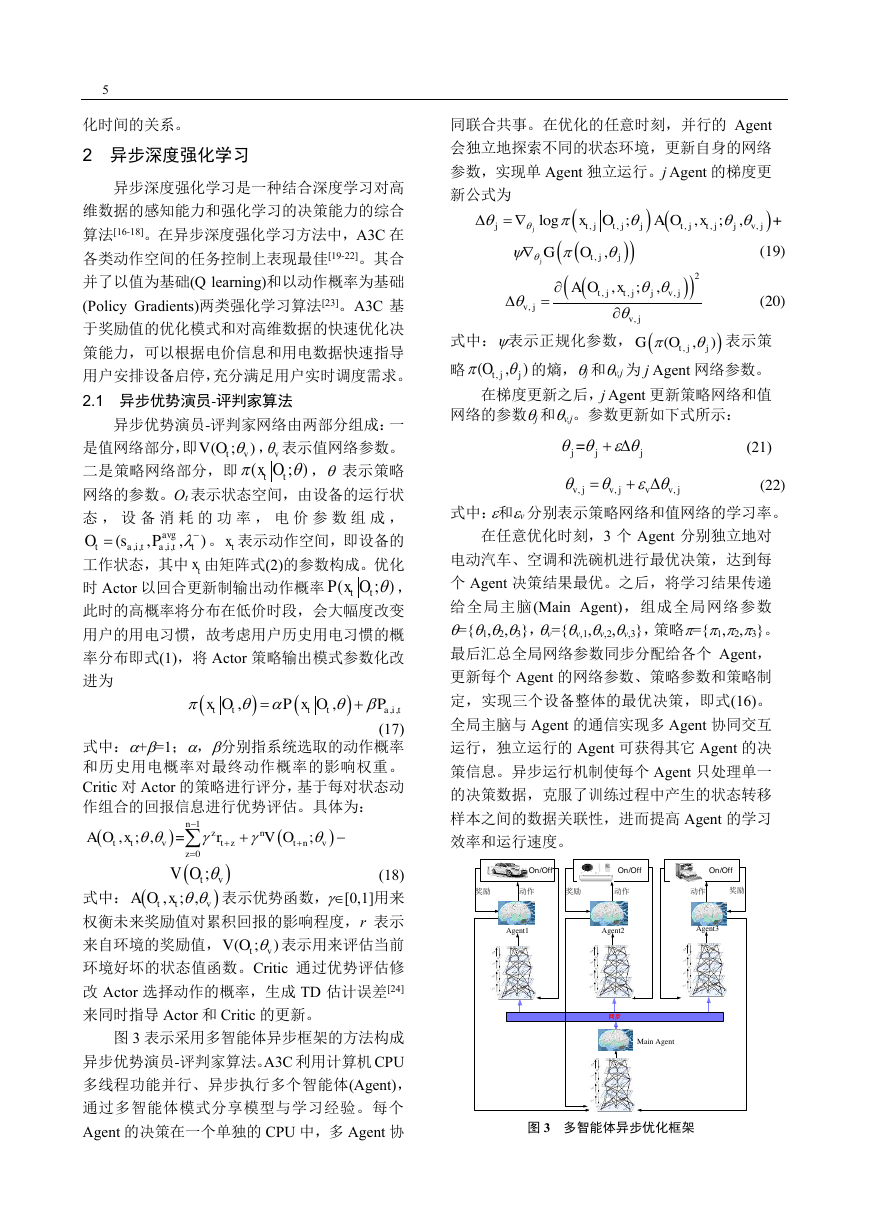

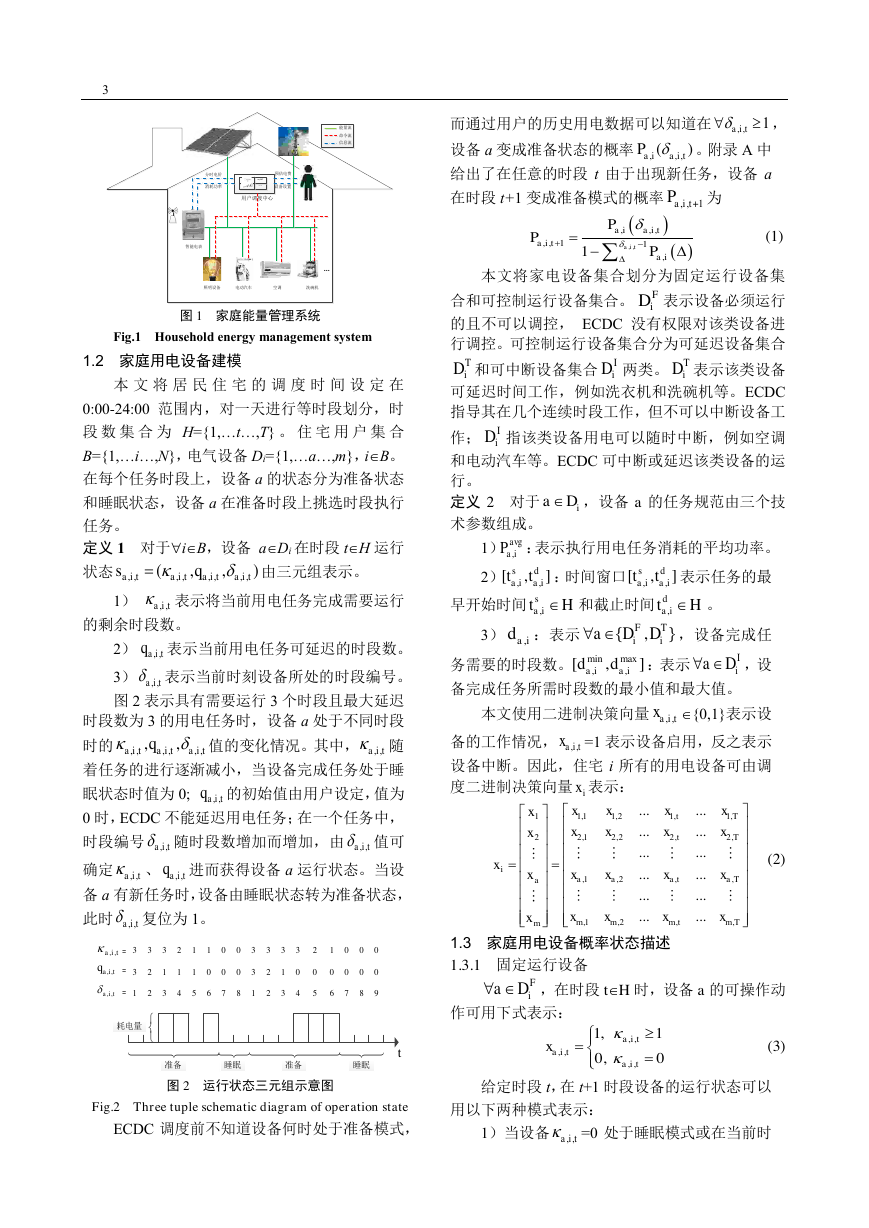

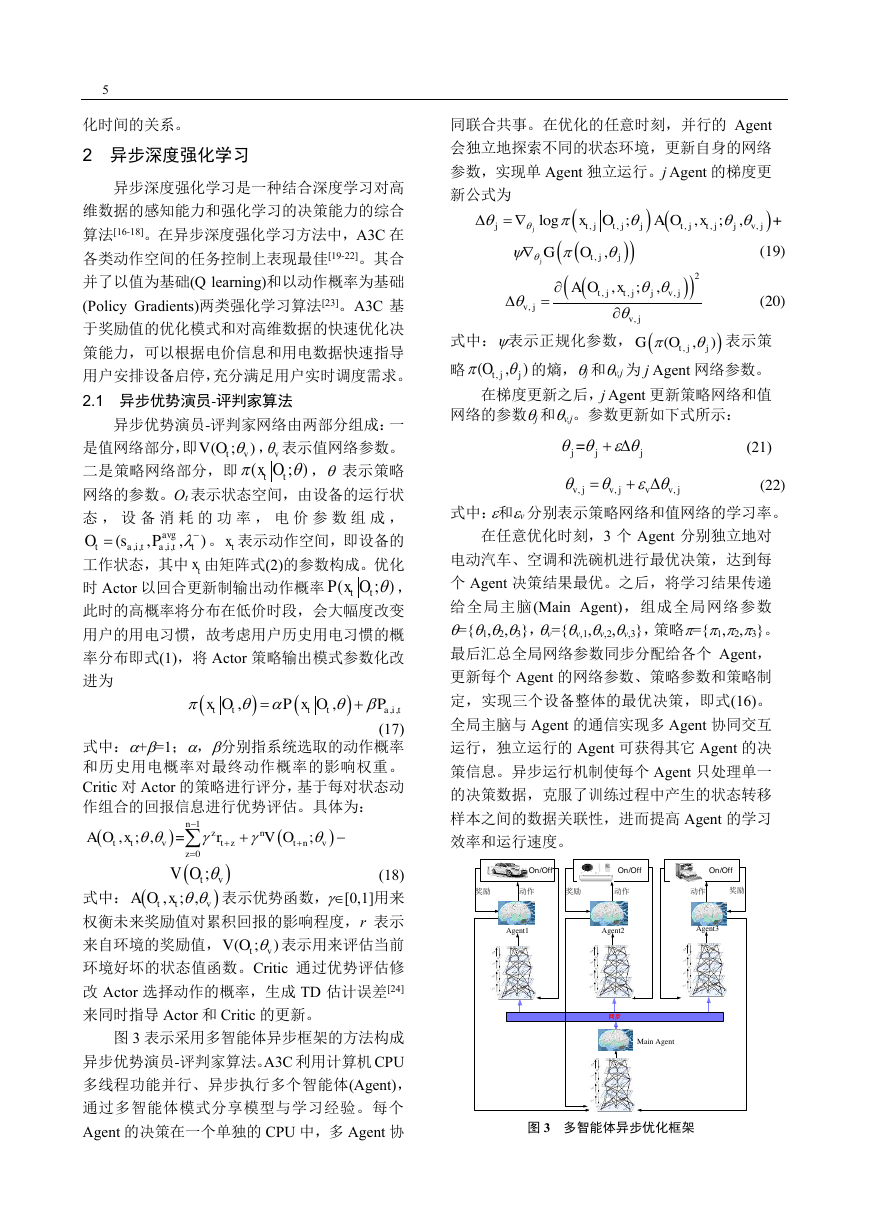

同联合共事。在优化的任意时刻,并行的 Agent

会独立地探索不同的状态环境,更新自身的网络

参数,实现单 Agent 独立运行。j Agent 的梯度更

新公式为

(19)

(20)

式中:表示正规化参数,

表示策

略

的熵,j 和v,j 为 j Agent 网络参数。

在梯度更新之后,j Agent 更新策略网络和值

网络的参数j 和v,j。参数更新如下式所示:

(21)

(22)

式中:和v 分别表示策略网络和值网络的学习率。

在任意优化时刻,3 个 Agent 分别独立地对

电动汽车、空调和洗碗机进行最优决策,达到每

个 Agent 决策结果最优。之后,将学习结果传递

给全局主脑(Main Agent),组成全局网络参数

={1,2,3},v={v,1,v,2,v,3},策略={1,2,3}。

最后汇总全局网络参数同步分配给各个 Agent,

更新每个 Agent 的网络参数、策略参数和策略制

定,实现三个设备整体的最优决策,即式(16)。

全局主脑与 Agent 的通信实现多 Agent 协同交互

运行,独立运行的 Agent 可获得其它 Agent 的决

策信息。异步运行机制使每个 Agent 只处理单一

的决策数据,克服了训练过程中产生的状态转移

样本之间的数据关联性,进而提高 Agent 的学习

效率和运行速度。

5

化时间的关系。

2 异步深度强化学习

异步深度强化学习是一种结合深度学习对高

维数据的感知能力和强化学习的决策能力的综合

算法[16-18]。在异步深度强化学习方法中,A3C 在

各类动作空间的任务控制上表现最佳[19-22]。其合

并了以值为基础(Q learning)和以动作概率为基础

(Policy Gradients)两类强化学习算法[23]。A3C 基

于奖励值的优化模式和对高维数据的快速优化决

策能力,可以根据电价信息和用电数据快速指导

用户安排设备启停,充分满足用户实时调度需求。

2.1 异步优势演员-评判家算法

是值网络部分,即

异步优势演员-评判家网络由两部分组成:一

, 表示值网络参数。

, 表示策略

二是策略网络部分,即

网络的参数。Ot 表示状态空间,由设备的运行状

态 , 设 备 消 耗 的 功 率 , 电 价 参 数 组 成 ,

。 表示动作空间,即设备的

工作状态,其中 由矩阵式(2)的参数构成。优化

时 Actor 以回合更新制输出动作概率

,

此时的高概率将分布在低价时段,会大幅度改变

用户的用电习惯,故考虑用户历史用电习惯的概

率分布即式(1),将 Actor 策略输出模式参数化改

进为

(17)

式中:+=1;,分别指系统选取的动作概率

和历史用电概率对最终动作概率的影响权重。

Critic 对 Actor 的策略进行评分,基于每对状态动

作组合的回报信息进行优势评估。具体为:

(18)

式中:

表示优势函数,[0,1]用来

权衡未来奖励值对累积回报的影响程度,r 表示

来自环境的奖励值,

表示用来评估当前

环境好坏的状态值函数。Critic 通过优势评估修

改 Actor 选择动作的概率,生成 TD 估计误差[24]

来同时指导 Actor 和 Critic 的更新。

图 3 表示采用多智能体异步框架的方法构成

异步优势演员-评判家算法。A3C 利用计算机 CPU

多线程功能并行、异步执行多个智能体(Agent),

通过多智能体模式分享模型与学习经验。每个

Agent 的决策在一个单独的 CPU 中,多 Agent 协

图 3 多智能体异步优化框架

(;)tvVOv(;)ttxO,,,,(,,)avgtaitaittOP−=stxtx(;)ttPxO()(),,,,ttttaitxOPxOP=+()()10,;,=;nznttvtztnvzAOxrVO−++=+−();tvVO(),;,ttvAOx(;)tvVO()(),,,,,log;,;,+jjtjtjjtjtjjvjxOAOx=()(),,jtjjGO()()2,,,,,,;,tjtjjvjvjvjAOx=(),(,)tjjGO,(,)tjjO=jjj+,,,vjvjvvj=+动作动作动作同步奖励奖励奖励On/OffOn/OffOn/OffAgent1Agent2Agent3Main Agent�

6

中 国 电 机 工 程 学 报

Fig.3 Multi-Agent asynchronous optimization

参数,设定为 0.01。

framework

优化问题等价于最大化家庭设备启停最优组

合策略下系统的总期望回报值:

(23)

式中:

表示在一个优化周期内获得的系

统总奖励值,为优化周期内设备最优启停策略。

住宅负荷的调度由电动汽车的充电与否以及

空调和洗碗机的启停组成,动作的执行与否取决

于与特定输入状态的柔性设备相关的操作概率的

大小。针对本文所解决的多目标优化问题,采用

多任务联合奖励,由二个奖励组成:

奖励一:对于全部的

,奖励向量

的设置应控制三种负荷。因此,电动汽车、空调

和洗碗机使用不同的奖励。三个 Agent 奖励设置

如下:

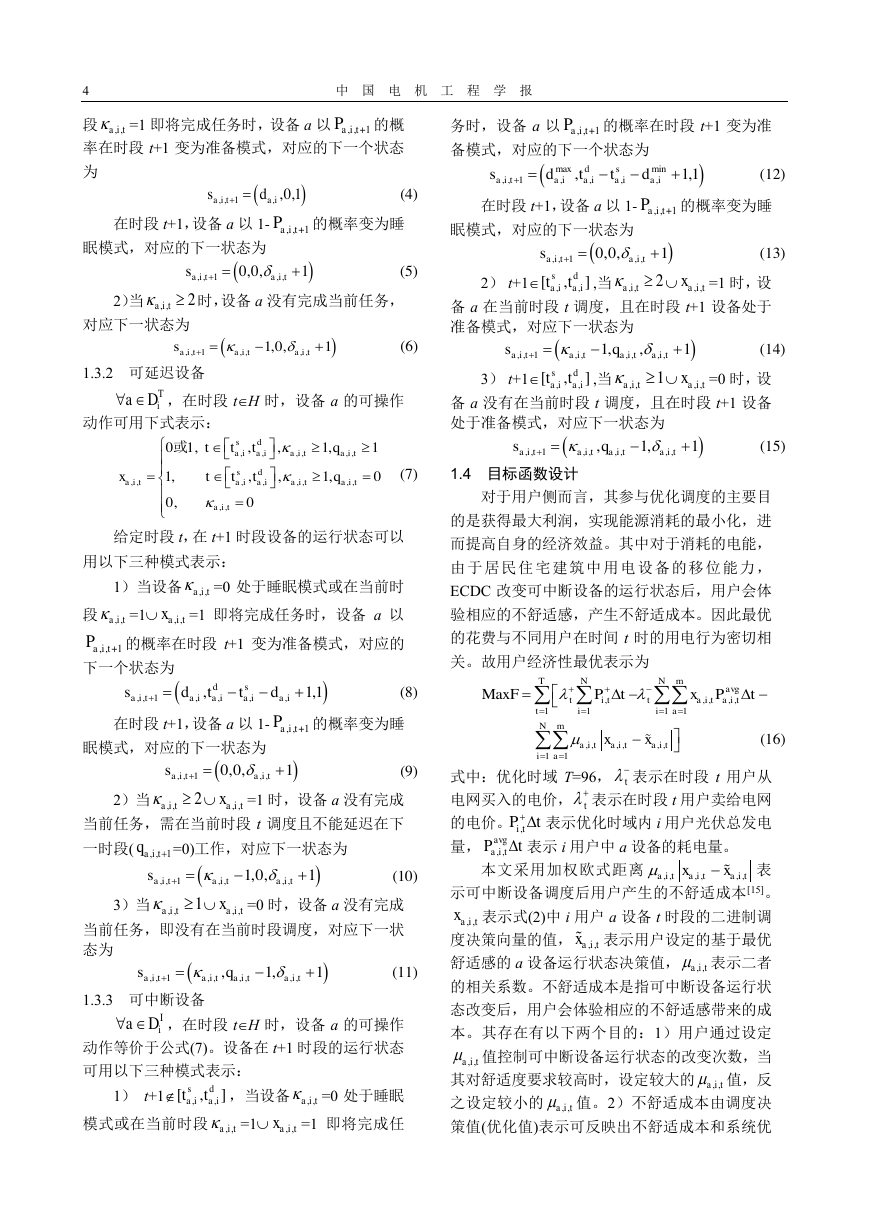

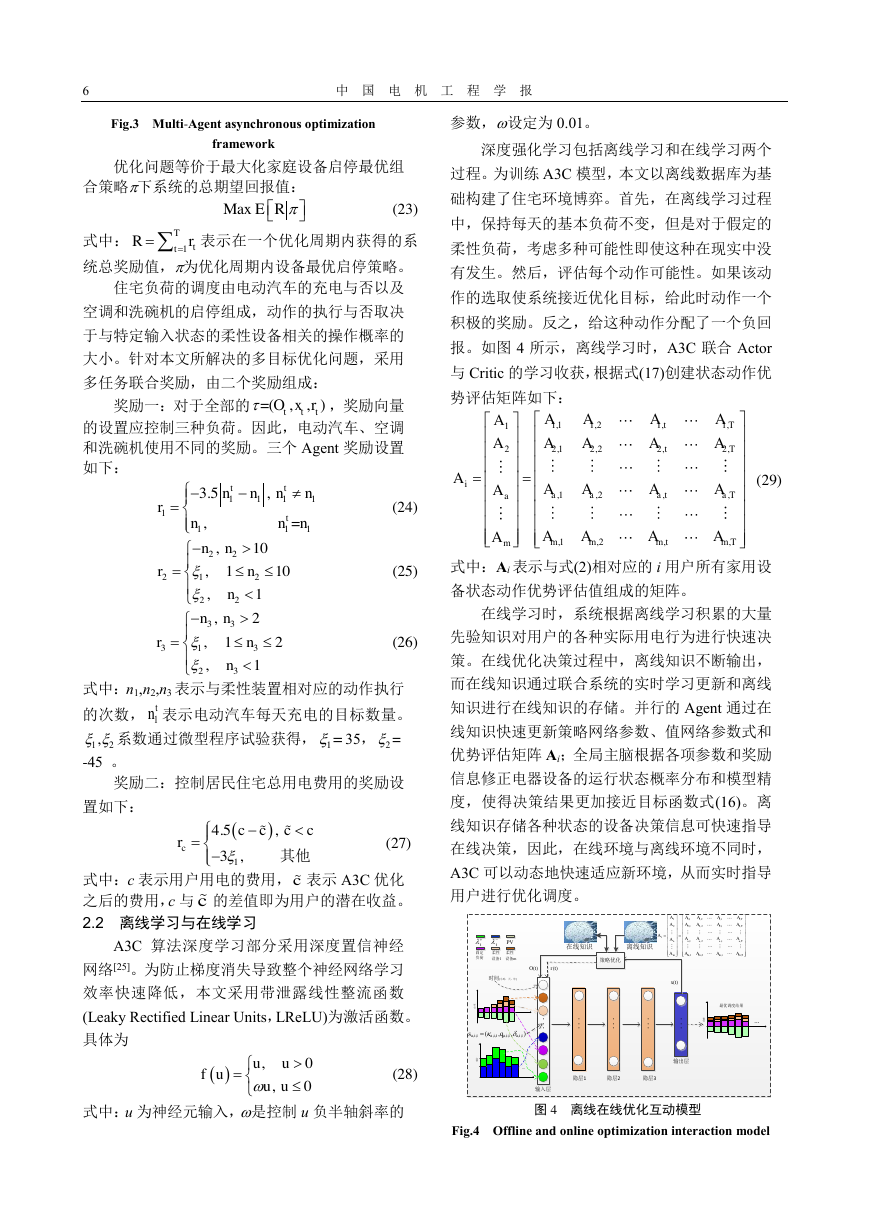

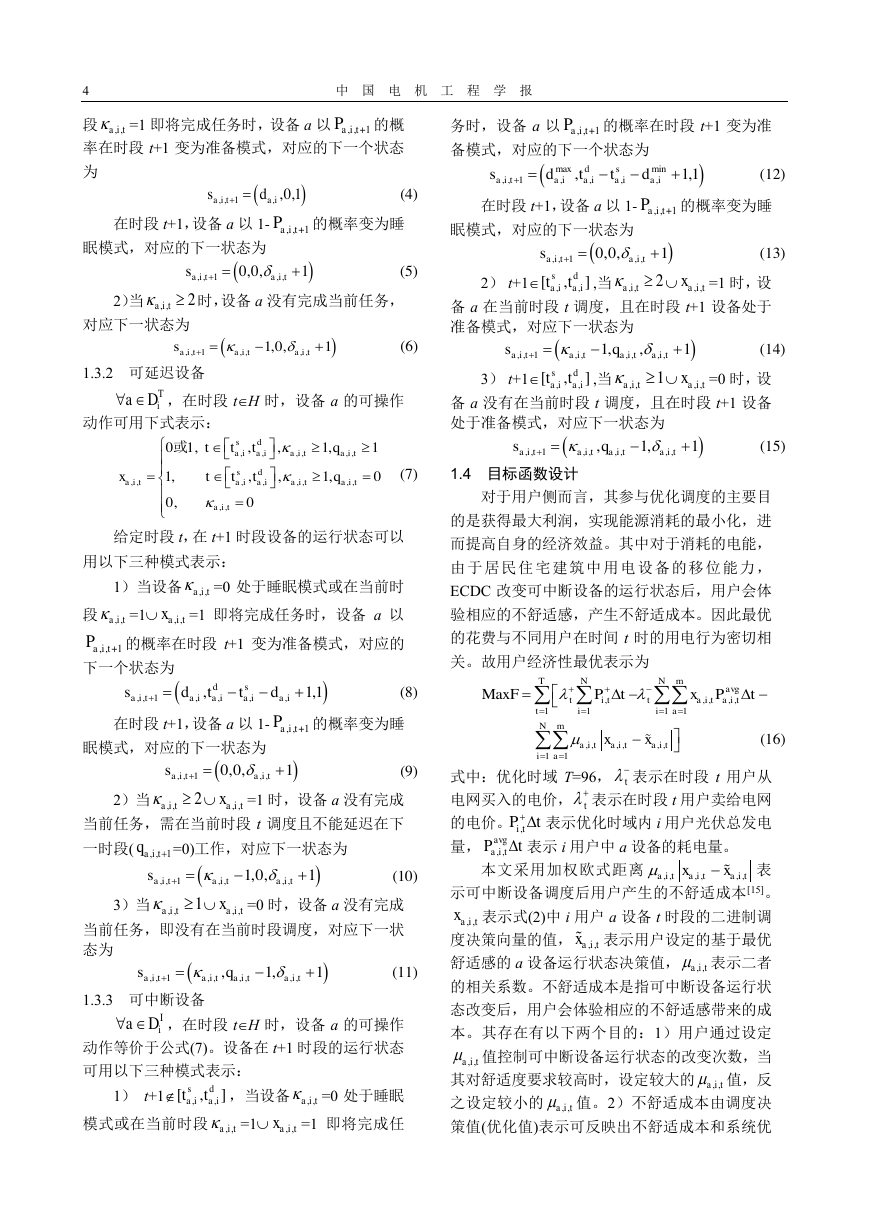

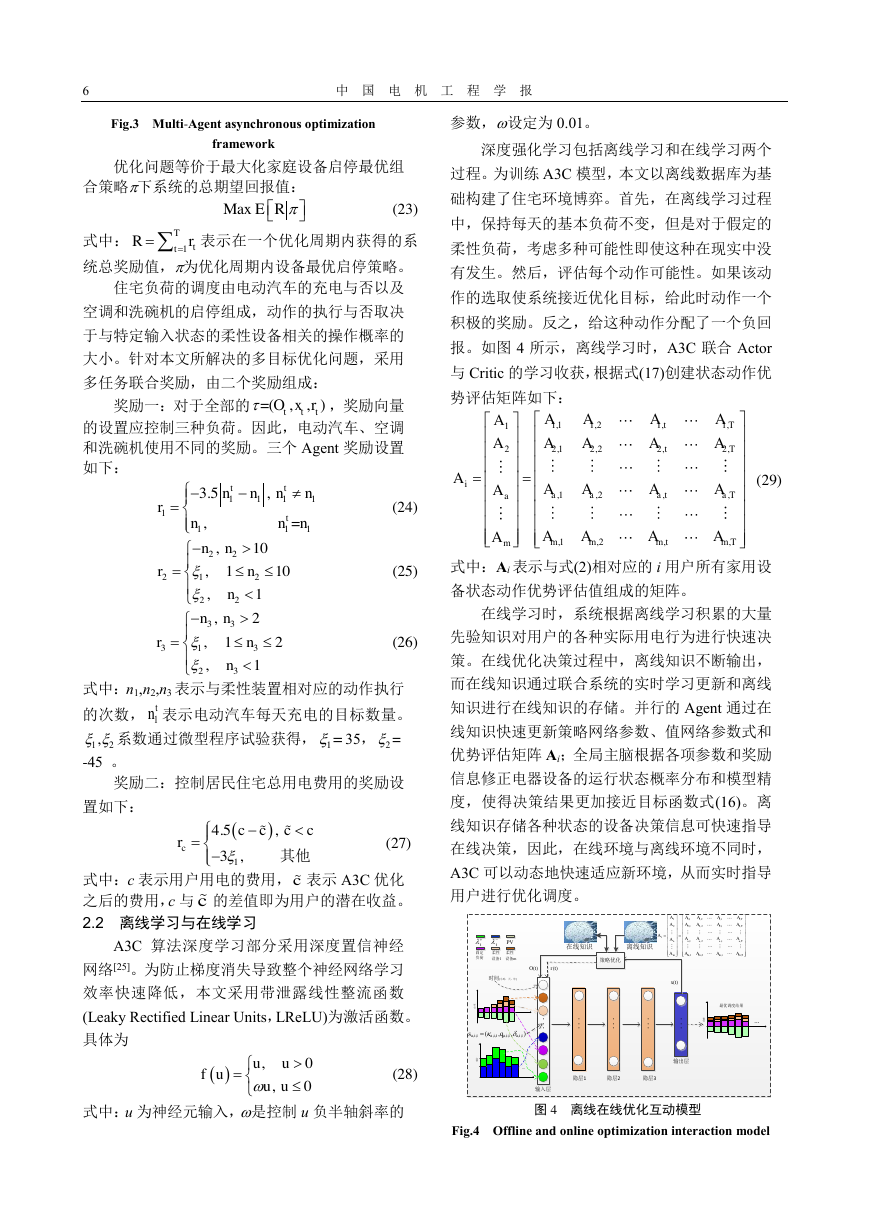

深度强化学习包括离线学习和在线学习两个

过程。为训练 A3C 模型,本文以离线数据库为基

础构建了住宅环境博弈。首先,在离线学习过程

中,保持每天的基本负荷不变,但是对于假定的

柔性负荷,考虑多种可能性即使这种在现实中没

有发生。然后,评估每个动作可能性。如果该动

作的选取使系统接近优化目标,给此时动作一个

积极的奖励。反之,给这种动作分配了一个负回

报。如图 4 所示,离线学习时,A3C 联合 Actor

与 Critic 的学习收获,根据式(17)创建状态动作优

势评估矩阵如下:

(29)

(24)

(25)

式中:Ai 表示与式(2)相对应的 i 用户所有家用设

备状态动作优势评估值组成的矩阵。

在线学习时,系统根据离线学习积累的大量

(26)

先验知识对用户的各种实际用电行为进行快速决

式中:n1,n2,n3 表示与柔性装置相对应的动作执行

的次数, 表示电动汽车每天充电的目标数量。

系数通过微型程序试验获得, 35,

-45 。

奖励二:控制居民住宅总用电费用的奖励设

置如下:

策。在线优化决策过程中,离线知识不断输出,

而在线知识通过联合系统的实时学习更新和离线

知识进行在线知识的存储。并行的 Agent 通过在

线知识快速更新策略网络参数、值网络参数式和

优势评估矩阵 Ai;全局主脑根据各项参数和奖励

信息修正电器设备的运行状态概率分布和模型精

度,使得决策结果更加接近目标函数式(16)。离

线知识存储各种状态的设备决策信息可快速指导

(27)

在线决策,因此,在线环境与离线环境不同时,

A3C 可以动态地快速适应新环境,从而实时指导

用户进行优化调度。

式中:c 表示用户用电的费用, 表示 A3C 优化

之后的费用,c 与 的差值即为用户的潜在收益。

2.2 离线学习与在线学习

A3C 算法深度学习部分采用深度置信神经

网络[25]。为防止梯度消失导致整个神经网络学习

效率快速降低,本文采用带泄露线性整流函数

(Leaky Rectified Linear Units,LReLU)为激活函数。

具体为

式中:u 为神经元输入,是控制 u 负半轴斜率的

图 4 离线在线优化互动模型

Fig.4 Offline and online optimization interaction model

(28)

Max ER1TttRr===(,,)tttOxr111111113.5, , = tttnnnnrnnn−−=2221222, 10, 110, 1nnrnn−=3331323, 2, 12, 1nnrnn−=1tn12,1=2=()14.5, 3, cccccr−=−其他cc(), 0, 0uufuuu=1,11,21,1,12,12,22,2,2,1,2,,,1,2,,tTtTiaaataTammmtmTmAAAAAAAAAAAAAAAA==AAAAA. . .. . .. . .. . .. . .策略优化x(t)r(t)O(t)离线知识在线知识电价...功率时间{小时,天,年}... t+ t−PV固定负荷柔性 设备1柔性 设备m功率最优调度结果...输入层隐层1隐层2隐层3输出层1,11,21,1,12,12,22,2,2,1,2,,,1,2,,tTtTiaaataTammmtmTmAAAAAAAAAAAAAAAA==AAAAA,,,,,,,,(,,)aitaitaitaitq=s�

7

在模型中,神经网络输入层有 10 个神经元,

分别对应时段 t,分时电价,光伏输出功率,固

定设备消耗功率,空调、电动汽车以及洗碗机的

运行状态 和消耗功率

。住宅用电数据维

度较高,为了提高网络的识别率和处理精度,充

分拟合用户的响应行为。本文将 DBN 设定为三

个隐层,每层由 100 个神经元组成,采用 LReLU

作为神经元激活函数。A3C 输出层由三个神经元

组成,每个神经元代表一个设备的动作。

3 算例分析

实 验 模 型 中 , 模 型 训 练 3000 episodes, 每

episodes 的训练由随机的 15 天数据组成,每 2

episodes 更新一次权重。仿真环境为英特尔 core

i7-8700 @ 3.20GHz,6 核 12 线程,内存 16GB,软

件配置 Python3.5.2,TensorFlow1.7.0。表 1 表示 A3C

算法参数设置情况,表 2 表示用户侧用电设备的设

置情况,其中 表示当电动汽车处于准备状态时的

初始电量, 表示满足出行需求所需电量, 表

示电动汽车电池最大容量。

表 1 算法参数配置

Tab. 1 Algorithm parameter configuration

系统参数

v

取值

0.01

0.001

0.95

0.7

0.3

0.08

表 2 电器设备参数配置

Tab.2 Appliances parameter configuration

洗碗机

空调

家庭用电设备参数

(1kW,1.5h,—,—)

(1.5kW,—,1.5h,7.5h)

(a) 用户Ⅰ优化前能量分布

(b) 用户Ⅱ优化前能量分布

(c) 用户Ⅰ优化后能量分布

(d) 用户Ⅱ优化后能量分布

图 5 不同用户优化结果对比

Fig.5 Comparison of different users optimization

,

)

results

电动汽车

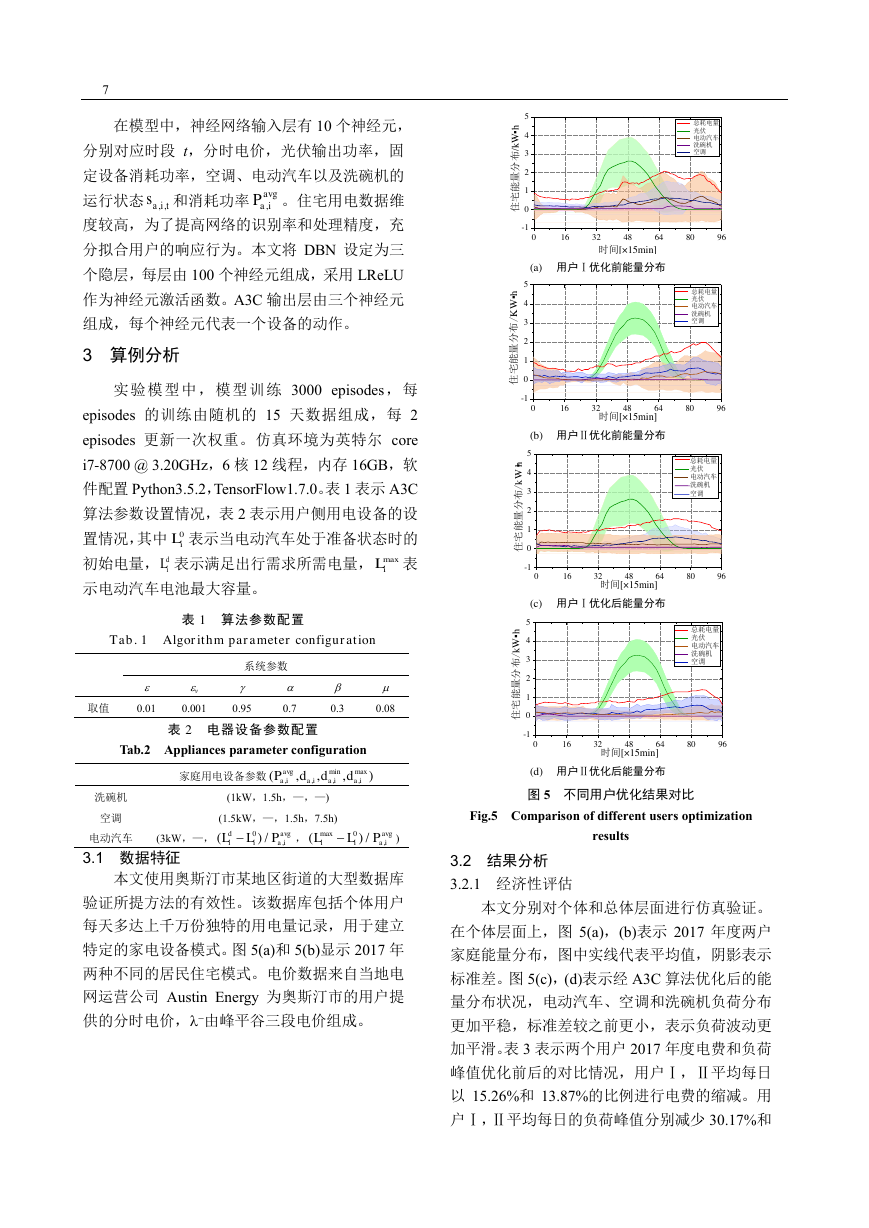

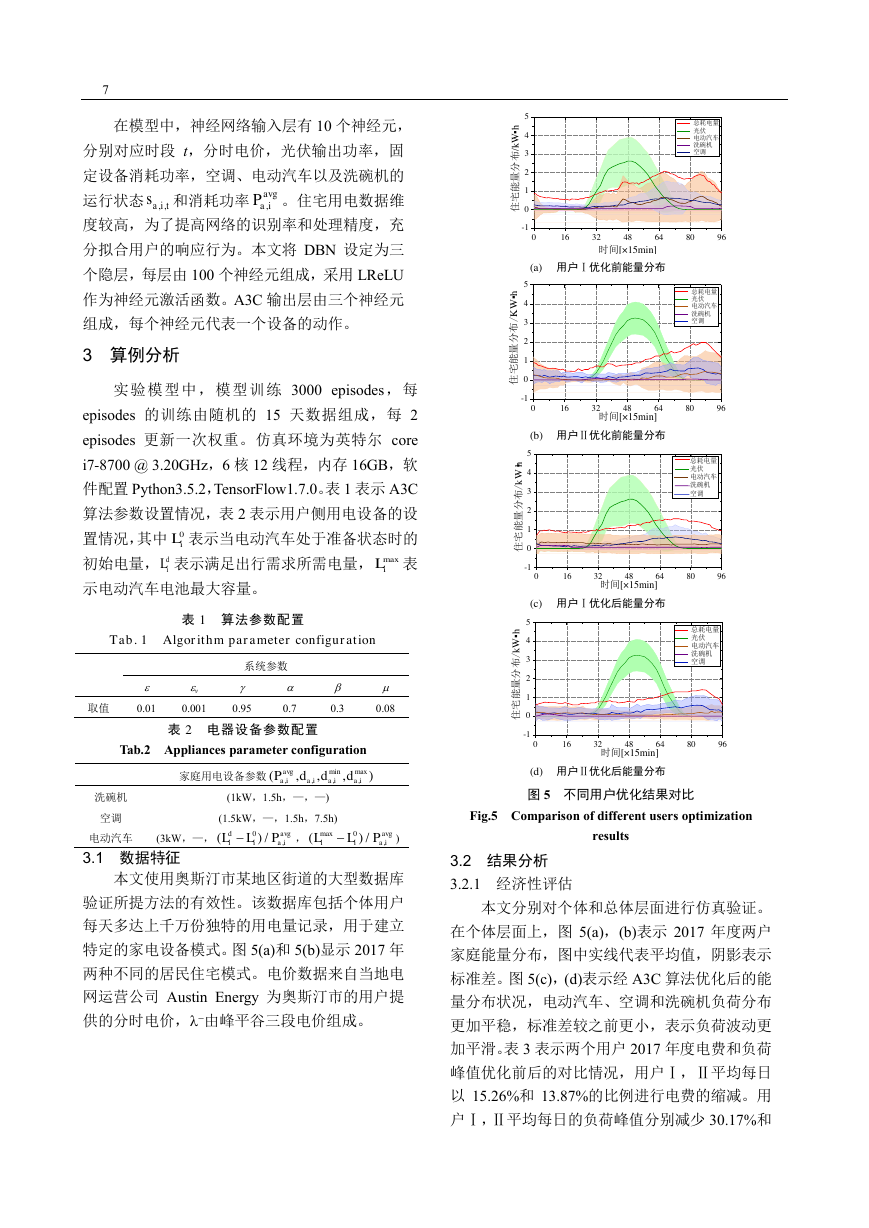

3.1 数据特征

(3kW,—,

本文使用奥斯汀市某地区街道的大型数据库

验证所提方法的有效性。该数据库包括个体用户

每天多达上千万份独特的用电量记录,用于建立

特定的家电设备模式。图 5(a)和 5(b)显示 2017 年

两种不同的居民住宅模式。电价数据来自当地电

网运营公司 Austin Energy 为奥斯汀市的用户提

供的分时电价,−由峰平谷三段电价组成。

3.2 结果分析

3.2.1 经济性评估

本文分别对个体和总体层面进行仿真验证。

在个体层面上,图 5(a),(b)表示 2017 年度两户

家庭能量分布,图中实线代表平均值,阴影表示

标准差。图 5(c),(d)表示经 A3C 算法优化后的能

量分布状况,电动汽车、空调和洗碗机负荷分布

更加平稳,标准差较之前更小,表示负荷波动更

加平滑。表 3 表示两个用户 2017 年度电费和负荷

峰值优化前后的对比情况,用户Ⅰ,Ⅱ平均每日

以 15.26%和 13.87%的比例进行电费的缩减。用

户Ⅰ,Ⅱ平均每日的负荷峰值分别减少 30.17%和

,,aits,avgaiP0iLdiLmaxiLminmax,,,,(,,,)avgaiaiaiaiPddd0,()/davgiiaiLLP−max0,()/avgiiaiLLP−0163248648096-1012345住宅能量分布/kW▪h时间[×15min] 总耗电量 光伏 电动汽车 洗碗机 空调0163248648096-1012345时间[×15min]住宅能量分布/KW▪h 总耗电量 光伏 电动汽车 洗碗机 空调0163248648096-1012345住宅能量分布/kW▪h时间[×15min] 总耗电量 光伏 电动汽车 洗碗机 空调0163248648096-1012345时间[×15min]住宅能量分布/kW▪h 总耗电量 光伏 电动汽车 洗碗机 空调�

8

中 国 电 机 工 程 学 报

22.45%,当用户以用电经济性为目标时,可以一

定程度上达到削峰填谷的目地。在总体层面上,

如表 4 所示对随机选择的 10 栋,30 栋,50 栋住

宅进行验证分析。经 A3C 优化后,用电费用分别

以 19.7%,30.7%,31.7%的幅度进行缩减。图 6

表示分别对 50 个用户未优化和优化后的结果对

比,每个用户优化结果有很大差异,有的用户能

够将用电费用减半,有的只减低几个百分点。这

与用户的用电量和用电行为密切相关。

表 3 用电费用和负荷峰值优化结果对比

Tab.3 Comparison of power cost and peak load

optimization results

用户Ⅰ

用户Ⅱ

均值 柔性设备 均值 柔性设备

费用($/day)

优化费用($/day)

峰值(kW)

优化峰值(kW)

3.08

2.61

4.35

3.11

3.58

3.03

1.79

1.27

2.38

2.05

3.83

2.97

2.23

2.02

1.51

1.25

表 4 不同用户规模下总费用

Tab.4 Total cost under different scales of users

10 户

30 户

50 户

日用

电费

柔性

设备

日用

电费

柔性

设备

日用

电费

柔性

设备

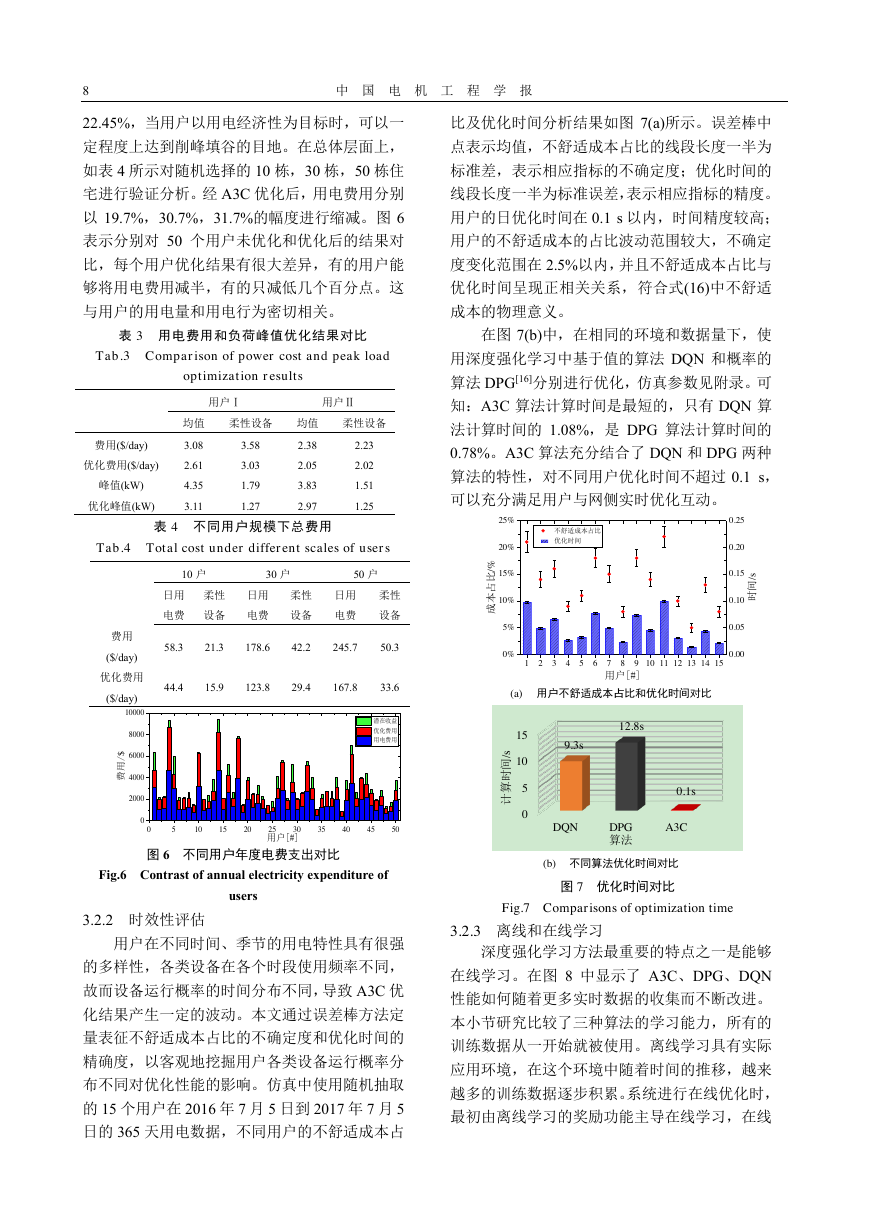

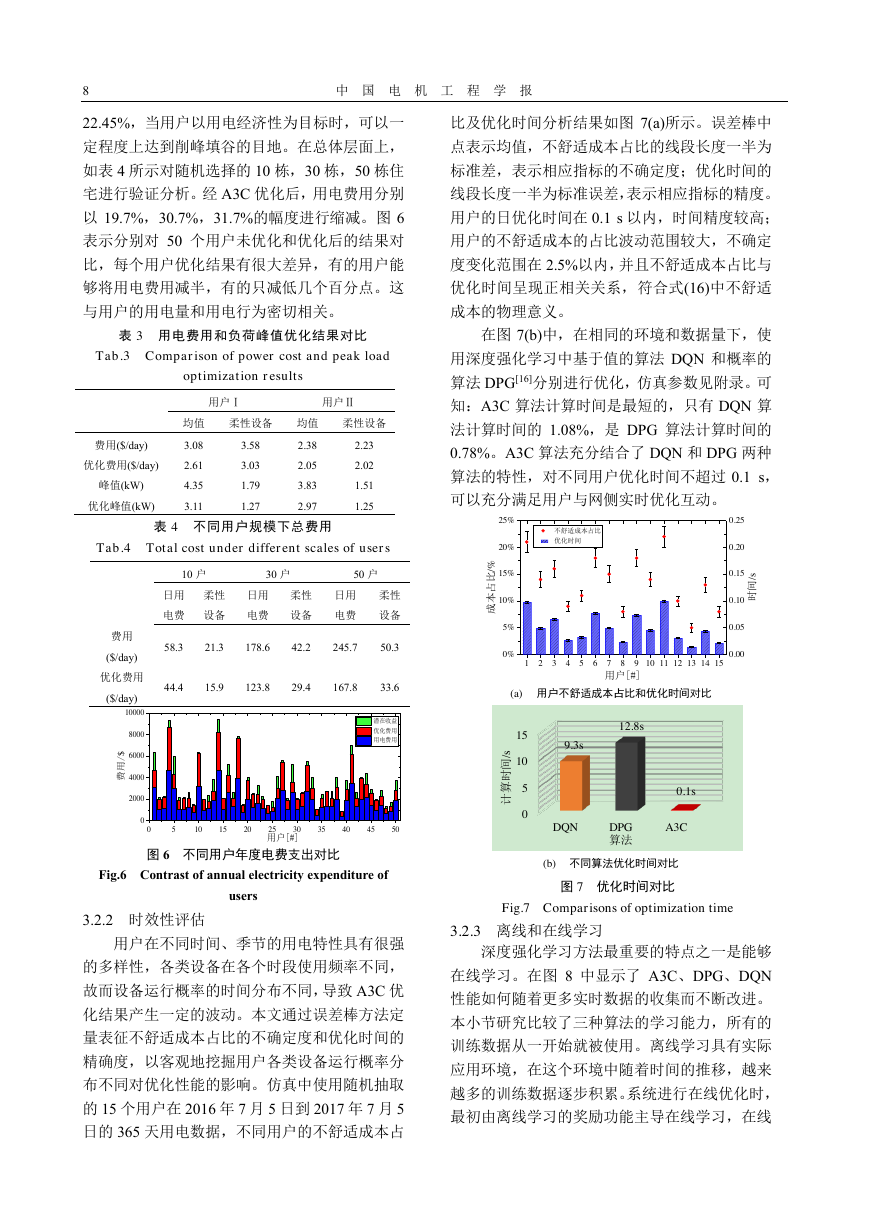

比及优化时间分析结果如图 7(a)所示。误差棒中

点表示均值,不舒适成本占比的线段长度一半为

标准差,表示相应指标的不确定度;优化时间的

线段长度一半为标准误差,表示相应指标的精度。

用户的日优化时间在 0.1 s 以内,时间精度较高;

用户的不舒适成本的占比波动范围较大,不确定

度变化范围在 2.5%以内,并且不舒适成本占比与

优化时间呈现正相关关系,符合式(16)中不舒适

成本的物理意义。

在图 7(b)中,在相同的环境和数据量下,使

用深度强化学习中基于值的算法 DQN 和概率的

算法 DPG[16]分别进行优化,仿真参数见附录。可

知:A3C 算法计算时间是最短的,只有 DQN 算

法计算时间的 1.08%,是 DPG 算法计算时间的

0.78%。A3C 算法充分结合了 DQN 和 DPG 两种

算法的特性,对不同用户优化时间不超过 0.1 s,

可以充分满足用户与网侧实时优化互动。

费用

($/day)

优化费用

($/day)

58.3

21.3

178.6

42.2

245.7

50.3

44.4

15.9

123.8

29.4

167.8

33.6

(a) 用户不舒适成本占比和优化时间对比

12.8s

9.3s

s

/

间

时

算

计

15

10

5

0

DQN

DPG

算法

0.1s

A3C

图 6 不同用户年度电费支出对比

Fig.6 Contrast of annual electricity expenditure of

3.2.2 时效性评估

users

用户在不同时间、季节的用电特性具有很强

的多样性,各类设备在各个时段使用频率不同,

故而设备运行概率的时间分布不同,导致 A3C 优

化结果产生一定的波动。本文通过误差棒方法定

量表征不舒适成本占比的不确定度和优化时间的

精确度,以客观地挖掘用户各类设备运行概率分

布不同对优化性能的影响。仿真中使用随机抽取

的 15 个用户在 2016 年 7 月 5 日到 2017 年 7 月 5

日的 365 天用电数据,不同用户的不舒适成本占

(b) 不同算法优化时间对比

图 7 优化时间对比

Fig.7 Comparisons of optimization time

3.2.3 离线和在线学习

深度强化学习方法最重要的特点之一是能够

在线学习。在图 8 中显示了 A3C、DPG、DQN

性能如何随着更多实时数据的收集而不断改进。

本小节研究比较了三种算法的学习能力,所有的

训练数据从一开始就被使用。离线学习具有实际

应用环境,在这个环境中随着时间的推移,越来

越多的训练数据逐步积累。系统进行在线优化时,

最初由离线学习的奖励功能主导在线学习,在线

051015202530354045500200040006000800010000费用/$用户[#] 潜在收益 优化费用 用电费用1234567891011121314150%5%10%15%20%25%成本占比/%用户[#] 不舒适成本占比 优化时间0.000.050.100.150.200.25时间/s�

2023年江西萍乡中考道德与法治真题及答案.doc

2023年江西萍乡中考道德与法治真题及答案.doc 2012年重庆南川中考生物真题及答案.doc

2012年重庆南川中考生物真题及答案.doc 2013年江西师范大学地理学综合及文艺理论基础考研真题.doc

2013年江西师范大学地理学综合及文艺理论基础考研真题.doc 2020年四川甘孜小升初语文真题及答案I卷.doc

2020年四川甘孜小升初语文真题及答案I卷.doc 2020年注册岩土工程师专业基础考试真题及答案.doc

2020年注册岩土工程师专业基础考试真题及答案.doc 2023-2024学年福建省厦门市九年级上学期数学月考试题及答案.doc

2023-2024学年福建省厦门市九年级上学期数学月考试题及答案.doc 2021-2022学年辽宁省沈阳市大东区九年级上学期语文期末试题及答案.doc

2021-2022学年辽宁省沈阳市大东区九年级上学期语文期末试题及答案.doc 2022-2023学年北京东城区初三第一学期物理期末试卷及答案.doc

2022-2023学年北京东城区初三第一学期物理期末试卷及答案.doc 2018上半年江西教师资格初中地理学科知识与教学能力真题及答案.doc

2018上半年江西教师资格初中地理学科知识与教学能力真题及答案.doc 2012年河北国家公务员申论考试真题及答案-省级.doc

2012年河北国家公务员申论考试真题及答案-省级.doc 2020-2021学年江苏省扬州市江都区邵樊片九年级上学期数学第一次质量检测试题及答案.doc

2020-2021学年江苏省扬州市江都区邵樊片九年级上学期数学第一次质量检测试题及答案.doc 2022下半年黑龙江教师资格证中学综合素质真题及答案.doc

2022下半年黑龙江教师资格证中学综合素质真题及答案.doc