第32卷第3期2018年3月电子测量与仪器学报JOURNALOFELECTRONICMEASUREMENTANDINSTRUMENTATIONVol.32No.3·195·收稿日期:2017-08ReceivedDate:2017-08*基金项目:国家重点研发计划(2016YFF020440508)、安徽省科技重大专项(16030901060)、安徽省高校自然科学研究重大项目(KJ2014ZD05)、安徽省高校优秀青年人才支持计划资助项目DOI:10.13382/j.jemi.2018.03.028基于卷积记忆神经网络的微博短文本情感分析*郑啸王义真袁志祥秦锋(安徽工业大学计算机科学与技术学院马鞍山243032)摘要:微博短文本情感分析的目的是发现用户对热点事件的观点及态度。已有的方法大多是基于词袋模型,然而,词袋模型无法准确捕获带有情感倾向性的语言表现特征。结合卷积神经网络(CNN)和长短期记忆网络(LSTM)模型的特点,提出了卷积记忆神经网络模型(CMNN),并基于此模型来解决情感分析问题。与传统算法相比,模型避免了具体任务的特征工程设计;与CNN和LSTM相比,模型既能够有效提取短文本局部最优特征,又能够解决远距离的上下文依赖。通过在COAE2014数据集上的实验来验证了模型对微博短文本情感分析的有效性。并与CNN、LSTM以及传统模型SVM做了实验对比,结果表明,模型对于微博短文本情感分析在性能上优于其他3种模型。关键词:微博短文本;情感分析;神经网络;卷积记忆神经网络中图分类号:TP391文献标识码:A国家标准学科分类代码:520.60Sentimentanalysisofmicro-blogshorttextbasedonconvolutionalmemoryneuralnetworkZhengXiaoWangYizhenYuanZhixiangQinFeng(SchoolofComputerScienceandTechnology,AnhuiUniversityofTechnology,Ma'anshan243032,China)Abstract:Thesentimentanalysisofmicro-blogshorttextisaimedatfindingusers’attitudetohotevents.Theexistingmethodsaremostlybasedonthebagofwordsmodelforsentimentanalysis.Thispaperpresentsanewmodelnamedconvolutionmemoryneuralnetwork(CMNN)tosolvesentimentanalysisproblems,whichcombinedwiththecharacteristicsoftheconvolutionalneuralnetwork(CNN)andthelongshort-termmemoryneuralnetwork(LSTM).Comparedwithtraditionalalgorithms,theproposedmodelavoidsthespecifictaskoffeatureengineeringdesign.ComparedwithCNNandLSTM,thismodelcaneffectivelyextractthecharacteristicsoflocaloptimalfeaturesofshorttextandlearnlong-termdependenciesinformation.ExperimentsontheCOAE2014datasetareconductedtoverifytheproposedmodelonthemicro-blogsentimentanalysis.Theexperimentalresultsshowthattheproposedmodelissuperiortothreemodels,i.e.SVM,CNNandLSTM.Keywords:micro-blogshorttext;sentimentclassification;neuralnetworks;convolutionalmemoryneuralnetworks0引言近年来随着移动互联网的快速发展,越来越多的用户更方便地通过微博等各种社交媒体来表达自己的观点,发表对热点事件的评论。社交网络已成为人们发表观点和抒发情绪的重要平台,它对社会诸领域的介入和渗透与日俱增,社会影响力日益巨大。根据微博短文本进行情感倾向性分析是一个具有挑战性的任务,近年来引起了专家学者的关注[1]。分析和挖掘微博短文本中所隐藏的情感信息,可以从中了解大众对热点事件的关注程度和舆情情感的变化情况,从而能够辅助识别热点事件和掌握舆情及突发事件的发展状况。此外,微博短文本情感分析的研究,也是自然语言处理和文本挖掘的重要研究方向之一。目前,国内外的专家学者已对情感分析问题做出了�

·196·电子测量与仪器学报第32卷一些研究探索,已有研究方法大多数都基于词袋模型。然而,词袋模型[2-3]是无法准确捕获带有情感倾向性的语言表现特征。此外,还有很多研究者借助人工标注的情感词典(Hownet)来提高情感分析的准确率。传统机器学习情感分析方法归纳起来有3类:有监督学习、无监督学习以及半监督学习。虽然当前大多数基于有监督学习的情感分析研究取得了不错的效果,但有监督学习依赖于大量人工标注的数据,从而限制了这类方法在其他领域以及跨语言的推广[4]。微博短文本具有口语化、不规范性、主题不明确、上下文有限等特点,传统机器学习对其情感特征提取费时耗力。对于微博短文本的情感分析研究是一项循序渐进、由浅入深的任务,近年来,随着深度学习相关技术的发展,研究人员更倾向于利用深度学习来解决这一任务。例如,利用RecursiveAuto-encoder方法试图以一种树形结构来描述文本,能够学习到文本的句法信息[5]。利用构建在句法分析树上的循环神经网络(recurrentneuralnetwork,RNN)对电影评论文本进行细粒度的情感极性判别[6]。将wordembedding与卷积神经网络(convolutionalneuralnetwork,CNN)结合进行句子的分类,获得了非常好的效果[7]。CNN虽然能够学习到时间或空间局部特征,避免了人工特征的提取,但是缺乏学习序列相关性的能力。RNN被证明是一种有效解决上下文信息的方法,但该方法存在梯度消失和爆炸的问题。文献[8]指出长短期记忆(longshorttermmemory,LSTM)型RNN可以有效地解决这一问题。与CNN相比虽然LSTM能够解决序列问题,但是无法提取出平行的特征。为此,本文提出一种基于卷积记忆神经网络模型(convolutionalmemoryneuralnetwork,CMNN)的微博短文本情感分析方法,使用CNN的卷积层提取局部特征,作为下一层LSTM网络的输入来完成微博短文本情感分析,从而更好地利用局部平行特征、上下文信息和减少了人工标注的方式来解决微博短文本的情感分类。1相关工作情感分析(sentimentanalysis),又称倾向性分析,意见抽取(opinionextraction),意见挖掘(opinionmining),情感挖掘(sentimentmining),主观分析(subjectivityanalysis),它是对带有情感色彩的主观性文本进行分析、处理、归纳和推理的过程[9]。李婷婷等人[3]尝试从文本数据中人工构建若干特征,再利用传统的机器学习方法进行情感分类。同时有些研究者从语言学角度出发,Taboada等人[10]利用词典中情感词和短语的相关极性和强度,并采用集约化和否定化计算文本的情感得分。Yuan等人[11]结合词典和规则来计算文本的情感极性。这种方法通常的重点是情感评价词语或其组合的极性判断以及极性求和的方法。然而,特征工程的设计耗费人力,它在需要一定的先验知识的同时还依赖于不断深入理解问题和依赖情感知识,其分类效果严重依赖于所构建特征的质量和模型参数的调优。近年来,越来越多的研究人员青睐于使用深度学习技术来解决文本分类问题[12]。深度学习强大的特征学习能力可以从少量的样本集中抓取到数据的本质特征。Socher等人[5]利用递归神经网络模型对影评数据进行情感分析,取得了比传统方法更好的效果。Luong等人[13]用递归神经网络以明确词的形态结构来建模。Chrupala等人[14]提出一个简单的循环网络(simplerecurrentnetwork,SRN),从而得到连续的字序列的向量表示,并将此向量作为特征用条件随机场进行分类,解决了字级文本分割和标签的嵌入任务。Santos等人[15]提出了基于深度卷积神经网络的分析模型,利用两层卷积层从任意长度的单子和句子中抽取特征。秦锋等人[16]引入了隐马尔可夫支持向量机模型,将微博的上下文语境融入模型中,提高了情感极性的识别率。目前的相关工作中,基于传统机器学习、情感词典资源、人工规则的特征抽取往往依赖于语料领域,而且所抽取的文本特征维数随着抽取规则的增加线性增加。与前者相比,神经网络模型较多考虑的还是将单一模型或者改进模型应用到文本的情感分析,实验效果依赖于原本模型的特点。2CNN模型文本向量化,为文本的向量化的实现提供了基础。结合CNN和LSTM的特点,提出了CMNN模型。该模型首先要将短文本向量化,通过CNN的卷积层抽取短文本的局部最优信息,将其作为LSTM的输入层,并利用误差反向传播算法训练模型。从而CMNN模型不仅可以学习到微博短文本的局部特征,还可以学习到长距离的上下文历史信息。2.1文本向量化神经网络的输入是需要将文本数据映射为维的实数向量,即文本向量化。目前,文本向量化的表现方式主要有两种:one-hotrepresentation和distributedrepresentation。one-hotrepresentation是将每个词表示为一个很长的向量,向量的维度是词表大小,通常非常稀疏,且任意两个字间不存在联系、均是孤立的;而distributedrepresentation的方式以低维度的向量来表示,让相关的字在语义上更加接近,通常又称嵌入(embedding)。本文细分为两种种表示方式:onehot和wordembedding。onehot:利用分词工具首先将句子进行分词,以词为�

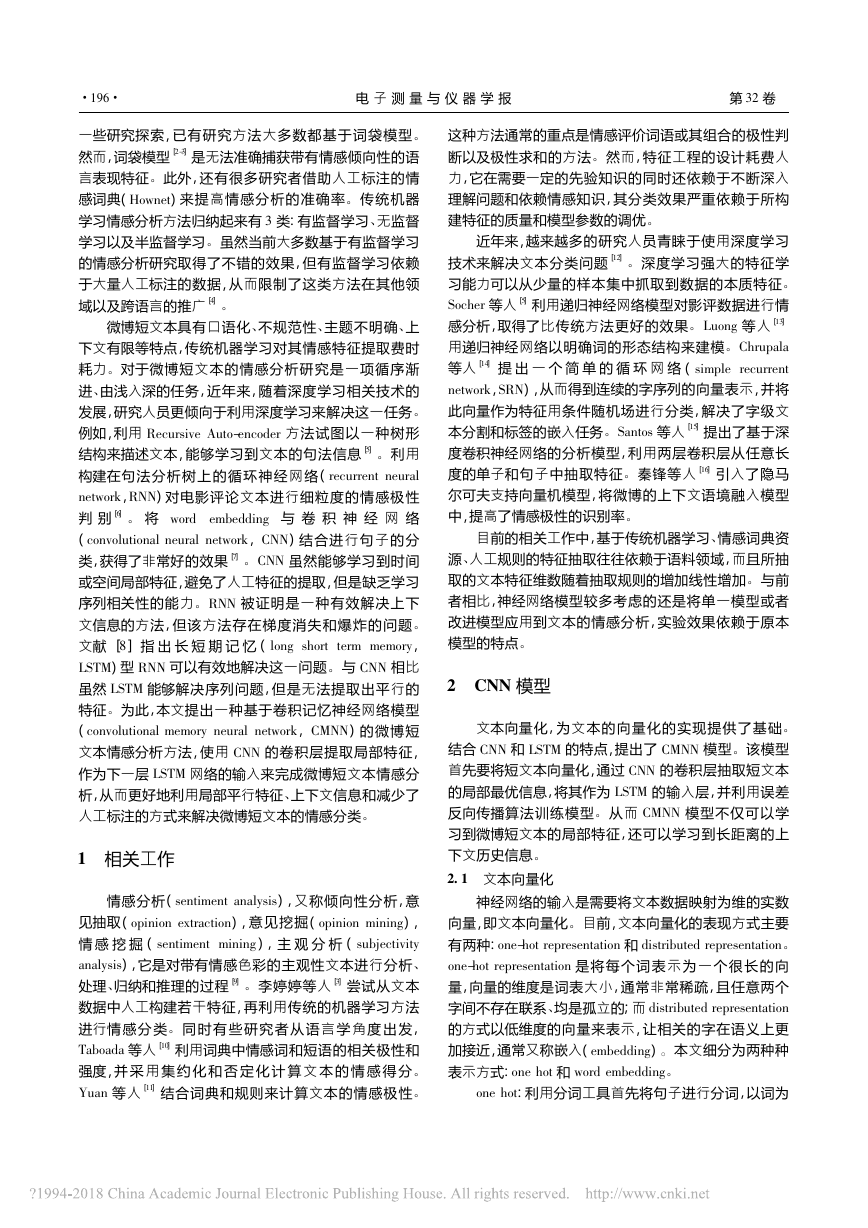

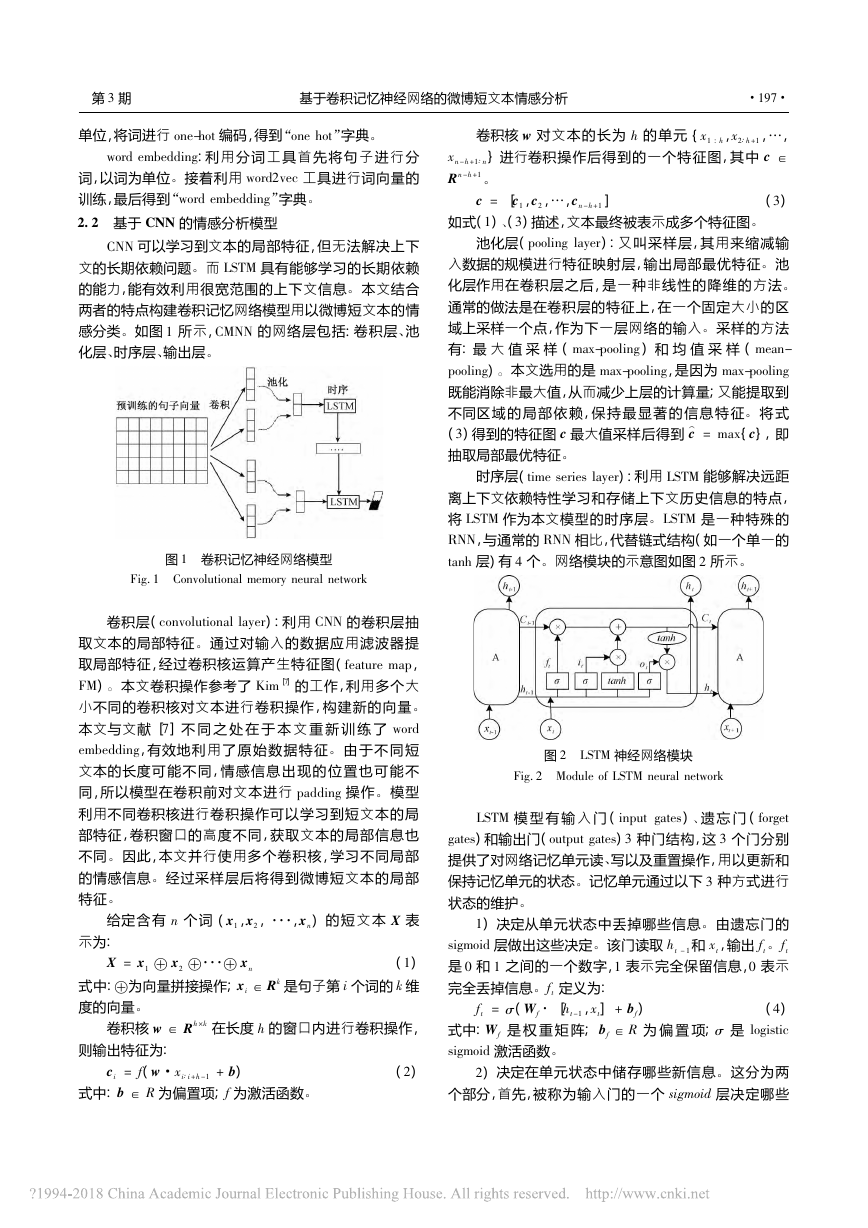

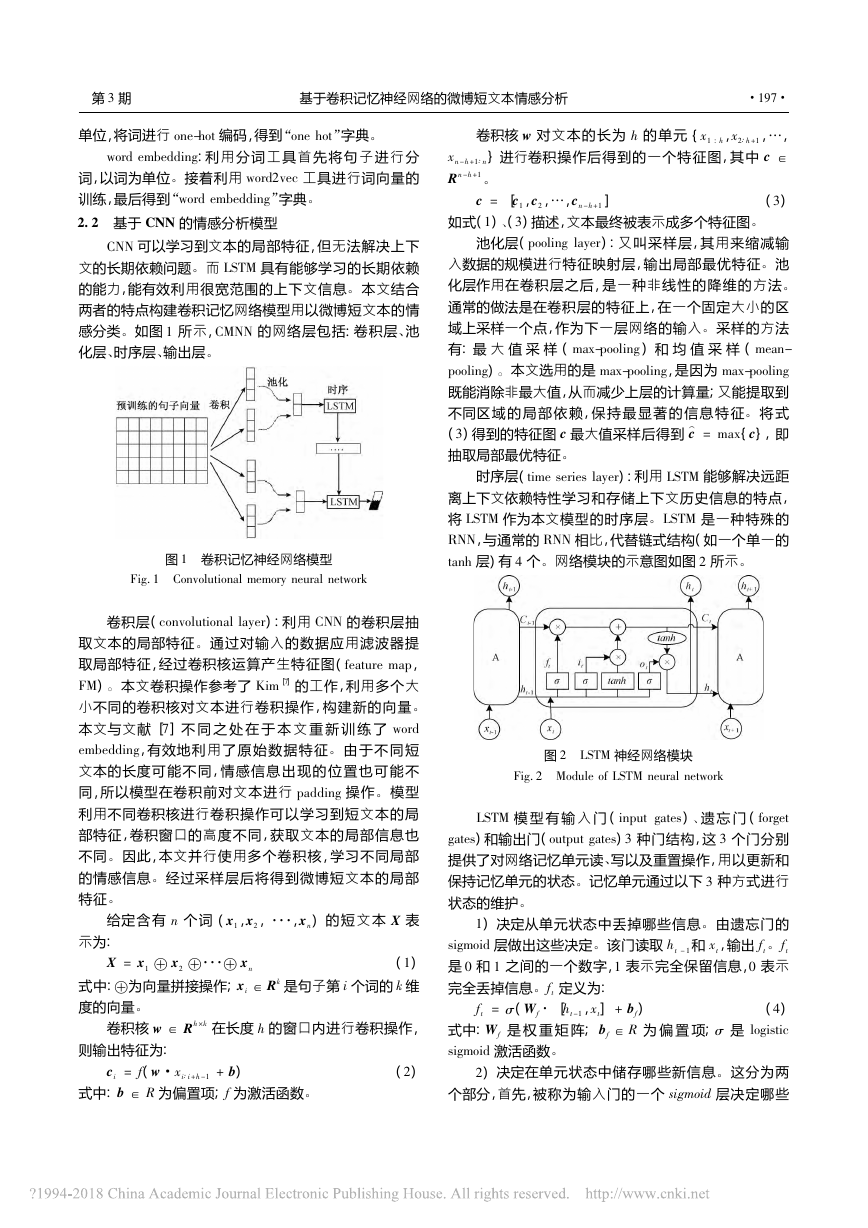

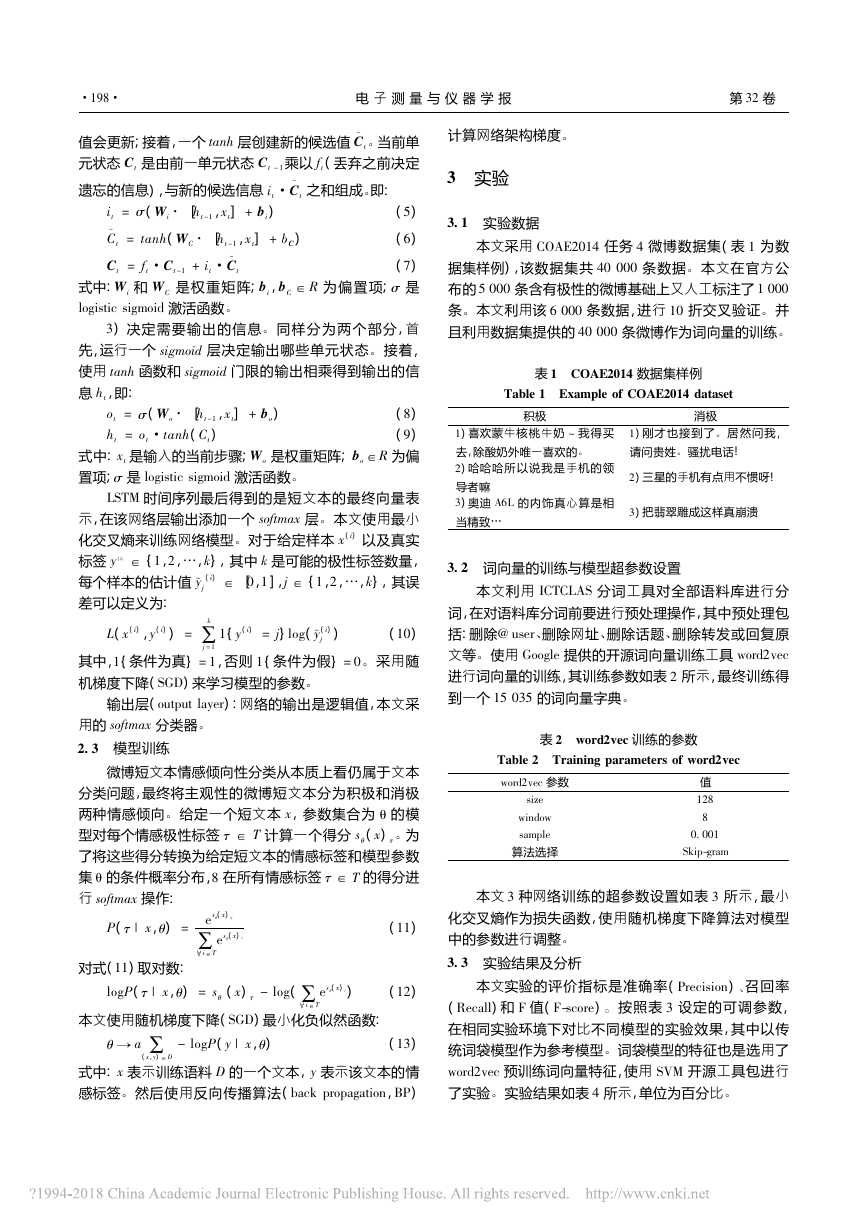

第3期基于卷积记忆神经网络的微博短文本情感分析·197·单位,将词进行one-hot编码,得到“onehot”字典。wordembedding:利用分词工具首先将句子进行分词,以词为单位。接着利用word2vec工具进行词向量的训练,最后得到“wordembedding”字典。2.2基于CNN的情感分析模型CNN可以学习到文本的局部特征,但无法解决上下文的长期依赖问题。而LSTM具有能够学习的长期依赖的能力,能有效利用很宽范围的上下文信息。本文结合两者的特点构建卷积记忆网络模型用以微博短文本的情感分类。如图1所示,CMNN的网络层包括:卷积层、池化层、时序层、输出层。图1卷积记忆神经网络模型Fig.1Convolutionalmemoryneuralnetwork卷积层(convolutionallayer):利用CNN的卷积层抽取文本的局部特征。通过对输入的数据应用滤波器提取局部特征,经过卷积核运算产生特征图(featuremap,FM)。本文卷积操作参考了Kim[7]的工作,利用多个大小不同的卷积核对文本进行卷积操作,构建新的向量。本文与文献[7]不同之处在于本文重新训练了wordembedding,有效地利用了原始数据特征。由于不同短文本的长度可能不同,情感信息出现的位置也可能不同,所以模型在卷积前对文本进行padding操作。模型利用不同卷积核进行卷积操作可以学习到短文本的局部特征,卷积窗口的高度不同,获取文本的局部信息也不同。因此,本文并行使用多个卷积核,学习不同局部的情感信息。经过采样层后将得到微博短文本的局部特征。给定含有n个词(x1,x2,···,xn)的短文本X表示为:X=x1x2···xn(1)式中:为向量拼接操作;xi∈Rk是句子第i个词的k维度的向量。卷积核w∈Rh×k在长度h的窗口内进行卷积操作,则输出特征为:ci=f(w·xi∶i+h-1+b)(2)式中:b∈R为偏置项;f为激活函数。卷积核w对文本的长为h的单元{x1h,x2∶h+1,…,xn-h+1∶n}进行卷积操作后得到的一个特征图,其中c∈Rn-h+1。c=[c1,c2,…,cn-h+1](3)如式(1)、(3)描述,文本最终被表示成多个特征图。池化层(poolinglayer):又叫采样层,其用来缩减输入数据的规模进行特征映射层,输出局部最优特征。池化层作用在卷积层之后,是一种非线性的降维的方法。通常的做法是在卷积层的特征上,在一个固定大小的区域上采样一个点,作为下一层网络的输入。采样的方法有:最大值采样(max-pooling)和均值采样(mean-pooling)。本文选用的是max-pooling,是因为max-pooling既能消除非最大值,从而减少上层的计算量;又能提取到不同区域的局部依赖,保持最显著的信息特征。将式(3)得到的特征图c最大值采样后得到c⌒=max{c},即抽取局部最优特征。时序层(timeserieslayer):利用LSTM能够解决远距离上下文依赖特性学习和存储上下文历史信息的特点,将LSTM作为本文模型的时序层。LSTM是一种特殊的RNN,与通常的RNN相比,代替链式结构(如一个单一的tanh层)有4个。网络模块的示意图如图2所示。图2LSTM神经网络模块Fig.2ModuleofLSTMneuralnetworkLSTM模型有输入门(inputgates)、遗忘门(forgetgates)和输出门(outputgates)3种门结构,这3个门分别提供了对网络记忆单元读、写以及重置操作,用以更新和保持记忆单元的状态。记忆单元通过以下3种方式进行状态的维护。1)决定从单元状态中丢掉哪些信息。由遗忘门的sigmoid层做出这些决定。该门读取ht-1和xt,输出ft。ft是0和1之间的一个数字,1表示完全保留信息,0表示完全丢掉信息。ft定义为:ft=σ(Wf·[ht-1,xt]+bf)(4)式中:Wf是权重矩阵;bf∈R为偏置项;σ是logisticsigmoid激活函数。2)决定在单元状态中储存哪些新信息。这分为两个部分,首先,被称为输入门的一个sigmoid层决定哪些�

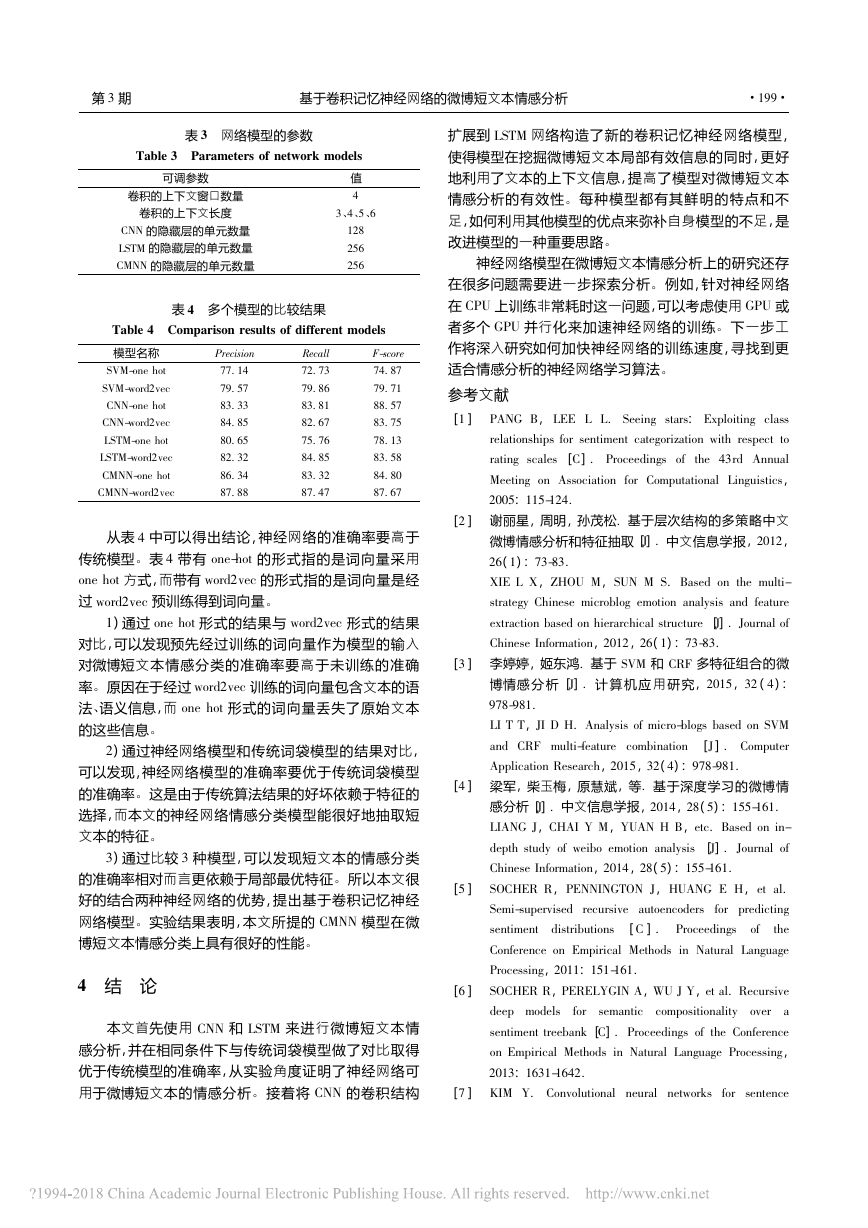

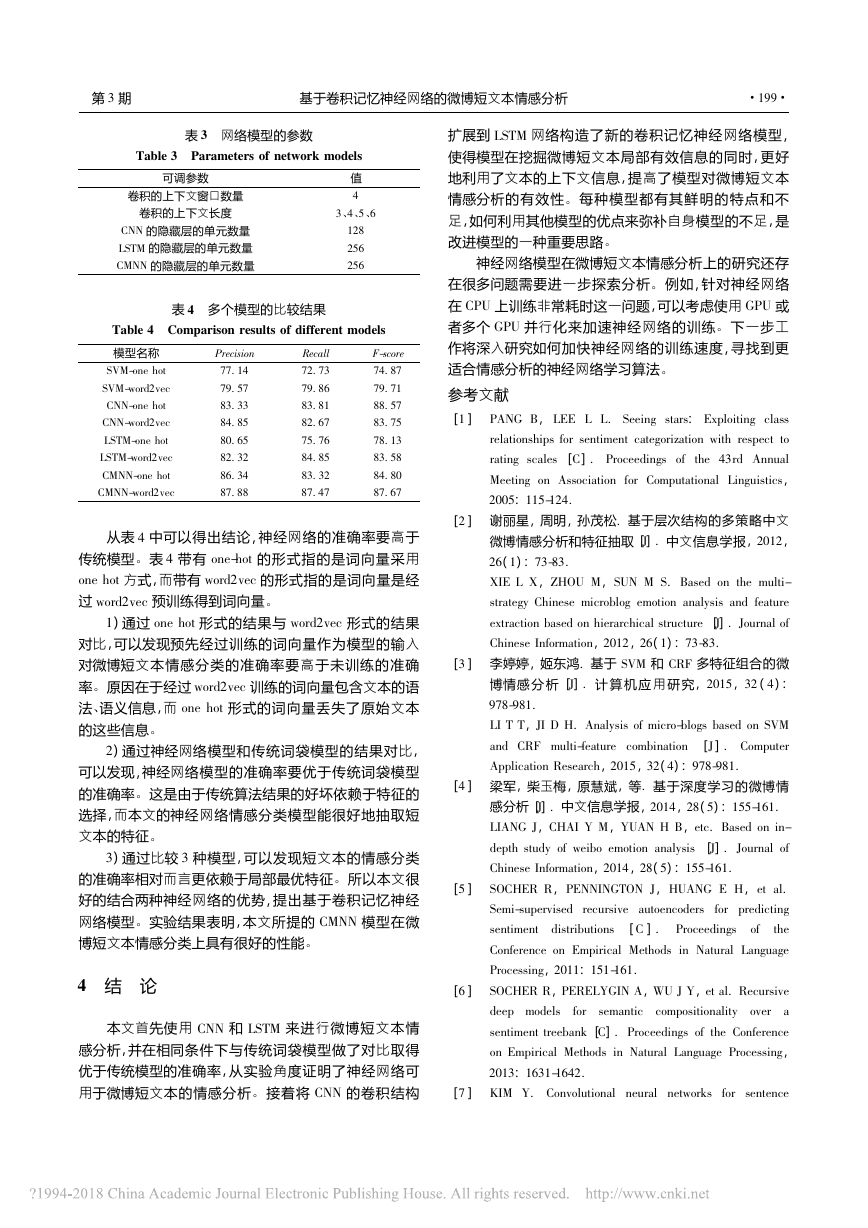

·198·电子测量与仪器学报第32卷值会更新;接着,一个tanh层创建新的候选值C~t。当前单元状态Ct是由前一单元状态Ct-1乘以ft(丢弃之前决定遗忘的信息),与新的候选信息it·C~t之和组成。即:it=σ(Wi·[ht-1,xt]+bi)(5)C~t=tanh(WC·[ht-1,xt]+bC)(6)Ct=ft·Ct-1+it·C~t(7)式中:Wi和WC是权重矩阵;bi,bC∈R为偏置项;σ是logisticsigmoid激活函数。3)决定需要输出的信息。同样分为两个部分,首先,运行一个sigmoid层决定输出哪些单元状态。接着,使用tanh函数和sigmoid门限的输出相乘得到输出的信息ht,即:ot=σ(Wo·[ht-1,xt]+bo)(8)ht=ot·tanh(Ct)(9)式中:xt是输入的当前步骤;Wo是权重矩阵;bo∈R为偏置项;σ是logisticsigmoid激活函数。LSTM时间序列最后得到的是短文本的最终向量表示,在该网络层输出添加一个softmax层。本文使用最小化交叉熵来训练网络模型。对于给定样本x(i)以及真实标签y(i)∈{1,2,…,k},其中k是可能的极性标签数量,每个样本的估计值珓yj(i)∈[0,1],j∈{1,2,…,k},其误差可以定义为:L(x(i),y(i))=∑kj=11{y(i)=j}log(珓y(i)j)(10)其中,1{条件为真}=1,否则1{条件为假}=0。采用随机梯度下降(SGD)来学习模型的参数。输出层(outputlayer):网络的输出是逻辑值,本文采用的softmax分类器。2.3模型训练微博短文本情感倾向性分类从本质上看仍属于文本分类问题,最终将主观性的微博短文本分为积极和消极两种情感倾向。给定一个短文本x,参数集合为θ的模型对每个情感极性标签τ∈T计算一个得分sθ(x)τ。为了将这些得分转换为给定短文本的情感标签和模型参数集θ的条件概率分布,8在所有情感标签τ∈T的得分进行softmax操作:P(τ|x,θ)=esθ(x)τ∑i∈Tesθ(x)i(11)对式(11)取对数:logP(τ|x,θ)=sθ(x)τ-log(∑i∈Tesθ(x)i)(12)本文使用随机梯度下降(SGD)最小化负似然函数:θ→a∑(x,y)∈D-logP(y|x,θ)(13)式中:x表示训练语料D的一个文本,y表示该文本的情感标签。然后使用反向传播算法(backpropagation,BP)计算网络架构梯度。3实验3.1实验数据本文采用COAE2014任务4微博数据集(表1为数据集样例),该数据集共40000条数据。本文在官方公布的5000条含有极性的微博基础上又人工标注了1000条。本文利用该6000条数据,进行10折交叉验证。并且利用数据集提供的40000条微博作为词向量的训练。表1COAE2014数据集样例Table1ExampleofCOAE2014dataset积极消极1)喜欢蒙牛核桃牛奶~我得买去,除酸奶外唯一喜欢的。1)刚才也接到了。居然问我,请问贵姓。骚扰电话!2)哈哈哈所以说我是手机的领导者嘛2)三星的手机有点用不惯呀!3)奥迪A6L的内饰真心算是相当精致…3)把翡翠雕成这样真崩溃3.2词向量的训练与模型超参数设置本文利用ICTCLAS分词工具对全部语料库进行分词,在对语料库分词前要进行预处理操作,其中预处理包括:删除@user、删除网址、删除话题、删除转发或回复原文等。使用Google提供的开源词向量训练工具word2vec进行词向量的训练,其训练参数如表2所示,最终训练得到一个15035的词向量字典。表2word2vec训练的参数Table2Trainingparametersofword2vecword2vec参数值size128window8sample0.001算法选择Skip-gram本文3种网络训练的超参数设置如表3所示,最小化交叉熵作为损失函数,使用随机梯度下降算法对模型中的参数进行调整。3.3实验结果及分析本文实验的评价指标是准确率(Precision)、召回率(Recall)和F值(F-score)。按照表3设定的可调参数,在相同实验环境下对比不同模型的实验效果,其中以传统词袋模型作为参考模型。词袋模型的特征也是选用了word2vec预训练词向量特征,使用SVM开源工具包进行了实验。实验结果如表4所示,单位为百分比。�

第3期基于卷积记忆神经网络的微博短文本情感分析·199·表3网络模型的参数Table3Parametersofnetworkmodels可调参数值卷积的上下文窗口数量4卷积的上下文长度3、4、5、6CNN的隐藏层的单元数量128LSTM的隐藏层的单元数量256CMNN的隐藏层的单元数量256表4多个模型的比较结果Table4Comparisonresultsofdifferentmodels模型名称PrecisionRecallF-scoreSVM-onehot77.1472.7374.87SVM-word2vec79.5779.8679.71CNN-onehot83.3383.8188.57CNN-word2vec84.8582.6783.75LSTM-onehot80.6575.7678.13LSTM-word2vec82.3284.8583.58CMNN-onehot86.3483.3284.80CMNN-word2vec87.8887.4787.67从表4中可以得出结论,神经网络的准确率要高于传统模型。表4带有one-hot的形式指的是词向量采用onehot方式,而带有word2vec的形式指的是词向量是经过word2vec预训练得到词向量。1)通过onehot形式的结果与word2vec形式的结果对比,可以发现预先经过训练的词向量作为模型的输入对微博短文本情感分类的准确率要高于未训练的准确率。原因在于经过word2vec训练的词向量包含文本的语法、语义信息,而onehot形式的词向量丢失了原始文本的这些信息。2)通过神经网络模型和传统词袋模型的结果对比,可以发现,神经网络模型的准确率要优于传统词袋模型的准确率。这是由于传统算法结果的好坏依赖于特征的选择,而本文的神经网络情感分类模型能很好地抽取短文本的特征。3)通过比较3种模型,可以发现短文本的情感分类的准确率相对而言更依赖于局部最优特征。所以本文很好的结合两种神经网络的优势,提出基于卷积记忆神经网络模型。实验结果表明,本文所提的CMNN模型在微博短文本情感分类上具有很好的性能。4结论本文首先使用CNN和LSTM来进行微博短文本情感分析,并在相同条件下与传统词袋模型做了对比取得优于传统模型的准确率,从实验角度证明了神经网络可用于微博短文本的情感分析。接着将CNN的卷积结构扩展到LSTM网络构造了新的卷积记忆神经网络模型,使得模型在挖掘微博短文本局部有效信息的同时,更好地利用了文本的上下文信息,提高了模型对微博短文本情感分析的有效性。每种模型都有其鲜明的特点和不足,如何利用其他模型的优点来弥补自身模型的不足,是改进模型的一种重要思路。神经网络模型在微博短文本情感分析上的研究还存在很多问题需要进一步探索分析。例如,针对神经网络在CPU上训练非常耗时这一问题,可以考虑使用GPU或者多个GPU并行化来加速神经网络的训练。下一步工作将深入研究如何加快神经网络的训练速度,寻找到更适合情感分析的神经网络学习算法。参考文献[1]PANGB,LEELL.Seeingstars:Exploitingclassrelationshipsforsentimentcategorizationwithrespecttoratingscales[C].Proceedingsofthe43rdAnnualMeetingonAssociationforComputationalLinguistics,2005:115-124.[2]谢丽星,周明,孙茂松.基于层次结构的多策略中文微博情感分析和特征抽取[J].中文信息学报,2012,26(1):73-83.XIELX,ZHOUM,SUNMS.Basedonthemulti-strategyChinesemicroblogemotionanalysisandfeatureextractionbasedonhierarchicalstructure[J].JournalofChineseInformation,2012,26(1):73-83.[3]李婷婷,姬东鸿.基于SVM和CRF多特征组合的微博情感分析[J].计算机应用研究,2015,32(4):978-981.LITT,JIDH.Analysisofmicro-blogsbasedonSVMandCRFmulti-featurecombination[J].ComputerApplicationResearch,2015,32(4):978-981.[4]梁军,柴玉梅,原慧斌,等.基于深度学习的微博情感分析[J].中文信息学报,2014,28(5):155-161.LIANGJ,CHAIYM,YUANHB,etc.Basedonin-depthstudyofweiboemotionanalysis[J].JournalofChineseInformation,2014,28(5):155-161.[5]SOCHERR,PENNINGTONJ,HUANGEH,etal.Semi-supervisedrecursiveautoencodersforpredictingsentimentdistributions[C].ProceedingsoftheConferenceonEmpiricalMethodsinNaturalLanguageProcessing,2011:151-161.[6]SOCHERR,PERELYGINA,WUJY,etal.Recursivedeepmodelsforsemanticcompositionalityoverasentimenttreebank[C].ProceedingsoftheConferenceonEmpiricalMethodsinNaturalLanguageProcessing,2013:1631-1642.[7]KIMY.Convolutionalneuralnetworksforsentence�

·200·电子测量与仪器学报第32卷classification[C].ProceedingsoftheConferenceonEmpiricalMethodsinNaturalLanguageProcessing,2014:1746–1751.[8]SAKH,SENIORA,BEAUFAYSF.Longshort-termmemoryrecurrentneuralnetworkarchitecturesforlargescaleacousticmodeling[C].ProceedingsoftheAnnualConferenceoftheInternationalSpeechCommunicationAssociation,2014:338-342.[9]赵妍妍,秦兵,刘挺.文本情感分析[J].软件学报,2010,21(8):1834-1848.ZHAOYY,QINB,LIUB.Textemotionanalysis[J].JournalofSoftware,2010,21(8):1834-1848.[10]TABOADAM,BROOKEJ,TOFILOSKIM,etal.Lexicon-basedmethodsforsentimentanalysis[J].Computationallinguistics,2011,37(2):267-307.[11]YUAND,ZHOUY,LIR,etal.Sentimentanalysisofmicroblogcombiningdictionaryandrules[C].ProceedingsoftheIEEE/ACMInternationalConferenceonAdvancesinSocialNetworksAnalysisandMining,2014:785-789.[12]陈龙,管子玉,何金红,等.情感分类研究进展[J].计算机研究与发展,2017,54(6):1150-1170.CHENL,GUANZY,HEJH,etal.Asurveyonsentimentclassification[J].JournalofComputerResearchandDevelopment,2017,54(6):1150-1170.[13]LUONGT,SOCHERR,MANNINGCD.Betterwordrepresentationswithrecursiveneuralnetworksformorphology[C].ProceedingsoftheSIGNLLConferenceonComputationalNaturalLanguageLearning,2013:104-113.[14]CHRUPALAG.Textsegmentationwithcharacter-leveltextembeddings[C].ProceedingsoftheICMLworkshoponDeepLearningforAudio,SpeechandLanguageProcessing,2013.[15]SANTOSCND,GATTIM.Deepconvolutionalneuralnetworksforsentimentanalysisofshorttexts[C].Proceedingsofthe25thInternationalConferenceonComputationalLinguistics,2014:69-78.[16]秦锋,王恒,郑啸,等.基于上下文语境的微博情感分析[J].计算机工程,2017,43(3):241-246,252.QINF,WANGH,ZHENGX,etal.Micro-blogsentimentanalysisbasedonlinguisticcontext[J].ComputerEngineering,2017,43(3):241-246,252.作者简介郑啸,博士,现为安徽工业大学教授,主要研究方向为计算机网络、云计算与服务计算。E-mail:xzheng@ahut.edu.cnZhengXiao,Ph.D.,andnowheisaprofessorinAnhuiUniversityofTechnology.Hismainresearchinterestsincludeservicecomputingandmobilecloudcomputing.王义真,2017年于安徽工业大学获得硕士学位,主要研究方向为自然语言处理。E-mail:575092800@qq.comWangYizhenreceivedM.Sc.fromAnhuiUniversityofTechnologyin2017.Hismainresearchinterestsincludenaturallanguageprocessing.袁志祥,硕士,现为安徽工业大学副教授,主要研究方向为机器学习,信息系统应用。E-mail:zxyuan@ahut.edu.cnYuanZhixiang,M.Sc.,andnowheisanassociateprofessorinAnhuiUniversityofTechnology.Hismainresearchinterestsincludemachinelearning,andinformationsystemsapplication.秦锋,硕士,现为安徽工业大学教授,主要研究方向为数据挖掘,智能计算与计算机网络。E-mail:fqin@ahut.edu.cnQinFeng,M.Sc.andnowheisaprofessorinAnhuiUniversityofTechnology.Hismainresearchinterestsincludedatamining,intelligencecomputing,andcomputernetworks.�

2023年江西萍乡中考道德与法治真题及答案.doc

2023年江西萍乡中考道德与法治真题及答案.doc 2012年重庆南川中考生物真题及答案.doc

2012年重庆南川中考生物真题及答案.doc 2013年江西师范大学地理学综合及文艺理论基础考研真题.doc

2013年江西师范大学地理学综合及文艺理论基础考研真题.doc 2020年四川甘孜小升初语文真题及答案I卷.doc

2020年四川甘孜小升初语文真题及答案I卷.doc 2020年注册岩土工程师专业基础考试真题及答案.doc

2020年注册岩土工程师专业基础考试真题及答案.doc 2023-2024学年福建省厦门市九年级上学期数学月考试题及答案.doc

2023-2024学年福建省厦门市九年级上学期数学月考试题及答案.doc 2021-2022学年辽宁省沈阳市大东区九年级上学期语文期末试题及答案.doc

2021-2022学年辽宁省沈阳市大东区九年级上学期语文期末试题及答案.doc 2022-2023学年北京东城区初三第一学期物理期末试卷及答案.doc

2022-2023学年北京东城区初三第一学期物理期末试卷及答案.doc 2018上半年江西教师资格初中地理学科知识与教学能力真题及答案.doc

2018上半年江西教师资格初中地理学科知识与教学能力真题及答案.doc 2012年河北国家公务员申论考试真题及答案-省级.doc

2012年河北国家公务员申论考试真题及答案-省级.doc 2020-2021学年江苏省扬州市江都区邵樊片九年级上学期数学第一次质量检测试题及答案.doc

2020-2021学年江苏省扬州市江都区邵樊片九年级上学期数学第一次质量检测试题及答案.doc 2022下半年黑龙江教师资格证中学综合素质真题及答案.doc

2022下半年黑龙江教师资格证中学综合素质真题及答案.doc