Hadoop 安装实验报告

小组成员:靳尧凯 201748300129007

岳洋 201748300129006

一. 实验目的以及实验环境

在 Linux 或者 Windows 下安装 Hadoop 并运行其中任意实例,本次

试验简单运行一个 wordcount 实例,选择的安装环境是在 VMware Fusion

8.5.3 虚拟机上,使用 ubuntu 来安装。以下是两个版本的截图。

�

二. 实验步骤以及运行结果截图

1.首先下载 vmware 虚拟机并安装

2.接着下载 Linux 套件,本实验使用 ubuntu。前两个步骤不是本实验的重

点,在此不做详细论述

3.配置 jdk,首先在 Java 官网下载官方的 jdk,尽量不要使用 ubuntu 自带

的 openjdk,可能会出现一些安装包不完整的情况,导致最后的 Hadoop 启动失

败。将官网中下载的 jdk 放在主文件夹下,就是 Home 中。在/usr/local 文件夹

下创建一个 java 文件用来放置 jdk

cd /usr/local

sudo mkdir java

上述两个语句就在/usr/local 下创建了一个 Java 文件夹

将 jdk 放在 Java 文件夹下

sudo mv jdk-8u171-linux-x64.tar.gz /usr/local/java

解压

sudo tar zxvf ./jdk-8u171-linux-x64.tar.gz

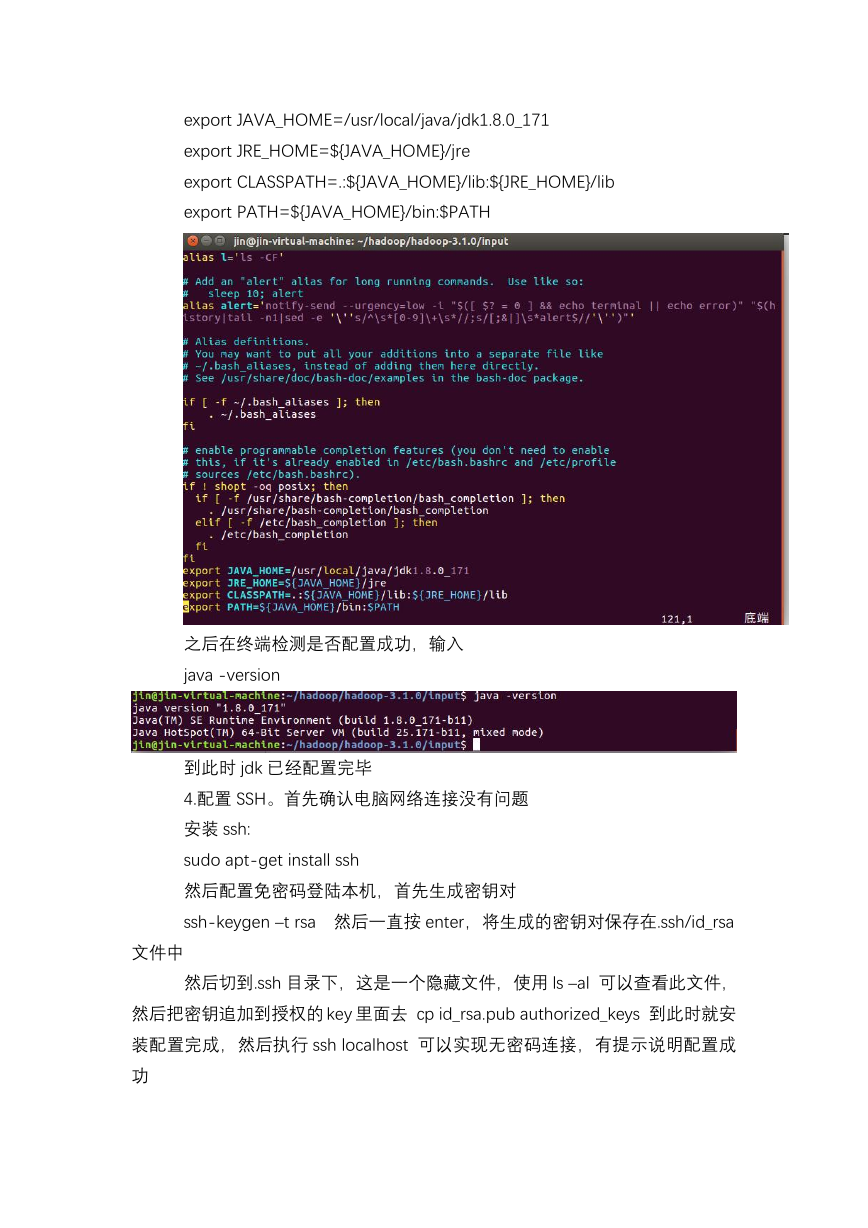

解压完成以后,在 Java 文件夹下就有了一个 jdk1.8.0_171 文件。然后设

置 jdk 环境变量,这里采用全局设置的方法

sudo vi ~/.bashrc

打开之后在末尾添加

�

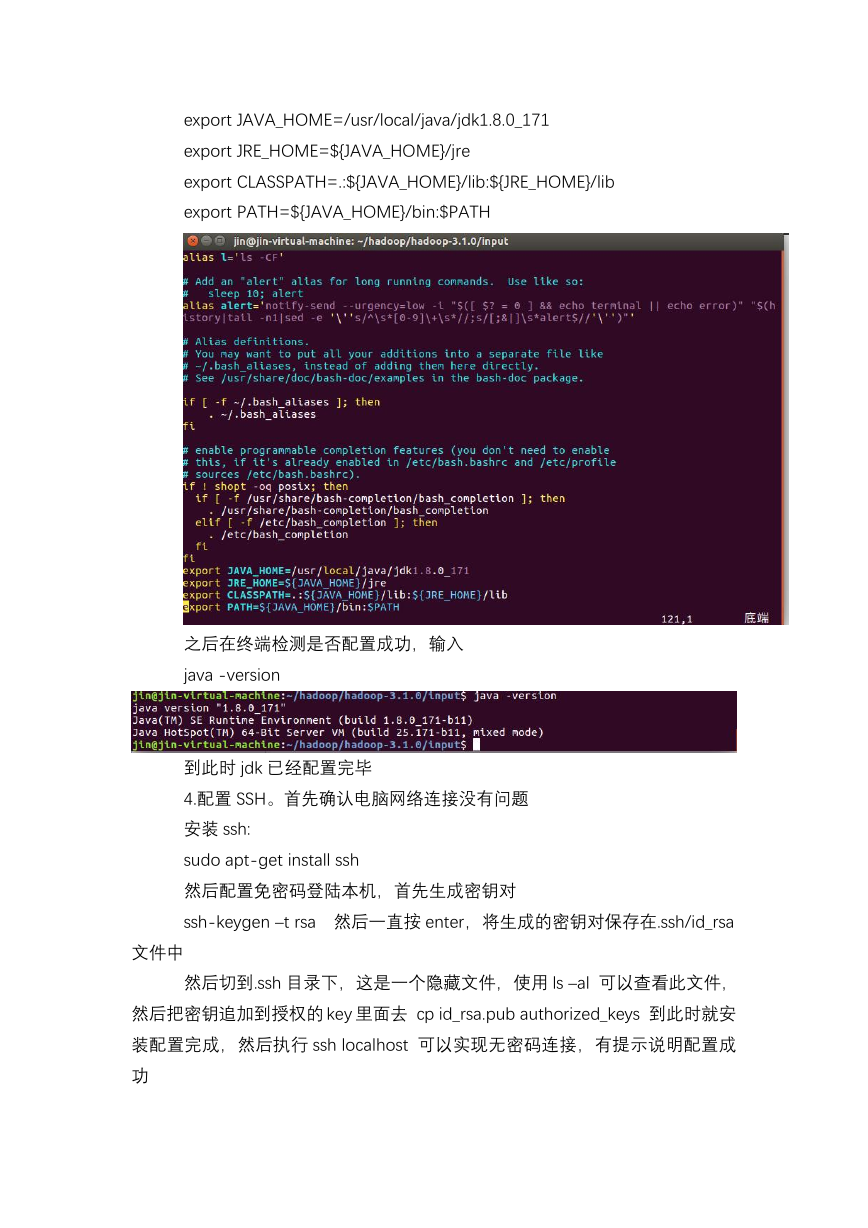

export JAVA_HOME=/usr/local/java/jdk1.8.0_171

export JRE_HOME=${JAVA_HOME}/jre

export CLASSPATH=.:${JAVA_HOME}/lib:${JRE_HOME}/lib

export PATH=${JAVA_HOME}/bin:$PATH

之后在终端检测是否配置成功,输入

java -version

到此时 jdk 已经配置完毕

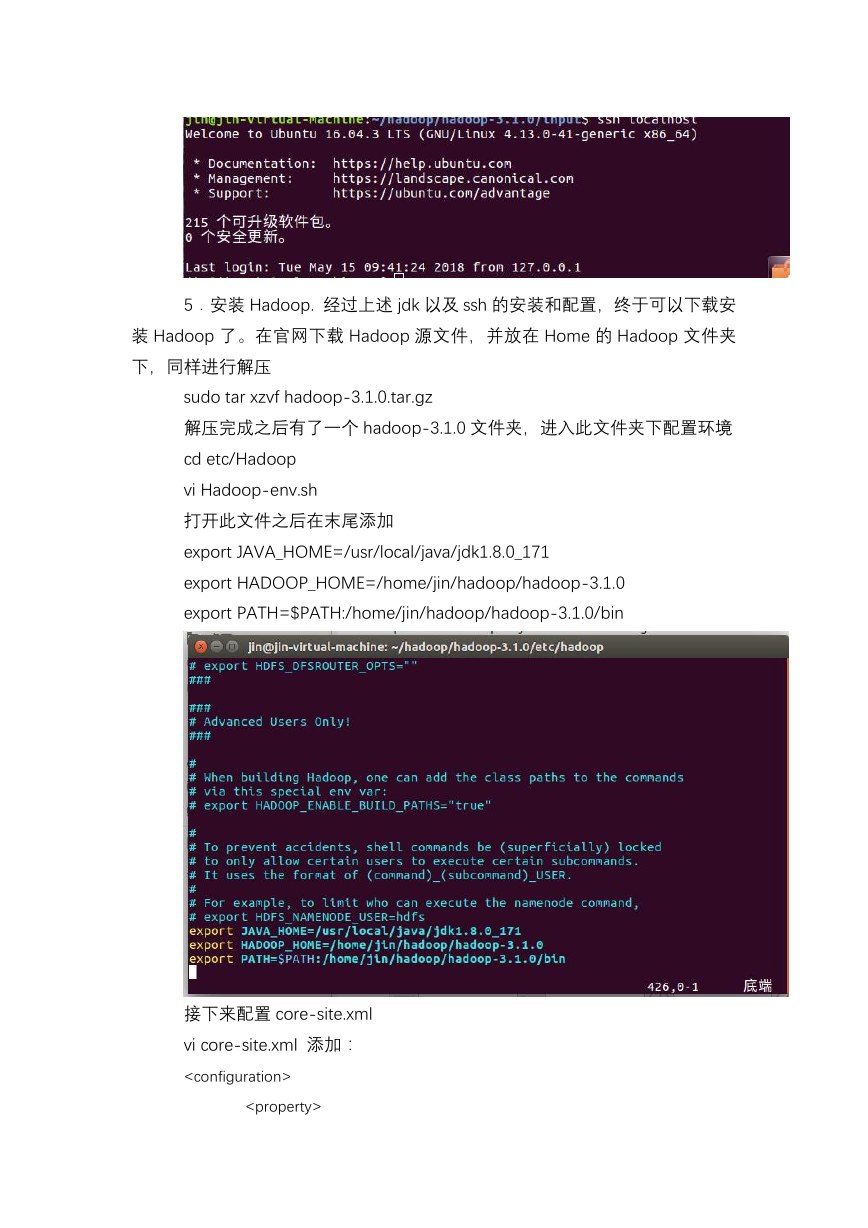

4.配置 SSH。首先确认电脑网络连接没有问题

安装 ssh:

sudo apt-get install ssh

然后配置免密码登陆本机,首先生成密钥对

ssh-keygen –t rsa 然后一直按 enter,将生成的密钥对保存在.ssh/id_rsa

文件中

然后切到.ssh 目录下,这是一个隐藏文件,使用 ls –al 可以查看此文件,

然后把密钥追加到授权的 key 里面去 cp id_rsa.pub authorized_keys 到此时就安

装配置完成,然后执行 ssh localhost 可以实现无密码连接,有提示说明配置成

功

�

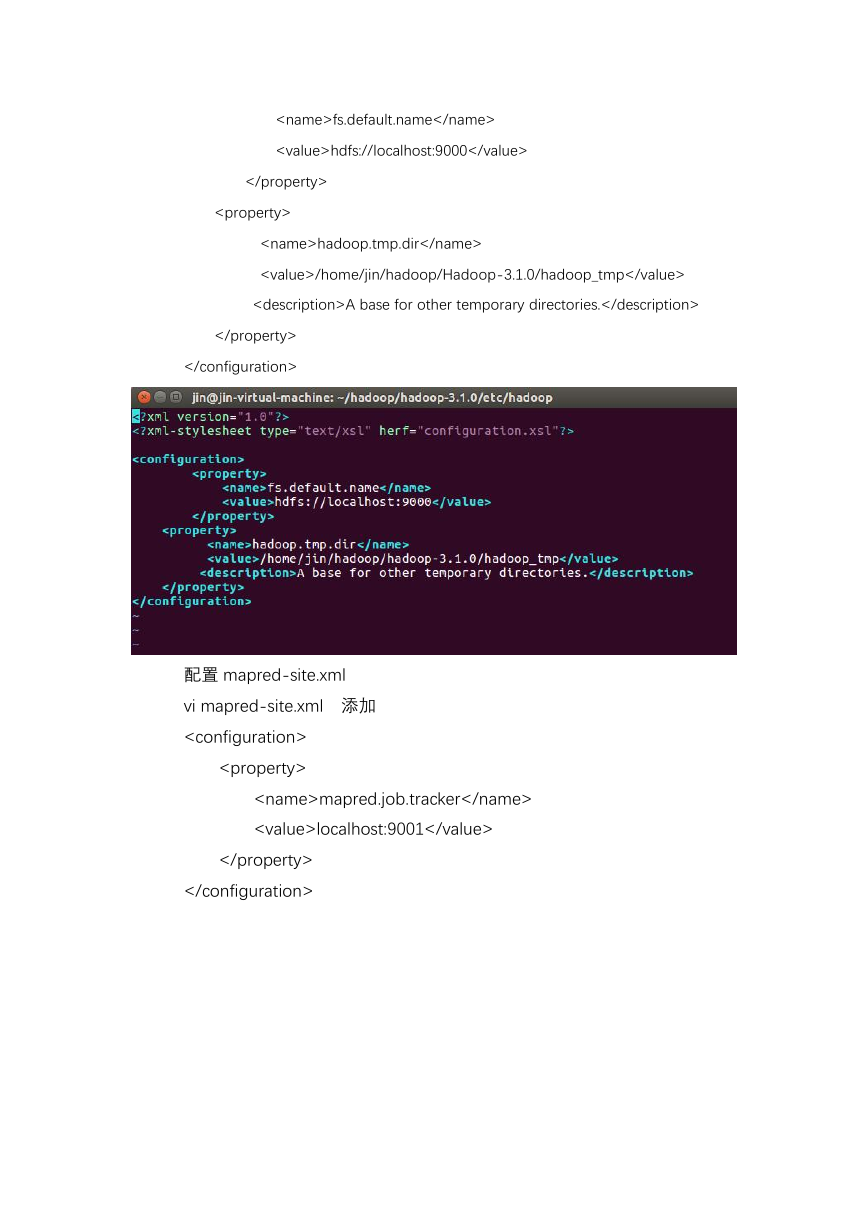

5.安装 Hadoop. 经过上述 jdk 以及 ssh 的安装和配置,终于可以下载安

装 Hadoop 了。在官网下载 Hadoop 源文件,并放在 Home 的 Hadoop 文件夹

下,同样进行解压

sudo tar xzvf hadoop-3.1.0.tar.gz

解压完成之后有了一个 hadoop-3.1.0 文件夹,进入此文件夹下配置环境

cd etc/Hadoop

vi Hadoop-env.sh

打开此文件之后在末尾添加

export JAVA_HOME=/usr/local/java/jdk1.8.0_171

export HADOOP_HOME=/home/jin/hadoop/hadoop-3.1.0

export PATH=$PATH:/home/jin/hadoop/hadoop-3.1.0/bin

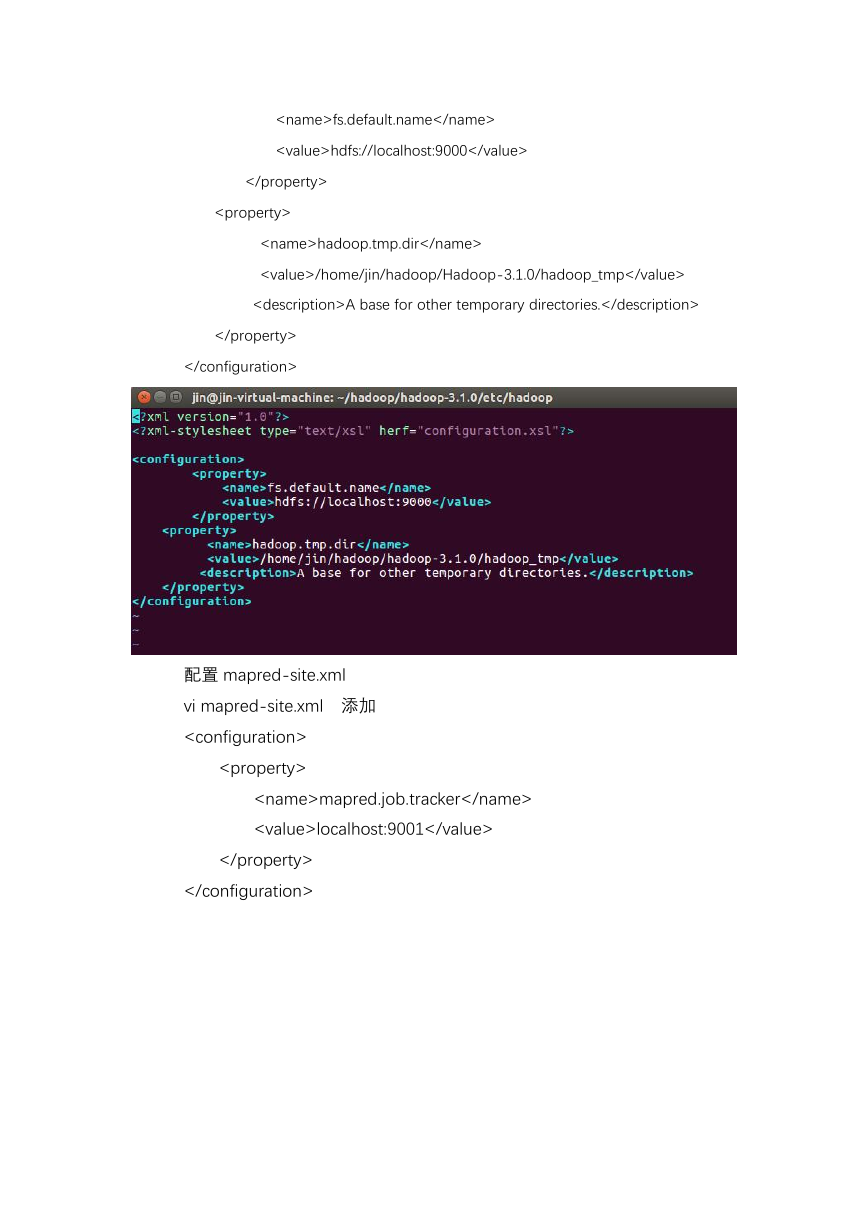

接下来配置 core-site.xml

vi core-site.xml 添加:

�fs.default.name

hdfs://localhost:9000

hadoop.tmp.dir

/home/jin/hadoop/Hadoop-3.1.0/hadoop_tmp

A base for other temporary directories.

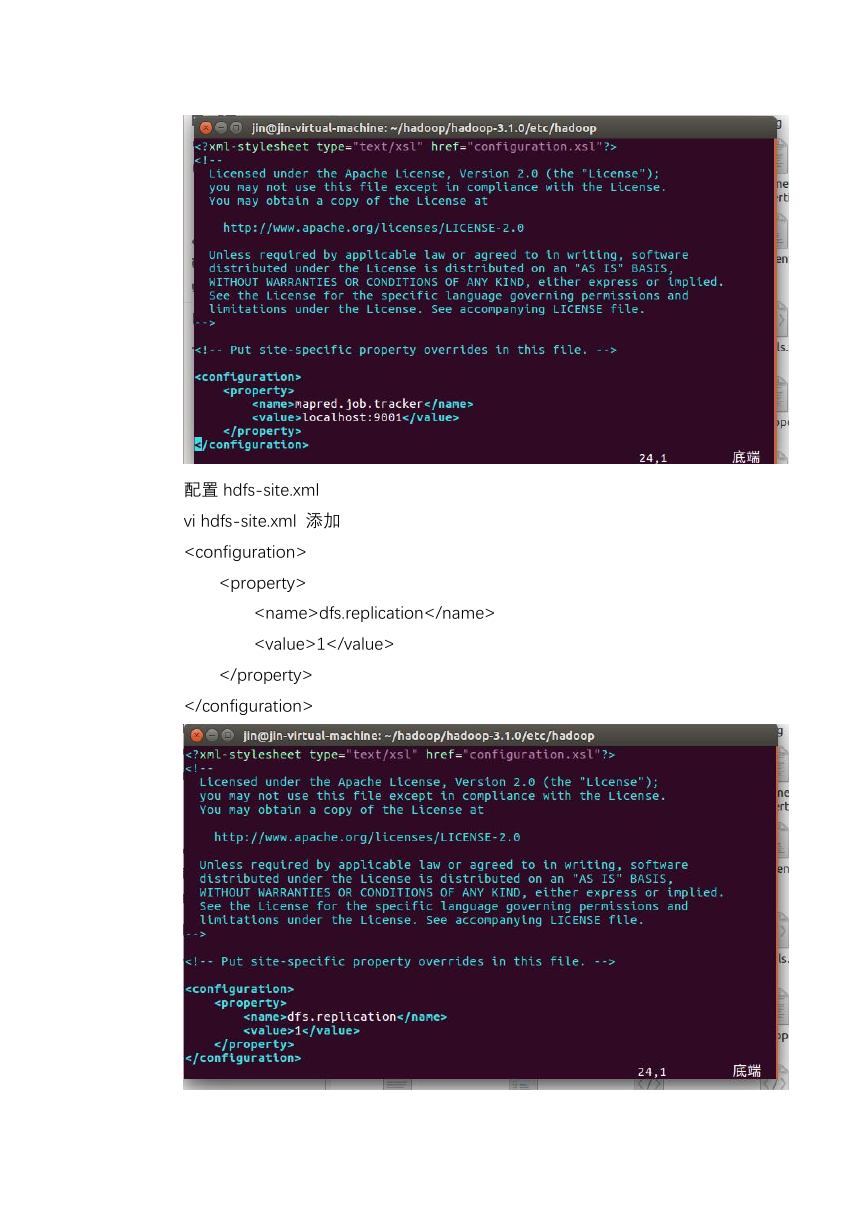

配置 mapred-site.xml

vi mapred-site.xml 添加

mapred.job.tracker

localhost:9001

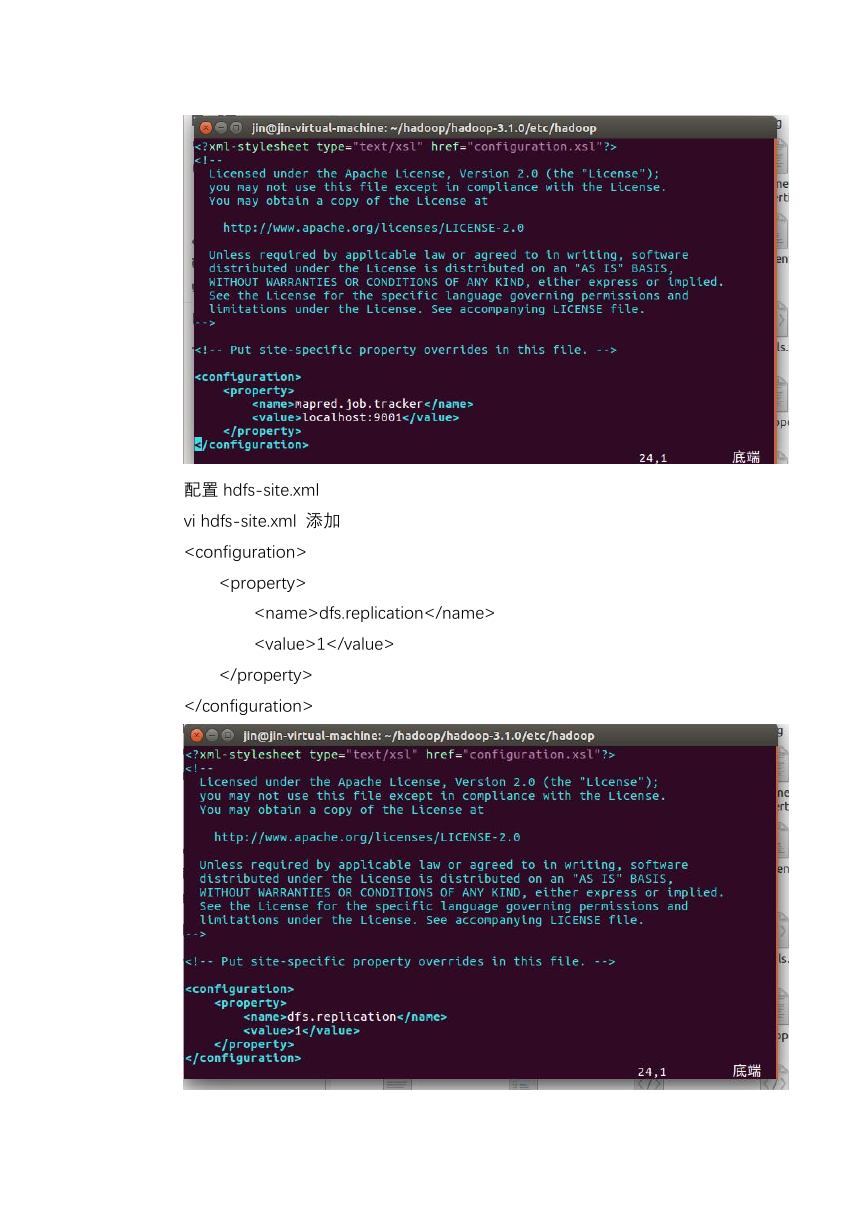

� 配置 hdfs-site.xml

vi hdfs-site.xml 添加

dfs.replication

1

�至此已经完全配置完毕,接下来就可以运行 Hadoop 了

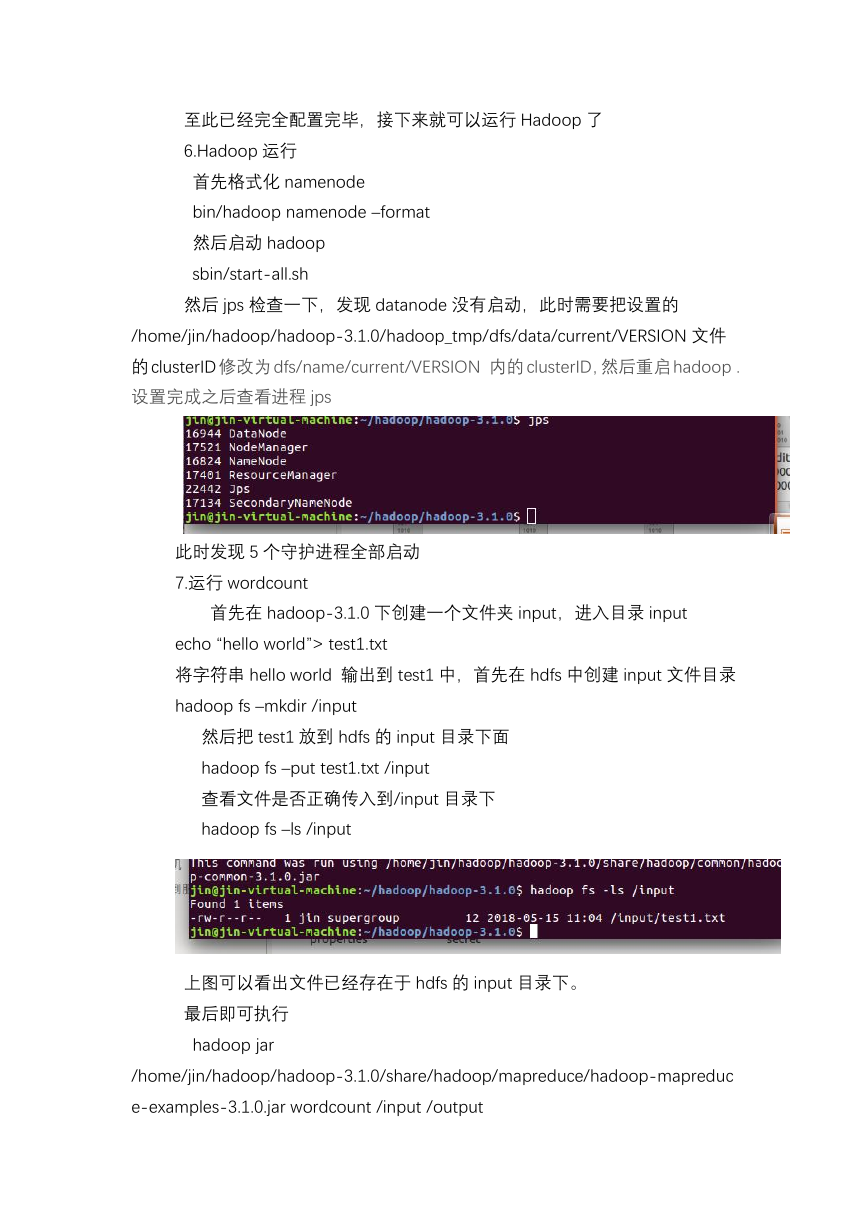

6.Hadoop 运行

首先格式化 namenode

bin/hadoop namenode –format

然后启动 hadoop

sbin/start-all.sh

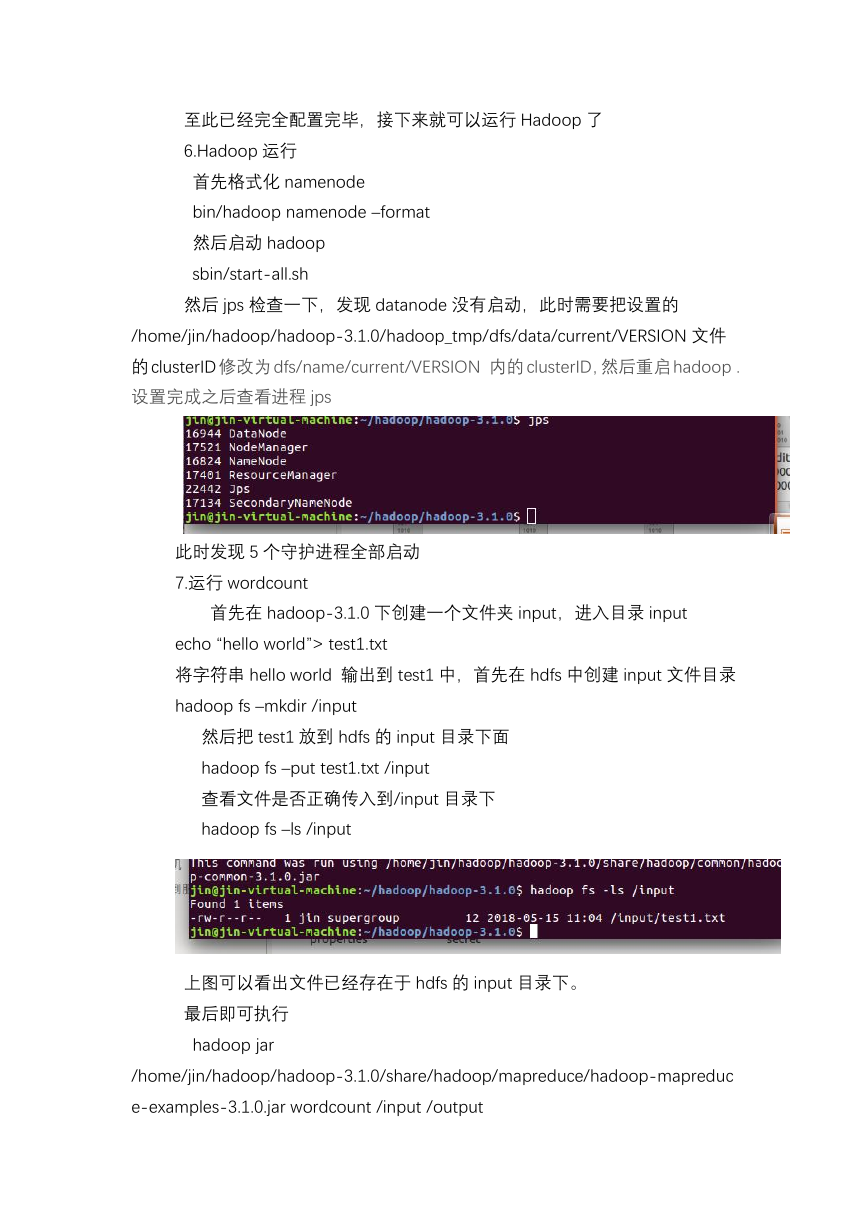

然后 jps 检查一下,发现 datanode 没有启动,此时需要把设置的

/home/jin/hadoop/hadoop-3.1.0/hadoop_tmp/dfs/data/current/VERSION 文件

的 clusterID 修改为 dfs/name/current/VERSION 内的 clusterID,然后重启 hadoop .

设置完成之后查看进程 jps

此时发现 5 个守护进程全部启动

7.运行 wordcount

首先在 hadoop-3.1.0 下创建一个文件夹 input,进入目录 input

echo “hello world”> test1.txt

将字符串 hello world 输出到 test1 中,首先在 hdfs 中创建 input 文件目录

hadoop fs –mkdir /input

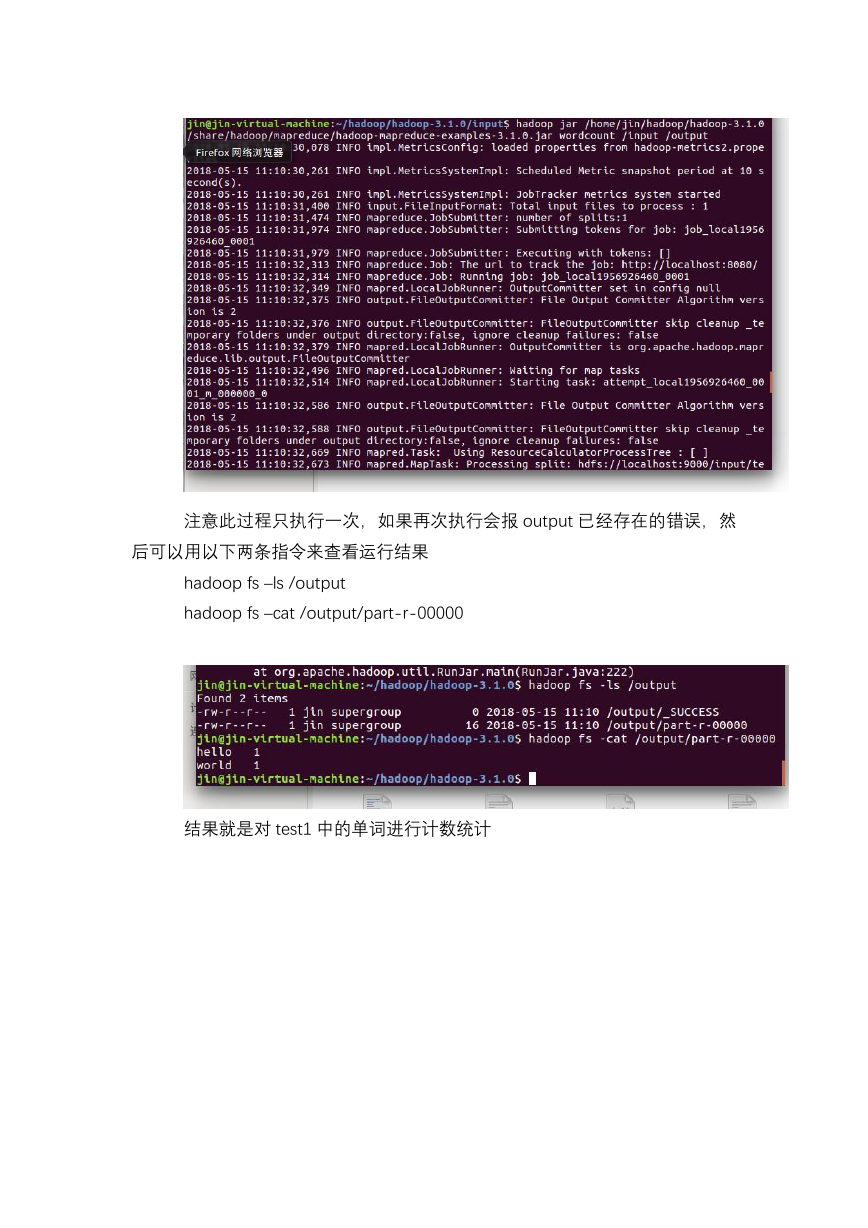

然后把 test1 放到 hdfs 的 input 目录下面

hadoop fs –put test1.txt /input

查看文件是否正确传入到/input 目录下

hadoop fs –ls /input

上图可以看出文件已经存在于 hdfs 的 input 目录下。

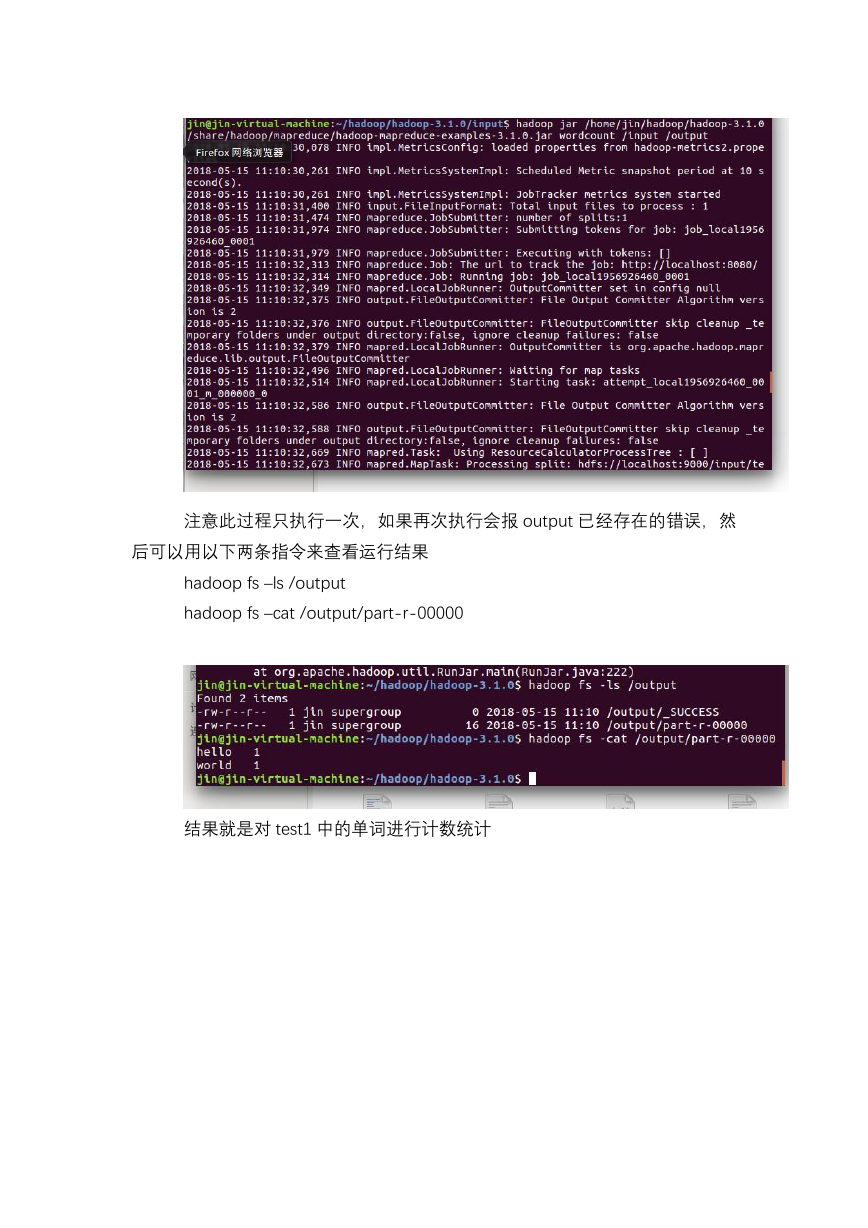

最后即可执行

hadoop jar

/home/jin/hadoop/hadoop-3.1.0/share/hadoop/mapreduce/hadoop-mapreduc

e-examples-3.1.0.jar wordcount /input /output

�

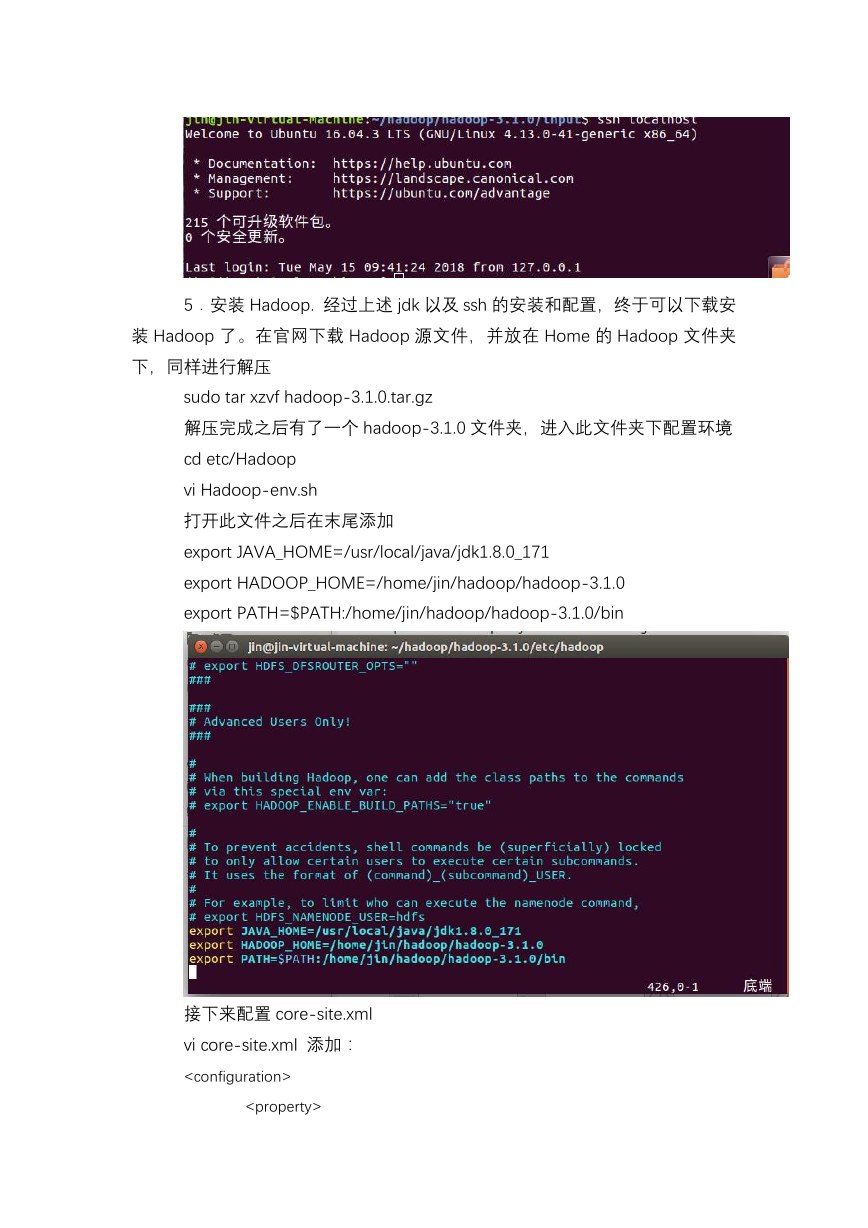

注意此过程只执行一次,如果再次执行会报 output 已经存在的错误,然

后可以用以下两条指令来查看运行结果

hadoop fs –ls /output

hadoop fs –cat /output/part-r-00000

结果就是对 test1 中的单词进行计数统计

�

2023年江西萍乡中考道德与法治真题及答案.doc

2023年江西萍乡中考道德与法治真题及答案.doc 2012年重庆南川中考生物真题及答案.doc

2012年重庆南川中考生物真题及答案.doc 2013年江西师范大学地理学综合及文艺理论基础考研真题.doc

2013年江西师范大学地理学综合及文艺理论基础考研真题.doc 2020年四川甘孜小升初语文真题及答案I卷.doc

2020年四川甘孜小升初语文真题及答案I卷.doc 2020年注册岩土工程师专业基础考试真题及答案.doc

2020年注册岩土工程师专业基础考试真题及答案.doc 2023-2024学年福建省厦门市九年级上学期数学月考试题及答案.doc

2023-2024学年福建省厦门市九年级上学期数学月考试题及答案.doc 2021-2022学年辽宁省沈阳市大东区九年级上学期语文期末试题及答案.doc

2021-2022学年辽宁省沈阳市大东区九年级上学期语文期末试题及答案.doc 2022-2023学年北京东城区初三第一学期物理期末试卷及答案.doc

2022-2023学年北京东城区初三第一学期物理期末试卷及答案.doc 2018上半年江西教师资格初中地理学科知识与教学能力真题及答案.doc

2018上半年江西教师资格初中地理学科知识与教学能力真题及答案.doc 2012年河北国家公务员申论考试真题及答案-省级.doc

2012年河北国家公务员申论考试真题及答案-省级.doc 2020-2021学年江苏省扬州市江都区邵樊片九年级上学期数学第一次质量检测试题及答案.doc

2020-2021学年江苏省扬州市江都区邵樊片九年级上学期数学第一次质量检测试题及答案.doc 2022下半年黑龙江教师资格证中学综合素质真题及答案.doc

2022下半年黑龙江教师资格证中学综合素质真题及答案.doc