如何运用stata进行文本分析

主讲人:张计宝

官方网站 stata-club.github.io

�

目录

1

2

3

4

分词原理

分词的实现

文本可视化

情感分析及实现

爬虫俱乐部

2

�

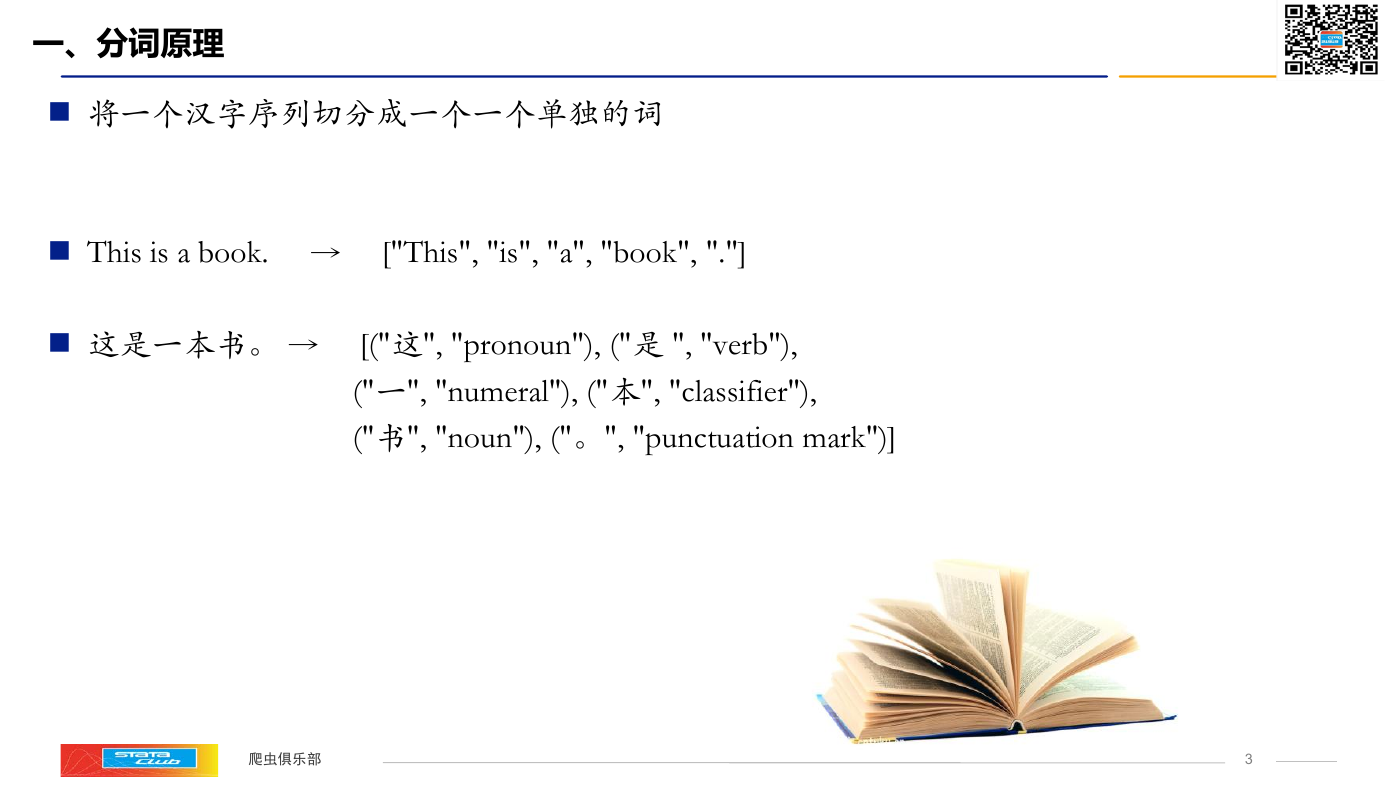

一、分词原理

将一个汉字序列切分成一个一个单独的词

This is a book. → ["This", "is", "a", "book", "."]

这是一本书。 → [("这", "pronoun"), ("是 ", "verb"),

("一", "numeral"), ("本", "classifier"),

("书", "noun"), ("。", "punctuation mark")]

爬虫俱乐部

3

�

为什么要进行中文分词?

词是最小的能够独立运用的语言单位

英文单词之间是以空格作为自然分界符

汉语是以字为基本的书写单位,词语之间没有明显的区分标记,

因此,中文词语分析是中文信息处理的基础与关键。

武汉市长江大桥 → 武汉市 长江大桥

武汉市 长江 大桥

武汉 市长 江大桥

爬虫俱乐部

4

�

中文分词技术的分类

基于字典、词库匹配的分词方法

基于词频度统计的分词方法

基于知识理解的分词方法。

爬虫俱乐部

5

�

基于字典、词库匹配的分词方法

扫描方向的不同:

正向匹配

逆向匹配

长度优先匹配:

最大(最长)匹配

最小(最短)匹配

爬虫俱乐部

6

�

正向最大匹配法

正向最大匹配法 (Maximum Matching Method)

简称为MM法

基本思想:假定分词词典中的最长词有i个汉字字符,则用被处理

文档的当前字串中的前i个字作为匹配字段,查找字典。若字典中

存在这样的一个i字词,则匹配成功,匹配字段被作为一个词切分

出来。如果词典中找不到这样的一个i字词,则匹配失败,将匹配

字段中的最后一个字去掉,对剩下的字串重新进行匹配处理如此

进行下去,直到匹配成功,即切分出一个词或剩余字串的长度为

零为止。这样就完成了一轮匹配,然后取下一个i字字串进行匹配

处理,直到文档被扫描完为止。

分词字典 :爬虫俱乐部 全体成员 祝 Stata 大会 越来 越好

被处理文档:爬虫俱乐部全体成员祝 Stata大会越来越好

爬虫俱乐部

7

�

逆向最大匹配法

逆向最大匹配法(Reverse Maximum Matching Method)

简称为RMM法

基本原理:逆向最大匹配法从被处理文档的末端开始匹配扫描,

每次取最末端的i字字串作为匹配字段,若匹配失败,则去掉匹配

字段最前面的一个字,继续匹配。相应地,它使用的分词词典是

逆序词典,其中的每个词条都将按逆序方式存放。在实际处理时

,先将文档进行倒排处理,生成逆序文档。然后,根据逆序词典

,对逆序文档用正向最大匹配法处理即可。

分词字典 :爬虫俱乐部 全体成员 祝 Stata 大会 越来 越好

被处理文档:爬虫俱乐部全体成员祝 Stata大会越来越好

爬虫俱乐部

8

�

2023年江西萍乡中考道德与法治真题及答案.doc

2023年江西萍乡中考道德与法治真题及答案.doc 2012年重庆南川中考生物真题及答案.doc

2012年重庆南川中考生物真题及答案.doc 2013年江西师范大学地理学综合及文艺理论基础考研真题.doc

2013年江西师范大学地理学综合及文艺理论基础考研真题.doc 2020年四川甘孜小升初语文真题及答案I卷.doc

2020年四川甘孜小升初语文真题及答案I卷.doc 2020年注册岩土工程师专业基础考试真题及答案.doc

2020年注册岩土工程师专业基础考试真题及答案.doc 2023-2024学年福建省厦门市九年级上学期数学月考试题及答案.doc

2023-2024学年福建省厦门市九年级上学期数学月考试题及答案.doc 2021-2022学年辽宁省沈阳市大东区九年级上学期语文期末试题及答案.doc

2021-2022学年辽宁省沈阳市大东区九年级上学期语文期末试题及答案.doc 2022-2023学年北京东城区初三第一学期物理期末试卷及答案.doc

2022-2023学年北京东城区初三第一学期物理期末试卷及答案.doc 2018上半年江西教师资格初中地理学科知识与教学能力真题及答案.doc

2018上半年江西教师资格初中地理学科知识与教学能力真题及答案.doc 2012年河北国家公务员申论考试真题及答案-省级.doc

2012年河北国家公务员申论考试真题及答案-省级.doc 2020-2021学年江苏省扬州市江都区邵樊片九年级上学期数学第一次质量检测试题及答案.doc

2020-2021学年江苏省扬州市江都区邵樊片九年级上学期数学第一次质量检测试题及答案.doc 2022下半年黑龙江教师资格证中学综合素质真题及答案.doc

2022下半年黑龙江教师资格证中学综合素质真题及答案.doc