第 41 卷第 10 期

2020 年 10 月

通 信 学 报

Journal on Communications

Vol.41 No.10

October 2020

基于 DQN 的车载边缘网络任务分发卸载算法

赵海涛 1,2,3,张唐伟 1,2,3,陈跃 1,2,3,赵厚麟 1,2,3,朱洪波 1,2,3

(1. 南京邮电大学教育部泛在网络健康服务系统工程研究中心,江苏 南京 210003;

2. 南京邮电大学江苏省无线通信重点实验室,江苏 南京 210003;

3. 南京邮电大学通信与信息工程学院,江苏 南京 210003)

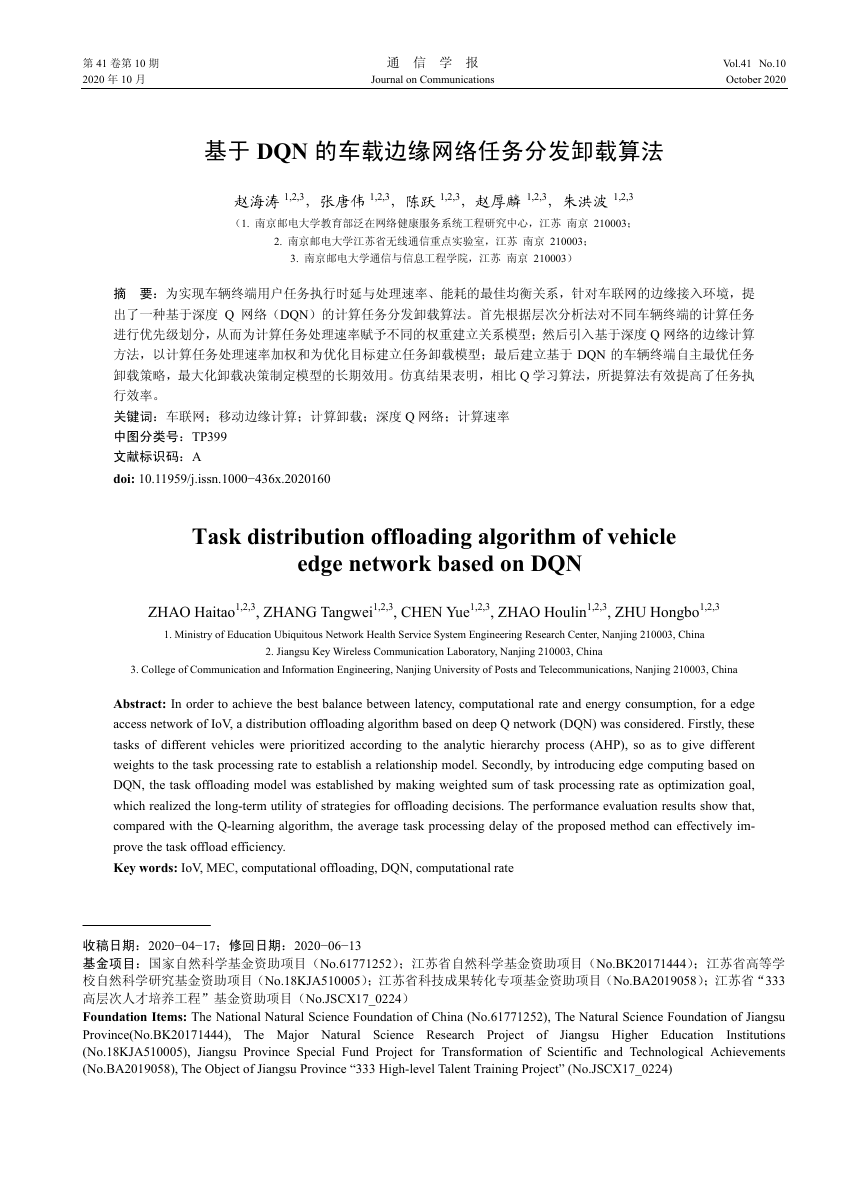

摘 要:为实现车辆终端用户任务执行时延与处理速率、能耗的最佳均衡关系,针对车联网的边缘接入环境,提

出了一种基于深度 Q 网络(DQN)的计算任务分发卸载算法。首先根据层次分析法对不同车辆终端的计算任务

进行优先级划分,从而为计算任务处理速率赋予不同的权重建立关系模型;然后引入基于深度 Q 网络的边缘计算

方法,以计算任务处理速率加权和为优化目标建立任务卸载模型;最后建立基于 DQN 的车辆终端自主最优任务

卸载策略,最大化卸载决策制定模型的长期效用。仿真结果表明,相比 Q 学习算法,所提算法有效提高了任务执

行效率。

关键词:车联网;移动边缘计算;计算卸载;深度 Q 网络;计算速率

中图分类号:TP399

文献标识码:A

doi: 10.11959/j.issn.1000−436x.2020160

Task distribution offloading algorithm of vehicle

edge network based on DQN

ZHAO Haitao1,2,3, ZHANG Tangwei1,2,3, CHEN Yue1,2,3, ZHAO Houlin1,2,3, ZHU Hongbo1,2,3

1. Ministry of Education Ubiquitous Network Health Service System Engineering Research Center, Nanjing 210003, China

2. Jiangsu Key Wireless Communication Laboratory, Nanjing 210003, China

3. College of Communication and Information Engineering, Nanjing University of Posts and Telecommunications, Nanjing 210003, China

Abstract: In order to achieve the best balance between latency, computational rate and energy consumption, for a edge

access network of IoV, a distribution offloading algorithm based on deep Q network (DQN) was considered. Firstly, these

tasks of different vehicles were prioritized according to the analytic hierarchy process (AHP), so as to give different

weights to the task processing rate to establish a relationship model. Secondly, by introducing edge computing based on

DQN, the task offloading model was established by making weighted sum of task processing rate as optimization goal,

which realized the long-term utility of strategies for offloading decisions. The performance evaluation results show that,

compared with the Q-learning algorithm, the average task processing delay of the proposed method can effectively im-

prove the task offload efficiency.

Key words: IoV, MEC, computational offloading, DQN, computational rate

收稿日期:2020−04−17;修回日期:2020−06−13

基金项目:国家自然科学基金资助项目(No.61771252);江苏省自然科学基金资助项目(No.BK20171444);江苏省高等学

校自然科学研究基金资助项目(No.18KJA510005);江苏省科技成果转化专项基金资助项目(No.BA2019058);江苏省“333

高层次人才培养工程”基金资助项目(No.JSCX17_0224)

Foundation Items: The National Natural Science Foundation of China (No.61771252), The Natural Science Foundation of Jiangsu

Province(No.BK20171444), The Major Natural Science Research Project of Jiangsu Higher Education

Institutions

(No.18KJA510005), Jiangsu Province Special Fund Project for Transformation of Scientific and Technological Achievements

(No.BA2019058), The Object of Jiangsu Province “333 High-level Talent Training Project” (No.JSCX17_0224)

�

第 10 期

1 引言

作为 5G 移动通信代表性应用场景之一,车联

网及自动驾驶已经成为热点研究领域,在未来将会

经历前所未有的发展[1]。随着车联网等技术的快速

发展及数据量的日益庞大,大量对计算资源高需求

的车载应用任务随之出现,如自动驾驶、智能识别、

实时路况等[2]。这些车载应用任务不仅需要大量的

存储与计算资源,同时对于任务执行时延的要求非

常严格,给现有车载设备的通信能力、计算能力带

来了很大的挑战[3]。为了解决车辆终端与车载应用

任务之间的矛盾,融合移动边缘计算(MEC, mobile

edge computing)的协同通信技术被引入车联网中[4]。

车 辆 终 端 携带 的 计 算 任务 可 以 卸 载到 路 边 单 元

(RSU, road side unit)配置的 MEC 服务器上,在车

辆终端旁边就能够完成任务的计算及分析,有效缓

解了车辆终端计算、存储资源不足的困境,减小了

计算任务的处理时延与车辆终端能耗[5]。针对任务

迁移和资源调度问题,国内外进行了大量相关研

究。文献[6]对通信与计算融合技术的机遇与挑战做

了大量的介绍,并针对“边缘智能”提出了具体的

实施方案。然而,动态的车联网场景给 MEC 技术的

大规模应用带来了许多问题,车辆终端的高速移动及

通信参数的变化导致计算任务卸载决策复杂化[7]。

目前车联网场景下计算任务卸载决策主要解

决车载应用任务是否需要卸载及卸载多少的问题。

卸载决策的主要优化目标有任务执行时延、能耗及

时延与能耗的权衡等[8]。文献[9]提出了一种面向 5G

的边缘计算多用户卸载方案,将问题转换为多重背

包问题,有效降低了任务执行时延。文献[10-12]基

于各种数值优化算法,提出了一系列计算卸载决策

及 资 源 配 置方 案 。 基 于马 尔 可 夫 决策 过 程 理 论

(MDP, Markov decision process)的强化学习方法,

如 Q 学习算法、深度强化学习(DRL, deep rein-

forcement learning)方法如深度 Q 网络(DQN, deep

Q nework)也被研究人员用来解决卸载问题。文献[13]

构建了马尔可夫决策过程函数,解决了车辆终端由

于 MEC 服务器服务范围不足而导致的服务中断问

题,解决了单纯基于距离进行卸载服务的不足,但

是该方法在卸载过程中没有对服务方的时延、能耗

等成本进行合理的评估。文献[14]提出了一种基于

DQN 的多用户单小区计算卸载与资源分配算法,联

合优化任务执行时延与能耗的加权和,实现了任务

赵海涛等:基于 DQN 的车载边缘网络任务分发卸载算法

·173·

总成本的下降。与其他方法明显不同的是,DQN 可

以在没有任何先验信息的前提下与环境进行交互,从

中学习并调整卸载策略以达到最佳的长期回报[15-16],

这对于动态时变的车联网环境来说尤其重要。

上述方法都没有针对不同车辆终端进行任务

优先级划分,从而不能实现处理程序的优化。同时

这些方法需要实时准确的信道状态消息,算法复杂

度高、迭代步骤长,难以满足时延敏感型的车联网

通信系统。针对以上研究中存在的问题,本文通过

引入移动边缘计算,根据车辆终端任务属性的不同

进行优先级划分,使车辆终端携带的计算任务能够

直接在边缘节点进行处理;在车辆终端,基于 DQN

研究了计算速率最优的任务卸载策略,在信道条件

时变的环境中能够根据过去的经验实现卸载策略

的自我更新,从而有效降低任务执行时延、提高车

联网车辆终端用户的使用体验。

2 系统模型

本文选取车辆终端、RSU 与其连接的 MEC 服

务器所构成的网络通信模型。由于车辆终端的快速

移动,车联网络拓扑架构会产生动态变化。为了满

足时延要求,车辆终端将其携带的计算任务迁移至

RSU 连接的 MEC 服务器中。这产生了 2 个问题,

具体如下。

1) 卸载决策的制定问题。由于计算任务的类

型、信道增益均不相同,如果将计算任务统一卸载

到 MEC 服务器,在信道增益很差的情况下会造成

非常严重的传输时延问题,同时车辆终端计算资源也

得不到充分利用,导致计算资源浪费。因此本文根据

车辆终端信道实时状态制定卸载决策,将部分车辆终

端的计算任务卸载至边缘侧服务器,从而降低计算任

务处理时延、提高计算资源利用率。

2) 计算资源分配问题。系统会根据业务类型分

配优先级,但是相同类型业务由于其属性的不同,

也可能具有不同的优先级需求,因此,必须在计算

资源分配之前根据计算任务属性的不同进行预处

理,否则相同的卸载决策会导致 MEC 服务器不能

合理分配计算资源,影响用户使用体验。

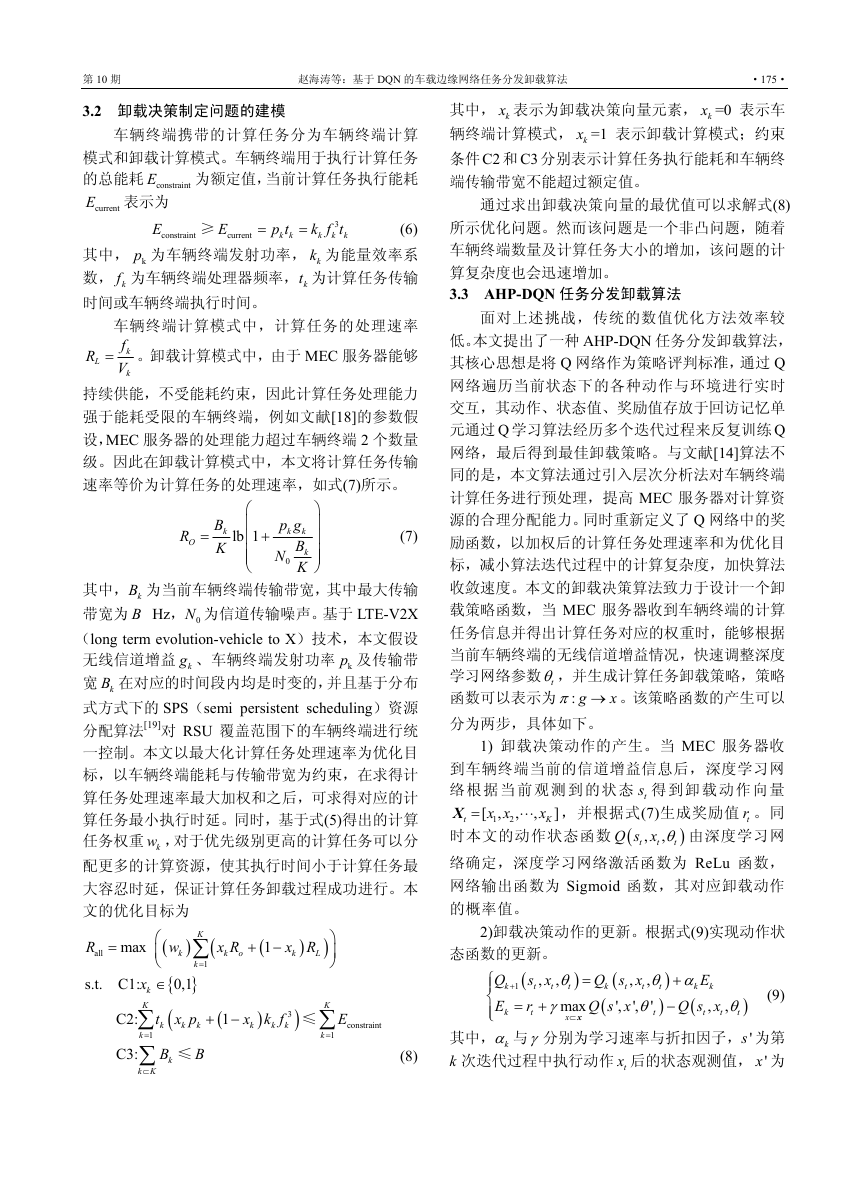

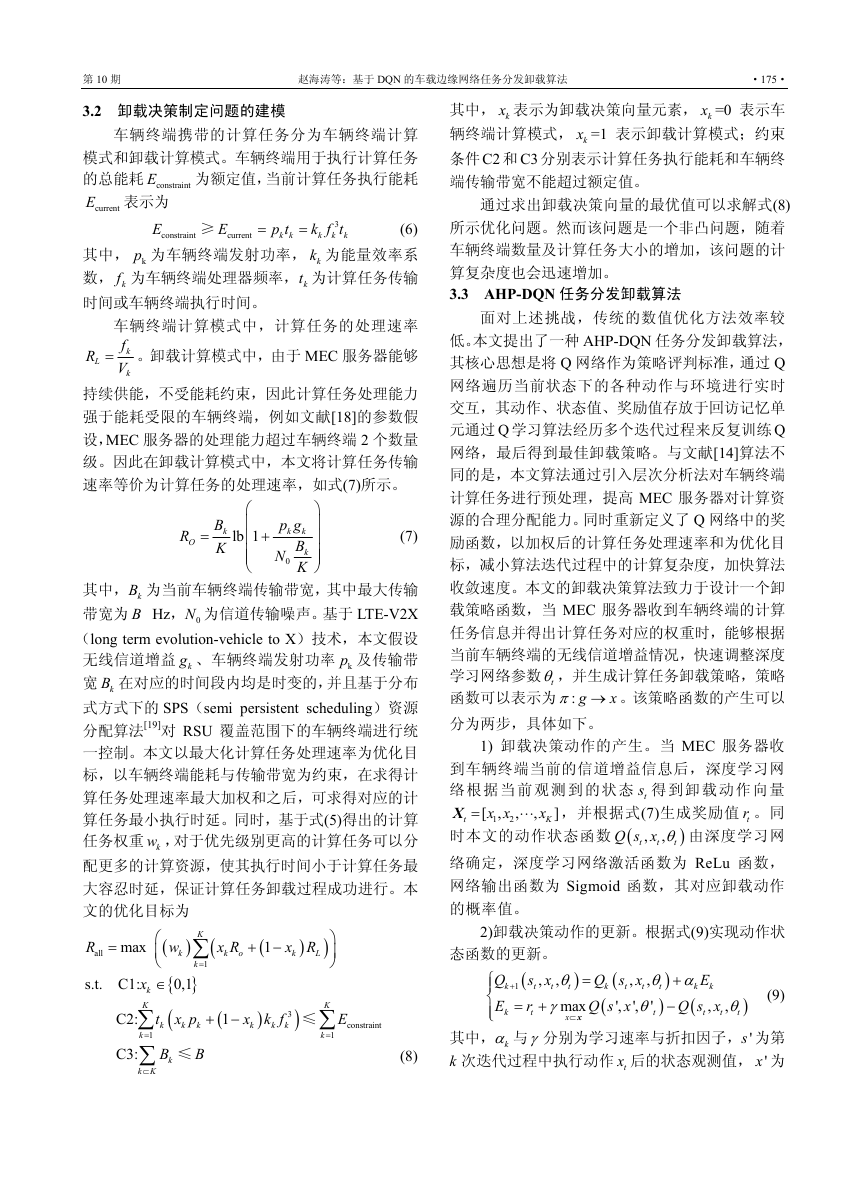

车联网环境下的计算任务卸载模型架构如图 1

所示。在该模型架构中,受限于较弱的计算能力,

部分车辆终端会将自身携带的计算任务通过无线

网络卸载到 RSU 连接的 MEC 服务器进行处理。首

先,车辆终端会将自身携带的计算任务信息如最大

�

·174·

通 信 学 报

第 41 卷

可容忍时延、数据量大小、计算复杂度等上传至

RSU。RSU 通过计算得到计算任务优先级,然后根

据 MEC 服务器的计算任务调度算法决定将哪些车

辆终端的计算任务卸载至服务器。车辆终端随后接

受 RSU 的调度信息,开始卸载或执行计算任务。

假设在计算任务执行过程中,一旦执行时间超过其

最大容忍时延,就判定当前计算任务执行失败,并

将当前计算任务执行时间设置为最大值。

提供更合理的依据,提高车辆终端计算任务的卸载

执行成功率。

当确定计算任务的权重系数时,本文主要考虑

计算任务的计算复杂度、数据总量和最大容忍时延

这 3 个评价因素,其中,计算复杂度的重要程度最

高,数据总量次之,最大容忍时延最低。本文将计

算任务目标层的因素进行两两比较,构造出评价因

素判断矩阵

,以及目标层相对于准则层

的判断矩阵 1

=

(

a

)ij K K

×

。其中,

=A

(

B B

,

2

)ija

3 3

×

B

,

,

3

a

ij

1

⎧

⎪= ⎨

a

ji

⎪

i

1,

⎩

=

n n

,

=

{

1,2,3,

}

,9 ,

i

≠

j

(1)

=

j

根据方根法求得判断矩阵 kB 对应的权重向量

元素,如式(2)所示。

u

i

k

=

K

a

ij

K

Π

j

1

=

K

K

Π∑

K

j

1

=

i

1

=

a

ij

(2)

图 1 计算任务卸载模型架构

k

k

,

,

,

)

=

PΓ

k

V D

(

k

k

本文假设 RSU 覆盖范围内有 K 个车辆终端,

车 辆 终 端 携 带 的 计 算 任 务 表 示 为

C

,其中, kD 表示计算任务的数

据大小,单位为 bit; kV 表示计算任务计算复杂度,

单位为 round/bit; kΓ 表示计算任务最大可容忍时

延,单位为 ms; kP 表示计算任务的优先级,由 RSU

计算后得出。假设计算任务无论是在车辆终端执行

还是卸载到 MEC 服务器执行,以上参数均保持不

变。RSU 覆盖范围内的所有车辆终端的计算任务表

示为

,其中 k K∈ 。

M M M

M

=

{

,

,

,

1

2

}k

3 车载边缘网络计算任务分发卸载方案

3.1 计算任务优先级划分

车辆终端将携带的计算任务卸载到 MEC 服务

器时,由于计算任务类型的不同导致所需要的计算

资源也不同。层次分析法(AHP, analytic hierarrchy

process)指将与决策总是有关的元素分解成目标

层、准则层、方案层等层次,并在此基础之上进行

定性和定量分析的决策方法,是一个多标准决策/

多属性决策模型,非常适用于权重分配的计算任务

调度应用场景[17]。本文通过 AHP 算法可以给容忍

时延小、计算复杂度高的计算任务分配相对高一些

的权重系数,为 MEC 服务器的计算资源调度过程

其中,k 表示第 k 个终端车辆,i 表示第 k 个终端车辆

所携带任务的第 i 个评价因素,可以得到所有车辆

终端计算任务的权重矢量矩阵为

u

3

1

u

3

2

u

3

K

u

2

1

u

2

2

u

2

K

u

1

1

u

1

2

u

1

K

U

=

⎡

⎢

⎢

⎢

⎢

⎢

⎣

⎤

⎥

⎥

⎥

⎥

⎥

⎦

(3)

根据同样的方法求得评价因素判断矩阵 A 的

权重向量

=Δ

1

[

3

Δ Δ Δ

,

,

2

]

,其权重元素为

i

Δ

=

3

3

Π

j

1

=

a

ij

3

3

Π∑

3

j

1

=

i

1

=

a

ij

(4)

权重元素通过一致性检验后,得到所有计算任

务的权重向量 W,其中每一个元素分别代表对应车

辆终端计算任务的权重,如式(5)所示。

⎛

⎜

⎜

⎜

⎜

= ⎜

⎜

⎜

⎜

⎜

⎝

W UΔ

=

3

∑

i

1

=

3

∑

i

1

=

3

∑

i

1

=

U

i

1

1

Δ

U

i

2

Δ

2

U

i

Δ

i

K

⎞

⎟

⎟

⎟

⎟

⎟

⎟

⎟

⎟

⎟

⎠

(5)

�

第 10 期

赵海涛等:基于 DQN 的车载边缘网络任务分发卸载算法

·175·

3.2 卸载决策制定问题的建模

E

车辆终端携带的计算任务分为车辆终端计算

模式和卸载计算模式。车辆终端用于执行计算任务

为额定值,当前计算任务执行能耗

的总能耗 constraint

E 表示为

current

(6)

其中, kp 为车辆终端发射功率, kk 为能量效率系

数, kf 为车辆终端处理器频率, kt 为计算任务传输

时间或车辆终端执行时间。

E

constraint

E

current

k f t

3

k

k

p t

k k

≥

=

=

k

车辆终端计算模式中,计算任务的处理速率

f

k

V

k

= 。卸载计算模式中,由于 MEC 服务器能够

R

L

持续供能,不受能耗约束,因此计算任务处理能力

强于能耗受限的车辆终端,例如文献[18]的参数假

设,MEC 服务器的处理能力超过车辆终端 2 个数量

级。因此在卸载计算模式中,本文将计算任务传输

速率等价为计算任务的处理速率,如式(7)所示。

R

O

=

B

k

K

⎛

⎜

lb 1

+⎜

⎜

⎜

⎝

p g

k

k

B

N

k

K

0

⎞

⎟

⎟

⎟

⎟

⎠

(7)

其中, kB 为当前车辆终端传输带宽,其中最大传输

带宽为 B Hz, 0N 为信道传输噪声。基于 LTE-V2X

(long term evolution-vehicle to X)技术,本文假设

无线信道增益 kg 、车辆终端发射功率 kp 及传输带

宽 kB 在对应的时间段内均是时变的,并且基于分布

式方式下的 SPS(semi persistent scheduling)资源

分配算法[19]对 RSU 覆盖范围下的车辆终端进行统

一控制。本文以最大化计算任务处理速率为优化目

标,以车辆终端能耗与传输带宽为约束,在求得计

算任务处理速率最大加权和之后,可求得对应的计

算任务最小执行时延。同时,基于式(5)得出的计算

任务权重 kw ,对于优先级别更高的计算任务可以分

配更多的计算资源,使其执行时间小于计算任务最

大容忍时延,保证计算任务卸载过程成功进行。本

文的优化目标为

其中, kx 表示为卸载决策向量元素, kx =0 表示车

辆终端计算模式, kx =1 表示卸载计算模式;约束

条件 C2 和 C3 分别表示计算任务执行能耗和车辆终

端传输带宽不能超过额定值。

通过求出卸载决策向量的最优值可以求解式(8)

所示优化问题。然而该问题是一个非凸问题,随着

车辆终端数量及计算任务大小的增加,该问题的计

算复杂度也会迅速增加。

3.3 AHP-DQN 任务分发卸载算法

面对上述挑战,传统的数值优化方法效率较

低。本文提出了一种 AHP-DQN 任务分发卸载算法,

其核心思想是将 Q 网络作为策略评判标准,通过 Q

网络遍历当前状态下的各种动作与环境进行实时

交互,其动作、状态值、奖励值存放于回访记忆单

元通过 Q 学习算法经历多个迭代过程来反复训练 Q

网络,最后得到最佳卸载策略。与文献[14]算法不

同的是,本文算法通过引入层次分析法对车辆终端

计算任务进行预处理,提高 MEC 服务器对计算资

源的合理分配能力。同时重新定义了 Q 网络中的奖

励函数,以加权后的计算任务处理速率和为优化目

标,减小算法迭代过程中的计算复杂度,加快算法

收敛速度。本文的卸载决策算法致力于设计一个卸

载策略函数,当 MEC 服务器收到车辆终端的计算

任务信息并得出计算任务对应的权重时,能够根据

当前车辆终端的无线信道增益情况,快速调整深度

学习网络参数 tθ,并生成计算任务卸载策略,策略

函数可以表示为 : g

π → 。该策略函数的产生可以

分为两步,具体如下。

x

t

,

,

[

x x

,

1

2

1) 卸载决策动作的产生。当 MEC 服务器收

到车辆终端当前的信道增益信息后,深度学习网

络 根 据 当 前 观 测 到 的 状 态 ts 得 到 卸 载 动 作 向 量

=X

,并根据式(7)生成奖励值 tr 。同

时本文的动作状态函数 (

Q s x θ 由深度学习网

络确定,深度学习网络激活函数为 ReLu 函数,

网络输出函数为 Sigmoid 函数,其对应卸载动作

的概率值。

x

K

)

]

,

,

t

t

t

R

all

=

max

C2:

x

s.t. C1:

k

K

∑

t

∑

C3:

1

=

k

k K

⊂

K

⎛

⎜

⎝

∈

k

1

=

)

w

k

∑

(

}

{

0,1

(

B

k

x p

k

k

≤

B

k

(

x R

k

o

(

1

+ −

)

x R

k

L

)

⎞

⎟

⎠

(

1

+ −

x

k

)

k f

k

3

k

)

≤

K

∑

k

1

=

2)卸载决策动作的更新。根据式(9)实现动作状

态函数的更新。

(

(

)

Q s x

s x

,

,

,

,

=

θ α

θ

t

t

t

t

t

k

1

+

(

(

)

Q s x

r

max

'

',

',

= +

θ

γ

t

t

x

x

⊂

)

E

+

k

Q s x

,

−

t

Q

⎧

⎪

k

⎨

E

⎪⎩

k

k

t

t

(9)

,

θ

t

)

其中, kα 与γ分别为学习速率与折扣因子, 's 为第

k 次迭代过程中执行动作 tx 后的状态观测值, 'x 为

E

constraint

(8)

�

·176·

通 信 学 报

第 41 卷

状态 s′ 下奖励值最大的动作, kE 为迭代过程中的累

积奖励值。对于第 k 次迭代过程而言,通过最小化

式(10)目标函数,可以更新网络参数θ,从而实现

卸载决策动作的更新。

(

t

t

)

(

t

)

−

r

t

+

=

E

(

γ

)*

,

θ

t

min

min

',

'

θ

t

max

x

x

⊂

Q s x

',

Q s x

,

t

)

(10)

重复上述 2 个步骤得到 t 时刻最佳状态对后,

将该状态−动作对(

g x 放入经验池,作为新的训

,t

练样本。当经验池容量足够后,新生成的状态−动

作对会代替旧的数据样本。深度学习网络反复学习

最佳状态对(

g x ,并随着时间的推移生成更好的

,t

卸载决策输出。在存储空间有限的约束下,DNN 仅

从最新生成的数据样本中进行学习,这种闭环强化

学习机制会不断改善其卸载策略,直到收敛。本文

算法伪代码如算法 1 所示。

)*

算法 1 AHP-DQN 计算任务分发卸载算法

输入 计算任务的计算复杂度 kV 、数据总量 kD

及最大容忍时延 kΓ 。根据式(1)~式(5)得到每个计算

任务的优先级 kP ,即计算任务的计算资源分配权重

输 出 车 辆 终 端 携 带 任 务 的 最 终 卸 载 决 策

x x

[

,

1

2

1) 初始化经验池存储空间容量并且用随机权

]K

=X

x

,

,

重θ初始化动作−价值函数 (

Q s x

,t

t

θ

)

2) for each episode

3) 初始化状态 1s 及预处理序列 1

4) for each iteration

5) 以ε的概率选择随机动作 tx ,否则选

)sφ φ=

1(

Q s

择潜在回报最大的动作 max ( (

t

xφ

;

),

)

θ

x

t

=

x

6) 执行动作 tx ,将步骤 1)中求出的权

重值代入式(8)后得到奖励值 tr 与 1ts +

,处理 1

)1

s

s x

,

)

7) 令 1

+ =

t

t

t

1

+

8) 将(

x rφ

φ+ 存放于经验池中

,

,

,

t

t

t

9) 从经验池中对向量进行均匀随机抽

(

φ φ+

t

ts

=

t

4 仿真结果与分析

本节通过 Python 编程语言对本文算法进行仿真以

评估算法性能。本文仿真场景为 IEEE 802.11p 标准规

定下的车联网场景,仿真实验参数根据文献[20]及移动

边缘计算白皮书相关约束进行假设。在车联网场景下,

每个 RSU 的覆盖范围为 1 000 m,车辆终端速度假设

为 40 km/h,每个车辆终端计算能力为 108 round/s,车

载车辆终端计算功率为 3 W,发射功率为 0.3 W。携

带的计算任务数据(以 kbit 为单位)服从[300, 500]

的均匀分布,计算任务复杂度(以兆轮为单位)服

从[9 000,11 000]的均匀分布。下面将本文算法分别

与全部车辆终端计算、Q 学习算法、DQN[14]进行

比较。

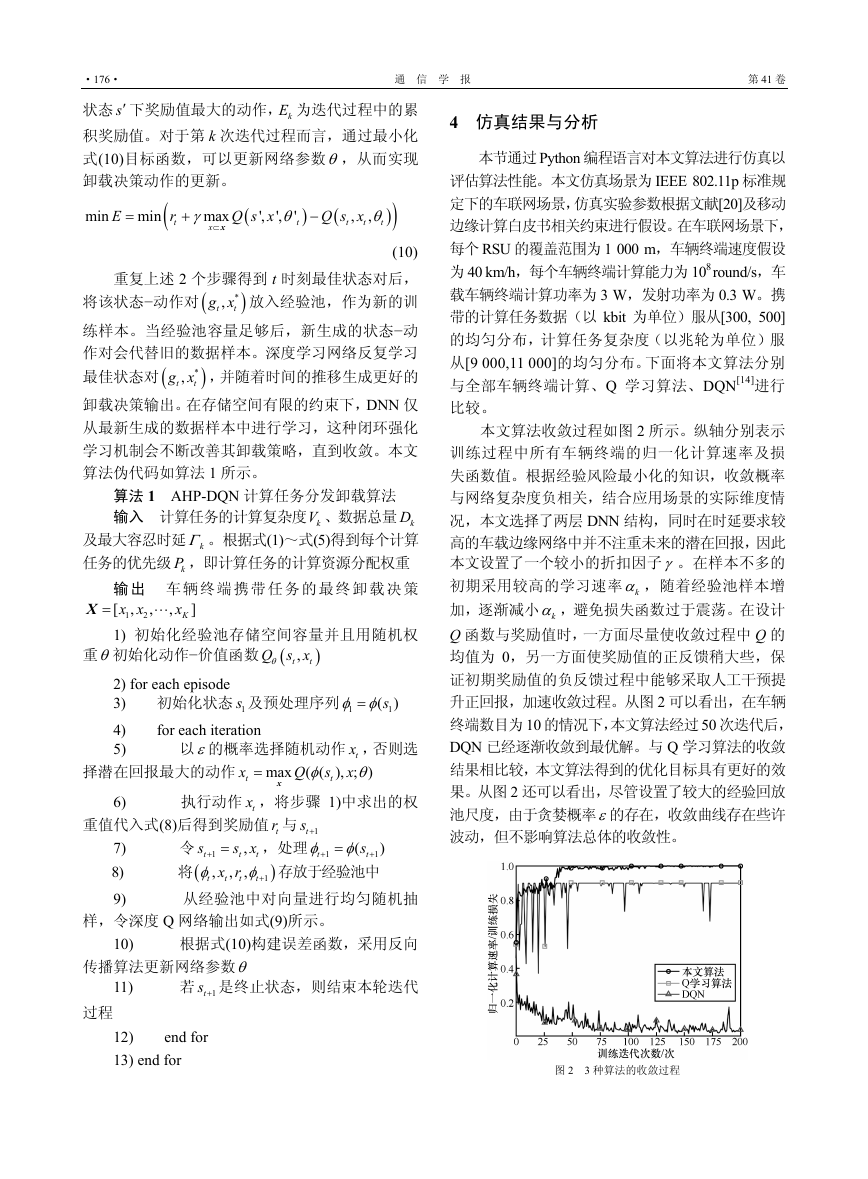

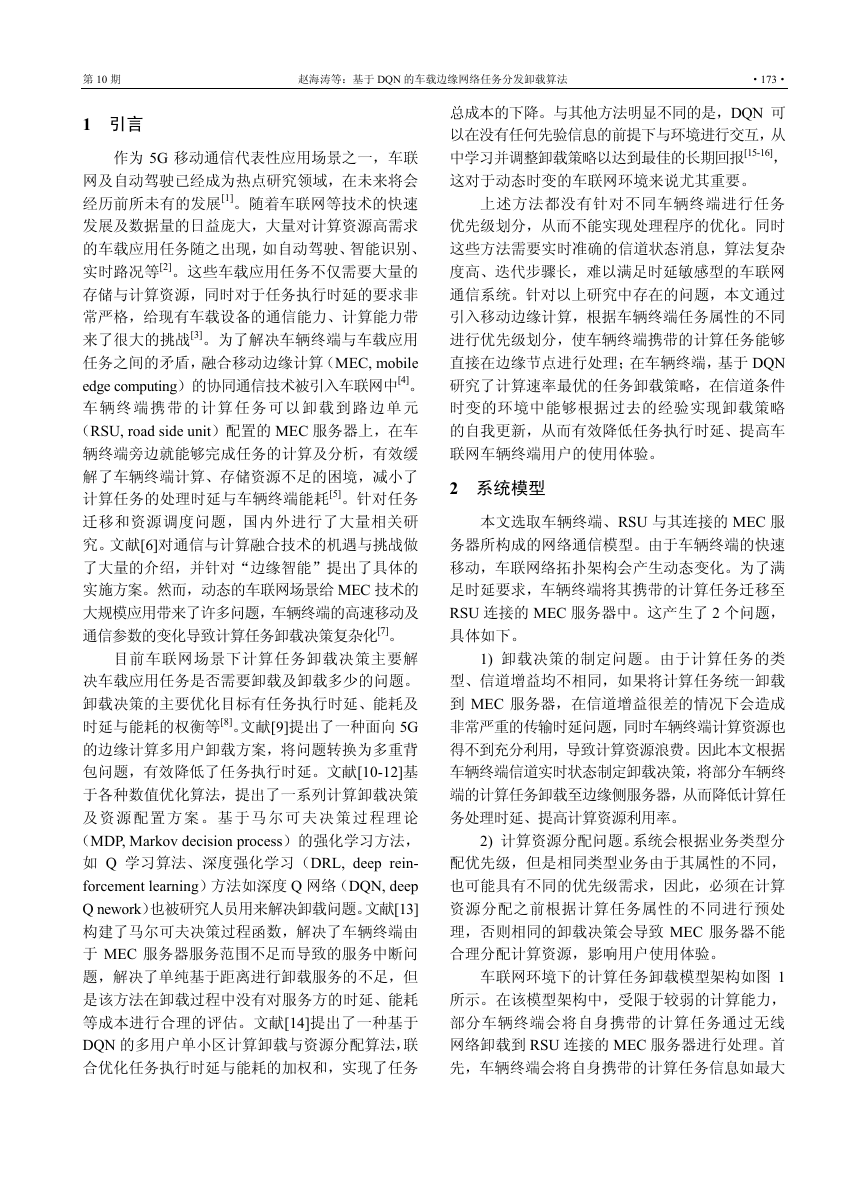

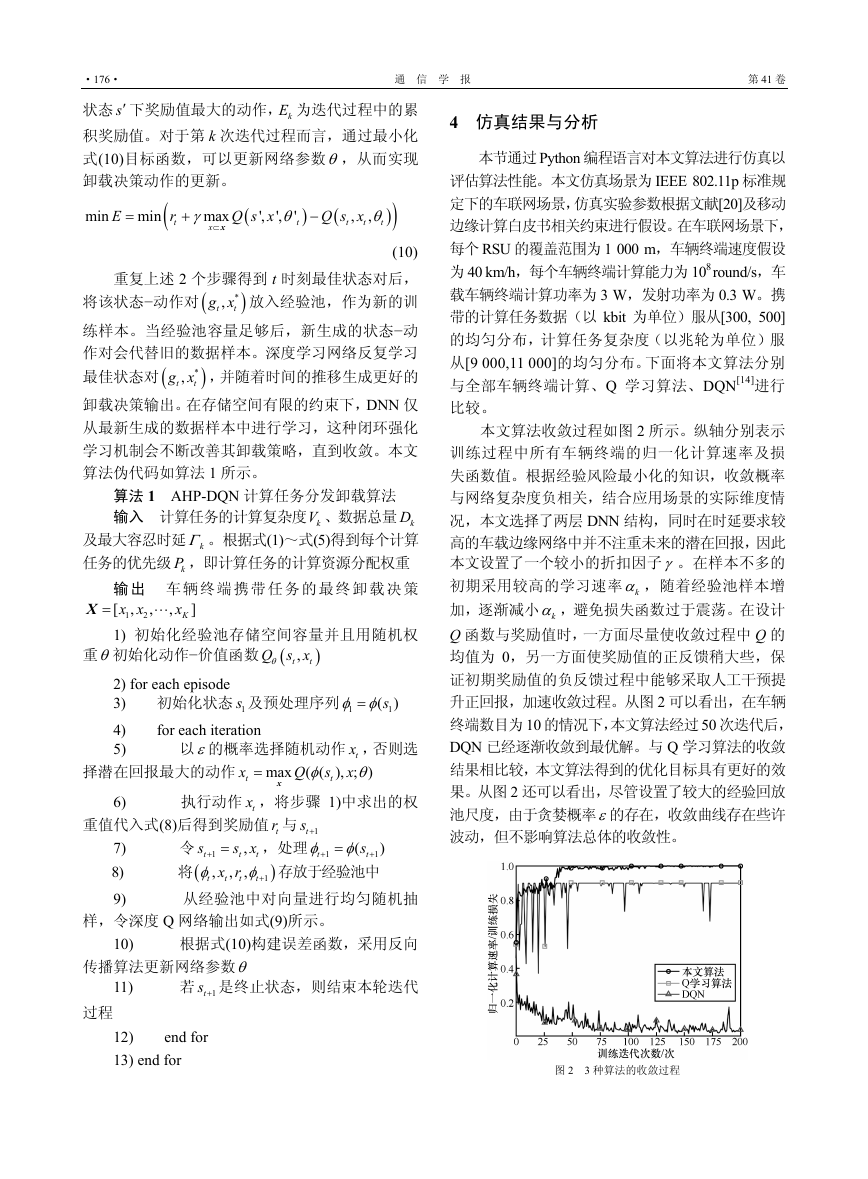

本文算法收敛过程如图 2 所示。纵轴分别表示

训练过程中所有车辆终端的归一化计算速率及损

失函数值。根据经验风险最小化的知识,收敛概率

与网络复杂度负相关,结合应用场景的实际维度情

况,本文选择了两层 DNN 结构,同时在时延要求较

高的车载边缘网络中并不注重未来的潜在回报,因此

本文设置了一个较小的折扣因子γ。在样本不多的

初期采用较高的学习速率 kα ,随着经验池样本增

加,逐渐减小 kα ,避免损失函数过于震荡。在设计

Q 函数与奖励值时,一方面尽量使收敛过程中 Q 的

均值为 0,另一方面使奖励值的正反馈稍大些,保

证初期奖励值的负反馈过程中能够采取人工干预提

升正回报,加速收敛过程。从图 2 可以看出,在车辆

终端数目为 10 的情况下,本文算法经过 50 次迭代后,

DQN 已经逐渐收敛到最优解。与 Q 学习算法的收敛

结果相比较,本文算法得到的优化目标具有更好的效

果。从图 2 还可以看出,尽管设置了较大的经验回放

池尺度,由于贪婪概率ε的存在,收敛曲线存在些许

波动,但不影响算法总体的收敛性。

样,令深度 Q 网络输出如式(9)所示。

10) 根据式(10)构建误差函数,采用反向

传播算法更新网络参数θ

11) 若 1ts + 是终止状态,则结束本轮迭代

过程

12) end for

13) end for

图 2 3 种算法的收敛过程

�

第 10 期

赵海涛等:基于 DQN 的车载边缘网络任务分发卸载算法

·177·

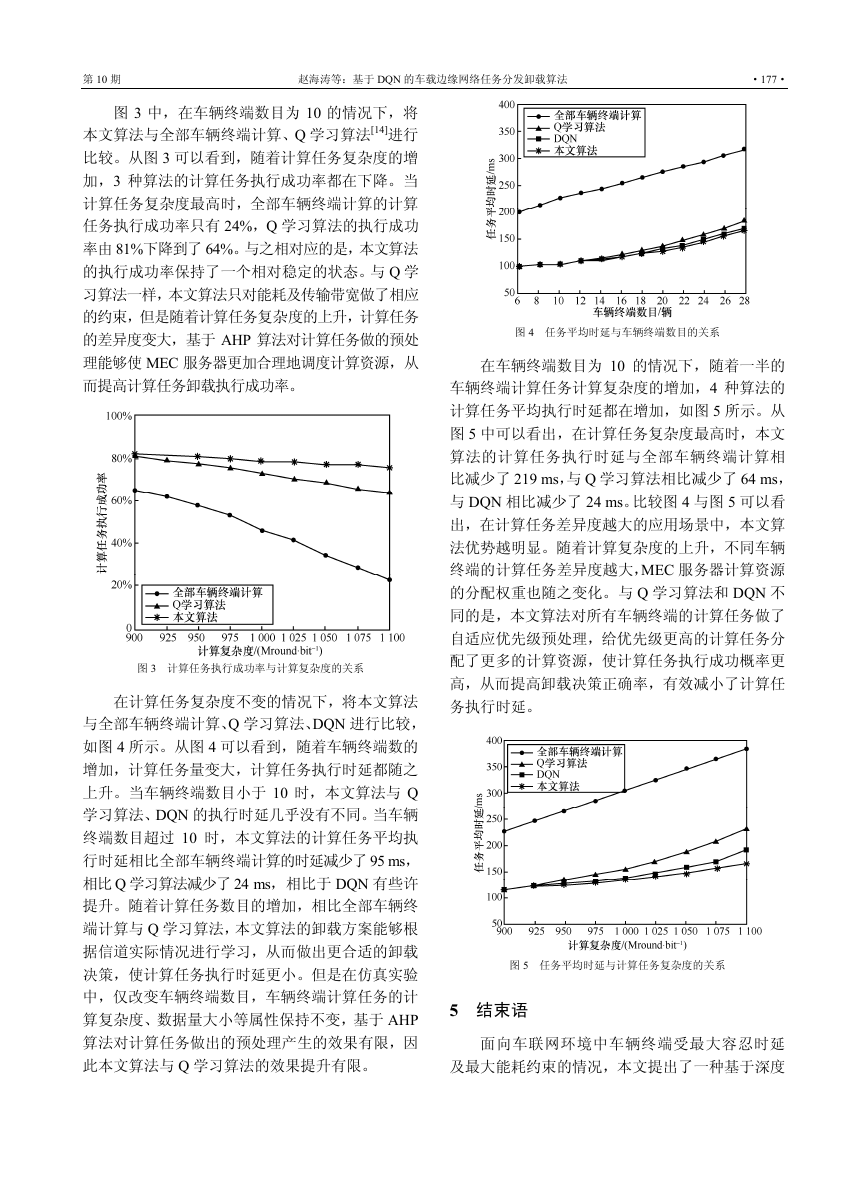

图 3 中,在车辆终端数目为 10 的情况下,将

本文算法与全部车辆终端计算、Q 学习算法[14]进行

比较。从图 3 可以看到,随着计算任务复杂度的增

加,3 种算法的计算任务执行成功率都在下降。当

计算任务复杂度最高时,全部车辆终端计算的计算

任务执行成功率只有 24%,Q 学习算法的执行成功

率由 81%下降到了 64%。与之相对应的是,本文算法

的执行成功率保持了一个相对稳定的状态。与 Q 学

习算法一样,本文算法只对能耗及传输带宽做了相应

的约束,但是随着计算任务复杂度的上升,计算任务

的差异度变大,基于 AHP 算法对计算任务做的预处

理能够使 MEC 服务器更加合理地调度计算资源,从

而提高计算任务卸载执行成功率。

图 3 计算任务执行成功率与计算复杂度的关系

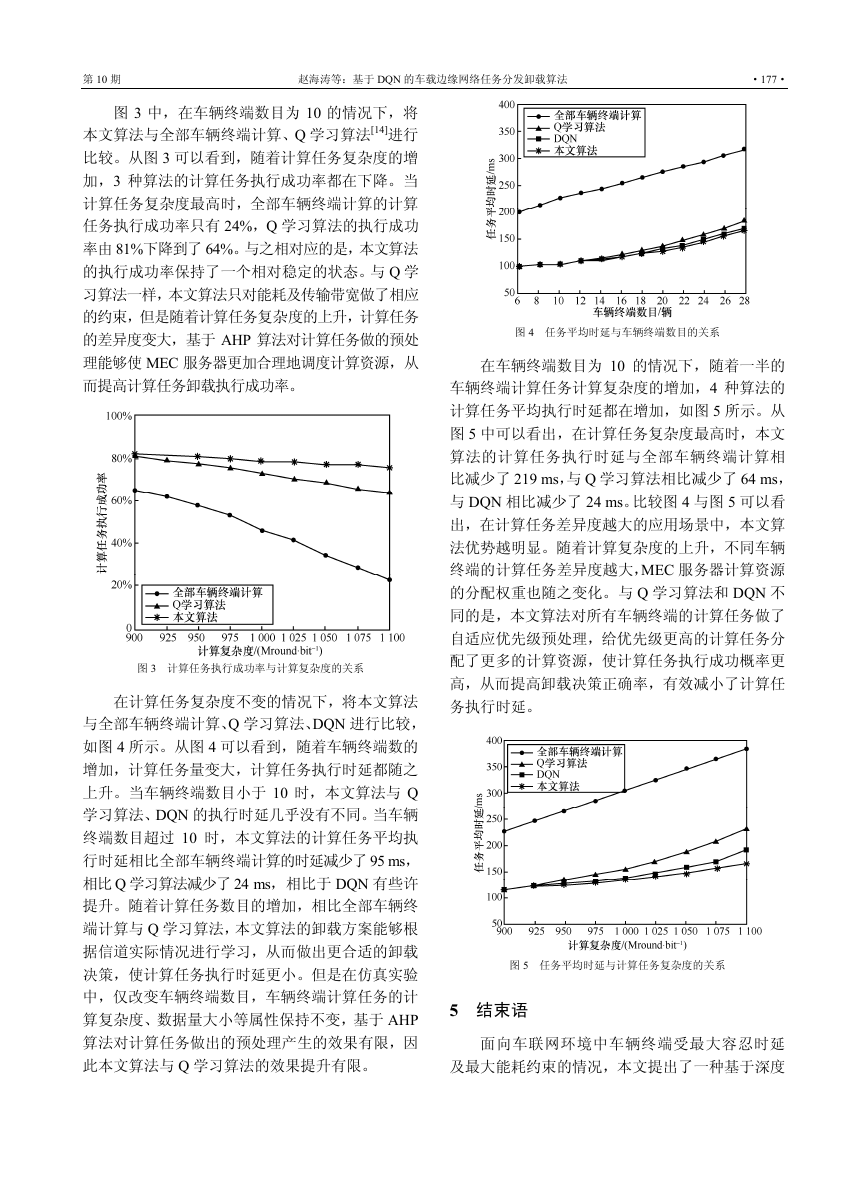

在计算任务复杂度不变的情况下,将本文算法

与全部车辆终端计算、Q 学习算法、DQN 进行比较,

如图 4 所示。从图 4 可以看到,随着车辆终端数的

增加,计算任务量变大,计算任务执行时延都随之

上升。当车辆终端数目小于 10 时,本文算法与 Q

学习算法、DQN 的执行时延几乎没有不同。当车辆

终端数目超过 10 时,本文算法的计算任务平均执

行时延相比全部车辆终端计算的时延减少了 95 ms,

相比 Q 学习算法减少了 24 ms,相比于 DQN 有些许

提升。随着计算任务数目的增加,相比全部车辆终

端计算与 Q 学习算法,本文算法的卸载方案能够根

据信道实际情况进行学习,从而做出更合适的卸载

决策,使计算任务执行时延更小。但是在仿真实验

中,仅改变车辆终端数目,车辆终端计算任务的计

算复杂度、数据量大小等属性保持不变,基于 AHP

算法对计算任务做出的预处理产生的效果有限,因

此本文算法与 Q 学习算法的效果提升有限。

图 4 任务平均时延与车辆终端数目的关系

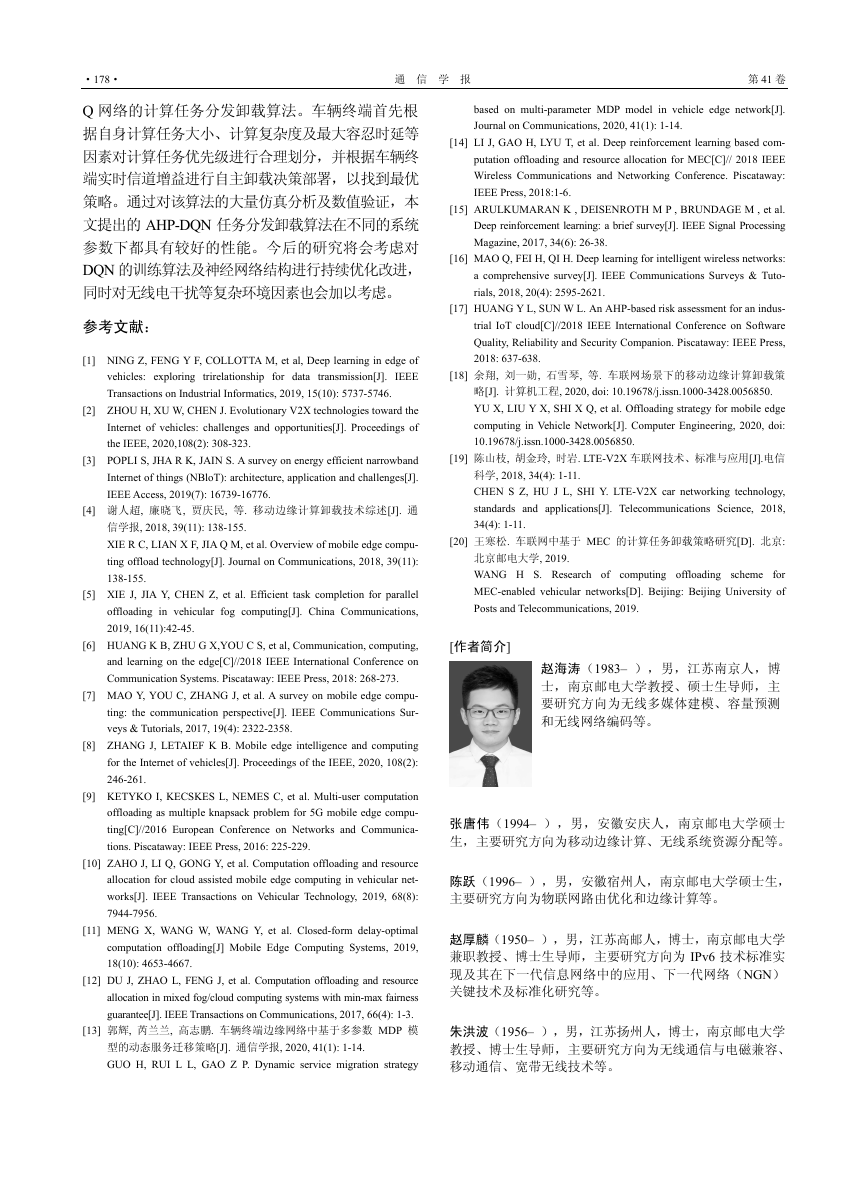

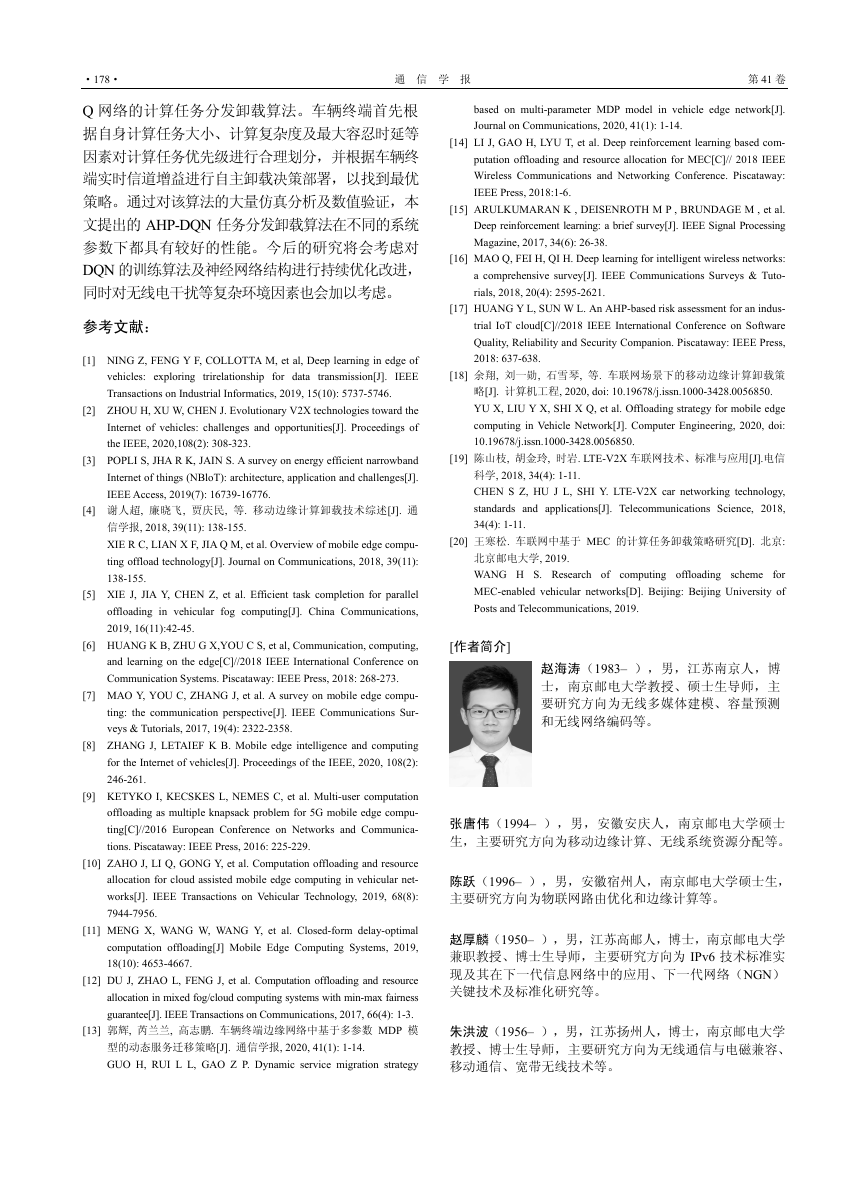

在车辆终端数目为 10 的情况下,随着一半的

车辆终端计算任务计算复杂度的增加,4 种算法的

计算任务平均执行时延都在增加,如图 5 所示。从

图 5 中可以看出,在计算任务复杂度最高时,本文

算法的计算任务执行时延与全部车辆终端计算相

比减少了 219 ms,与 Q 学习算法相比减少了 64 ms,

与 DQN 相比减少了 24 ms。比较图 4 与图 5 可以看

出,在计算任务差异度越大的应用场景中,本文算

法优势越明显。随着计算复杂度的上升,不同车辆

终端的计算任务差异度越大,MEC 服务器计算资源

的分配权重也随之变化。与 Q 学习算法和 DQN 不

同的是,本文算法对所有车辆终端的计算任务做了

自适应优先级预处理,给优先级更高的计算任务分

配了更多的计算资源,使计算任务执行成功概率更

高,从而提高卸载决策正确率,有效减小了计算任

务执行时延。

图 5 任务平均时延与计算任务复杂度的关系

5 结束语

面向车联网环境中车辆终端受最大容忍时延

及最大能耗约束的情况,本文提出了一种基于深度

�

·178·

通 信 学 报

第 41 卷

Q 网络的计算任务分发卸载算法。车辆终端首先根

据自身计算任务大小、计算复杂度及最大容忍时延等

因素对计算任务优先级进行合理划分,并根据车辆终

端实时信道增益进行自主卸载决策部署,以找到最优

策略。通过对该算法的大量仿真分析及数值验证,本

文提出的 AHP-DQN 任务分发卸载算法在不同的系统

参数下都具有较好的性能。今后的研究将会考虑对

DQN 的训练算法及神经网络结构进行持续优化改进,

同时对无线电干扰等复杂环境因素也会加以考虑。

参考文献:

[1] NING Z, FENG Y F, COLLOTTA M, et al, Deep learning in edge of

vehicles: exploring trirelationship for data transmission[J]. IEEE

Transactions on Industrial Informatics, 2019, 15(10): 5737-5746.

[2] ZHOU H, XU W, CHEN J. Evolutionary V2X technologies toward the

Internet of vehicles: challenges and opportunities[J]. Proceedings of

the IEEE, 2020,108(2): 308-323.

[3] POPLI S, JHA R K, JAIN S. A survey on energy efficient narrowband

Internet of things (NBloT): architecture, application and challenges[J].

IEEE Access, 2019(7): 16739-16776.

[4] 谢人超, 廉晓飞, 贾庆民, 等. 移动边缘计算卸载技术综述[J]. 通

信学报, 2018, 39(11): 138-155.

XIE R C, LIAN X F, JIA Q M, et al. Overview of mobile edge compu-

ting offload technology[J]. Journal on Communications, 2018, 39(11):

138-155.

[5] XIE J, JIA Y, CHEN Z, et al. Efficient task completion for parallel

offloading in vehicular fog computing[J]. China Communications,

2019, 16(11):42-45.

[6] HUANG K B, ZHU G X,YOU C S, et al, Communication, computing,

and learning on the edge[C]//2018 IEEE International Conference on

Communication Systems. Piscataway: IEEE Press, 2018: 268-273.

[7] MAO Y, YOU C, ZHANG J, et al. A survey on mobile edge compu-

ting: the communication perspective[J]. IEEE Communications Sur-

veys & Tutorials, 2017, 19(4): 2322-2358.

[8] ZHANG J, LETAIEF K B. Mobile edge intelligence and computing

for the Internet of vehicles[J]. Proceedings of the IEEE, 2020, 108(2):

246-261.

[9] KETYKO I, KECSKES L, NEMES C, et al. Multi-user computation

offloading as multiple knapsack problem for 5G mobile edge compu-

ting[C]//2016 European Conference on Networks and Communica-

tions. Piscataway: IEEE Press, 2016: 225-229.

[10] ZAHO J, LI Q, GONG Y, et al. Computation offloading and resource

allocation for cloud assisted mobile edge computing in vehicular net-

works[J]. IEEE Transactions on Vehicular Technology, 2019, 68(8):

7944-7956.

[11] MENG X, WANG W, WANG Y, et al. Closed-form delay-optimal

computation offloading[J] Mobile Edge Computing Systems, 2019,

18(10): 4653-4667.

[12] DU J, ZHAO L, FENG J, et al. Computation offloading and resource

allocation in mixed fog/cloud computing systems with min-max fairness

guarantee[J]. IEEE Transactions on Communications, 2017, 66(4): 1-3.

[13] 郭辉, 芮兰兰, 高志鹏. 车辆终端边缘网络中基于多参数 MDP 模

型的动态服务迁移策略[J]. 通信学报, 2020, 41(1): 1-14.

GUO H, RUI L L, GAO Z P. Dynamic service migration strategy

based on multi-parameter MDP model in vehicle edge network[J].

Journal on Communications, 2020, 41(1): 1-14.

[14] LI J, GAO H, LYU T, et al. Deep reinforcement learning based com-

putation offloading and resource allocation for MEC[C]// 2018 IEEE

Wireless Communications and Networking Conference. Piscataway:

IEEE Press, 2018:1-6.

[15] ARULKUMARAN K , DEISENROTH M P , BRUNDAGE M , et al.

Deep reinforcement learning: a brief survey[J]. IEEE Signal Processing

Magazine, 2017, 34(6): 26-38.

[16] MAO Q, FEI H, QI H. Deep learning for intelligent wireless networks:

a comprehensive survey[J]. IEEE Communications Surveys & Tuto-

rials, 2018, 20(4): 2595-2621.

[17] HUANG Y L, SUN W L. An AHP-based risk assessment for an indus-

trial IoT cloud[C]//2018 IEEE International Conference on Software

Quality, Reliability and Security Companion. Piscataway: IEEE Press,

2018: 637-638.

[18] 余翔, 刘一勋, 石雪琴, 等. 车联网场景下的移动边缘计算卸载策

略[J]. 计算机工程, 2020, doi: 10.19678/j.issn.1000-3428.0056850.

YU X, LIU Y X, SHI X Q, et al. Offloading strategy for mobile edge

computing in Vehicle Network[J]. Computer Engineering, 2020, doi:

10.19678/j.issn.1000-3428.0056850.

[19] 陈山枝, 胡金玲, 时岩. LTE-V2X 车联网技术、标准与应用[J].电信

科学, 2018, 34(4): 1-11.

CHEN S Z, HU J L, SHI Y. LTE-V2X car networking technology,

standards and applications[J]. Telecommunications Science, 2018,

34(4): 1-11.

[20] 王寒松. 车联网中基于 MEC 的计算任务卸载策略研究[D]. 北京:

北京邮电大学, 2019.

WANG H S. Research of computing offloading scheme for

MEC-enabled vehicular networks[D]. Beijing: Beijing University of

Posts and Telecommunications, 2019.

[作者简介]

赵海涛(1983– ),男,江苏南京人,博

士,南京邮电大学教授、硕士生导师,主

要研究方向为无线多媒体建模、容量预测

和无线网络编码等。

张唐伟(1994– ),男,安徽安庆人,南京邮电大学硕士

生,主要研究方向为移动边缘计算、无线系统资源分配等。

陈跃(1996– ),男,安徽宿州人,南京邮电大学硕士生,

主要研究方向为物联网路由优化和边缘计算等。

赵厚麟(1950– ),男,江苏高邮人,博士,南京邮电大学

兼职教授、博士生导师,主要研究方向为 IPv6 技术标准实

现及其在下一代信息网络中的应用、下一代网络(NGN)

关键技术及标准化研究等。

朱洪波(1956– ),男,江苏扬州人,博士,南京邮电大学

教授、博士生导师,主要研究方向为无线通信与电磁兼容、

移动通信、宽带无线技术等。

�

2023年江西萍乡中考道德与法治真题及答案.doc

2023年江西萍乡中考道德与法治真题及答案.doc 2012年重庆南川中考生物真题及答案.doc

2012年重庆南川中考生物真题及答案.doc 2013年江西师范大学地理学综合及文艺理论基础考研真题.doc

2013年江西师范大学地理学综合及文艺理论基础考研真题.doc 2020年四川甘孜小升初语文真题及答案I卷.doc

2020年四川甘孜小升初语文真题及答案I卷.doc 2020年注册岩土工程师专业基础考试真题及答案.doc

2020年注册岩土工程师专业基础考试真题及答案.doc 2023-2024学年福建省厦门市九年级上学期数学月考试题及答案.doc

2023-2024学年福建省厦门市九年级上学期数学月考试题及答案.doc 2021-2022学年辽宁省沈阳市大东区九年级上学期语文期末试题及答案.doc

2021-2022学年辽宁省沈阳市大东区九年级上学期语文期末试题及答案.doc 2022-2023学年北京东城区初三第一学期物理期末试卷及答案.doc

2022-2023学年北京东城区初三第一学期物理期末试卷及答案.doc 2018上半年江西教师资格初中地理学科知识与教学能力真题及答案.doc

2018上半年江西教师资格初中地理学科知识与教学能力真题及答案.doc 2012年河北国家公务员申论考试真题及答案-省级.doc

2012年河北国家公务员申论考试真题及答案-省级.doc 2020-2021学年江苏省扬州市江都区邵樊片九年级上学期数学第一次质量检测试题及答案.doc

2020-2021学年江苏省扬州市江都区邵樊片九年级上学期数学第一次质量检测试题及答案.doc 2022下半年黑龙江教师资格证中学综合素质真题及答案.doc

2022下半年黑龙江教师资格证中学综合素质真题及答案.doc