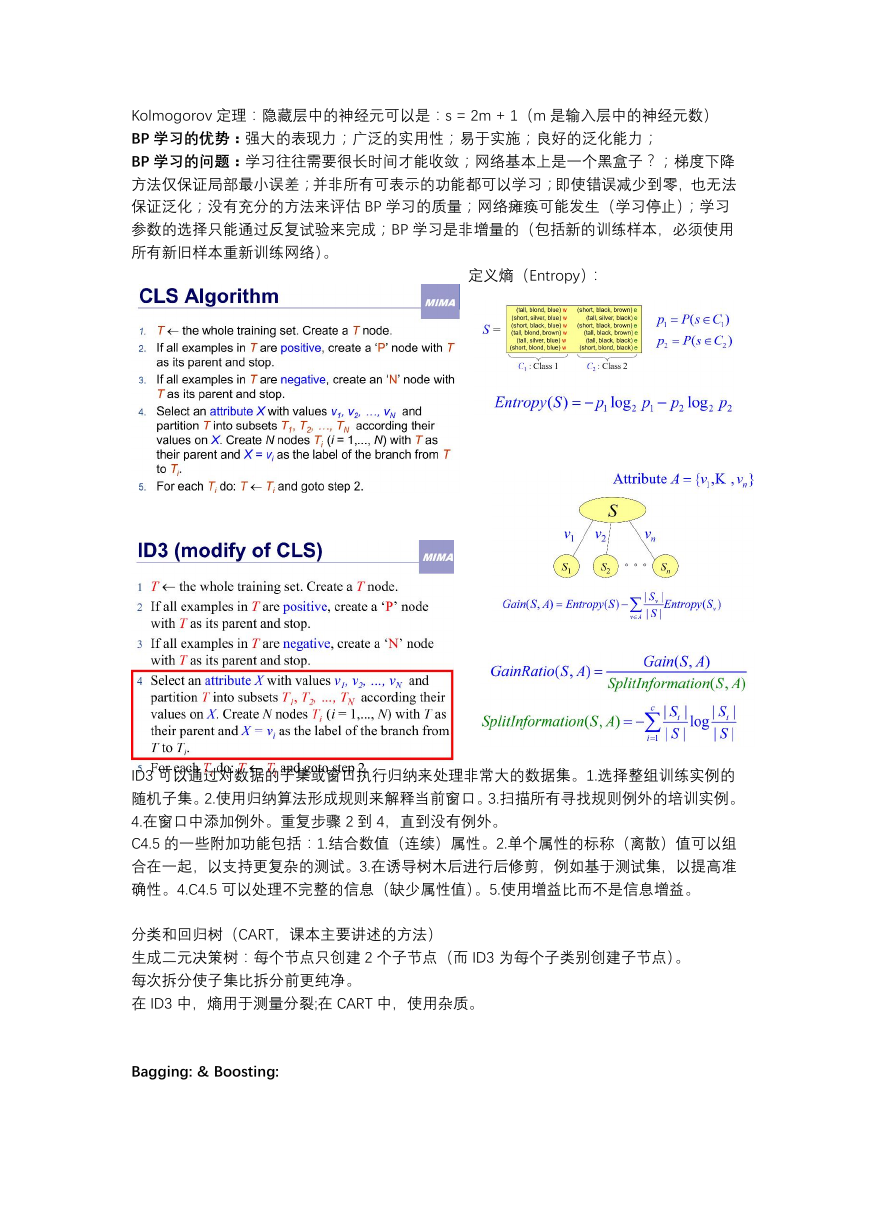

贝叶斯决策论的一些补充:

例题:

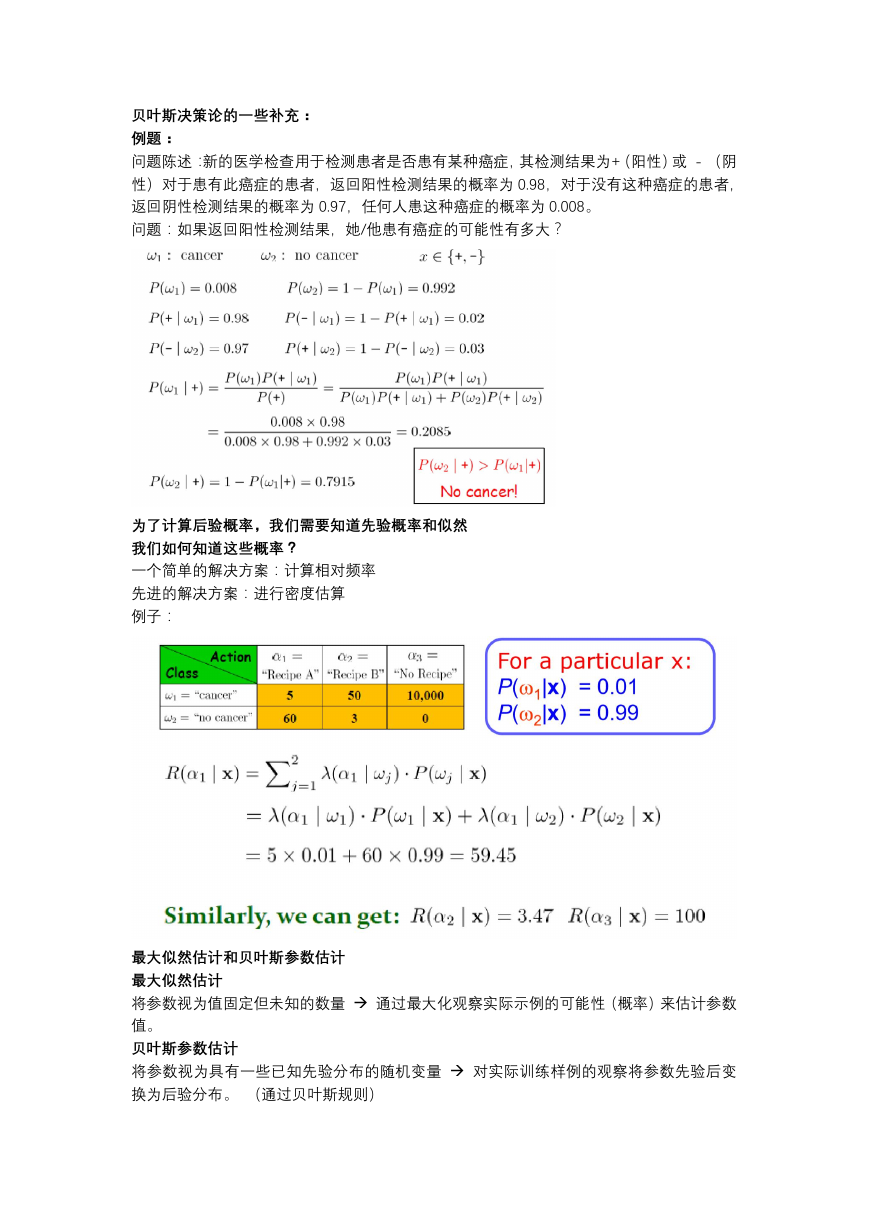

问题陈述:新的医学检查用于检测患者是否患有某种癌症,其检测结果为+(阳性)或 - (阴

性)对于患有此癌症的患者,返回阳性检测结果的概率为 0.98,对于没有这种癌症的患者,

返回阴性检测结果的概率为 0.97,任何人患这种癌症的概率为 0.008。

问题:如果返回阳性检测结果,她/他患有癌症的可能性有多大?

为了计算后验概率,我们需要知道先验概率和似然

我们如何知道这些概率?

一个简单的解决方案:计算相对频率

先进的解决方案:进行密度估算

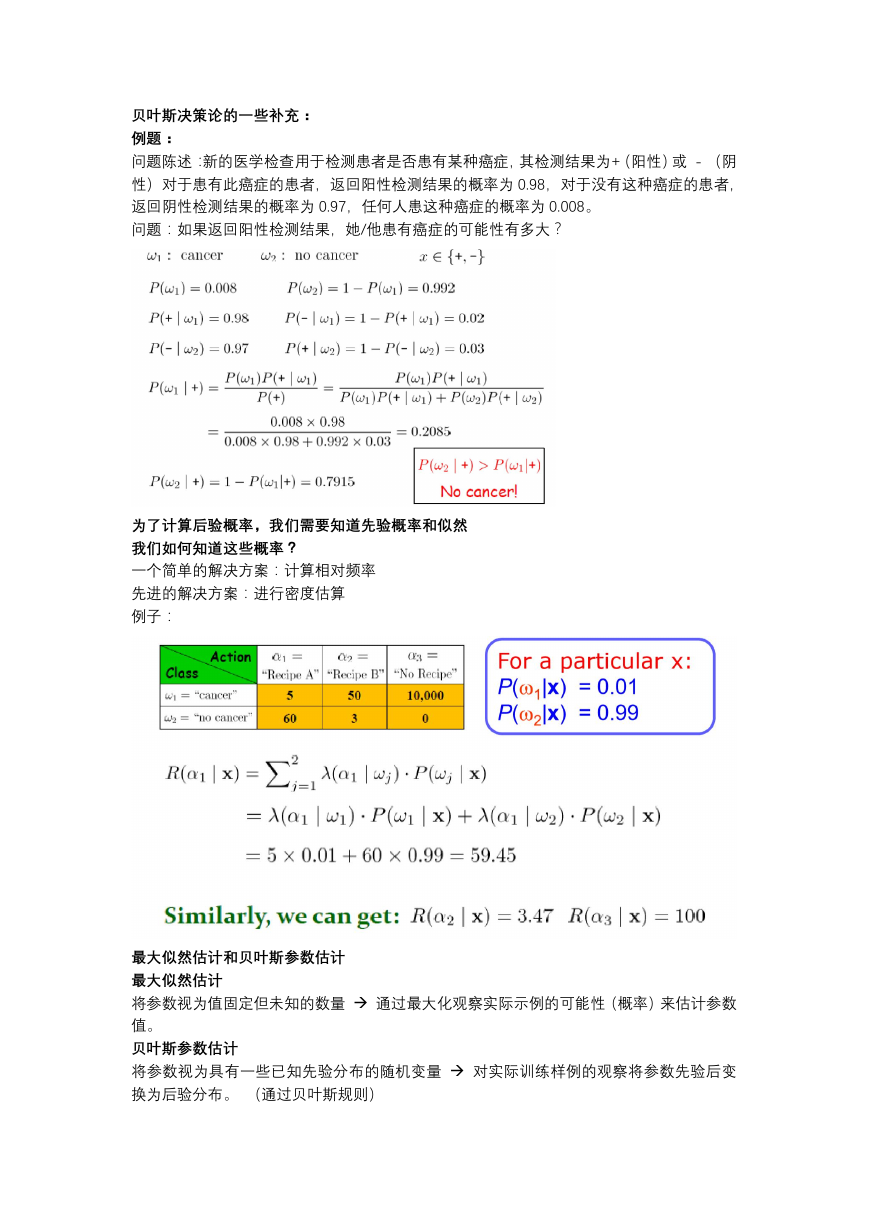

例子:

最大似然估计和贝叶斯参数估计

最大似然估计

将参数视为值固定但未知的数量 通过最大化观察实际示例的可能性(概率)来估计参数

值。

贝叶斯参数估计

将参数视为具有一些已知先验分布的随机变量 对实际训练样例的观察将参数先验后变

换为后验分布。 (通过贝叶斯规则)

�

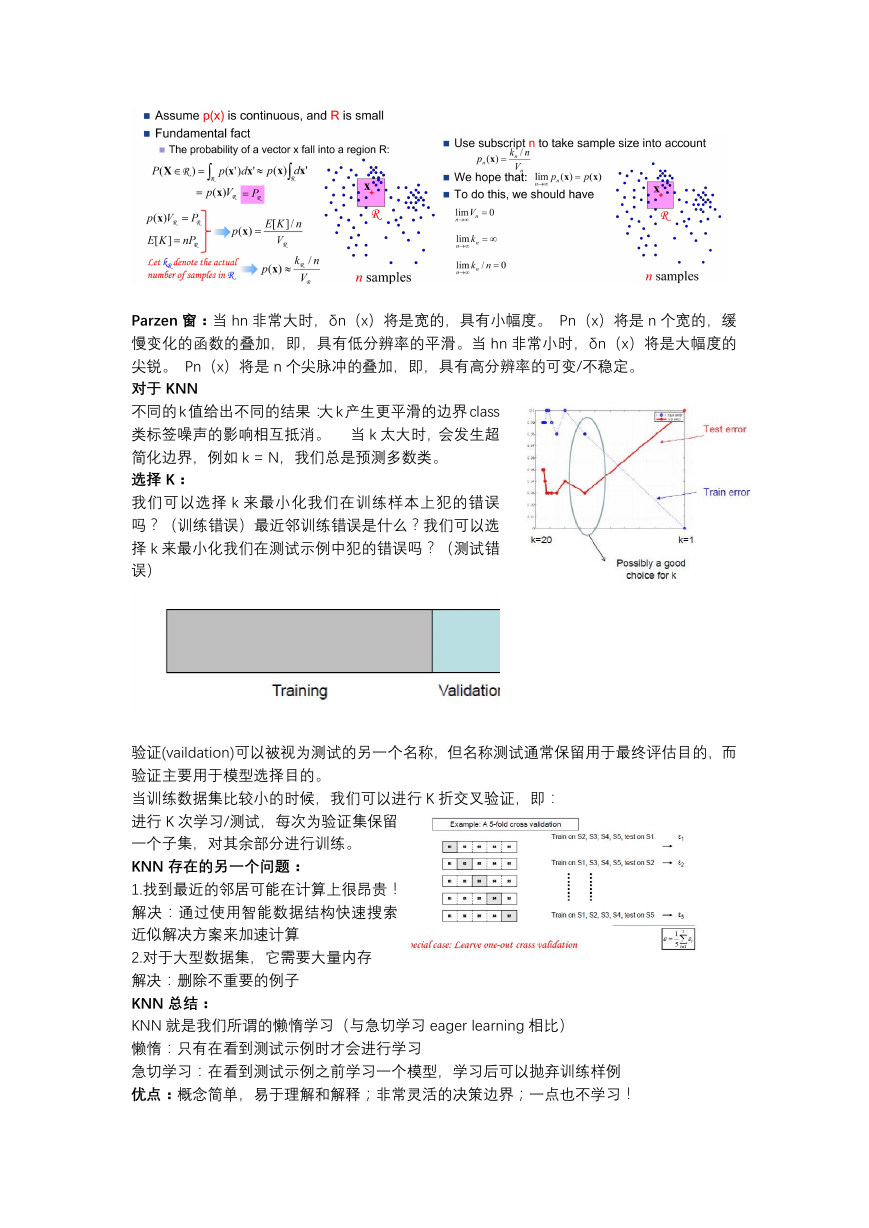

Parzen 窗:当 hn 非常大时,δn(x)将是宽的,具有小幅度。 Pn(x)将是 n 个宽的,缓

慢变化的函数的叠加,即,具有低分辨率的平滑。当 hn 非常小时,δn(x)将是大幅度的

尖锐。 Pn(x)将是 n 个尖脉冲的叠加,即,具有高分辨率的可变/不稳定。

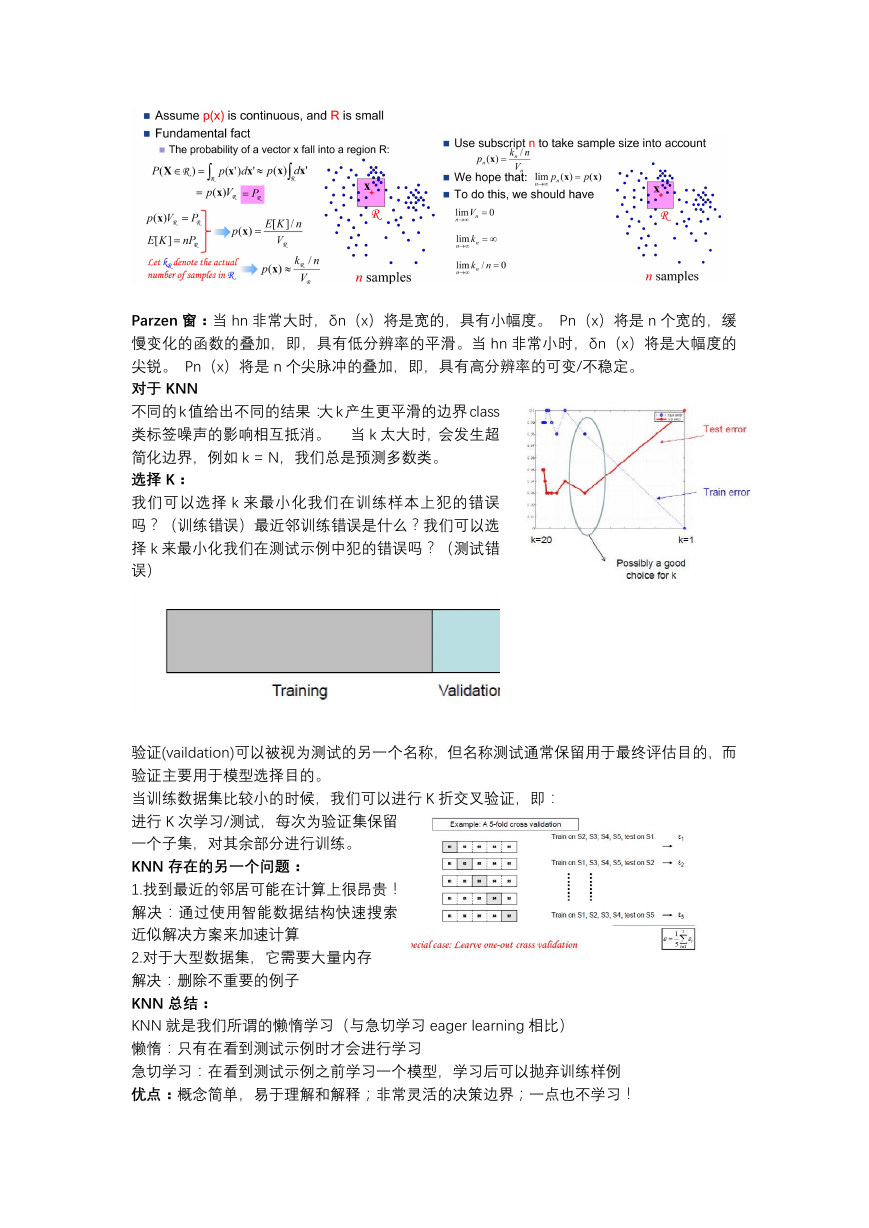

对于 KNN

不同的 k 值给出不同的结果:大 k 产生更平滑的边界 class

类标签噪声的影响相互抵消。 当 k 太大时,会发生超

简化边界,例如 k = N,我们总是预测多数类。

选择 K:

我们可以选择 k 来最小化我们在训练样本上犯的错误

吗?(训练错误)最近邻训练错误是什么?我们可以选

择 k 来最小化我们在测试示例中犯的错误吗?(测试错

误)

验证(vaildation)可以被视为测试的另一个名称,但名称测试通常保留用于最终评估目的,而

验证主要用于模型选择目的。

当训练数据集比较小的时候,我们可以进行 K 折交叉验证,即:

进行 K 次学习/测试,每次为验证集保留

一个子集,对其余部分进行训练。

KNN 存在的另一个问题:

1.找到最近的邻居可能在计算上很昂贵!

解决:通过使用智能数据结构快速搜索

近似解决方案来加速计算

2.对于大型数据集,它需要大量内存

解决:删除不重要的例子

KNN 总结:

KNN 就是我们所谓的懒惰学习(与急切学习 eager learning 相比)

懒惰:只有在看到测试示例时才会进行学习

急切学习:在看到测试示例之前学习一个模型,学习后可以抛弃训练样例

优点:概念简单,易于理解和解释;非常灵活的决策边界;一点也不学习!

�

坏处:- 很难找到一个好的距离测量;- 不相关的功能和 noise 可能非常有害

- 通常不能处理超过 30 个属性; - 计算成本:需要大量的计算和内存

距离度量应有的属性:非负;自反;对称;满足三角不等式

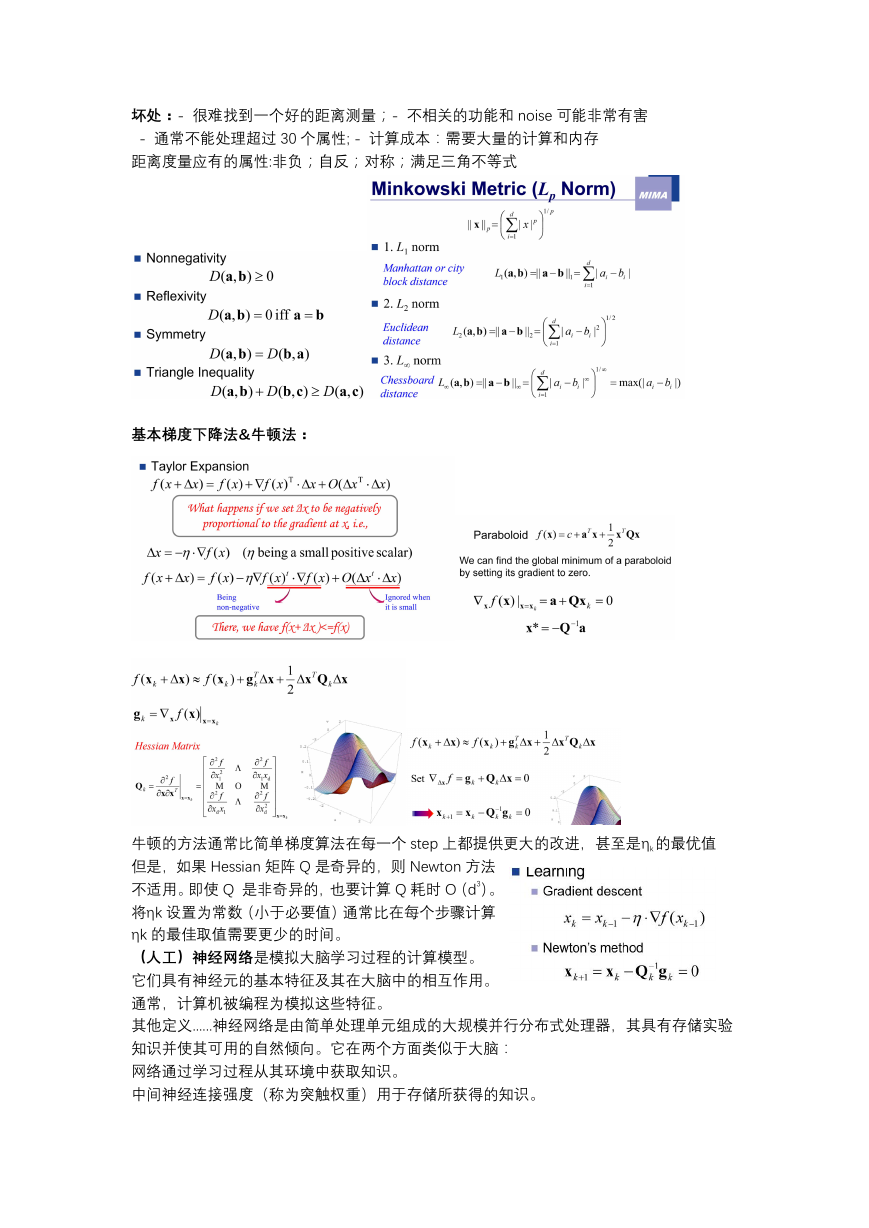

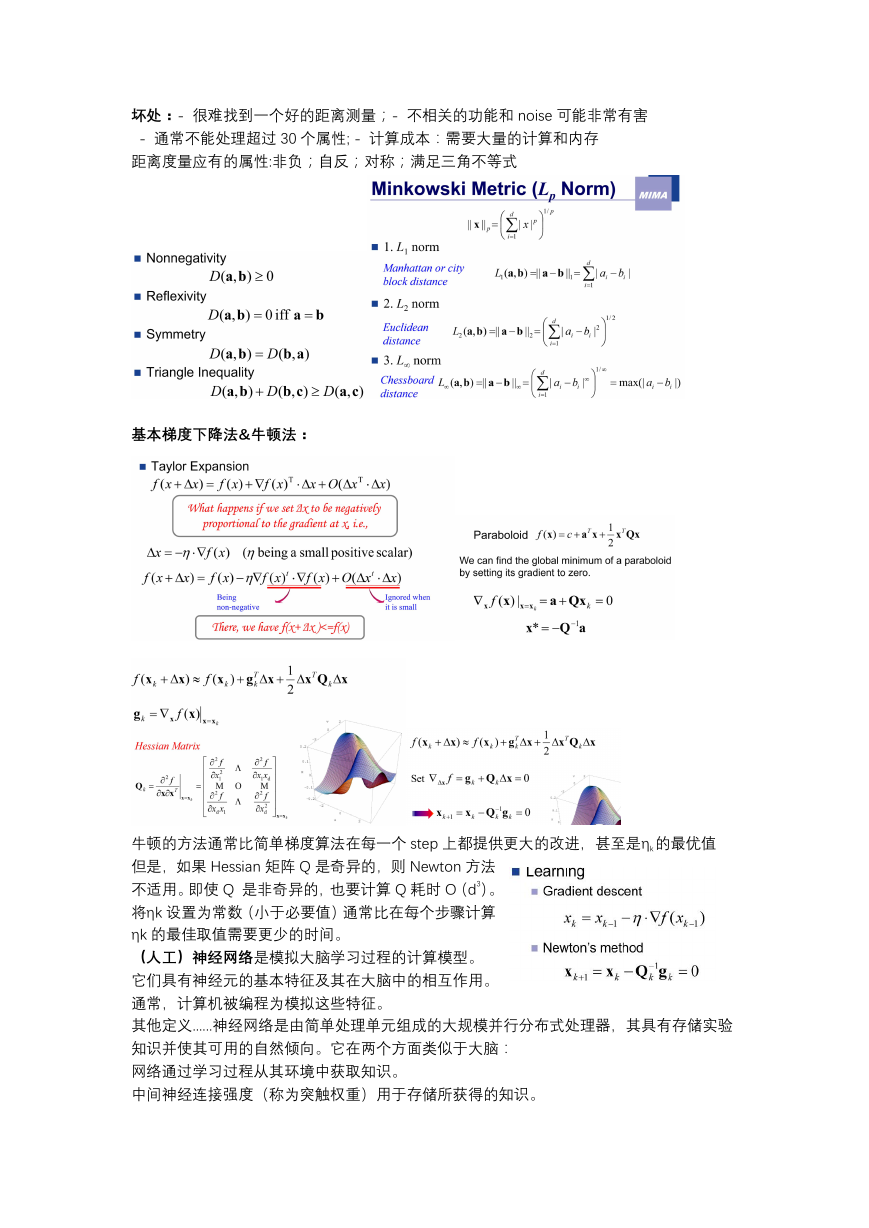

基本梯度下降法&牛顿法:

牛顿的方法通常比简单梯度算法在每一个 step 上都提供更大的改进,甚至是ηk 的最优值

但是,如果 Hessian 矩阵 Q 是奇异的,则 Newton 方法

不适用。即使 Q 是非奇异的,也要计算 Q 耗时 O(d3)。

将ηk 设置为常数(小于必要值)通常比在每个步骤计算

ηk 的最佳取值需要更少的时间。

(人工)神经网络是模拟大脑学习过程的计算模型。

它们具有神经元的基本特征及其在大脑中的相互作用。

通常,计算机被编程为模拟这些特征。

其他定义......神经网络是由简单处理单元组成的大规模并行分布式处理器,其具有存储实验

知识并使其可用的自然倾向。它在两个方面类似于大脑:

网络通过学习过程从其环境中获取知识。

中间神经连接强度(称为突触权重)用于存储所获得的知识。

�

神经网络的特征:大规模和并行处理;鲁棒的;自适应和组织;足以模拟非线性关系

结构:前馈、反馈 ;学习方法:监督、无监督 ;信号类型:连续、离散

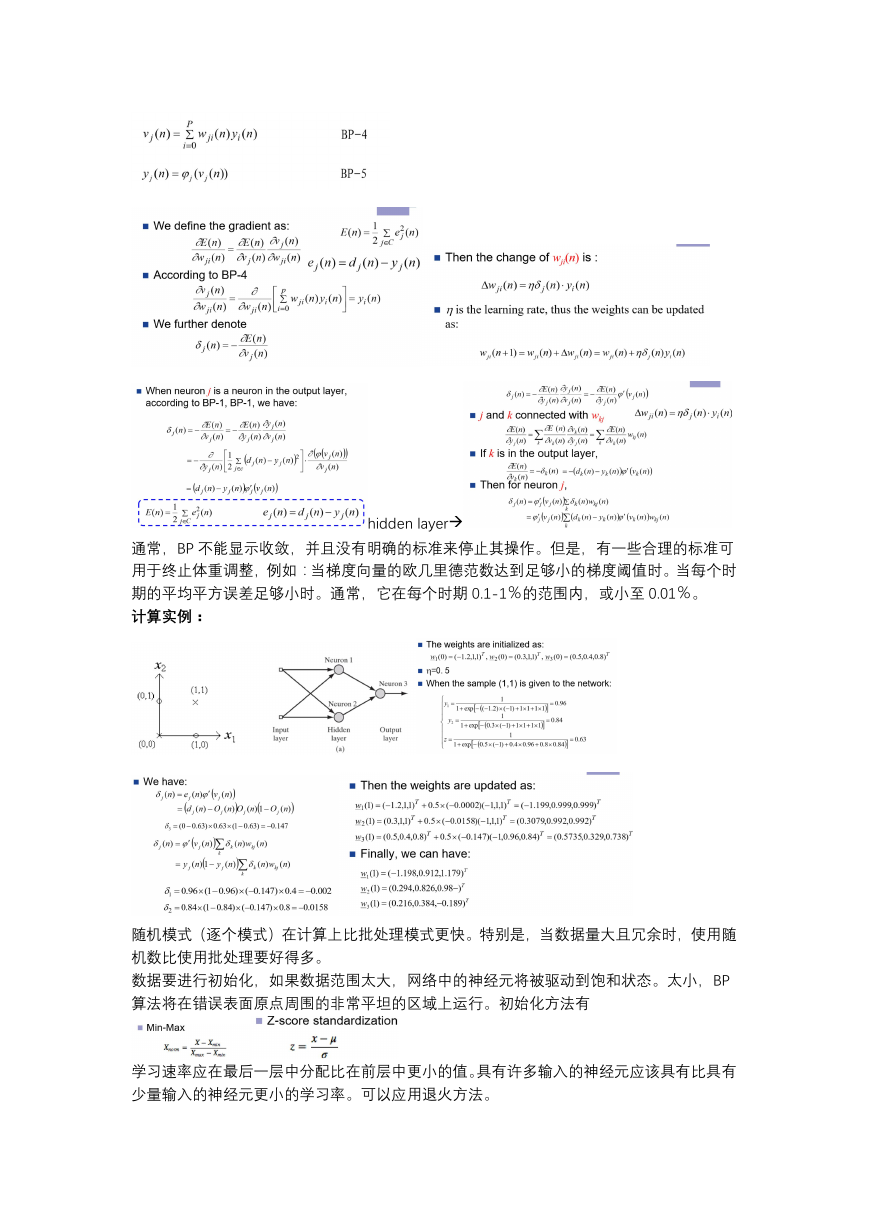

一般学习规则 测量误差 减少错误(通过适当

调整网络中的每个权重)

正向通过:从输出计算错误,用于更新输出权

重

向后通过:隐藏节点的错误是通过新权重反向

传播输出错误来计算的,更新隐藏权重、

在批量学习中,在呈现所有 N 个训练样本之后执行对多层感知器的突触权重的调整。 所

有 N 个样本一次表示的训练过程称为一个训练时期。因此批量学习的成本函数由平均误差

能量 Eav定义。优点:精确估计梯度向量,并行化 缺点:更多存储要求

�

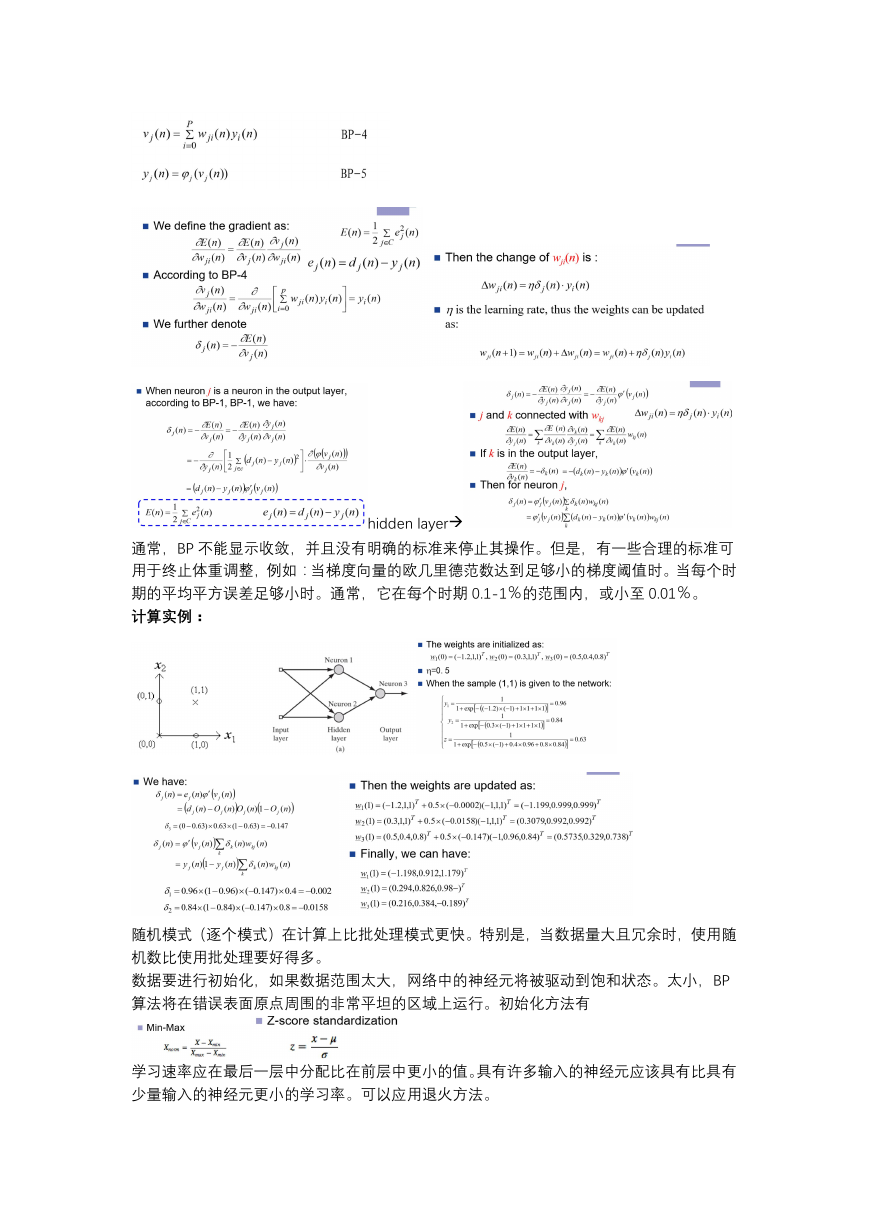

hidden layer

通常,BP 不能显示收敛,并且没有明确的标准来停止其操作。但是,有一些合理的标准可

用于终止体重调整,例如:当梯度向量的欧几里德范数达到足够小的梯度阈值时。当每个时

期的平均平方误差足够小时。通常,它在每个时期 0.1-1%的范围内,或小至 0.01%。

计算实例:

随机模式(逐个模式)在计算上比批处理模式更快。特别是,当数据量大且冗余时,使用随

机数比使用批处理要好得多。

数据要进行初始化,如果数据范围太大,网络中的神经元将被驱动到饱和状态。太小,BP

算法将在错误表面原点周围的非常平坦的区域上运行。初始化方法有

学习速率应在最后一层中分配比在前层中更小的值。具有许多输入的神经元应该具有比具有

少量输入的神经元更小的学习率。可以应用退火方法。

�

Kolmogorov 定理:隐藏层中的神经元可以是:s = 2m + 1(m 是输入层中的神经元数)

BP 学习的优势:强大的表现力;广泛的实用性;易于实施;良好的泛化能力;

BP 学习的问题:学习往往需要很长时间才能收敛;网络基本上是一个黑盒子?;梯度下降

方法仅保证局部最小误差;并非所有可表示的功能都可以学习;即使错误减少到零,也无法

保证泛化;没有充分的方法来评估 BP 学习的质量;网络瘫痪可能发生(学习停止);学习

参数的选择只能通过反复试验来完成;BP 学习是非增量的(包括新的训练样本,必须使用

所有新旧样本重新训练网络)。

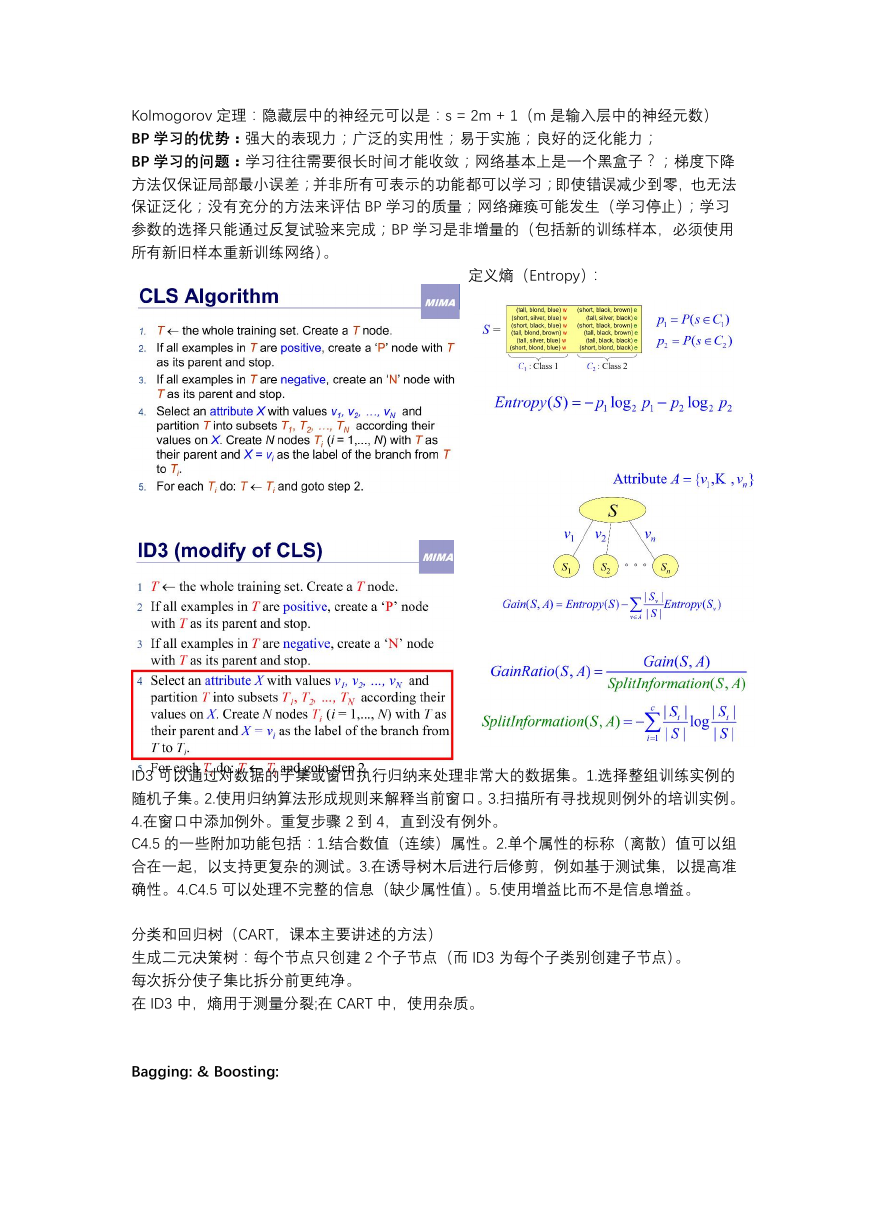

定义熵(Entropy):

ID3 可以通过对数据的子集或窗口执行归纳来处理非常大的数据集。1.选择整组训练实例的

随机子集。2.使用归纳算法形成规则来解释当前窗口。3.扫描所有寻找规则例外的培训实例。

4.在窗口中添加例外。重复步骤 2 到 4,直到没有例外。

C4.5 的一些附加功能包括:1.结合数值(连续)属性。2.单个属性的标称(离散)值可以组

合在一起,以支持更复杂的测试。3.在诱导树木后进行后修剪,例如基于测试集,以提高准

确性。4.C4.5 可以处理不完整的信息(缺少属性值)。5.使用增益比而不是信息增益。

分类和回归树(CART,课本主要讲述的方法)

生成二元决策树:每个节点只创建 2 个子节点(而 ID3 为每个子类别创建子节点)。

每次拆分使子集比拆分前更纯净。

在 ID3 中,熵用于测量分裂;在 CART 中,使用杂质。

Bagging: & Boosting:

�

Adaboost:

�

具有最大边距的线性判别函数是最佳的。边距定义为在击中数据点之前边界可以增加的宽度。

为什么它是最好的?对轮廓线具有直观的鲁棒性,因而具有很强的泛化能力

γ是 margin 宽度,R 是可以把数据集包裹的圆/球.的半径,d 是数据维度。

即 xTy

�

2023年江西萍乡中考道德与法治真题及答案.doc

2023年江西萍乡中考道德与法治真题及答案.doc 2012年重庆南川中考生物真题及答案.doc

2012年重庆南川中考生物真题及答案.doc 2013年江西师范大学地理学综合及文艺理论基础考研真题.doc

2013年江西师范大学地理学综合及文艺理论基础考研真题.doc 2020年四川甘孜小升初语文真题及答案I卷.doc

2020年四川甘孜小升初语文真题及答案I卷.doc 2020年注册岩土工程师专业基础考试真题及答案.doc

2020年注册岩土工程师专业基础考试真题及答案.doc 2023-2024学年福建省厦门市九年级上学期数学月考试题及答案.doc

2023-2024学年福建省厦门市九年级上学期数学月考试题及答案.doc 2021-2022学年辽宁省沈阳市大东区九年级上学期语文期末试题及答案.doc

2021-2022学年辽宁省沈阳市大东区九年级上学期语文期末试题及答案.doc 2022-2023学年北京东城区初三第一学期物理期末试卷及答案.doc

2022-2023学年北京东城区初三第一学期物理期末试卷及答案.doc 2018上半年江西教师资格初中地理学科知识与教学能力真题及答案.doc

2018上半年江西教师资格初中地理学科知识与教学能力真题及答案.doc 2012年河北国家公务员申论考试真题及答案-省级.doc

2012年河北国家公务员申论考试真题及答案-省级.doc 2020-2021学年江苏省扬州市江都区邵樊片九年级上学期数学第一次质量检测试题及答案.doc

2020-2021学年江苏省扬州市江都区邵樊片九年级上学期数学第一次质量检测试题及答案.doc 2022下半年黑龙江教师资格证中学综合素质真题及答案.doc

2022下半年黑龙江教师资格证中学综合素质真题及答案.doc