第34卷 第7期

2020年7月

文章编号:1003-0077(2020)07-0019-11

JOURNALOFCHINESEINFORMATIONPROCESSING

中文信息学报

Vol.34,No.7

July,2020

从视觉到文本:图像描述生成的研究进展综述

魏忠钰1,范智昊1,王瑞泽2,承怡菁1,赵王榕1,黄萱菁3

(1.复旦大学 大数据学院,上海200433;

2.复旦大学 工程与应用技术研究院,上海200433;

3.复旦大学 计算机科学与技术学院,上海200433)

摘 要:近年来,跨模态研究吸引了越来越多学者的关注,尤其是连接视觉和语言的相关课题。该文针对跨视觉和

语言模态研究中的核心任务———图像描述生成,进 行 文 献 综 述。该 文 从 基 于 视 觉 的 文 本 生 成 框 架、基 于 视 觉 的 文

本生成研究中的关键问题、图像描述生成模型的性能评价和图像描述生成模型的主 要 发 展 过 程 四 个 方 面 对 相 关 文

献进行介绍和总结。最后,该文给出了几个未来的重点研究方向,包括跨视觉和 语 言 模 态 的 特 征 对 齐、自 动 化 评 价

指标的设计以及多样化图像描述生成。

关键词:图像描述生成;跨模态特征对齐;文献综述

中图分类号:TP391 文献标识码:A

FromVisiontoText:ABriefSurveyforImageCaptioning

WEIZhongyu1,FANZhihao1,WANGRuize2,CHENGYijing1,

(1.SchoolofDataScience,FudanUniversity,Shanghai200433,China;

ZHAO Wangrong1,HUANGXuanjing3

2.AcademyforEngineeringandTechnology,FudanUniversity,Shanghai200433,China;

3.SchoolofComputerScienceandTechnology,FudanUniversity,Shanghai200433,China)

Abstract:Inrecentyears,increasingattentionhasbeenattractedtotheresearchfieldrelatedtocross-modality,

especiallyvisionandlanguage.Thissurveyfocusesonthetaskofimagecaptioningandsummarizesliteratures

fromfouraspects,includingtheoverallarchitecture,somekeyquestionsforcross-modalityresearch,theevalu-

ationofimagecaptioningandthestate-of-the-artapproachestoimagecaptioning.Inconclusion,wesuggestthree

directionsforfutureresearch,i.e.,cross-modalityrepresentation,automaticevaluationmetricsanddiversetext

generation.

Keywords:imagecaptioning;cross-modalityalignment;literaturereview

0 引言

多地引起 自 然 语 言 处 理 和 机 器 视 觉 领 域 学 者 的 关

近年来,结合图像和文本的跨模态研究越来越

注[1-3]。主流的任 务 包 括 图 像 描 述 生 成[4-5]、机 器 视

觉问答[6]、相册故事生成[7]、视觉对话生成 [8]、视觉

推理[9]、视觉导航[10],以 及 从 文 本 到 图 像 的 自 动 生

成[11]等。相关的 技 术 在 很 多 实 际 应 用 场 景 中 有 很

大的价值,包括构建 能 够 对 视 觉 信 息 进 行 处 理 的 智

能聊天机器人;在社交媒体上,为图片或者相册自动

产生描述;在幼儿教育中扮演讲师的角色;帮助视觉

障碍人士感知周边环境的视觉内容等。得益于深度

学习的最新进展,视觉—文本的跨模态研究在很多

应用中取得了在自 动 化 评 价 指 标 上 的 大 幅 度 进 步。

展进行综述。鉴于图像描述生成是目前受到关注最

多的应用任务,同时 包 括 了 基 于 视 觉 的 文 本 生 成 任

本文将针对基于视觉的文本生成领域的最新研究进

收稿日期:2019-03-16 定稿日期:2019-04-26

基金项目:国家 自 然 科 学 基 金(71991471);国 家 社 会 科 学 基 金(20ZDA060);上 海 市 科 学 技 术 委 员 会 (18DZ1201000,

17JC1420200)

�

中 文 信 息 学 报

02

务主要的技术模块,本 文 以 图 像 描 述 生 成 作 为 切 入

点,从基于视觉的文本生成框架、基于视觉的文本生

成的关键问题、图像 描 述 生 成 模 型 的 性 能 评 价 和 图

文献进行梳理。

1 基于视觉的文本生成框架

像描述生成模型的主要发展过程四个方面对相关的

的端到端自动生成框架以及融合神经网络的组合式

基于视觉的文本生成框架主要可以分成三类:

早期的基于模板匹 配 和 检 索 的 框 架、基 于 神 经 网 络

生成框架。

1.1 基于模板匹配和检索的框架

基于视觉的文本生成的早期方法大致可以分为

两类。第 一 类 是 基 于 模 板 匹 配 的 方 法[12-14]。 该 类

方法先从 图 像 中 检 测 出 相 关 的 实 体 信 息(物 体、属

性、动作),然后将这 些 实 体 填 充 到 手 工 设 计 的 句 子

模板中,存在的问题是生成的文本往往欠缺流利性,

在表达的多样性方面也不能满足实际需求。第二类

是基于 检 索 的 方 法[15-16]。 该 类 方 法 预 先 准 备 一 批

与 目 标 图 像 视 觉 上 相 似 的 图 像—文 本 匹 配 语 料 集

合,然后在该语料集 合 上 搜 索 与 目 标 图 片 最 相 近 的

样本,直接采用查询 到 的 图 片 所 对 应 的 文 本 作 为 需

要生成的描述。该类方法的问题是依赖预先准备的

图像—文本匹配的语料集合,对于内容上差异大的

图片往往很难找到 相 关 的 匹 配 对 象,因 此 在 生 成 精

度上存在很大的缺陷。

1.2 端到端的自动生成框架

针对早期框架所产生的文字存在流畅性欠缺和

不能产生新内容的 缺 点,基 于 深 度 神 经 网 络 的 端 到

端模型可以潜在地解决这两个问题。端到端的学习

框架[17]包括编码器和解码器两个基本部件,其中编

码器将输入的信息 转 换 成 低 维 稠 密 的 隐 式 向 量,再

通过解码器将该隐式向量转换成目标输出。该学习

范式最早应用在机 器 翻 译 的 场 景,并 取 得 了 显 著 的

性能提升。研究者于是将端到端的学习框架引入到

针对视 觉 信 息 的 自 动 化 描 述 任 务 中[4]。 在 该 框 架

中,编码器由在大规 模 图 像 分 类 中 被 证 明 有 效 的 多

层卷积神经网络(CNN)构成,以实现对图像进行视

觉信息 的 特 征 提 取[18-19]。 解 码 器 则 由 在 语 言 模 型

构建方面表现良好的循环神经网络(RNN)构成,包

括长短时 记 忆 网 络[20](LSTM)和 带 门 控 机 制 的 循

时间片使用前一个时间片产生的隐藏状态和生成单

2020年

环神经网络[21](GRU),RNN 对 于 句 子 的 生 成 依 循

逐字的方式进行,以图像特征作为初始状态,每一个

词作为输入,产生这个时间片的单词。最近,也有学

者在编码器和解 码 器 端 使 用transformer作 为 文 本

生成的基本部件[22]。当前,端到端的生成方式是基

于视觉的文本生成 任 务 的 主 流 框 架,不 同 模 型 的 差

别在于 采 用 不 同 的 视 觉 特 征 抽 取 方 式,以 及 采 用

RNN 的不同变 种 进 行 自 动 化 的 文 本 生 成。基 于 端

提高,但是视觉和文 本 的 关 联 仅 仅 通 过 中 间 的 隐 藏

表示构建,这使得生 成 的 文 本 包 含 一 些 不 可 控 的 结

果,如生成与图片信息无关的文字。

1.3 融合神经网络的组合式的框架

到端的生成框架在生成文本的流畅性方面有很大的

针对端到端框架会产生不确定性生成结果的缺

点,学者研究组合式 的 框 架 进 行 图 像 描 述 的 自 动 化

生成。该框架主要 包 含 两 个 部 件,视 觉 语 义 提 取 和

结合视觉语义的描述生成。文献[23]的研究首先从

图像中发现一组语义概念,以名词、动词和形容词的

形式表征。基于语 义 概 念,语 言 模 型 被 用 来 生 成 多

个候选描述。最后,多 模 态 的 相 似 度 计 算 模 型 为 候

选描述进行重要性 排 序,并 从 中 选 择 得 分 最 高 的 作

为输出。文献[24]沿用了早期基于模板匹配的图像

文本生成的思路,采 用 神 经 网 络 模 型 对 两 个 基 础 模

块进行替换,以达到 对 传 统 的 基 于 模 板 匹 配 的 方 法

和基于神经网络的端到端方法的调和作用。该方法

首先从 整 体 的 视 觉 信 息 中 自 动 化 地 构 建 句 子“模

板”,模板的每一个空格可以关联到图像中的一个局

部区域。在第二个 步 骤 中,从 槽 位 相 关 联 的 局 部 图

像中进行物体识别,并 将 检 测 的 物 体 填 充 到 模 板 中

作为最后的描述。文献[25]进一步修正文本生成模

块,抛弃了基 于 RNN 的 文 本 生 成 组 件。 该 框 架 包

含两个步骤,首先,从视觉信息中发现一些明确的语

义表示单元,以短语的形式表示。其次,用短语拼接

的方法来形成最后的图像描述。组合式的框架在生

度的性能提升,但是 非 端 到 端 模 型 在 生 成 文 本 的 流

畅性方面则有不可避免的缺陷。这也是目前针对该

类方法进行提升的主要方向。

2 基于视觉的文本生成的关键问题

成文本的准确性上相较单纯的端到端模型有一定程

基于视觉信息的文本生成主要包含四个核心的

�

魏忠钰等:从视觉到文本:图像描述生成的研究进展综述

7期

研究问题:视觉 端 的 特 征 表 示、视 觉 与 文 本 的 特 征

对齐、加入强化学习的图像描述生成,以及多样化图

像描述生成。

2.1 视觉端的特征表示

检测模型 所 使 用 的 语 料 集 合 中 包 含 的 标 注 标 签 个

当前研究在视觉端的特征提取,往往以两种基

本形式存在:视觉表示和文本概念。视觉表示代表

从图像中直接提 取 的 特 征 信 息。早 期 的 工 作,将 图

像划 分 为 大 小 相 等 的 视 觉 区 域,再 基 于 CNN[26]对

图像区域进行顺次 的 卷 积 处 理,过 程 中 不 编 码 更 细

粒度的信息。按照 指 定 大 小 划 分 得 到 的 图 像 区 域,

往往难以灵活捕捉 图 像 中 包 含 的 实 体 信 息,这 限 制

了对于图像端的语义理解。为了更好地进行图片信

息的 特 征 提 取,研 究 者 开 始 采 用 R-CNN[27]进 行 视

觉端的信息处理,该 方 法 采 用 物 体 检 测 模 型 作 为 特

征提取器,在图片中划定大小不等的边框,并从中发

现实体信息,作 为 视 觉 信 息 的 表 示。该 方 法 依 赖 于

物体检测模型的实 体 识 别 能 力,同 时 也 受 限 于 物 体

数。基于R-CNN,研究者进一步设计了在实际应用

中更高效 的 FasterR-CNN[28],并 得 到 更 广 泛 的 使

用。仅仅依靠图像处理的视觉信息提取方法建构视

义鸿沟。为 了 在 视 觉 端 的 特 征 提 取 中 考 虑 语 义 信

息,相关研究[29-31]将 图 像 的 语 义 概 念 识 别 转 换 成 多

标签分类问 题,采 用 单 词、短 语 作 为 语 义 的 表 示 单

元,并通过不同的方 式(注 意 力 机 制,嵌 入 到 循 环 神

经网络的解码单元中)将 这 一 组 语 义 单 元 作 用 到 文

本解码的过程中。最近,有研究者[32]引入场景图的

征表示。场景图中的节点代表视觉信息中发现的视

觉实体,而场景图的 边 则 是 基 于 语 义 信 息 的 实 体 关

系。然而,为了构造场景图,需要复杂的流水线,并

且不能避免错误传播。这在某种程度上限制了场景

图在更多场景进行推广。

2.2 视觉与文本的特征对齐

觉信息特征无法解决视觉信息与文本之间存在的语

方法将视觉特征和语义信息相结合作为图片端的特

基于卷积神经网络的视觉特征抽取模块将图像信息

在跨模态的相关研究中,核心部件是不同模态

信息的联合 表 示 学 习。在 端 到 端 的 学 习 框 架 中[4],

表征成低维稠密向 量,而 基 于 循 环 神 经 网 络 的 文 本

的描述。这个过程假设了整张图片的信息和待生成

文本的信息共享了 一 个 隐 空 间,以 低 维 稠 密 向 量 表

生成部件则从该低维稠密向量中逐字生成图像相关

针对图像 特 征 提 取 和 循 环 神 经 网 络 的 参 数 进 行 训

12

示。卷积神经网络和循环神经网络的参数在一个联

合训练的框架下完成。文 献[5]使 用 两 个 任 务 分 别

练。在卷积神经网 络 部 分,一 个 图 像 特 征 和 句 子 特

征对齐的任务被构造用来进行参数学习。在循环神

经网络部分,图像特征提取器的参数被固定,句子生

成任务被用来进行参数学习。在这种句子生成框架

中,图像特征以隐状 态 的 形 式 仅 仅 直 接 影 响 首 个 单

词的生成,对于句子 中 其 他 单 词 生 成 的 影 响 则 是 间

接的。

随着句 子 长 度 的 增 加,图 像 特 征 对 于 单 词 生

成的影响 慢 慢 淡 化,导 致 句 子 的 生 成 更 多 地 受 到

语言模型 的 影 响,而 不 能 很 好 地 描 绘 图 像 中 的 具

体信息。为了进一 步 关 联 局 部 图 像 特 征 和 句 子 中

字词的生 成 过 程,采 用 注 意 力 机 制 来 进 行 基 于 视

觉信息的文本生 成 任 务。 注 意 力 机 制 最 早 在 机 器

翻译领域被提出 作 为 编 码 器—解 码 器 框 架 的 一 个

补充部件[33],在解码器生成单词时,用 来 在 输 入 序

列中寻找最能提 供 辅 助 信 息 的 序 列 单 元 部 件。 文

献[34]引入注意力 机 制 连 接 文 本 生 成 过 程 和 图 片

中的局部区域特 征,在 解 码 某 个 单 词 时,解 码 器 计

算图片局 部 区 域 对 于 该 单 词 的 决 策 权 重,并 采 用

生成概率分布。学 者 将 这 种 关 联 图 像 区 域 特 征 和

文本生成 的 注 意 力 框 架 称 为 自 顶 向 下 的 方 案,而

自底向上的方案。文献[35]结 合 了 自 顶 向 下 和 自

底向 上 两 种 模 式,自 底 向 上 的 机 制 采 用 Faster

R-CNN[28]从图像中 选 取 有 显 著 意 义 的 区 域,在 解

码每个单 词 的 时 候,使 用 其 关 联 的 局 部 图 像 特 征

的重要性 权 重,重 新 调 整 FasterR-CNN 发 现 的 实

体的重要性,用来计算单词的生成概率向量。

的成 功 应 用,如 BERT[36]、ResNet[37]等,学 者 开 始

研究结合视觉和文本的预训练模型。基本的研究思

路借鉴BERT 等的预训练模型,将视觉与语言的混

合表示以序列的方式输入到基于transformer的框架

中,然后依照自监督的方式进行优化。到目前为止,

出现了 VisualBert[38]、Unicoder-VL[39]、VL-BERT[40]、

ViLBERT[41]、LXMERT[42]和 UNITER[43]等 研 究

工作。依据处理文 本 和 图 片 的 方 式,相 关 工 作 可 以

分成两大 类:单 流 编 码(VisualBert、Unicoder-VL、

VL-BERT 和 UNITER)和 双 流 编 码(ViLBERT 和

LXMERT)。单流编码将图片和句子拼接成一个序

加权平均的方法 引 入 图 片 区 域 特 征 来 计 算 单 词 的

将关联图像中的 实 体 特 征 和 文 本 生 成 的 方 法 称 为

随着预训练模型在视觉和文本单一模态场景中

�

22

列,输入到同一个编码器中,同时对两种模态的信息

进行编码。双流编码则认为图片和文本的底层表示

有着不同的特性,所 以 先 采 用 不 同 的 编 码 器 对 图 片

和文本进行单模态 编 码,之 后 再 通 过 互 注 意 力 机 制

对两种模态进行联合编码。这些预训练模型采用的

自监督训练 任 务 包 括,遮 盖 语 言 模 型、遮 盖 区 域 分

类/回归、视觉文本匹配以及视觉问答。遮盖语言模

型和BERT 的训练任务基本类似,但在推断被遮盖

的单词时,更希望模型学会从视觉信息中寻找线索。

遮盖区域和遮盖语 言 的 本 质 是 相 同 的,只 不 过 遮 盖

的部件从字符变成了某个图片区域。视觉文本匹配

任务和BERT 中的后续句子推断任务相似,通过构

造负样例的方式来判断文本和图片是否匹配。虽然

跨模态的预训练模 型 越 来 越 多 地 引 起 学 者 的 关 注,

但是在跨模态文本生成方面的应用还没有起步。鉴

究中并未引起足够 关 注,未 来 如 何 将 跨 模 态 的 预 训

重点。

2.3 引入强化学习的图像描述生成

练模 型 融 入 到 图 像 描 述 生 成 中 会 是 一 个 研 究 的

于跨模态的联合表示学习在当前的图像描述生成研

生成解码 器 将 每 一 个 单 词 的 产 生 看 成 一 个 分 类 问

在图像描述生成任务中,基于神经网络的文本

题,并使用交叉熵损 失 函 数 来 进 行 文 本 生 成 模 型 的

训练。这样的模型 训 练 方 式 存 在 两 个 问 题,一 个 被

称为暴露偏置(exposurebias),即在训练时,模型当

前时刻的输入是来 自 训 练 集 的 真 实 单 词,而 在 测 试

时,输入的却是上一时刻的预测结果,一旦模型单步

表现不佳,就会导致误差累积,从而影响整体的生成

效果;另一个问题被称 为 损 失 评 估 失 配(loss-evalu-

ationmismatching),即 在 训 练 时,模 型 采 用 交 叉 熵

损失函数来评估生成结果的好坏,而在测试时,却采

用其他的自动化 评 价 指 标(见3.2 节),存 在 训 练 和

测试评估方式不一 致 的 问 题,从 而 影 响 模 型 在 测 试

时的表现。

为了解 决 上 述 问 题,文 献[44]引 入 强 化 学 习

进行模型 训 练,以 解 决 模 型 训 练 和 测 试 过 程 的 不

一致问题。一方面,采 用 计 划 采 样(scheduledsam-

pling)的方 法 在 训 练 时 也 采 用 上 一 时 刻 产 生 的 词

语,从而解 决 暴 露 偏 置 的 问 题;另 一 方 面,强 化 学

价指标来 完 成 模 型 参 数 的 更 新,从 而 解 决 损 失 评

估失配问题。

习可以在训练时 通 过 最 大 化 一 些 测 试 时 采 用 的 评

强化学习的方法在图像描述任务中的应用需要

中 文 信 息 学 报

产生的原因是模型执行过程中计算期望梯度时会产

2020年

构造三个关键要素,即状态(state)、动作(action)与

奖励(reward)。状态就是解码过程中每个时间片的

隐藏状态表示,而动 作 是 对 当 前 时 刻 生 成 单 词 的 选

择,奖励一般采 用 自 动 化 的 评 价 指 标。基 于 强 化 学

习的基本方法存在模型训练不稳定的问题。该问题

生较高的方差,其中 一 种 解 决 办 法 是 加 上 基 线 模 型

的 约 束。 比 如 在 MIXER[44](mixedincremental

cross-entropyreinforce)中,基线就是一个简单的多

个采样 样 本 的 奖 励 均 值。 在 SCST[45](self-critical

sequencetraining)中,这 个 基 线 采 用 固 定 策 略 采 样

(贪婪搜索或者束搜索)进行奖励计算。还有一些方

法比如actor-critic[46],则训练一个评论(critic)网络

来估算奖励。

目前,引 入 强 化 学 习 进 行 图 像 描 述 生 成 的 模

型训练方法 一 般 遵 循 以 下 流 程:先 采 用 交 叉 熵 损

失函数进行模型 训 练,当 性 能 达 到 一 定 程 度 之 后,

再以自动 化 评 价 指 标 为 奖 励,使 用 强 化 学 习 进 行

模型训练。经过强 化 学 习 训 练 过 的 模 型 通 常 可 以

具有更好 的 性 能,因 此 当 前 针 对 图 像 描 述 的 模 型

能比较。

2.4 多样化图像描述生成

往往会配置使用 强 化 学 习 的 版 本 进 行 有 针 对 的 性

不同的 人 在 对 同 一 张 图 像 进 行 描 述 时,往 往

会产生不 同 的 描 述 语 言,为 了 使 机 器 产 生 的 文 本

能够具有 多 样 性 和 创 新 性,学 者 开 始 研 究 多 样 化

的图像描述生成方法。文 献[47]在 句 子 生 成 阶 段

产生多个样本,并 引 入 惩 罚 因 子,对 生 成 样 本 之 间

重复的词 进 行 惩 罚 以 激 励 产 生 更 多 样 化 的 句 子。

文献[48]尝试在互 相 不 重 叠 的 数 据 集 分 割 中 单 独

训练文本 生 成 器,以 通 过 不 同 的 文 本 生 成 器 来 产

生多样性的句子。文献[49]在 训 练 的 过 程 中 生 成

多个候选 句 子,并 使 用 核 方 法 来 计 算 句 子 之 间 的

相似性,随 后 将 相 似 性 计 算 模 型 加 入 到 对 抗 生 成

网络中,以 激 励 生 成 器 达 成 生 成 的 多 样 化。 文 献

[50]在问 题 生 成 这 个 场 景 中,将 问 题 类 型 和 图 片

信息一 起 建 模,以 达 到 产 生 多 样 化 问 题 的 目 的。

文献[51]将图片中 的 物 体 作 为 先 验 信 息 加 入 到 变

分自编码 器 的 隐 空 间 中,引 导 面 向 不 同 物 体 的 描

述生成,文 献[52]更 精 细 地 在 变 分 自 编 码 器 的 隐

空间当中去建模词汇 和 语 法 结 构。 文 献[53]认 为

生成模型 之 所 以 缺 乏 多 样 性,是 因 为 生 成 模 型 会

倾向于选择在 数 据 集 合 中 出 现 频 率 更 高(相 对 来

�

魏忠钰等:从视觉到文本:图像描述生成的研究进展综述

文本生成的多样性评估可以从数据集和单个样

并通过对抗生成 网 络 来 强 化 生 成 器 在 这 方 面 的 性

7期

说更安 全)的 词。 生 成 内 容 的 多 样 性 以 及 图 片 和

内容的相关性其 实 是 一 体 两 面。 他 们 因 此 通 过 负

采样的方法,训练 模 型 辨 识 图 片 和 句 子 的 相 关 性,

能。文 献[54]也 讨 论 了 相 同 的 问 题,并 引 入 了

RankGAN,该方法虽然在自动化指标 上 稍 有 逊 色,

但在人工评价上显示出更优越的效果。

例两个方面进行。在数据集方面:①计算生成的描

述没有出现在训练 数 据 集 中 的 比 例,② 计 算 基 于 图

片生成的 描 述 中 包 含 的 词 汇 数 量。 前 一 个 指 标 越

高,表示生成的描述在创新性方面的得分越低;后者

的指标越高,表 示 生 成 的 描 述 的 多 样 化 程 度 越 高。

在单个样例方面,学者提 出 Dist-n[55]和 mBLEU[48]

来度量生成的多个句子 之 间 的 相 似(不 相 似)性,从

而考量描述的多样化程度。Dist-n统计针对单个图

像 生 成 的 多 个 描 述 中 不 重 复 的 n 元 组 个 数。

mBLEU 在为目标图像生成的多个描述中每次选取

一个描述,并 计 算 它 与 其 他 描 述 之 间 的 BLEU 值。

因为BLEU 是基于n元组的相似性度量指标,所以

mBLEU 越低说明 生 成 的 句 子 之 间 的 差 异 性 越 大,

表明生成的描述多样性越好。

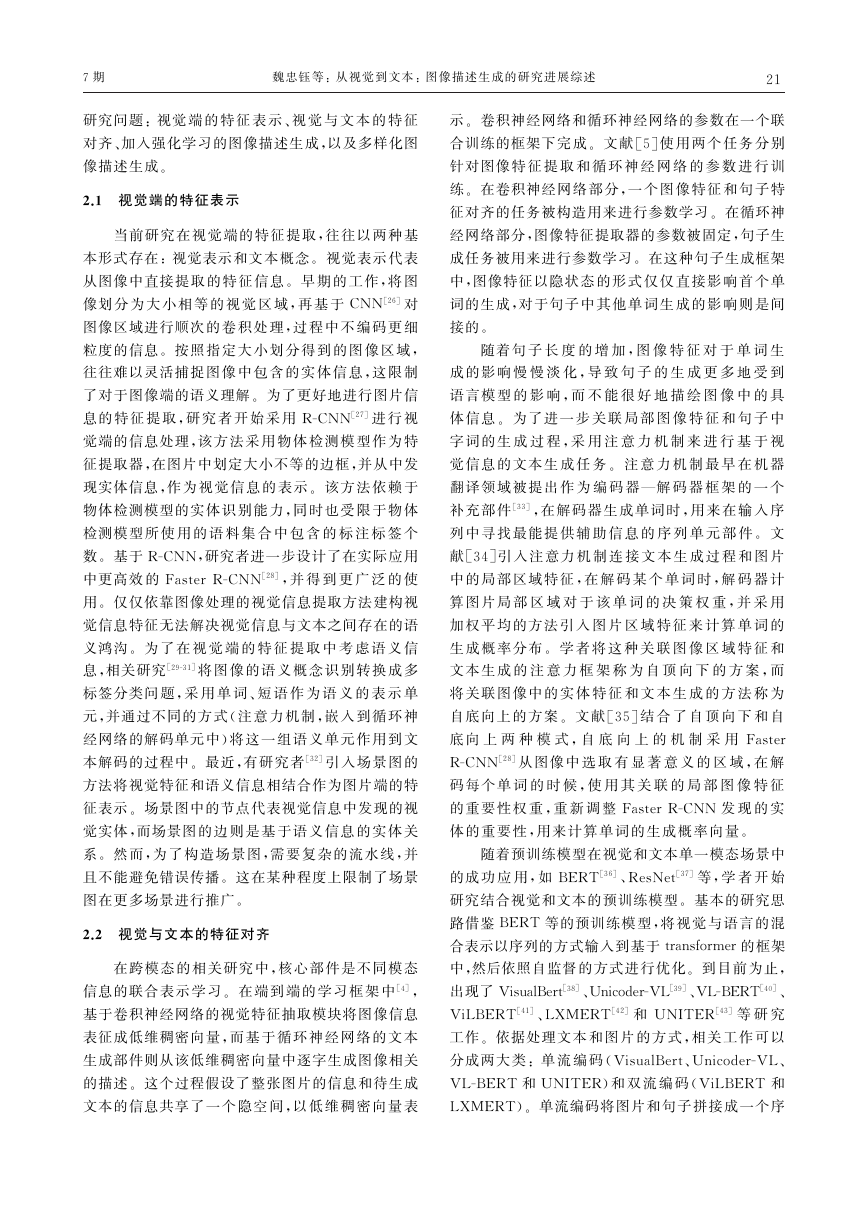

3 图像描述生成模型的性能评价

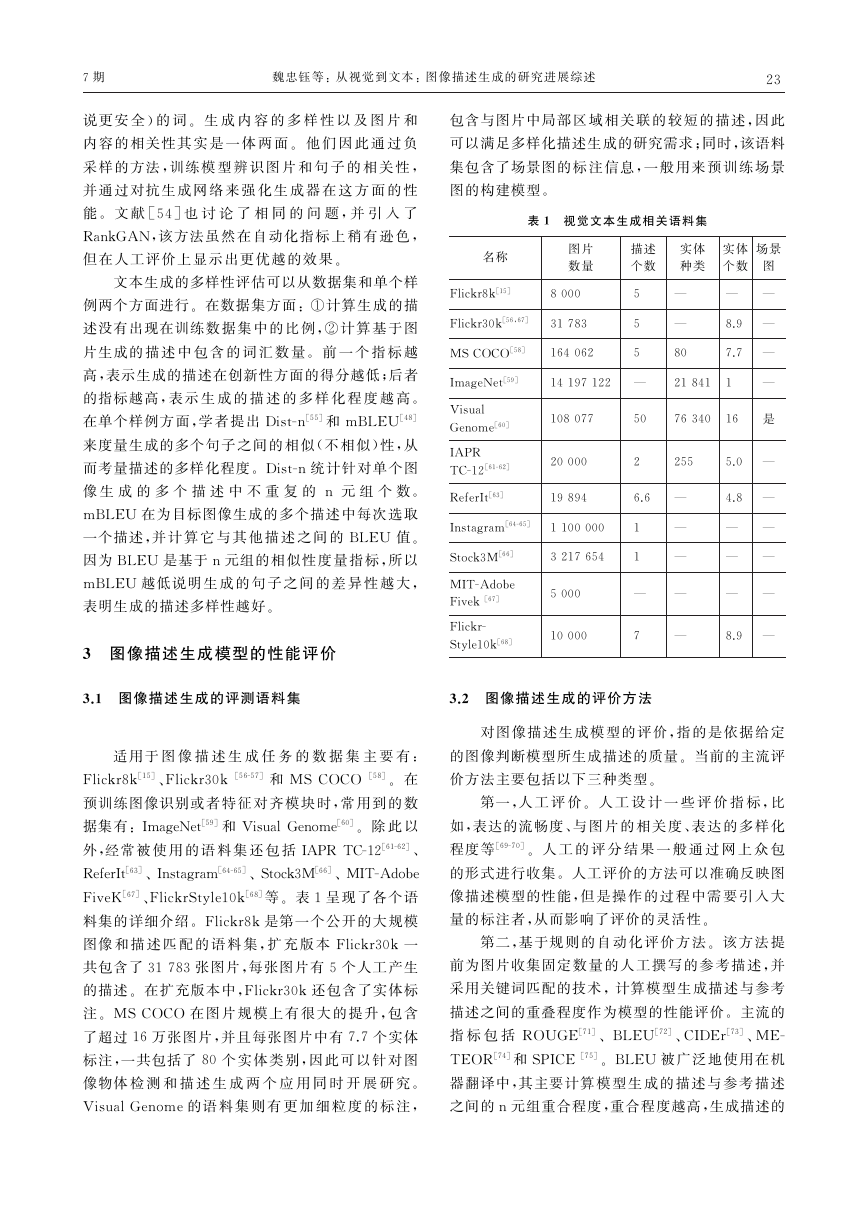

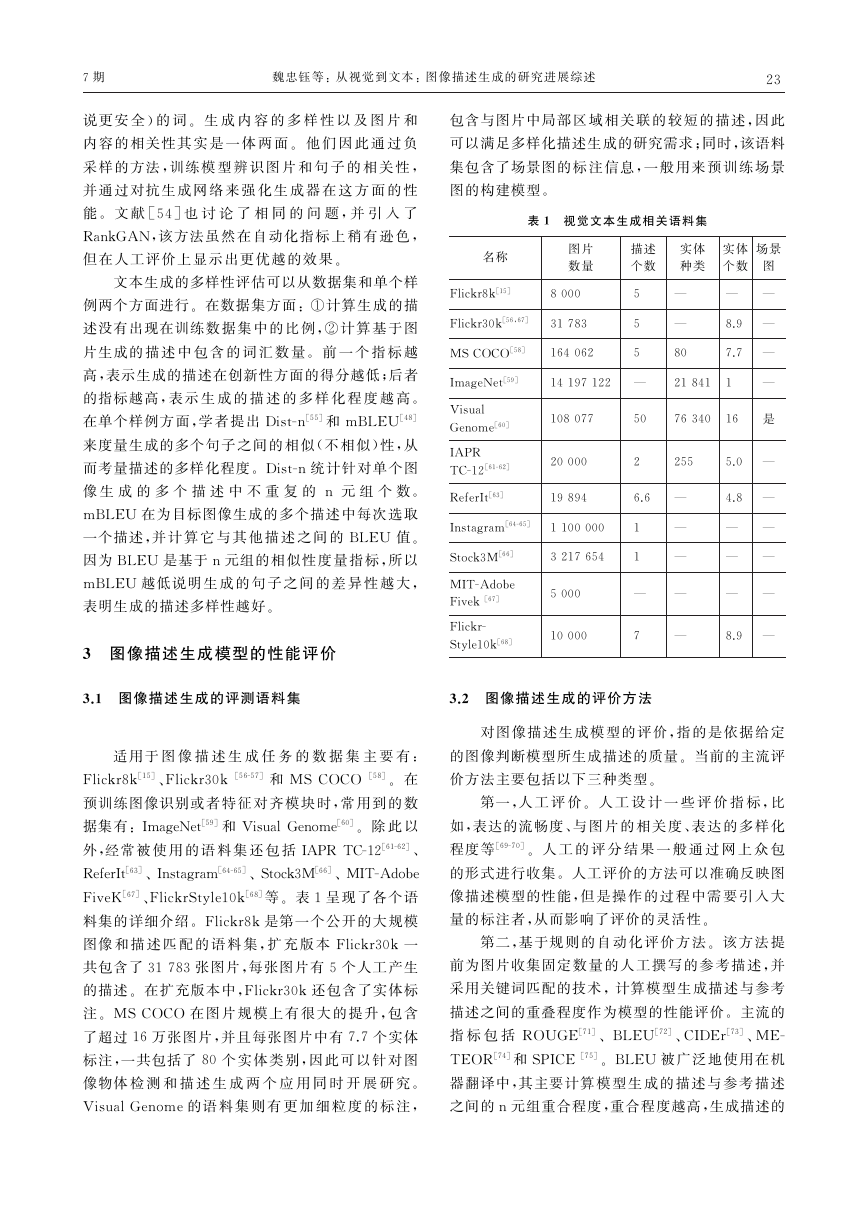

3.1 图像描述生成的评测语料集

适用于 图 像 描 述 生 成 任 务 的 数 据 集 主 要 有:

Flickr8k[15]、Flickr30k [56-57] 和 MSCOCO [58]。 在

预训练图像识别或 者 特 征 对 齐 模 块 时,常 用 到 的 数

据集 有:ImageNet[59]和 VisualGenome[60]。除 此 以

外,经常 被 使 用 的 语 料 集 还 包 括IAPRTC-12[61-62]、

ReferIt[63]、Instagram[64-65]、Stock3M[66]、MIT-Adobe

FiveK[67]、FlickrStyle10k[68]等。表1呈现了各个语

料集的详细介绍。Flickr8k是第一个公开的大规模

图像 和 描 述 匹 配 的 语 料 集,扩 充 版 本 Flickr30k 一

共包含了31783张图片,每张图片有5个人工产生

的描述。在扩充版本中,Flickr30k还包含了实体标

注。MSCOCO 在 图 片 规 模 上 有 很 大 的 提 升,包 含

了超过16万张图片,并且每张图片中有7.7个实体

标注,一共包括了80 个 实 体 类 别,因 此 可 以 针 对 图

像物体 检 测 和 描 述 生 成 两 个 应 用 同 时 开 展 研 究。

VisualGenome的语 料 集 则 有 更 加 细 粒 度 的 标 注,

32

包含与图片中局部 区 域 相 关 联 的 较 短 的 描 述,因 此

可以满足多样化描述生成的研究需求;同时,该语料

集包含了场景图的 标 注 信 息,一 般 用 来 预 训 练 场 景

图的构建模型。

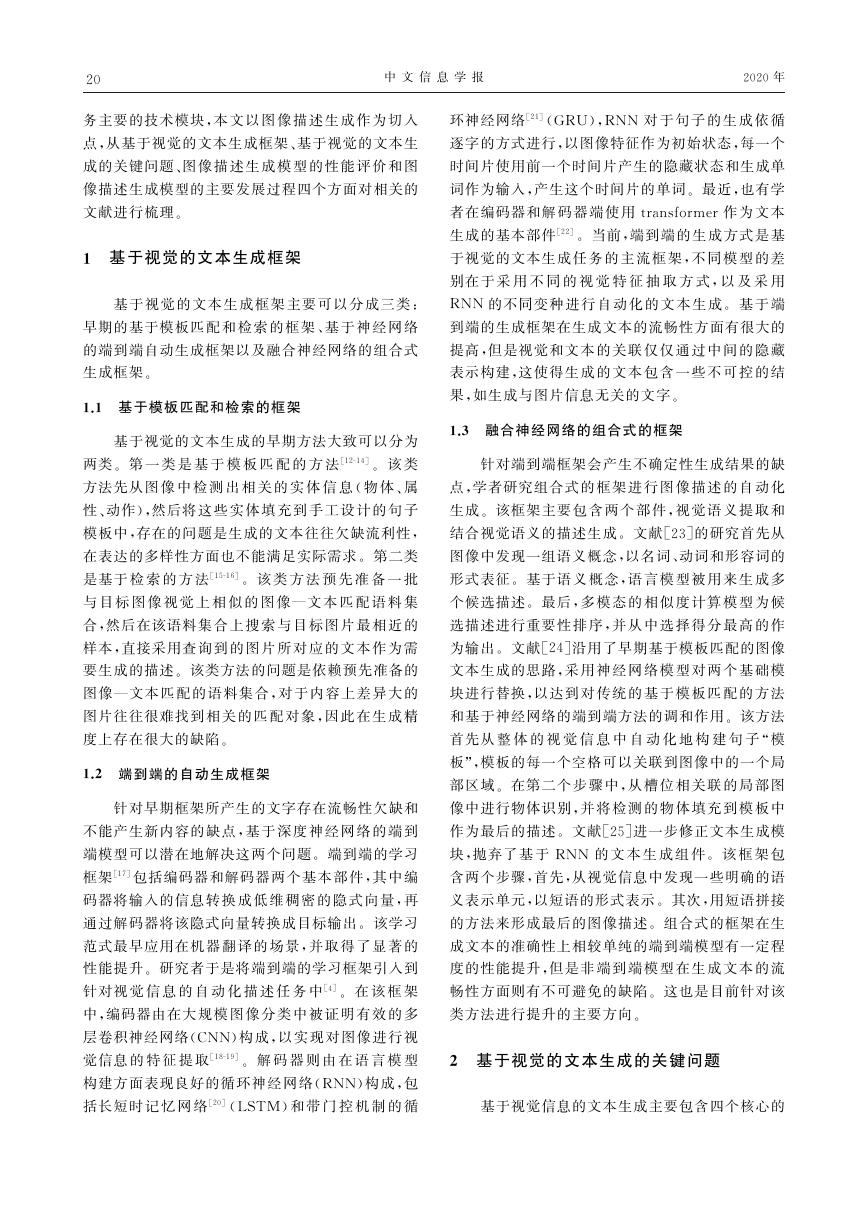

表1 视觉文本生成相关语料集

名称

图片

数量

描述

个数

实体

种类

实体

个数

场景

图

5

5

5

14197122 —

108077

8000

Flickr8k[15]

Flickr30k[56,67] 31783

MSCOCO[58] 164062

ImageNet[59]

Visual

Genome[60]

IAPR

TC-12[61-62]

ReferIt[63]

Instagram[64-65] 1100000 1

3217654 1

Stock3M[66]

MIT-Adobe

—

5000

Fivek [67]

Flickr-

Style10k[68]

—

—

80

21841 1

—

—

8.9 —

7.7 —

—

50 76340 16 是

5.0 —

4.8 —

—

—

—

—

—

—

8.9 —

255

2

6.6 —

—

—

—

20000

19894

10000

7

—

3.2 图像描述生成的评价方法

对图像描述生成模型的评价,指的是依据给定

的图像判断模型所生成描述的质量。当前的主流评

价方法主要包括以下三种类型。

第一,人 工 评 价。 人 工 设 计 一 些 评 价 指 标,比

如,表达的流畅度、与 图 片 的 相 关 度、表 达 的 多 样 化

程度等[69-70]。 人 工 的 评 分 结 果 一 般 通 过 网 上 众 包

的形式进行收集。人工评价的方法可以准确反映图

像描述模型的性能,但 是 操 作 的 过 程 中 需 要 引 入 大

量的标注者,从而影响了评价的灵活性。

第二,基于规 则 的 自 动 化 评 价 方 法。该 方 法 提

前为图片收集固定 数 量 的 人 工 撰 写 的 参 考 描 述,并

采用关键词匹配的技术,计算模型生成描述与参考

描述之间的重叠程度作为模型的性能评价。主流的

指 标 包 括 ROUGE[71]、BLEU[72]、CIDEr[73]、ME-

TEOR[74]和SPICE [75]。BLEU 被广泛地使用在机

器翻译中,其主要计 算 模 型 生 成 的 描 述 与 参 考 描 述

之间的n元组重合程度,重合程度越高,生成描述的

�

中 文 信 息 学 报

2020年

参考描述之间的相关度。基于学习的自动化评价虽

然增加了灵活性,但是评价模型本身是参数化的,因

此也有被图像描述模型攻击和欺骗的风险。

4 图像描述生成模型的主要发展过程

42

质量就越高。不同元组的选择可以从不同的侧面反

映生成描述的 质 量,单 元 组(uni-gram)的 准 确 率 可

以用于评估单词级 别 的 生 成 准 确 性,更 高 阶 的 元 组

准确率可以用来判断句子的整体流畅性。该指标更

关注生成的准 确 率,即 更 关 心 生 成 描 述 里 有 多 少n

元组是对的。ROUGE[71]最早被用来评价文本摘要

模型的质量,它 与 BLEU 的 计 算 公 式 非 常 相 似,但

它只计算召回率,考 虑 参 考 描 述 中 有 多 少 元 组 被 机

器生成的描述覆盖。为了在评价过程中考虑相同语

义不同 表 达 的 句 子,学 者 提 出 了 METEOR [74],它

引入一个外部资源库(WordNet)对词语的同义词进

行考虑,同时也考虑单词的词形 (stemming)。在评

价句子流 畅 性 时,用 词 块(chunk)作 为 基 本 评 价 单

元,考虑了调和召回率和准确率的F 值作为最终评

价指 标。 相 比 BLEU 和 ROUGE,METEOR 引 入

了外部资源和额外 的 句 子 分 块 算 法,这 也 给 其 评 价

结果带 来 一 些 不 稳 定 性。CIDEr[73]是 针 对 图 像 描

述任务提出的,它同样采用n 元 组 作 为 基 本 评 价 单

元,并采用词频和倒排文档频率(TF-IDF)作为n元

组的权重,这样可以降低高 频n 元 组 对 于 结 果 的 影

响。最近,学者提出SPICE[75]来考察图像中的实体

和实体间关系是否被图像描述生成模型考虑。该指

标为机器生成描述 构 建 场 景 图,并 与 基 于 图 像 构 建

的场景图进行相关 性 计 算,从 而 达 到 衡 量 生 成 描 述

目的。

对于图像 中 包 含 的 实 体 和 实 体 间 关 系 的 覆 盖 度 的

建一个机器学习模型直接计算图像描述生成模型产

第三,基于学 习 的 自 动 化 评 价 方 法。该 方 法 构

生的描述和给定图片之间的相关度。文献[76]引入

对抗生成的方法,训练一个判别器,在给定图片和一

个候选描述的情况 下,判 定 有 多 大 概 率 这 个 候 选 描

述是人工产 生 的,分 数 越 高 则 该 描 述 的 质 量 越 高。

在训练过程中,他们 自 动 化 地 为 给 定 图 片 产 生 一 些

不相关的描述作 为 负 样 本,用 以 训 练 判 别 器。文 献

[77]结合了基于学习 和 规 则 的 方 法,综 合 考 量 机 器

生成的描述与图片 的 相 关 度,以 及 机 器 生 成 的 描 述

与参考描述的相关度。在生成描述与图片相关度方

面,他们采用预训练的视觉和文本的对齐模块,计算

机器生成的描述与 图 片 区 域 之 间 的 关 联 分 布 向 量。

分布向量的集中 度 越 高,则 相 关 度 越 高。在 生 成 描

述与参考描述的相 关 度 计 算 方 面,他 们 通 过 图 片 区

域将二者进行关联,从 而 细 粒 度 地 评 价 生 成 描 述 和

像 特 征 和 语 言 特 征 方 面 对 图 像 标 注 进 行 改

研 究 工 作 主 要 集 中 于 通 过 基 于 卷 积 神 经 网 络

标作为优化目标已经成为目前图像描述生成工作中

近年来,基于神经网络的端到端模型作为主流

的图像描述生成模 型,在 公 开 评 测 语 料 集 上 不 断 刷

新各种评测指标的记录。因此,在本节中,我们主要

针对这一类别的方法进行发展进程的介绍。早期的

(CNN)和循环 神 经 网 络(RNN)的 基 础 端 到 端 框 架

来生 成 图 像 描 述[4-5,23,78-79];随 后,针 对 多 模 态 特 征

对齐问题,研究人员提出了不同的注意力机制,从图

进[31-32,34-35,46,80-82];同时,不 同 于 使 用 交 叉 熵 作 为 优

化目标的方法,一些研究人员采用强化学习方法,将

自动评价指标(一般选用CIDEr或 METEOR)作为

优化目标 来 训 练 模 型[16,32,35,46,81-84]。将 自 动 评 价 指

主流的实验设置。最近一些研究工作通过目标检测

算法(如FasterR-CNN)提取图像中的物体区域,来

引 入 更 为 丰 富 多 样 的 信 息,如 物 体、属 性 和 关 系

等[24,32,35]。随着预训练语言模型在自然语言处理领

域的兴起,也出 现 了 跨 模 态 预 训 练 模 型 的 工 作。比

如,Zhou等人[85]提 出 了 一 种 视 觉—语 言 预 训 练 模

型,可以应用到视觉—文本生成和理解任务当中;此

外,最近也出现了一 些 从 其 他 方 面 进 行 探 究 的 开 创

性工作:Feng等人[86]使用了视觉概念(concept)作

为连接图像和文本 的 桥 梁,将 无 监 督 学 习 应 用 到 图

片标注任务当中;Sammani等人[84]提出了一种自适

应“编辑”网络,可以对生成的描述进行迭代地润色。

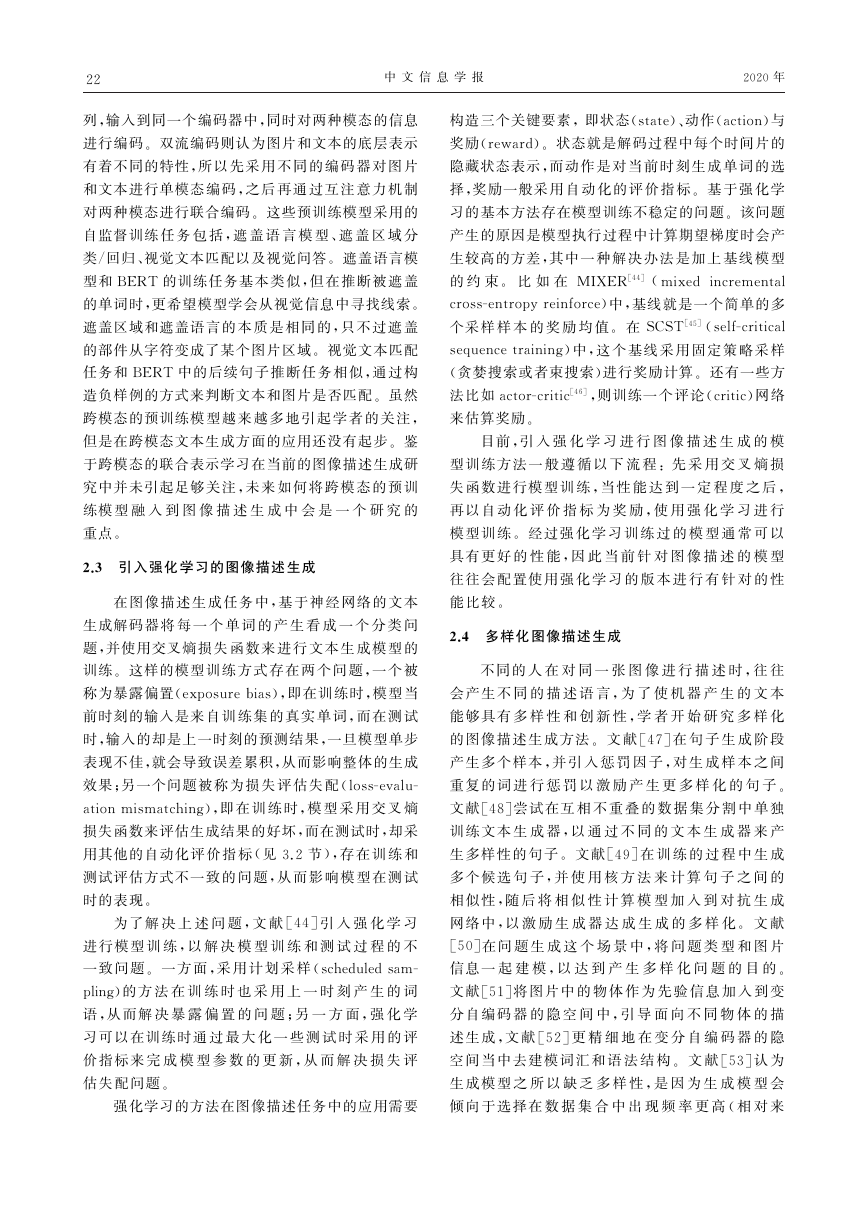

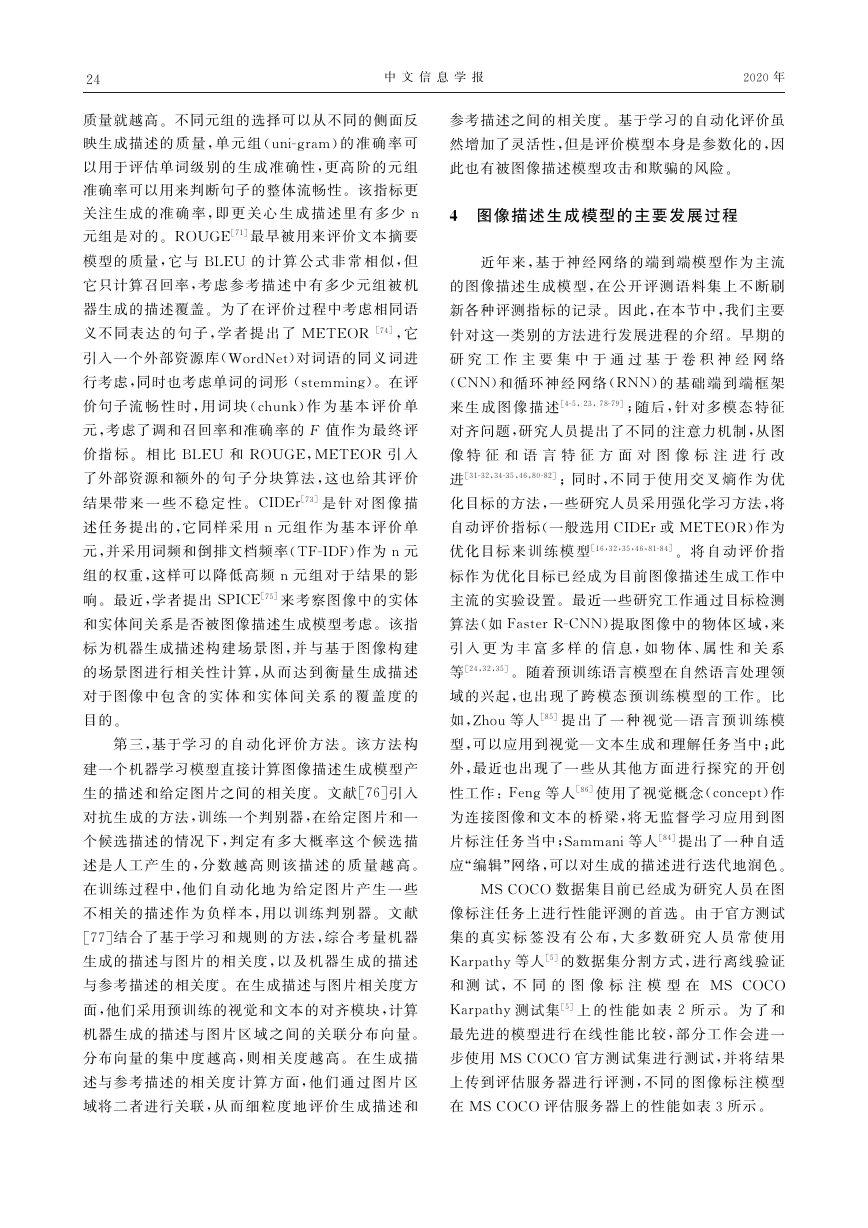

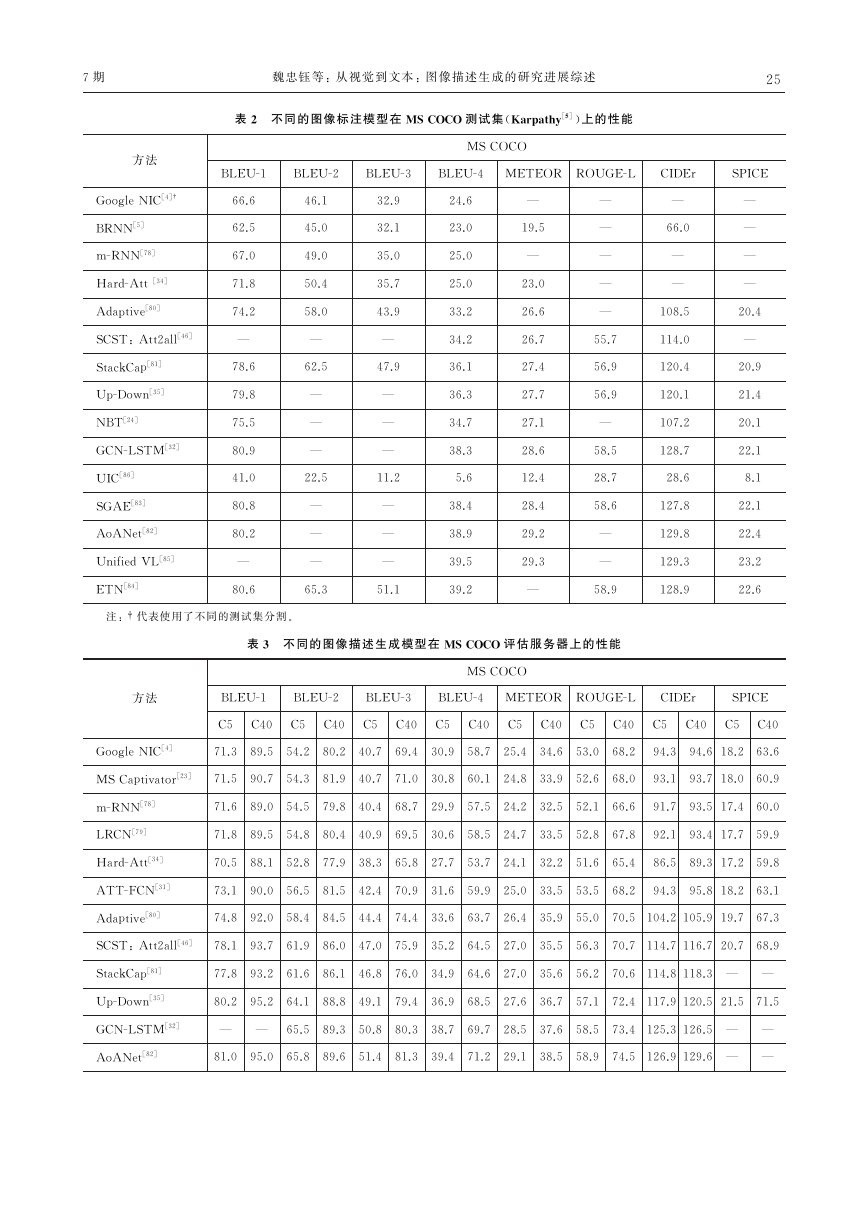

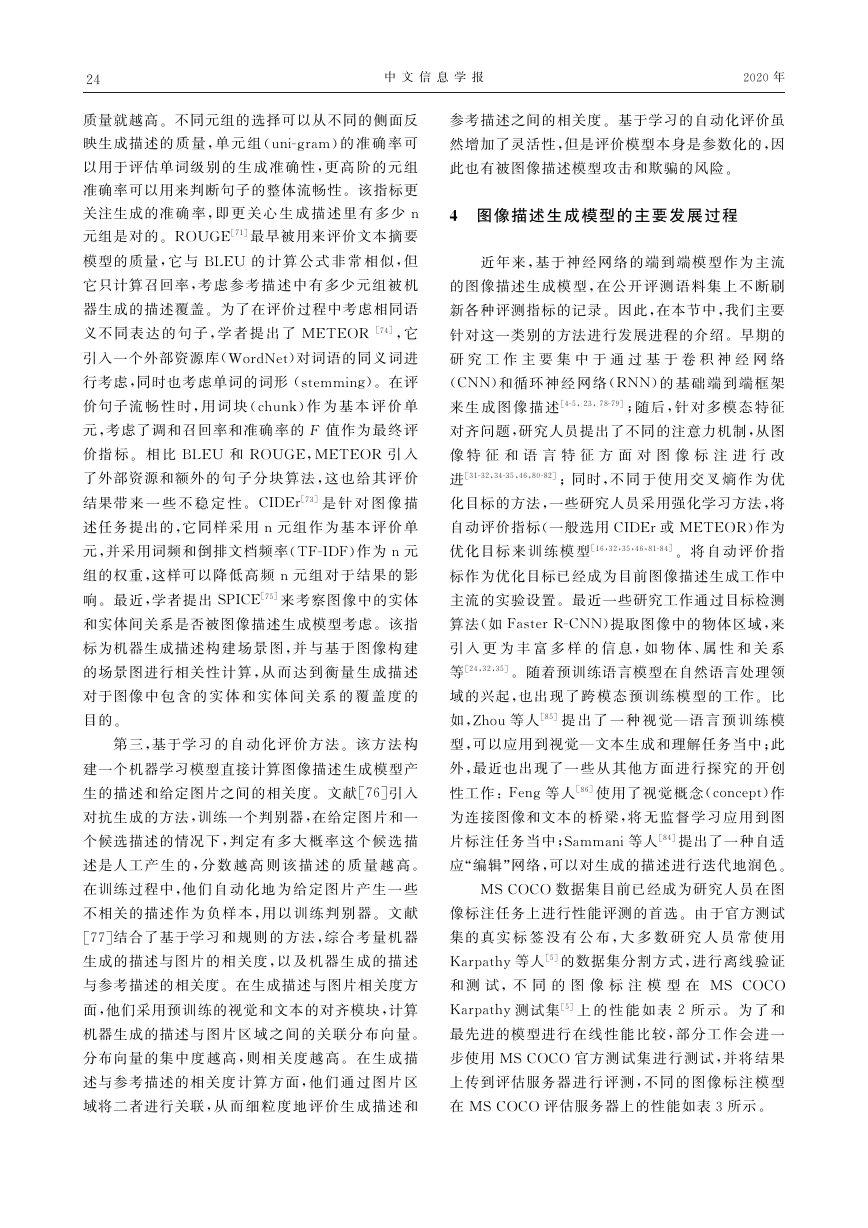

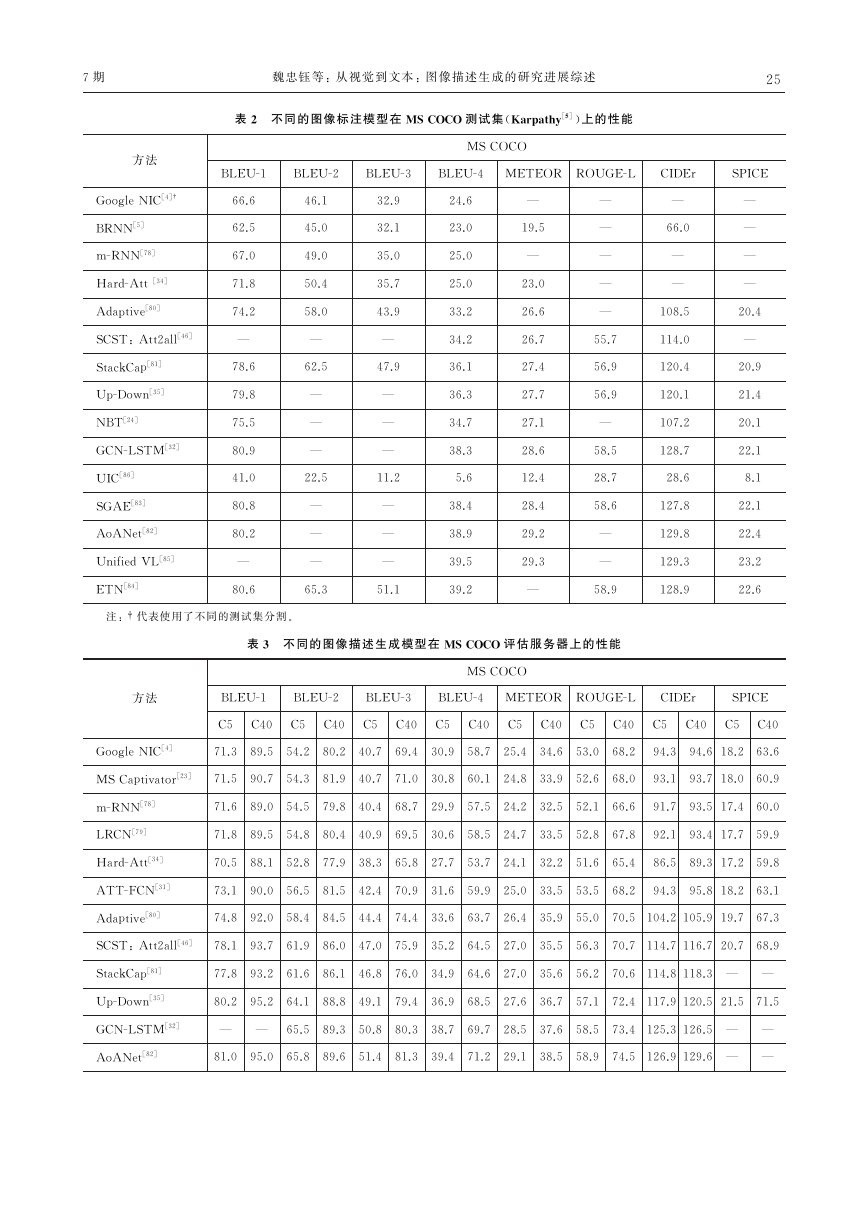

MSCOCO 数据集目前已经成为研究人员在图

像标注任务上进行性能评测的首选。由于官方测试

集的真 实 标 签 没 有 公 布,大 多 数 研 究 人 员 常 使 用

Karpathy等人[5]的数据集分割方式,进行离线验证

和 测 试,不 同 的 图 像 标 注 模 型 在 MS COCO

Karpathy测试集[5]上 的 性 能 如 表2 所 示。 为 了 和

最先进的模型进行 在 线 性 能 比 较,部 分 工 作 会 进 一

步使用 MSCOCO 官方测试集进行测试,并 将 结 果

上传到评估服务器 进 行 评 测,不 同 的 图 像 标 注 模 型

在 MSCOCO 评估服务器上的性能如表3所示。

�

7期

魏忠钰等:从视觉到文本:图像描述生成的研究进展综述

52

表2 不同的图像标注模型在 MSCOCO 测试集(Karpathy[5])上的性能

MSCOCO

方法

BLEU-1 BLEU-2 BLEU-3 BLEU-4 METEOR ROUGE-L CIDEr

66.6

62.5

67.0

71.8

74.2

—

78.6

79.8

75.5

80.9

41.0

80.8

80.2

—

80.6

GoogleNIC[4]†

BRNN[5]

m-RNN[78]

Hard-Att[34]

Adaptive[80]

SCST:Att2all[46]

StackCap[81]

Up-Down[35]

NBT[24]

GCN-LSTM[32]

UIC[86]

SGAE[83]

AoANet[82]

UnifiedVL[85]

ETN[84]

注:† 代表使用了不同的测试集分割。

—

66.0

—

—

108.5

114.0

120.4

120.1

107.2

128.7

28.6

127.8

129.8

129.3

128.9

—

—

—

—

—

55.7

56.9

56.9

—

58.5

28.7

58.6

—

—

58.9

—

19.5

—

23.0

26.6

26.7

27.4

27.7

27.1

28.6

12.4

28.4

29.2

29.3

—

46.1

45.0

49.0

50.4

58.0

—

62.5

—

—

—

22.5

—

—

—

65.3

32.9

32.1

35.0

35.7

43.9

—

47.9

—

—

—

11.2

—

—

—

51.1

24.6

23.0

25.0

25.0

33.2

34.2

36.1

36.3

34.7

38.3

5.6

38.4

38.9

39.5

39.2

SPICE

—

—

—

—

20.4

—

20.9

21.4

20.1

22.1

8.1

22.1

22.4

23.2

22.6

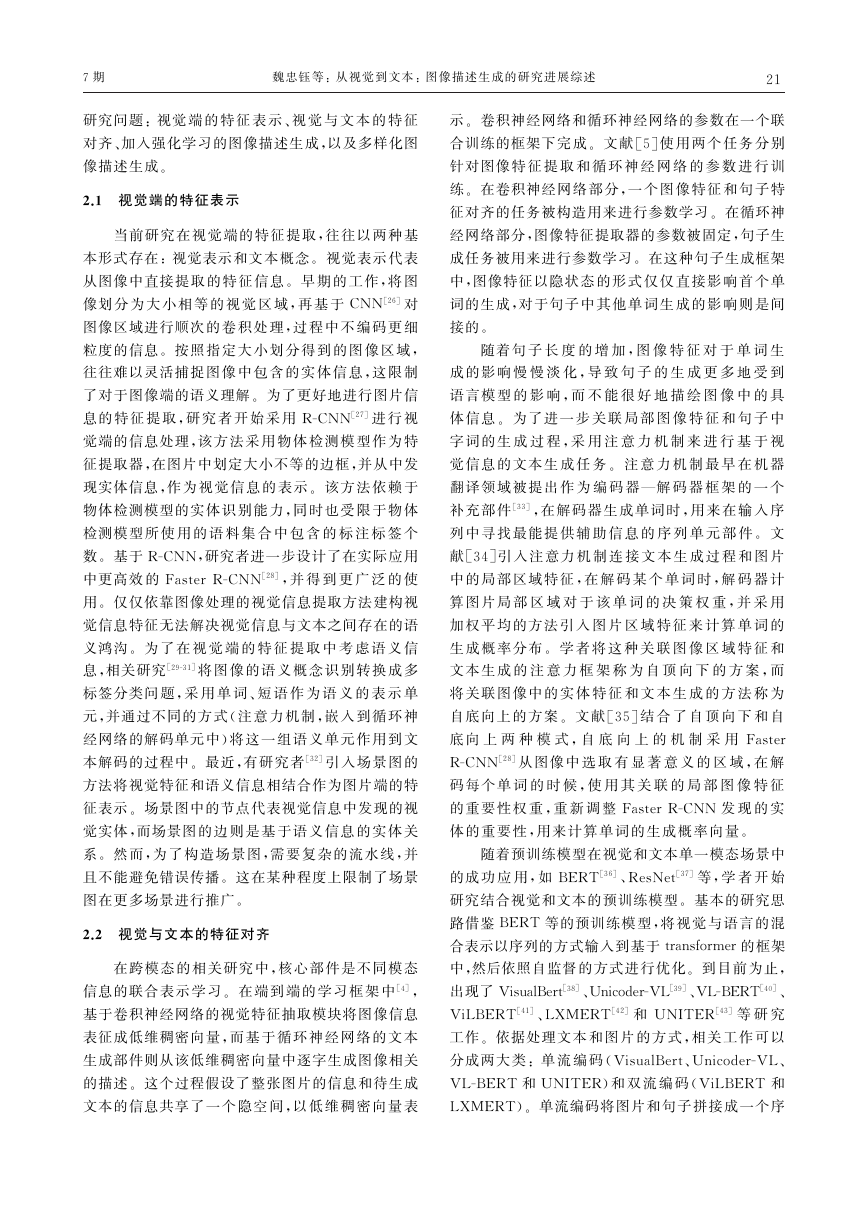

表3 不同的图像描述生成模型在 MSCOCO 评估服务器上的性能

MSCOCO

方法

BLEU-1 BLEU-2 BLEU-3 BLEU-4 METEOR ROUGE-L CIDEr

SPICE

C5 C40 C5 C40 C5 C40 C5 C40 C5 C40 C5 C40 C5 C40 C5 C40

71.3 89.5 54.2 80.2 40.7 69.4 30.9 58.7 25.4 34.6 53.0 68.2 94.3 94.618.2 63.6

GoogleNIC[4]

MSCaptivator[23] 71.5 90.7 54.3 81.9 40.7 71.0 30.8 60.1 24.8 33.9 52.6 68.0 93.1 93.718.0 60.9

71.6 89.0 54.5 79.8 40.4 68.7 29.9 57.5 24.2 32.5 52.1 66.6 91.7 93.517.4 60.0

m-RNN[78]

71.8 89.5 54.8 80.4 40.9 69.5 30.6 58.5 24.7 33.5 52.8 67.8 92.1 93.417.7 59.9

LRCN[79]

70.5 88.1 52.8 77.9 38.3 65.8 27.7 53.7 24.1 32.2 51.6 65.4 86.5 89.317.2 59.8

Hard-Att[34]

73.1 90.0 56.5 81.5 42.4 70.9 31.6 59.9 25.0 33.5 53.5 68.2 94.3 95.818.2 63.1

ATT-FCN[31]

74.8 92.0 58.4 84.5 44.4 74.4 33.6 63.7 26.4 35.9 55.0 70.5 104.2105.919.7 67.3

Adaptive[80]

SCST:Att2all[46] 78.1 93.7 61.9 86.0 47.0 75.9 35.2 64.5 27.0 35.5 56.3 70.7 114.7116.720.7 68.9

77.8 93.2 61.6 86.1 46.8 76.0 34.9 64.6 27.0 35.6 56.2 70.6 114.8118.3 — —

StackCap[81]

80.2 95.2 64.1 88.8 49.1 79.4 36.9 68.5 27.6 36.7 57.1 72.4 117.9120.521.5 71.5

Up-Down[35]

—

— 65.5 89.3 50.8 80.3 38.7 69.7 28.5 37.6 58.5 73.4 125.3126.5 — —

GCN-LSTM[32]

81.0 95.0 65.8 89.6 51.4 81.3 39.4 71.2 29.1 38.5 58.9 74.5 126.9129.6 — —

AoANet[82]

�

62

5 结论

中 文 信 息 学 报

本文回顾了近年来研究领域在图像描述生成模

于图像的自动化描述离实际应用依然存在不小的差

型方面的研究进展。虽然相关研究在自动化评价指

标方面有长足发展,但受限于真实场景的复杂性,对

距。以下三个方面 或 许 是 未 来 的 研 究 重 点,包 括 基

于跨模态预训练模 型 的 图 像 描 述 生 成 框 架 研 究、基

于视觉的文本生成 评 价 方 法、面 向 应 用 的 多 样 化 文

本生成框架研究。

参考文献

[1] HeX,DengL.Deeplearningforimage-to-textgenera-

tion:Atechnicaloverview[J].IEEESignalProcessing

Magazine,2017,34(6):109-116.

[2] HossainMZ,SohelF,ShiratuddinMF,etal.Acom-

prehensivesurveyofdeeplearningforimagecaptioning

[J].ACMComputingSurveys,2019,51(6):1-36.

[3] ZhangC,YangZ,HeX,etal.Multimodalintelli-

gence:Representationlearning,informationfusion,

andapplications[C]//ProceedingsofIEEEJournalof

SelectedTopicsinSignalProcessing,2020.

[4] VinyalsO,ToshevA,BengioS,etal.Showandtell:

Aneuralimagecaptiongenerator[C]//Proceedingsof

theIEEEConferenceonComputerVisionandPattern

Recognition,2015:3156-3164.

[5] KarpathyA,Fei-FeiL.Deepvisual-semanticalign-

mentsforgeneratingimagedescripttions[C]//Pro-

ceedingsoftheIEEEConferenceonComputerVision

andPatternRecognition,2015:3128-3137.

[6] AntolS,AgrawalA,LuJ,etal.Vqa:visualquestion

answering[C]//ProceedingsoftheInternationalCon-

ferenceonComputerVision,2015:2425-2433.

[7] Ting-HaoHuang,FerraroF,etal.Visualstorytelling

[C]//Proceedingsofthe2016ConferenceoftheNorth

AmericanChapteroftheAssociationforComputation-

alLinguistics:HumanLanguageTechnologies,2016:

1233-1239.

[8] DasA,KotturS,GuptaK,etal.Visualdialog[C]//

ProceedingsoftheIEEEConferenceonComputerVi-

sionandPatternRecognition,2017:326-335.

[9] JohnsonJ,HariharanB,vander MaatenL,etal.

Clevr:Adiagnosticdatasetforcompositionallanguage

andelementaryvisualreasoning[C]//Proceedingsof

theIEEEConferenceonComputerVisionandPattern

Recognition,2017:2901-2910.

[10] ZhuY,MottaghiR,KolveE,etal.Target-driven

2020年

visualnavigationinindoorscenesusingdeeprein-

forcementlearning[C]//Proceedings ofthe2017

IEEEInternationalConferenceonRoboticsandAuto-

mation,2017:3357-3364.

[11] ReedS,AkataZ,YanX,etal.Generativeadversari-

altexttoimagesynthesis[J].arXivpreprint:1605.

05396,2016.

[12] FarhadiA,HejratiM,SadeghiM A,etal.Every

picturetellsastory:Generatingsentencesfromima-

ges[C]//ProceedingsoftheEuropeanConferenceon

Computer Vision.Springer.Berlin. Heidelberg,

2010:15-29.

[13] KulkarniG,PremrajV,OrdonezV,etal.Babytalk:

Understandingandgeneratingsimpleimagedescrip-

tions[J].IEEETransactionsonPatternAnalysisand

MachineIntelligence,2013,35(12):2891-2903.

[14] LiS,KulkarniG,BergTL,etal.Composingsimple

imagedescriptionsusing web-scalen-grams[C]//

Proceedingsofthe15thConferenceonComputational

NaturalLanguageLearning.AssociationforCompu-

tationalLinguistics,2011:220-228.

[15] HodoshM,YoungP,HockenmaierJ.Framingim-

agedescriptionasarankingtask:data,modelsande-

valuationmetrics[J].JournalofArtificialIntelligence

Research,2013,47(1):853-899.

[16] OrdonezV,KulkarniG,BergTL.Im2text:Descri-

bingimagesusing1 millioncaptionedphotographs

[C]//ProceedingsoftheAdvancesinNeuralInfor-

mationProcessingSystems,2011:1143-1151.

[17] SutskeverI,VinyalsO,LeQ V.Sequencetose-

quencelearningwithneuralnetworks[C]//Proceed-

ingsoftheAdvancesinNeuralInformationProcess-

ingSystems,2014:3104-3112.

[18] KrizhevskyA,SutskeverI,HintonGE.Imagenet

classificationwithdeepconvolutionalneuralnetworks

[C]//ProceedingsoftheAdvancesinNeuralInfor-

mationProcessingSystems,2012:1097-1105.

[19] HeK,ZhangX,RenS,etal.Deepresiduallearning

forimagerecognition[C]//ProceedingsoftheIEEE

ConferenceonComputerVisionandPatternRecogni-

tion,2016:770-778.

[20] HochreiterS,SchmidhuberJ.Longshort-termmem-

ory[J].NeuralComputation,1997,9(8):1735-

1780.

[21] ChungJ,GulcehreC,ChoK,etal.Gatedfeedback

recurrentneuralnetworks[C]//ProceedingsoftheIn-

ternationalConferenceon MachineLearning,2015:

2067-2075.

[22] HerdadeS,KappelerA,BoakyeK,etal.Imagecap-

tioning:Transformingobjectsintowords[C]//Pro-

ceedingsoftheAdvancesinNeuralInformationPro-

�

2023年江西萍乡中考道德与法治真题及答案.doc

2023年江西萍乡中考道德与法治真题及答案.doc 2012年重庆南川中考生物真题及答案.doc

2012年重庆南川中考生物真题及答案.doc 2013年江西师范大学地理学综合及文艺理论基础考研真题.doc

2013年江西师范大学地理学综合及文艺理论基础考研真题.doc 2020年四川甘孜小升初语文真题及答案I卷.doc

2020年四川甘孜小升初语文真题及答案I卷.doc 2020年注册岩土工程师专业基础考试真题及答案.doc

2020年注册岩土工程师专业基础考试真题及答案.doc 2023-2024学年福建省厦门市九年级上学期数学月考试题及答案.doc

2023-2024学年福建省厦门市九年级上学期数学月考试题及答案.doc 2021-2022学年辽宁省沈阳市大东区九年级上学期语文期末试题及答案.doc

2021-2022学年辽宁省沈阳市大东区九年级上学期语文期末试题及答案.doc 2022-2023学年北京东城区初三第一学期物理期末试卷及答案.doc

2022-2023学年北京东城区初三第一学期物理期末试卷及答案.doc 2018上半年江西教师资格初中地理学科知识与教学能力真题及答案.doc

2018上半年江西教师资格初中地理学科知识与教学能力真题及答案.doc 2012年河北国家公务员申论考试真题及答案-省级.doc

2012年河北国家公务员申论考试真题及答案-省级.doc 2020-2021学年江苏省扬州市江都区邵樊片九年级上学期数学第一次质量检测试题及答案.doc

2020-2021学年江苏省扬州市江都区邵樊片九年级上学期数学第一次质量检测试题及答案.doc 2022下半年黑龙江教师资格证中学综合素质真题及答案.doc

2022下半年黑龙江教师资格证中学综合素质真题及答案.doc