2020 届本科毕业设计(论文)外文

文献翻译

学

专

姓

学

院:

业:

名:

号:

外文出处: 《Large-Scale Interactive Recommendation with

(用外文写)

Tree-Structured Policy Gradient》Haokun Chen,1 Xinyi Dai,1 Han Cai,1

Weinan Zhang,1Xuejian Wang,1 Ruiming Tang,2 Yuzhou Zhang,2 Yong

Yu1 1Shanghai Jiao Tong University

附

件: 1.外文资料翻译译文;2.外文原文。

指导教师评语:

评阅结果:

。

签名:

年

月

日

1

�

附件 1:外文资料翻译译文

具有树状结构策略梯度的大规模交互式推荐

摘要

强化学习(RL)最近已被引入交互式推荐系统(IRS),因为它具有从动态交互中学

习和规划长期性能的特性。由于 IRS 总是要推荐数千个项目(即数千个动作),因此,大

多数现有的基于 RL 的方法无法处理如此大的离散动作空间问题,因此效率低下。试图通

过使用深度确定性策略梯度框架来解决大型离散动作空间问题的现有工作遭受了连续动

作表示(参与者网络的输出)与实际离散动作之间的矛盾。为了避免这种不一致并实现高

效率和推荐效果,在本文中,我们提出了一种树状结构的政策梯度建议(TPGR)框架,其

中在项目之上构建了一个平衡的层次聚类树,并选择了一个项目作为寻找项目。从根到树

的某个叶子的路径。在基于两个真实世界数据集的精心设计的环境中进行的大量实验表明,

我们的模型与最新方法相比,具有出色的推荐性能和显着的效率提升。

引言

交互式推荐系统(IRS)(Zhao,Zhang 和 Wang,2013 年)在大多数个性化服务(例

如 Pandora,Musical.ly 和 YouTube 等)中起着关键作用。与传统推荐设置不同(Mooneyand

Roy 2000; Koren,Bell 和 Volinsky 2009),其中推荐过程被视为静态过程,因此 IRS

会连续向单个用户推荐商品并接收他们的反馈,这使得在此类互动过程中可以完善其推荐

政策。

为了处理互动性,通过将推荐过程建模为多臂匪徒(MAB)问题,已经做出了一些努

力(Li 等,2010; Zhao,Zhang 和 Wang,2013)。 但是,这些工作假设在推荐过程中基

本的用户偏好保持不变(Zhao,Zhang 和 Wang,2013 年),并且没有明确计划长期性能。

最近,强化学习(RL)(Sutton and Barto 1998),在需要动态互动和长期计划(例

如玩游戏)的各种挑战性场景中取得了显著成功(Mnih 等人,2015; Silver 等人,2016)。

引入和规范广告竞标(Cai 等人 2017; Jin 等人 2018),以对推荐过程进行建模,并显示

其在 IRS 中处理互动性质的潜力(Zheng 等人 2018; Zhao 等人 2018b; 2018a)。

但是,大多数现有的 RL 技术无法处理 IRS 中的大型离散动作空间问题,因为决策的

时间复杂度与动作空间的大小呈线性关系。具体而言,所有基于深度 Q 网络(DQN)的方

法(Zheng 等,2018; Zhao 等,2018b)都涉及对操作空间进行最大化操作以做出决策,

2

�

当操作空间大小变大时,该操作变得棘手,也就是说,可用项目的数量很大(Dulac-Arnold

等人,2015 年),这在 IRS 中非常普遍。大多数基于深度确定性策略梯度(DDPG)的方法

(Zhao 等人,2018a; Hu 等人,2018)也遇到相同的问题,因为对所有项目都应用了特定

的排名功能,以在做出决策时选择得分最高的项目。为了减少时间复杂度,Dulac-Arnold

等人。 (2015 年)建议选择一个连续隐藏空间中的原型动作,然后通过最近邻居方法选

择有效项。但是,这种方法会遭受学习的连续动作与实际所需的离散动作之间的不一致,

从而可能导致结果不令人满意(Tavakoli,Pardo 和 Kormushev 2018)。

在本文中,我们提出了一个树结构化的政策梯度建议(TPGR)框架,该框架同时实现

了高效率和高效率。 在 TPGR 框架中,在项目之上构建了一个平衡的层次聚类树,从而制

定了一个选择项目,以寻求从树的根到特定叶子的路径,这大大降低了训练和决策的时间

复杂性 制作阶段。 我们利用政策梯度技术(Sutton 等人,2000 年)来学习如何制定推

荐决策,从而最大化长期奖励。 据我们所知,这是为大型交互式推荐构建树型随机策略

的第一项工作。

此外,为证明使用公开的离线数据集提出的方法的合理性,我们构建了一个环境模拟

器,以根据从真实数据中得出的原理模拟在线环境。 在两个具有不同设置的现实世界数

据集上的大量实验表明,与最新方法相比,拟议的 TPGR 的性能更高且效率得到了显着提

高。

IRS 的相关工作和背景高级推荐算法

用于 IRS 的高级推荐算法

基于 MBA 的推荐 一组工作(Li 等人 2010; Chapelle 和 Li 2011; Zhao,Zhang 和

Wang 2013; Zeng 等人 2016; Wang,Wu 和 Wang 2016)试图将交互式推荐建模为 MAB

问题。 Li 等人(2010 年)采用线性模型来估计每个手臂的上置信界(UCB)。 Chapelle and

Li(2011)利用汤普森采样技术解决了勘探与开发之间的权衡问题。 此外,一些研究人

员尝试将 MAB 与矩阵分解技术相结合(Zhao,Zhang 和 Wang 2013; Kawale 等人 2015; Wang,

Wu 和 Wang 2017)。

基于 RL 的推荐 基于 RL 的推荐方法(Tan,Lu 和 Li 2017; Zheng 等人 2018; Zhao

等人 2018b; 2018a)将推荐程序表述为马尔可夫决策过程(MDP),明确地模拟了动态用

户状态和 规划长期绩效。 赵等。 (2018b)将消极和积极反馈纳入 DQN 框架中(Mnih et

al。2015),并提出最大程度地提高目标和竞争对手产品之间的 Q 值差异。 郑等。(2018)

结合 DQN 和 Dueling Bandit Gradient Decent(DBGD)(Grotov and de Rijke 2016)进

3

�

行在线新闻推荐。 赵等。 (2018a)建议利用 DDPG 框架(Lillicrap et al。2015)和

页面显示方法进行页面推荐。

基于 RL 的推荐中的大型离散行动空间问题

对于具有较大离散动作空间的 IRS,大多数基于 RL 的模型效率低下,因为决策的时间

复杂度与动作空间的大小成线性关系。对于所有基于 DQN 的解决方案(Zhao et al.2018b;

Zheng et al.2018),学习了一个值函数 Q(s,a),用于估计在状态 s 采取行动 a 时预期

的折现累积奖励。 该政策的决定是:

如方程式(1)所示,为了做出决定,| A | (A 表示项目集)评估是必需的,这使

得对于行动空间大的任务的学习和利用都变得很棘手,这对于 IRS 很常见。

大多数基于 DDPG 的解决方案(Zhao 等,2018a; Hu 等,2018)中也存在类似的问题,

其中学习了一些排名参数,并对所有项目应用了特定的排名功能,以挑选得分最高的项目。

因此,针对这些方法的动作采样的复杂度也相对于| A |呈线性增长。

Dulac-Arnold 等。 (2015 年)尝试通过将每个离散动作映射到隐藏空间中的低维连

续向量,同时保持参与者网络在隐藏空间中生成连续向量 av 来解决基于 DDPG 框架的大型

离散动作空间问题。 后来映射到 av 的 k 个最近邻居中的特定有效动作 a。同时,使用通

过 执

网络。

行有效动作 a 收集的转换来学习价值网络 Q(s,a),并更新参与者

根据 DDPG 框架的 尽管这样的方法可以降低当 k 的值(即要查找的

最近邻居的数量)较小时从 O(| A |)到 O(log(| A |))进行决策的时间复杂度,但

是 不能保证以原始 DDPG 中的正确方向学习参与者网络。 原因是价值网络 Q(s,a)在

参与者网络 av 的输出上(在训练参与者网络时)和实际执行的动作 a(在价值网络上训

练时)可能有不同的行为。 此外,由于发现的邻居可能不是最接近的邻居,因此,所采

用的近似 k 最近邻居(KNN)方法也可能造成麻烦。

在本文中,我们提出了一种新颖的解决方案来解决大型离散动作空间问题。 我们没

有使用连续的隐藏空间,而是构建了一个平衡树来表示离散的动作空间,其中每个叶节点

都对应一个动作,并且自上而下的决策是从根到特定的叶节点进行的,从而减少了动作。

从 O(| A |)到 O(×||1)进行决策的时间复杂度,其中 d 表示树的深度。 由于这种

方法不涉及从连续空间到离散空间的映射,因此避免了参与者网络给定的连续向量与实际

执行的离散动作之间的间隙(Dulac-Arnold et al.2015 ),这可能导致错误的更新。

4

�

问题定义

拟议模型

我们使用 MDP 对推荐过程进行建模,其中关键组件定义如下。

State. 状态 s 被定义为用户和推荐系统之间的历史交互,可以通过循环神经网络

(RNN)将其编码为低维向量(请参见图 2)。

Action. 动作 a 是选择要推荐的项目,例如歌曲或视频等。

Reward. 在我们的公式中,所有与推荐系统互动的用户都形成了这样的环境:在

状态 s 收到动作 a 后,它会返回奖励 r,这反映了用户对推荐项目的反馈。

Transition. 由于状态是历史互动,因此,一旦推荐了新商品并给出了相应用户

的反馈,就可以确定状态转换。

上面定义的 MDP 中的一个情节对应于一个推荐过程,它是一系列用户状态,推荐动作

种情况下,序列从用户状态 s1 开始,然后在推荐系统执行推荐动作 a1 后,由指示用户对

和用户反馈的序列,例如(s1,a1,r1,s2,a2,r2,...,,,,+1)。 在这

状态+1处终止 i。 在不失一般性的前提下,我们将第 n 集的长度设置为固定数(Cai 等

推荐动作的反馈的环境给出的奖励 r1 转换为 s2。 当满足一些预定义的条件时,在特定

2017; Zhao 等 2018b)。

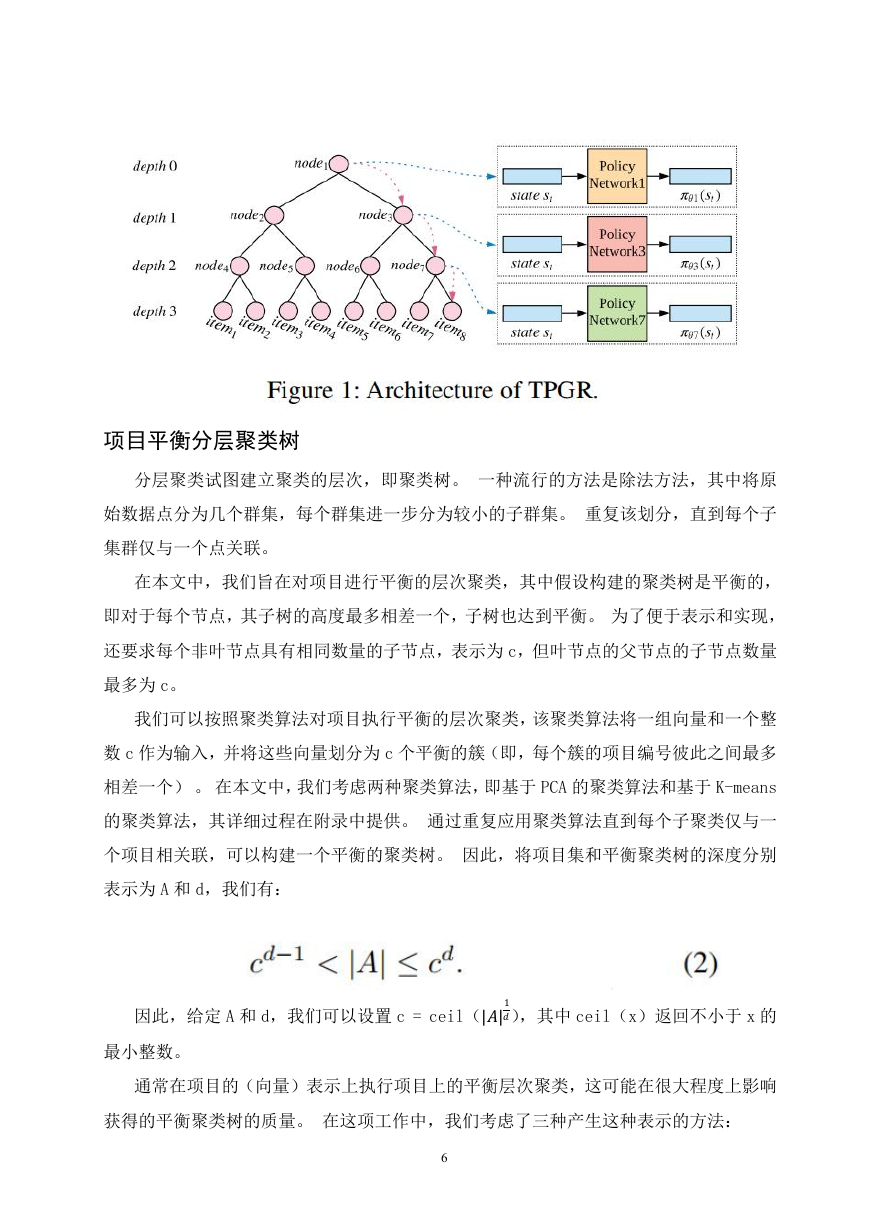

TPGR 的树形策略梯度推荐直觉

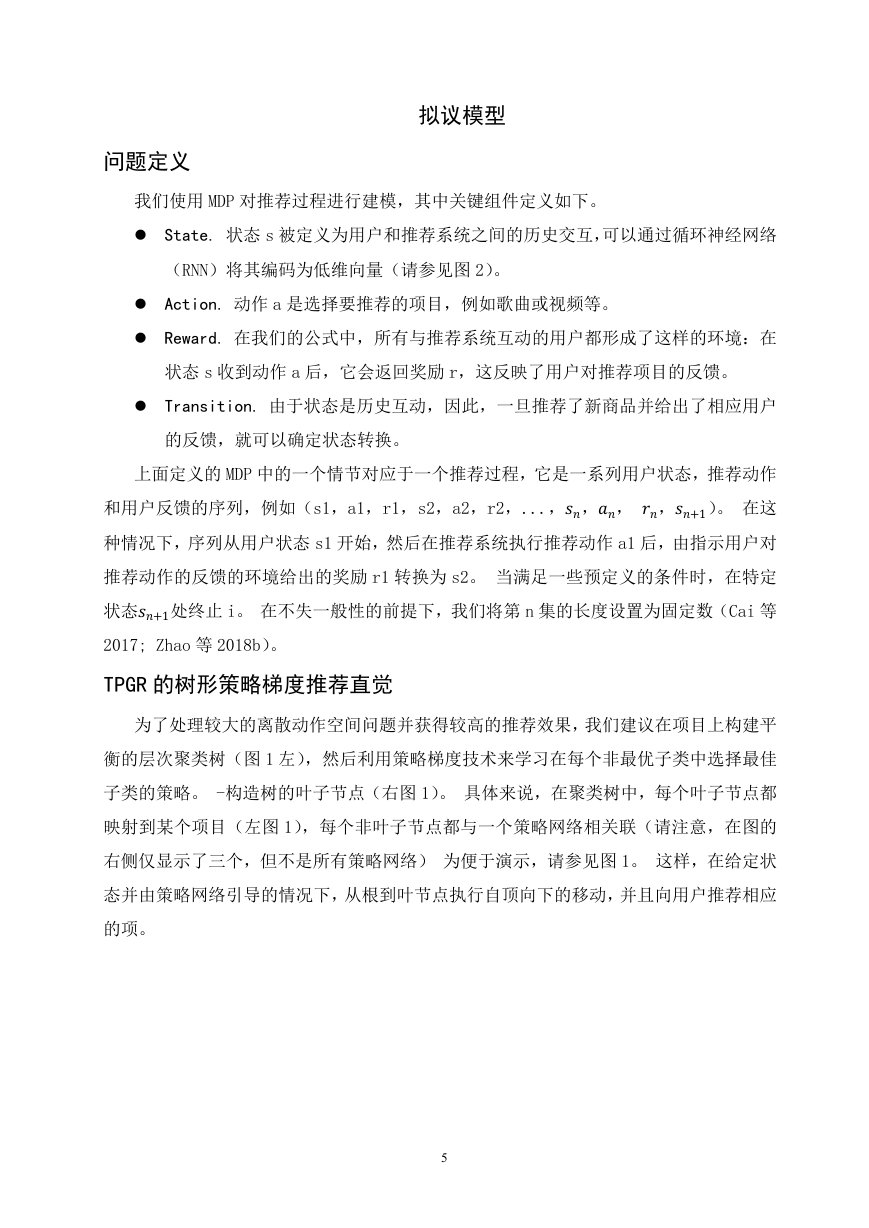

为了处理较大的离散动作空间问题并获得较高的推荐效果,我们建议在项目上构建平

衡的层次聚类树(图 1 左),然后利用策略梯度技术来学习在每个非最优子类中选择最佳

子类的策略。 -构造树的叶子节点(右图 1)。 具体来说,在聚类树中,每个叶子节点都

映射到某个项目(左图 1),每个非叶子节点都与一个策略网络相关联(请注意,在图的

右侧仅显示了三个,但不是所有策略网络) 为便于演示,请参见图 1。 这样,在给定状

态并由策略网络引导的情况下,从根到叶节点执行自顶向下的移动,并且向用户推荐相应

的项。

5

�

项目平衡分层聚类树

分层聚类试图建立聚类的层次,即聚类树。 一种流行的方法是除法方法,其中将原

始数据点分为几个群集,每个群集进一步分为较小的子群集。 重复该划分,直到每个子

集群仅与一个点关联。

在本文中,我们旨在对项目进行平衡的层次聚类,其中假设构建的聚类树是平衡的,

即对于每个节点,其子树的高度最多相差一个,子树也达到平衡。 为了便于表示和实现,

还要求每个非叶节点具有相同数量的子节点,表示为 c,但叶节点的父节点的子节点数量

最多为 c。

我们可以按照聚类算法对项目执行平衡的层次聚类,该聚类算法将一组向量和一个整

数 c 作为输入,并将这些向量划分为 c 个平衡的簇(即,每个簇的项目编号彼此之间最多

相差一个) 。 在本文中,我们考虑两种聚类算法,即基于 PCA 的聚类算法和基于 K-means

的聚类算法,其详细过程在附录中提供。 通过重复应用聚类算法直到每个子聚类仅与一

个项目相关联,可以构建一个平衡的聚类树。 因此,将项目集和平衡聚类树的深度分别

表示为 A 和 d,我们有:

因此,给定 A 和 d,我们可以设置 c = ceil(||1),其中 ceil(x)返回不小于 x 的

最小整数。

通常在项目的(向量)表示上执行项目上的平衡层次聚类,这可能在很大程度上影响

获得的平衡聚类树的质量。 在这项工作中,我们考虑了三种产生这种表示的方法:

6

�

Rating-based. 一项表示为用户项评分矩阵的相应列,其中每个元素(i,j)的值是

用户 i 对项 j 的评分。

VAE-based. 可以通过使用变分自动编码器(VAE)了解每个项目的评级向量的低维表

示(Kingma and Welling 2013)。

MF-based. 矩阵分解(MF)技术(Koren,Bell 和 Volinsky 2009)也可以用来学习

每个项目的表示向量。

TPGR 的架构

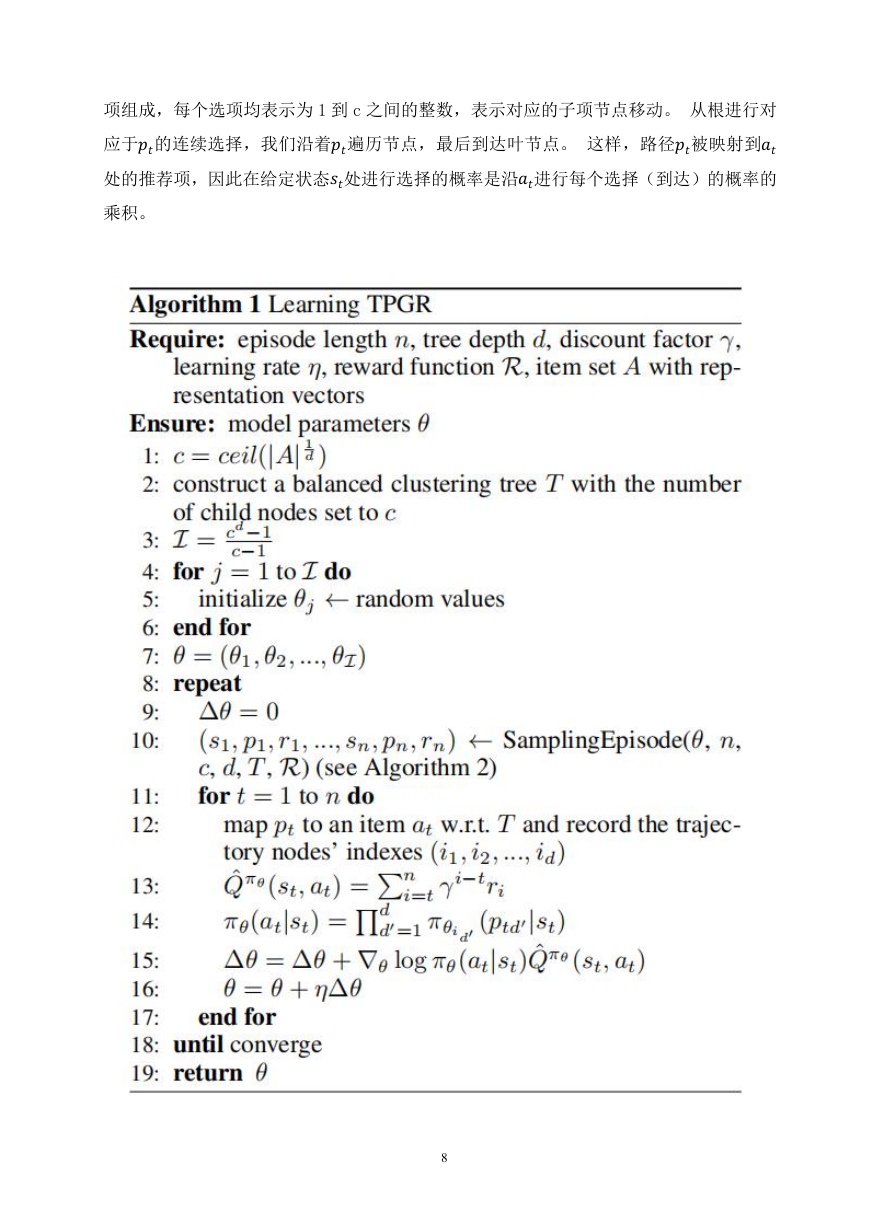

树结构策略梯度建议(TPGR)的体系结构基于构造的聚类树。 为了简化说明,我们

假设有一个状态点指示当前位于哪个节点。 因此,选择一个项目就是将状态点从根移动

到某个叶子。 树的每个非叶节点都与一个策略网络相关联,该策略网络被实现为在输出

层具有 softmax 激活功能的完全连接的神经网络。 考虑到状态点所在的节点 v,与 v 关

联的策略网络将当前状态作为输入,并在 v 的所有子节点上输出概率分布,这表明移动到

v 的每个子节点的概率。

使用带有 8 个项目的推荐方案进行说明,图 1(左)显示了树深度设置为 3 的构造的

平衡聚类树。 对于给定的状态 st,状态点最初位于根(node1)处,并根据与根(node1)

对应的策略网络给出的概率分布移动到其子节点之一(node3)。 状态点一直移动,直到

到达叶节点,并向用户推荐了相应的项(图 1 中的 item8)。

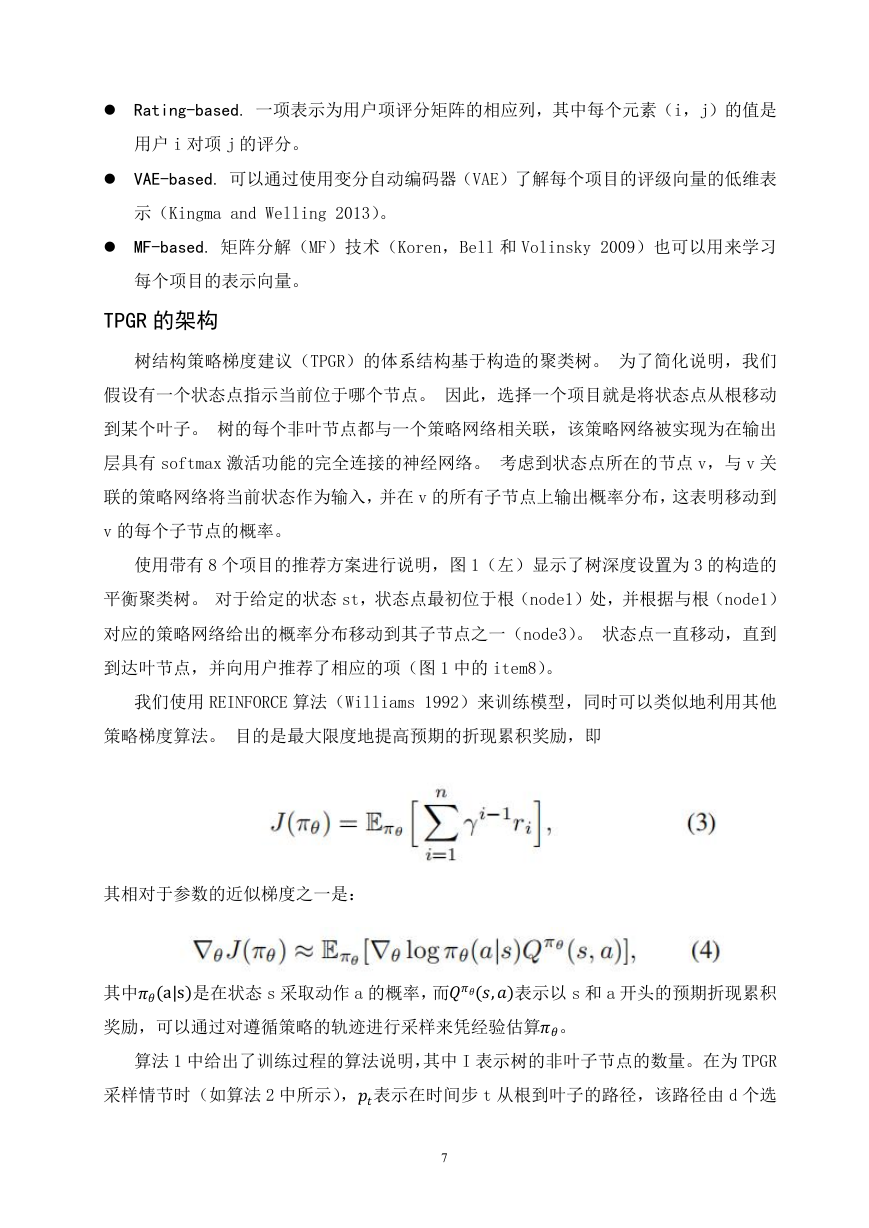

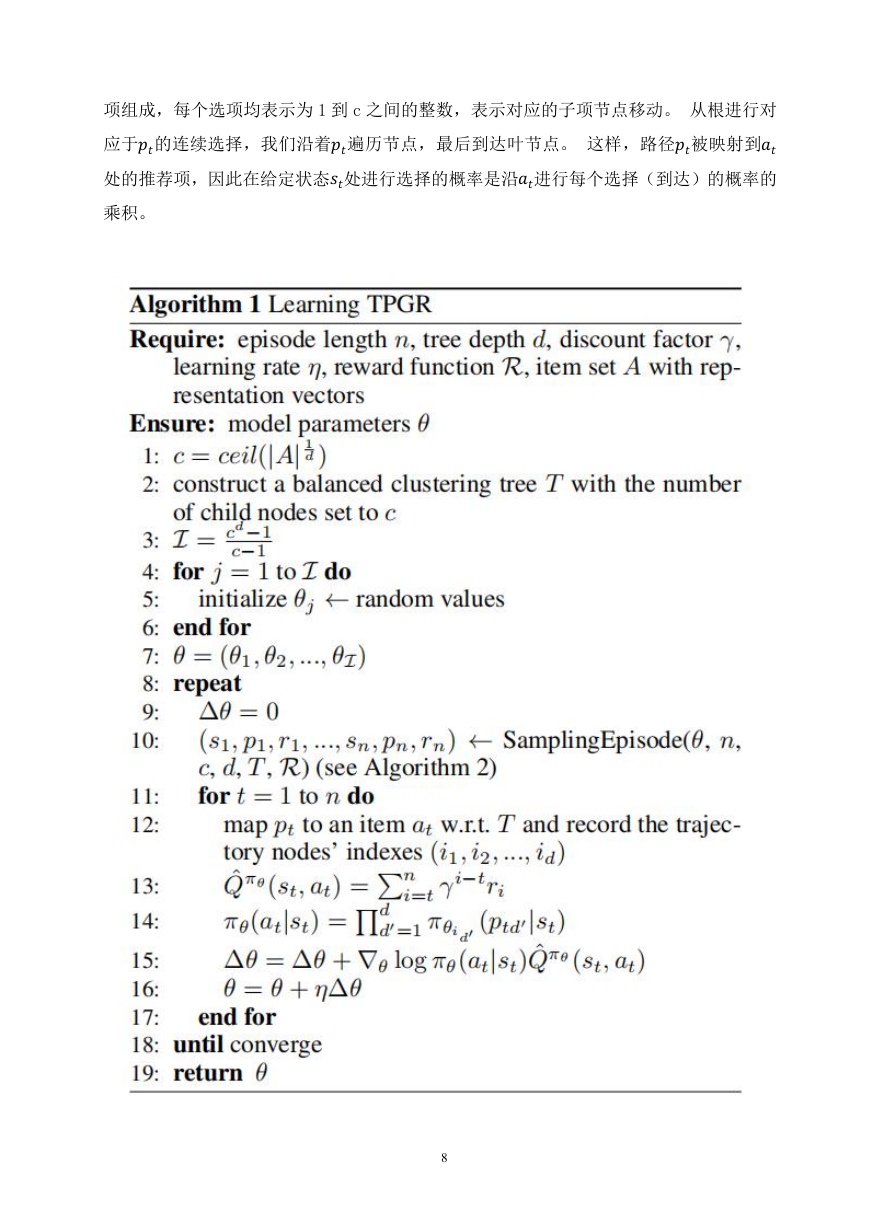

我们使用 REINFORCE 算法(Williams 1992)来训练模型,同时可以类似地利用其他

策略梯度算法。 目的是最大限度地提高预期的折现累积奖励,即

其相对于参数的近似梯度之一是:

其中(a|s)是在状态 s 采取动作 a 的概率,而(,)表示以 s 和 a 开头的预期折现累积

奖励,可以通过对遵循策略的轨迹进行采样来凭经验估算。

采样情节时(如算法 2 中所示),表示在时间步 t 从根到叶子的路径,该路径由 d 个选

算法 1 中给出了训练过程的算法说明,其中 I 表示树的非叶子节点的数量。在为 TPGR

7

�

项组成,每个选项均表示为 1 到 c 之间的整数,表示对应的子项节点移动。 从根进行对

应于的连续选择,我们沿着遍历节点,最后到达叶节点。 这样,路径被映射到

处的推荐项,因此在给定状态处进行选择的概率是沿进行每个选择(到达)的概率的

乘积。

8

�

2023年江西萍乡中考道德与法治真题及答案.doc

2023年江西萍乡中考道德与法治真题及答案.doc 2012年重庆南川中考生物真题及答案.doc

2012年重庆南川中考生物真题及答案.doc 2013年江西师范大学地理学综合及文艺理论基础考研真题.doc

2013年江西师范大学地理学综合及文艺理论基础考研真题.doc 2020年四川甘孜小升初语文真题及答案I卷.doc

2020年四川甘孜小升初语文真题及答案I卷.doc 2020年注册岩土工程师专业基础考试真题及答案.doc

2020年注册岩土工程师专业基础考试真题及答案.doc 2023-2024学年福建省厦门市九年级上学期数学月考试题及答案.doc

2023-2024学年福建省厦门市九年级上学期数学月考试题及答案.doc 2021-2022学年辽宁省沈阳市大东区九年级上学期语文期末试题及答案.doc

2021-2022学年辽宁省沈阳市大东区九年级上学期语文期末试题及答案.doc 2022-2023学年北京东城区初三第一学期物理期末试卷及答案.doc

2022-2023学年北京东城区初三第一学期物理期末试卷及答案.doc 2018上半年江西教师资格初中地理学科知识与教学能力真题及答案.doc

2018上半年江西教师资格初中地理学科知识与教学能力真题及答案.doc 2012年河北国家公务员申论考试真题及答案-省级.doc

2012年河北国家公务员申论考试真题及答案-省级.doc 2020-2021学年江苏省扬州市江都区邵樊片九年级上学期数学第一次质量检测试题及答案.doc

2020-2021学年江苏省扬州市江都区邵樊片九年级上学期数学第一次质量检测试题及答案.doc 2022下半年黑龙江教师资格证中学综合素质真题及答案.doc

2022下半年黑龙江教师资格证中学综合素质真题及答案.doc