1.选择题

1.1.下面哪个程序负责 HDFS 数据存储。

1.2.HDfS 中的 block 默认保存几份?

1.3.下列哪个程序通常与NameNode在一个节点启动?

1.4.HDFS 默认 Block Size

1.5.下列哪项通常是集群的最主要瓶颈

1.6.关于 SecondaryNameNode 哪项是正确的?

1.7.下列哪项可以作为集群的管理?

1.8.Client 端上传文件的时候下列哪项正确

1.9.下列哪个是 Hadoop 运行的模式

2.面试题

2.1. Hadoop的核心配置是什么?

2.2.那当下又该如何配置?

2.3.“jps”命令的用处?

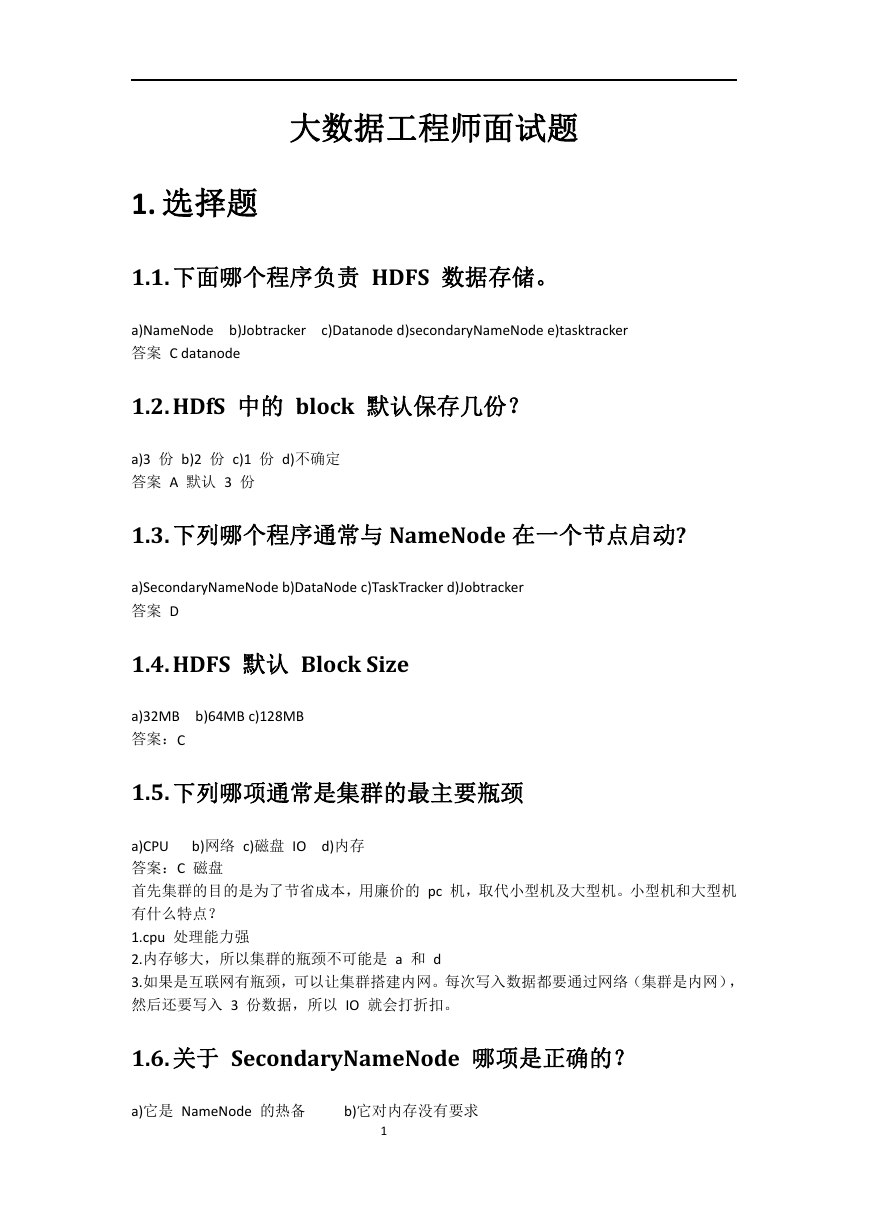

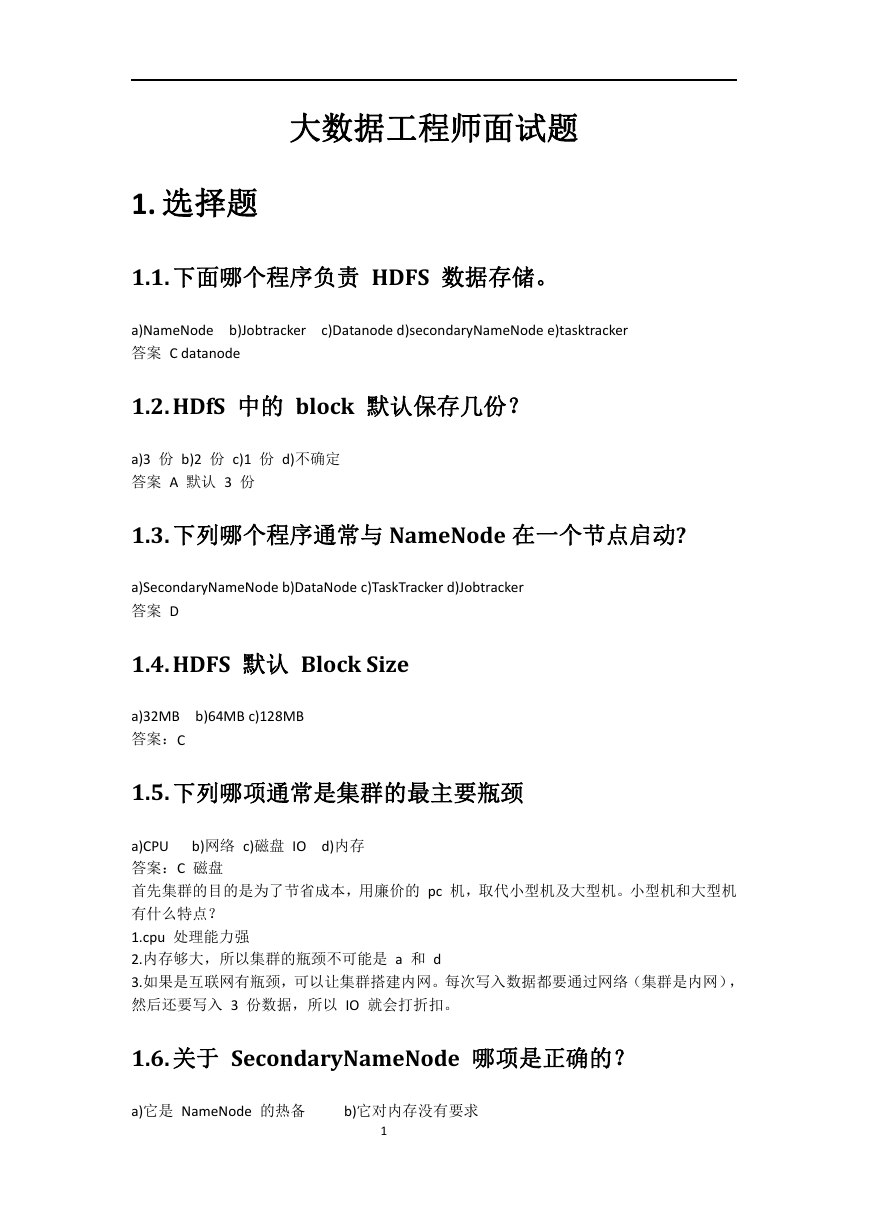

2.4.mapreduce的原理?

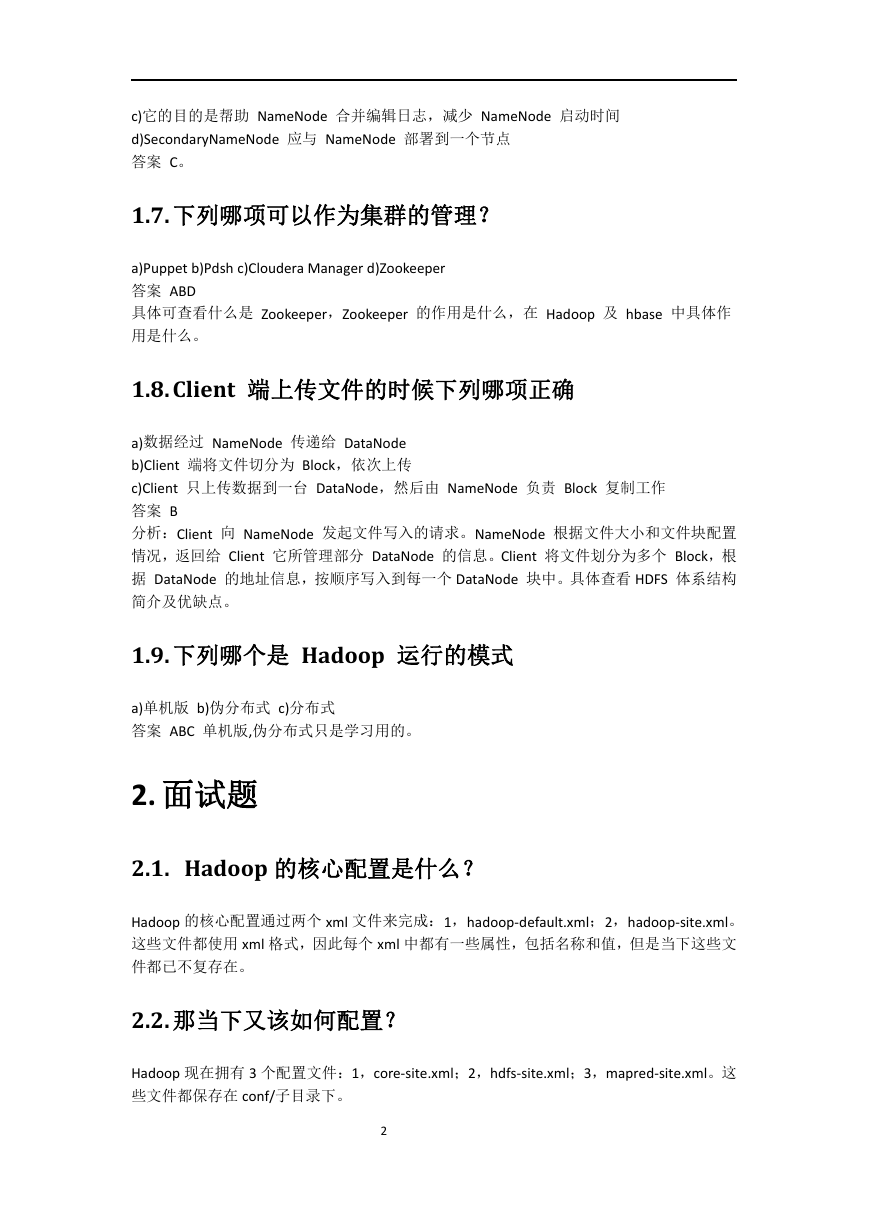

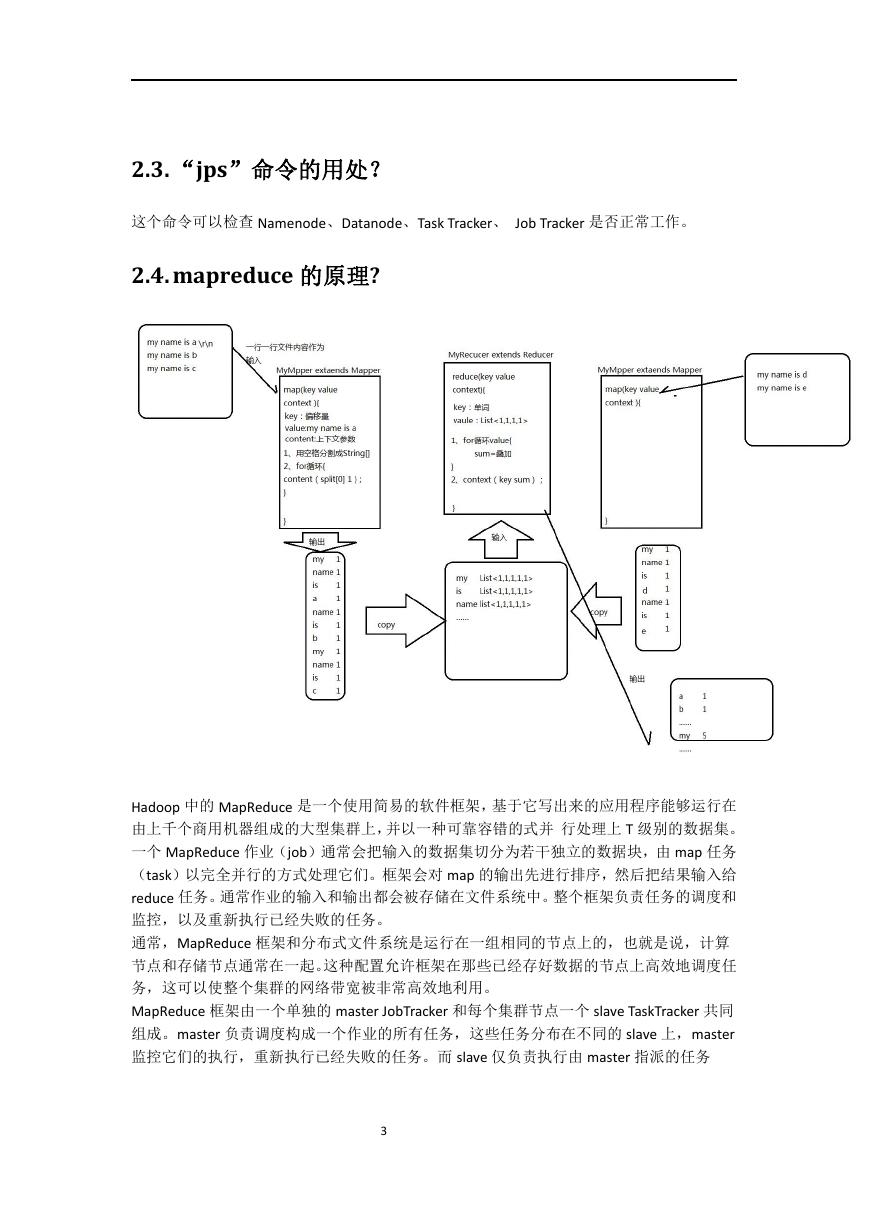

2.5.HDFS存储的机制?

2.5.1.hdfs写流程

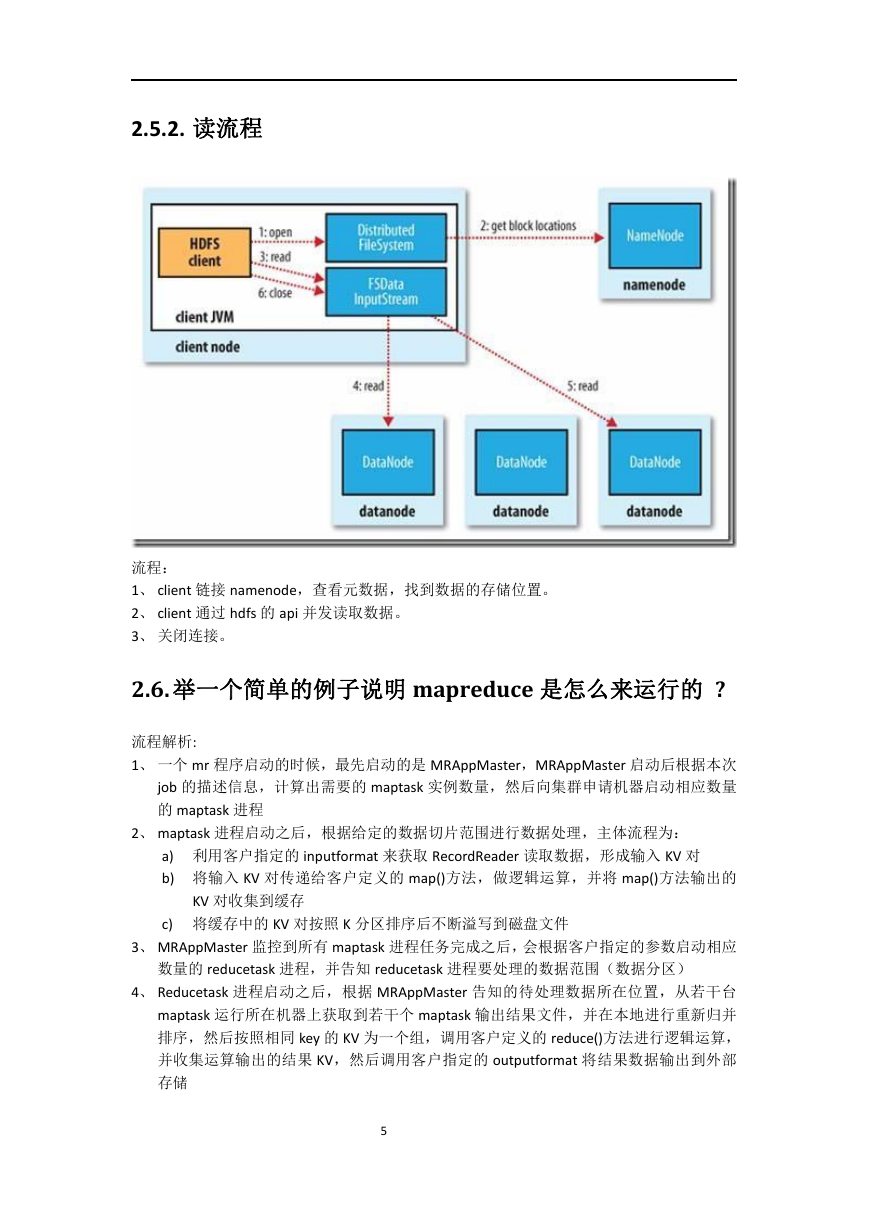

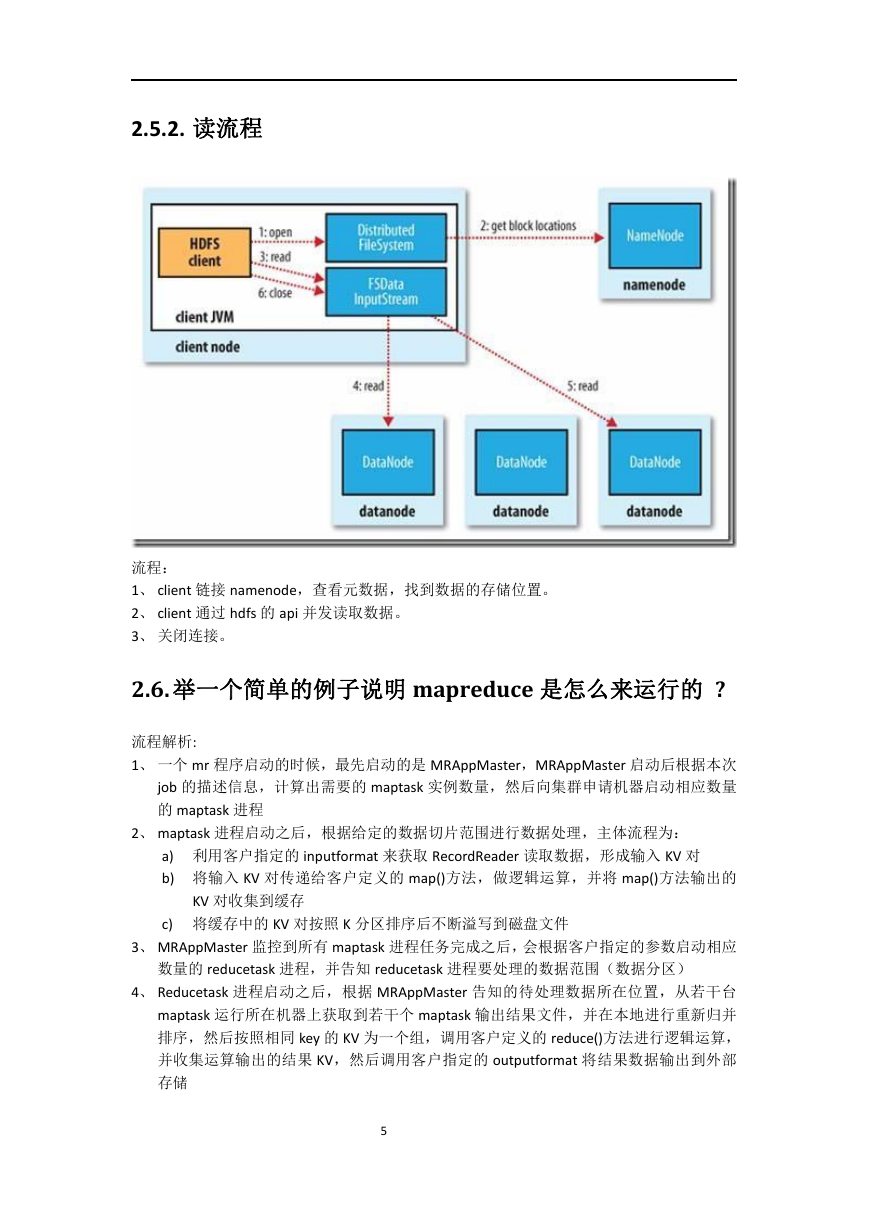

2.5.2.读流程

2.6.举一个简单的例子说明mapreduce是怎么来运行的 ?

2.7.用mapreduce来实现下面需求?

2.8.hadoop中Combiner的作用?

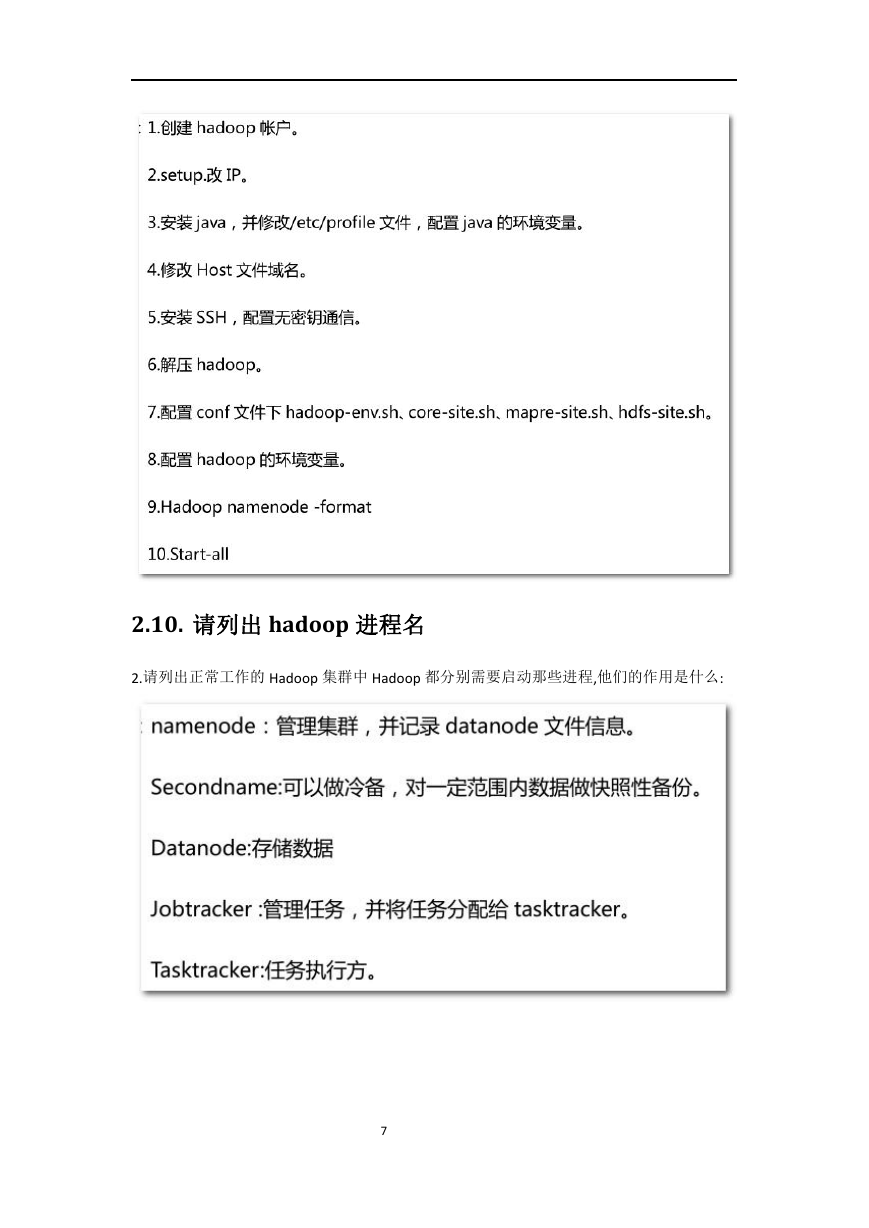

2.9.简述hadoop安装

2.10.请列出hadoop进程名

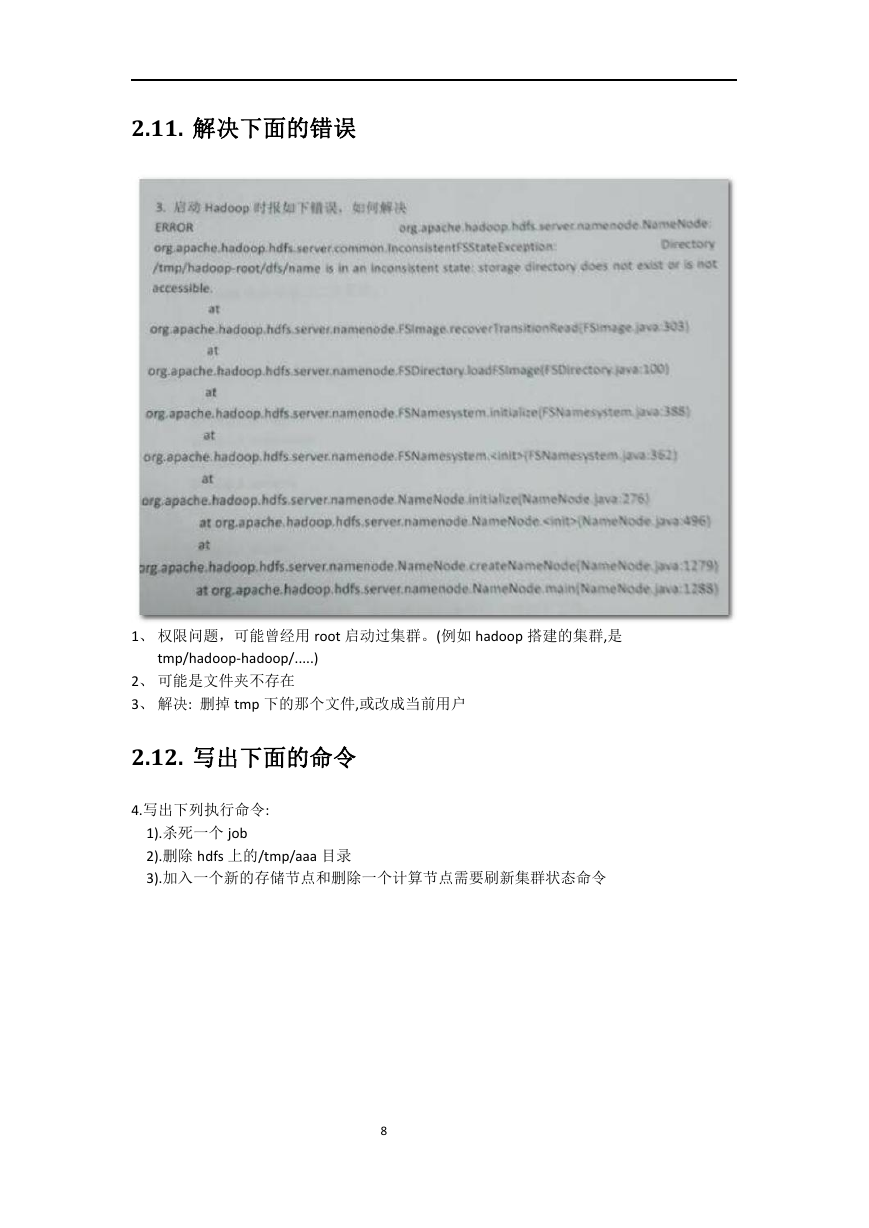

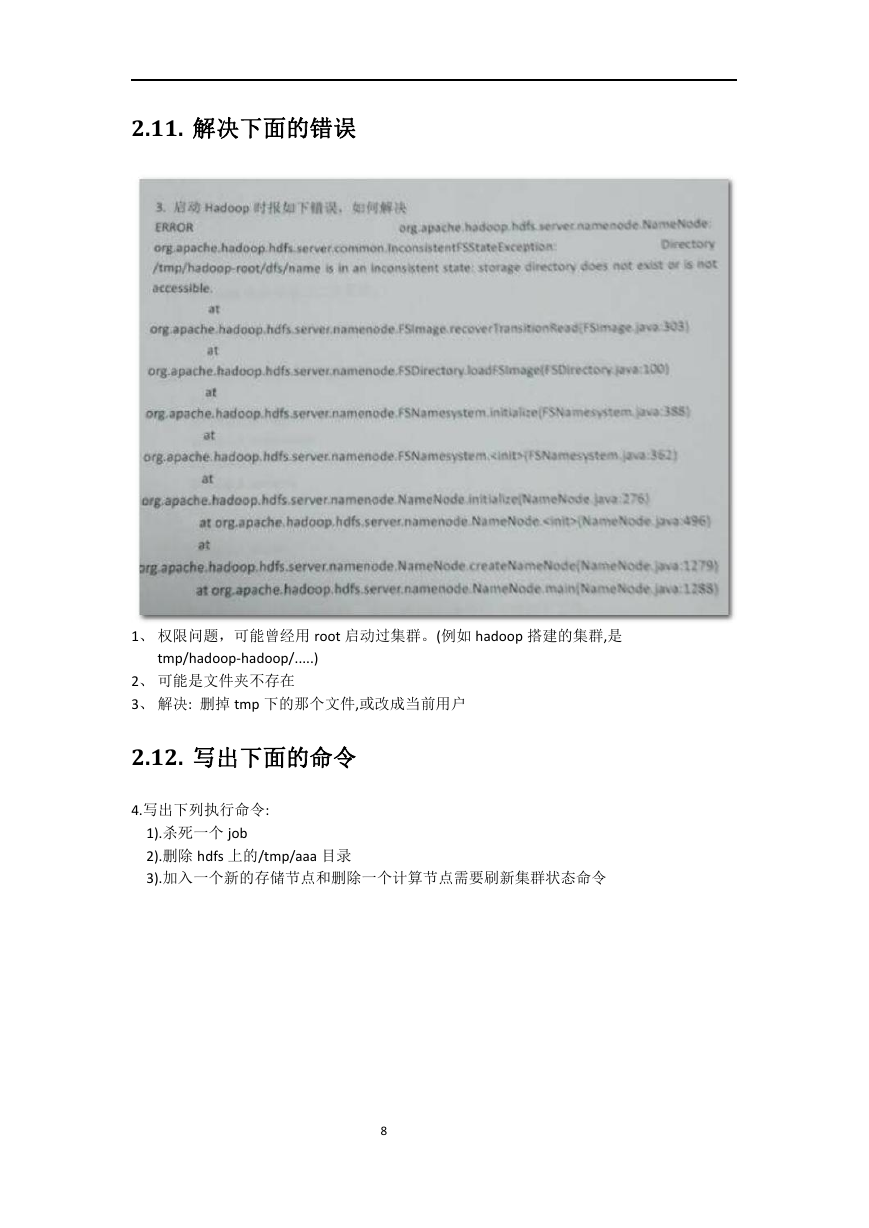

2.11.解决下面的错误

2.12.写出下面的命令

2.13.简述hadoop的调度器

2.14.列出你开发mapreduce的语言

2.15.wordcount示例书写程序

2.16.不同语言的优缺点

2.17.hive有哪些保存元数据的方式,个有什么特点。

2.18.简述MapReduce中combiner和partition的作用

2.19.hive内部表和外部表的区别

2.20.hbase的rowkey怎么创建好?列族怎么创建好?

2.21.用mapreduce怎么处理数据倾斜问题?

2.22.hadoop框架中怎么来优化

2.22.1.从应用程序角度进行优化

2.22.2.对参数进行调优

2.23.我们开发job时,是否可以去掉reduce阶段。

2.24.datanode在什么情况下不会备份

2.25.combiner出现在那个过程

2.26.hdfs的体系结构

2.27.3个datanode中有一个datanode出现错误会怎样?

2.28.描述一下hadoop中,有哪些地方使用了缓存机制,作用分别是什么?

2.29.如何确定hadoop集群的健康状态

2.30.生产环境中为什么建议使用外部表?

3.15期新增

3.1.新增

3.2.你们数据库怎么导入hive 的,有没有出现问题

3.3.一个datanode 宕机,怎么一个流程恢复

3.4.Hbase 的特性,以及你怎么去设计 rowkey 和 columnFamily ,怎么去建一个ta

3.5.Redis,传统数据库,hbase,hive 每个之间的区别

3.6.shuffle 阶段,你怎么理解的

3.7.Mapreduce 的 map 数量 和 reduce 数量 怎么确定 ,怎么配置

3.8.唯一难住我的是他说实时计算,storm 如果碰上了复杂逻辑,需要算很长的时间,你怎么去优化,怎么保证

3.9.Hive 你们用的是外部表还是内部表,有没有写过UDF,hive 的版本

3.10.设计日志收集分析系统

3.11.你来做技术分享,选择什么主题?课程安排?

3.12.Hive语句实现WordCount。

3.13.a、b两个文件,各存放50亿个url,每个url各占64字节,内存限制是4G,找出a、b文件共同的u

3.14.一亿个数据获取前100个最大值(步骤及算法复杂度)

3.15.实时数据统计会用到哪些技术,它们各自的应用场景及区别是什么?

3.16.String和StringBuffer的区别,StringBuffer与StringBuilder的

3.17. HashMap,HashTable,Vector,ArrayList,linkedlist和 Ar

3.18.多线程实现方式Thread和Runnable的区别

3.19.一个Hadoop环境,整合了HBase和Hive,是否有必要给HDFS和Hbase都分别配置压缩策略

3.20.简述Hbase性能优化的思路

3.21.简述Hbase filter的实现原理是什么?结合实际项目经验,写出几个使用filter的场景

3.22.ROWKEY的后缀匹配怎么实现?例如ROWKEY是yyyyMMDD-UserID形式,如果要以Use

3.23.简述Hive中虚拟列作用是什么,使用它的注意事项。

3.24.如果要存储海量的小文件(大小都是几百K~几M),请简述自己的设计方案。

3.25.有两个文本文件,文件中的数据按行存放,请编写MapReduce程序,找到两个文件中彼此不相同的行

4.共同朋友

5.脚本替换

6.一键执行

7.面试问题:

8.面试问题:

9.面试问题:

10.面试问题:

11.京东商城 - 大数据

11.1.可靠的sources和receivers

11.2.metadata checkpoint

11.3.数据可能丢失的场景

11.4.WAL

11.5.At-Least-Once

11.6.WAL的缺点

11.7.Kafka direct API

11.8.总结